Hadoop伪集群安装

1、 基础配置

考核条件如下:

(1) 按照左侧虚拟机名称修改对应主机名为hadoop000(使用hostnamectl命令)

hostnamectl set-hostname hadoop000

bash

**(2) /root/目录下创建文件夹task **

mkdir /root/task

(3) task文件夹下创建文件student

touch /root/task/student

(4) 修改hosts文件添加左侧hadoop000节点IP与主机名映射(使用内网IP)

echo '内网ip hadoop000' >> /etc/hosts

(5) 时区更改为上海时间(CST+0800时区)

echo TZ="Asia/Shanghai;export TZ" >> /etc/profile

source /etc/profile

(6) 添加定时任务要求每天早十点将系统日期和时间写入创建好的student文件中

crontab -e

* * 10 * * echo `date +"%Y-%m-%d %H:%M:%S"` begin >> /root/task/student

2、 ssh免密配置

考核条件如下:

**(1) 节点中生成公钥文件id_rsa.pub(数字签名RSA,用户root,主机名hadoop000) **

/usr/sbin/sshd

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

ssh-copy-id -i /root/.ssh/id_rsa.pub hadoop000

(2) 建⽴hadop000⾃身使⽤root⽤户ssh访问localhost免密登录(自行完成首次公钥匙认证)

ssh localhost

3、 JDK安装

考核条件如下:

(1) 将jdk安装包解压到/usr/java目录(安装包存放于/usr/package277,路径自行创建,解压后文件夹为默认名称,其他安装同理)

cd /usr/ && mkdir java

tar -zxvf /usr/package277/jdk-8u221-linux-x64.tar.gz -C /usr/java

(2) 配置系统环境变量JAVA_HOME,同时将JDK安装路径中bin目录加入PATH系统变量,注意生效变量,查看JDK版本

echo 'export JAVA_HOME=/usr/java/jdk1.8.0_221' >> /etc/profile

echo 'export PATH=$PATH:$JAVA_HOME/bin' >> /etc/profile

source /etc/profile && bash

java -version

4、 Hadoo伪集群部署

考核条件如下:

(1) 将Hadoop安装包解压到指定路径/usr/hadoop(安装包存放于/usr/package277/)

cd /usr/ && mkdir hadoop

tar -zxvf /usr/package277/hadoop-2.7.7.tar.gz -C /usr/hadoop

(2) 配置环境变量HADOOP_HOME,将Hadoop安装路径中bin目录和sbin目录加入PATH系统变量,注意生效变量

echo 'export HADOOP_HOME=/usr/hadoop/hadoop-2.7.7' >> /etc/profile

echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile

source /etc/profile && bash

接下来所有的配置文件都存放在/usr/hadoop/hadoop-2.7.7/etc/hadoop中,我们先进入该目录

cd /usr/hadoop/hadoop-2.7.7/etc/hadoop

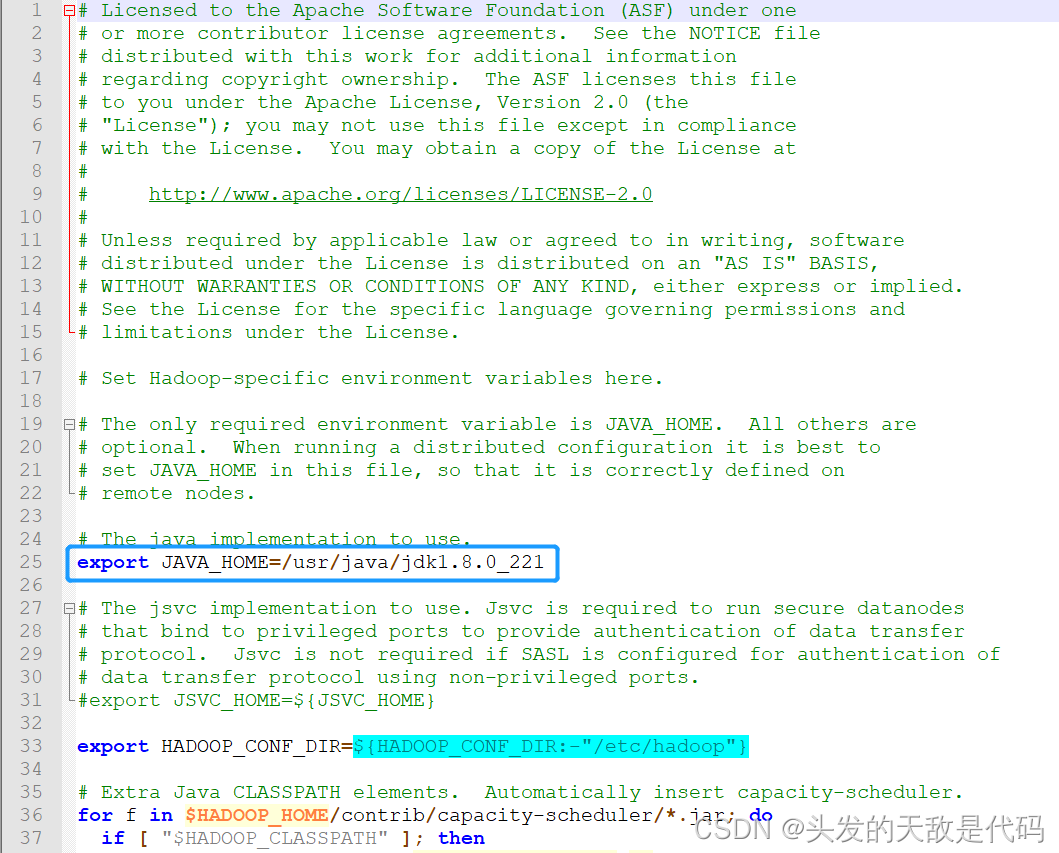

(3) 配置Hadoop运行环境JAVA_HOME(hadoop-env.sh)

修改JAVA_HOME

(4) 设置全局参数,指定HDFS上NameNode地址为hadoop000,端口默认为9000(core-site.xml)

<property>

<name>fs.default.name</name>

<value>hdfs://hadoop000:9000</value>

</property>

**(5) 设置全局参数,指定临时存储目录为本地/root/hadoopData/tmp(要求为绝对路径,下同) **

<property>

<name>hadoop.tmp.dir</name>

<value>/root/hadoopData/tmp</value>

</property>

(6) 设置HDFS参数,指定备份文本数量为1(hdfs-site.xml)

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

**(7) 设置HDFS参数,指定NN存放元数据信息路径为本地/root/hadoopData/name;指定DN存放元数据信息路径为本地/root/hadoopData/data(要求为绝对路径) **

<property>

<name>dfs.namenode.name.dir</name>

<value>/root/hadoopData/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/root/hadoopData/data</value>

</property>

(8) 设置HDFS参数,关闭hadoop集群权限校验(安全配置),允许其他用户连接集群

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

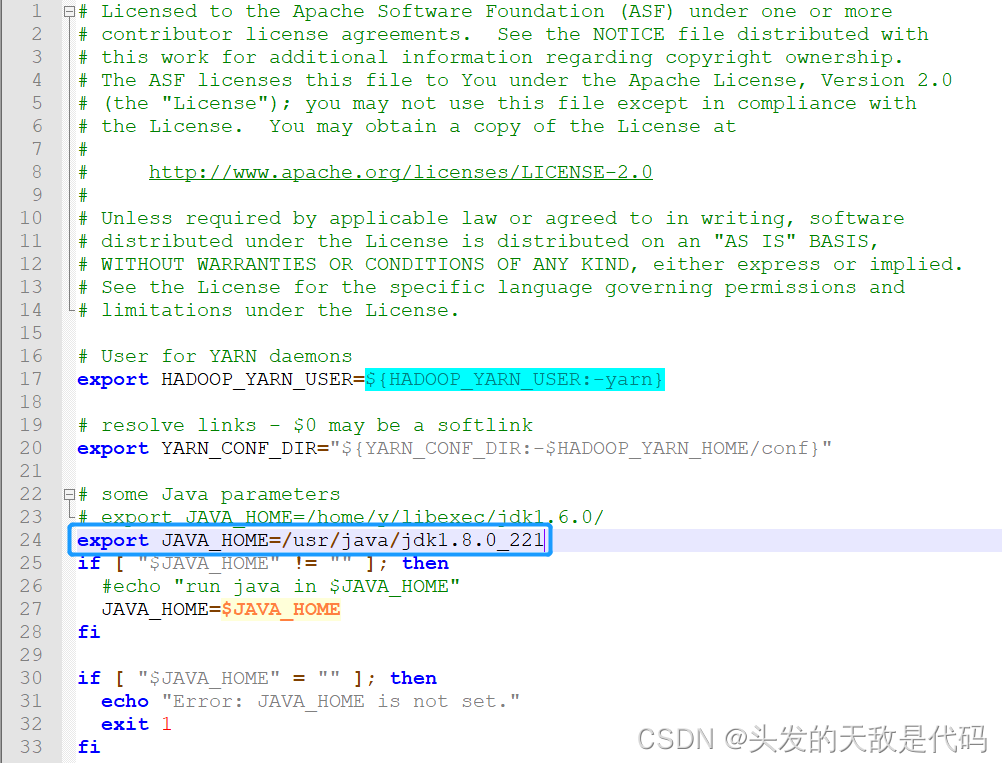

(9) 设置YARN运行环境$JAVA_HOME参数(yarn-env.sh)

(10) 设置YARN核心参数,指定mapreduce 获取数据的方式为mapreduce_shuffle(yarn-site.xml)

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

(11) 设置计算框架参数,指定MR运行在yarn上(mapred-site.xml)

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

(12) 设置节点文件slaves,要求hadoop000为子节点

hadoop000

(13) 对文件系统进行格式化

hdfs namenode -format

当出现“Exiting with status 0”的时候,表明格式化成功。

(14) 启动Hadoop集群查看各节点服务

start-all.sh

(15) 查看集群运行状态是否正常

jps

一定确保进程都已经启动

版权归原作者 头发的天敌是代码 所有, 如有侵权,请联系我们删除。