iDRAC

iDRAC又称为Integrated Dell Remote Access Controller(集成式戴尔远程控制卡),是戴尔服务器的独有功能。

iDRAC相当于是附加在服务器上的一个计算机,可以实现一对一的服务器远程管理与监控,通过与服务器主板上的管理芯片BMC进行通信,监控与管理服务器的硬件状态信息。

iDRAC拥有自己的系统和IP地址,与服务器上的OS无关,是管理员进行远程访问和管理的利器,戴尔服务器集成了iDRAC控制卡,我们就可以扔掉价格昂贵的KVM设备了。

服务器带外管理和iDRAC 接口

也就是标识为iDRAC的接口

使用时,将笔记本直接通过网线连接到这个接口

笔记本上设置以太网连接的属性为手动IP,例如192.168.0.100

然后ping 192.168.0.120(服务器的默认的带外IP)

理论上应该是好使的

查看服务器的iDRAC地址

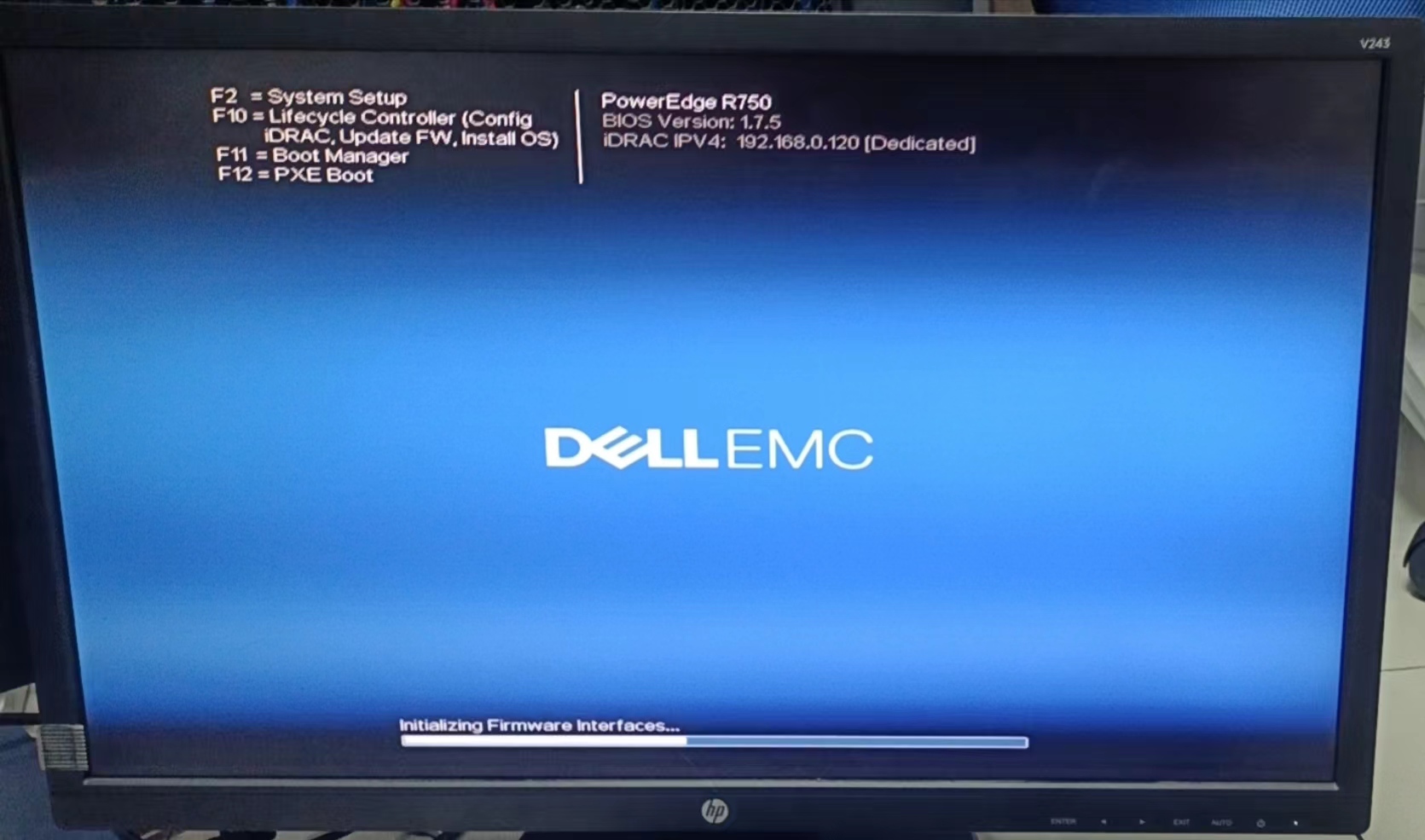

以R750为例

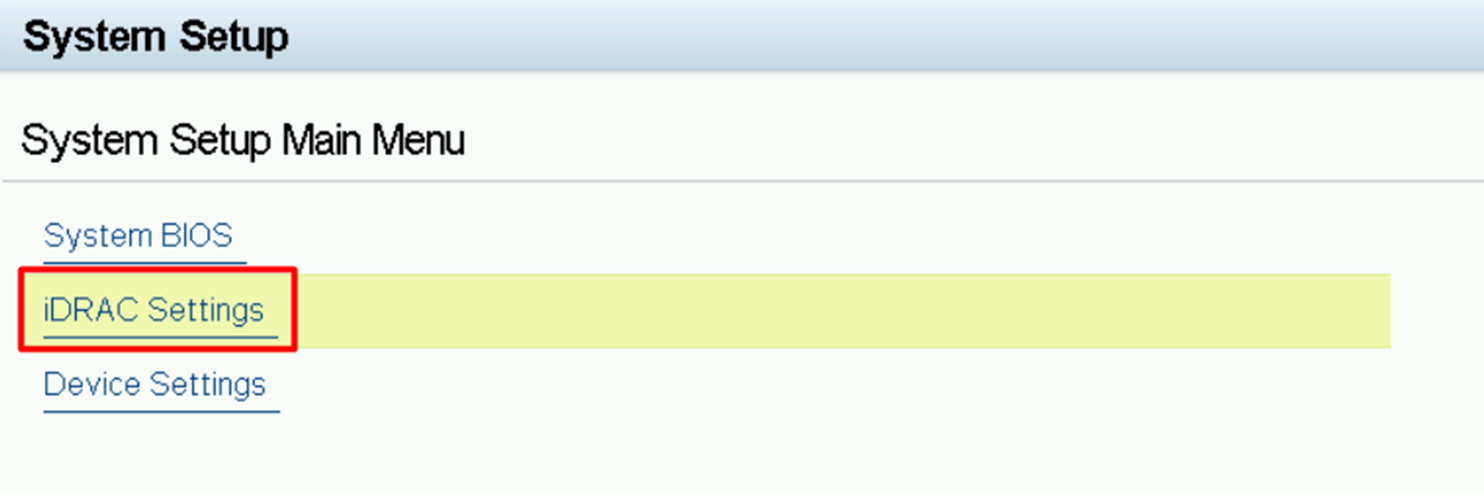

在开机过程中不断按F2,进入这里:

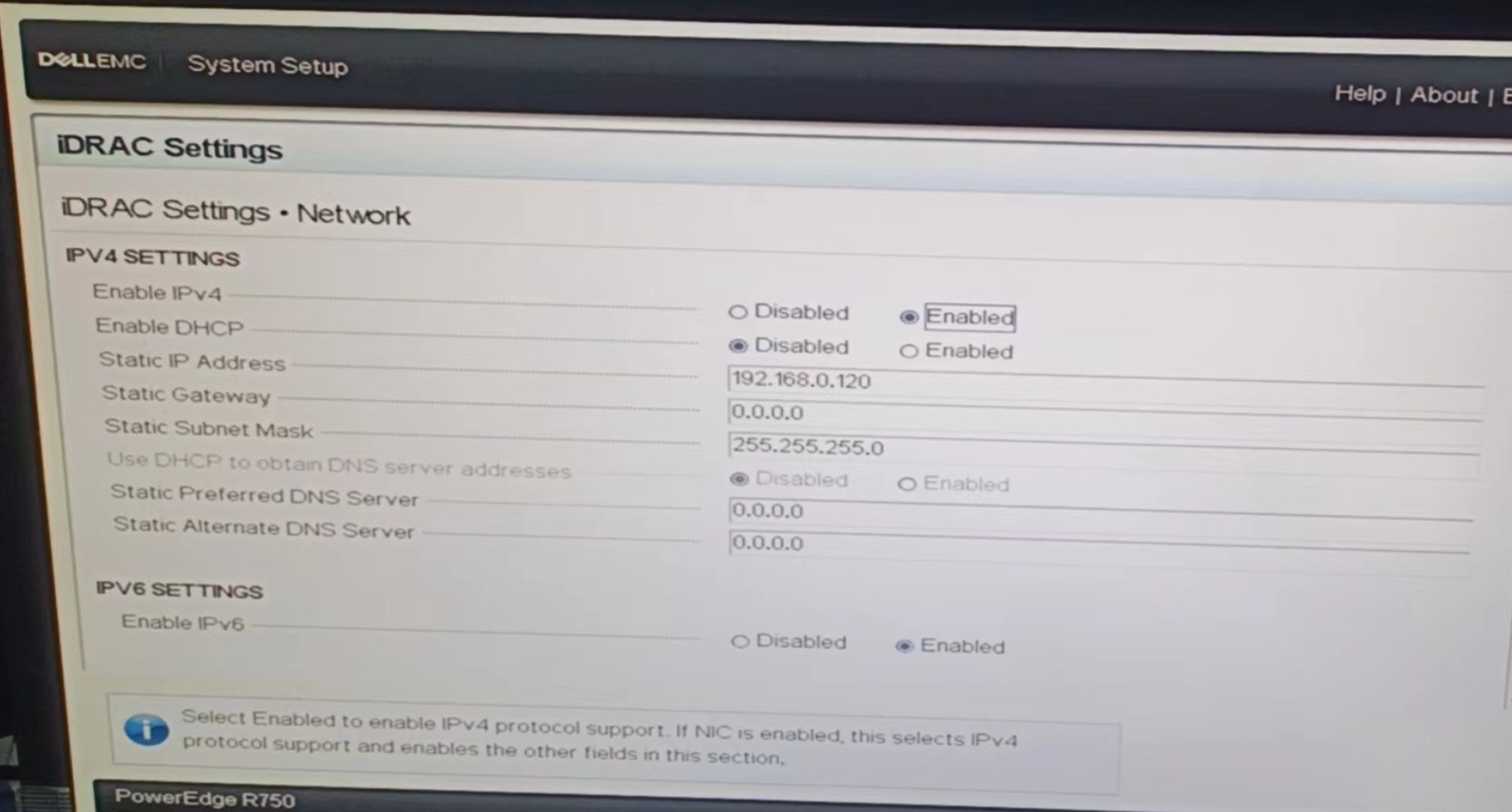

这里就能看到iDRAC的IPV4地址是192.168.0.120

设置iDRAC地址:官方教程

设置iDRAC地址

以R750为例

在开机过程中不断按F2,进入这里:

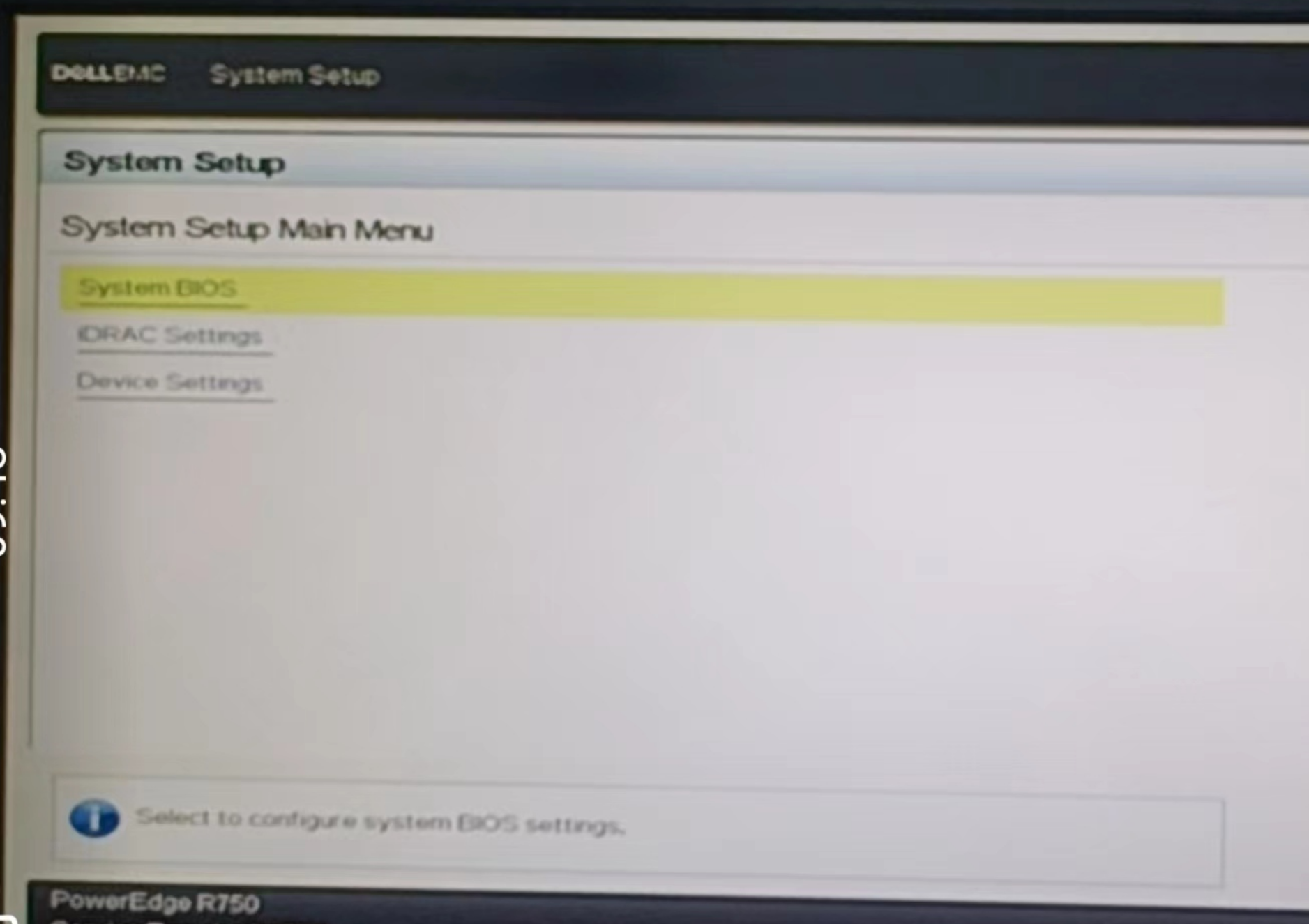

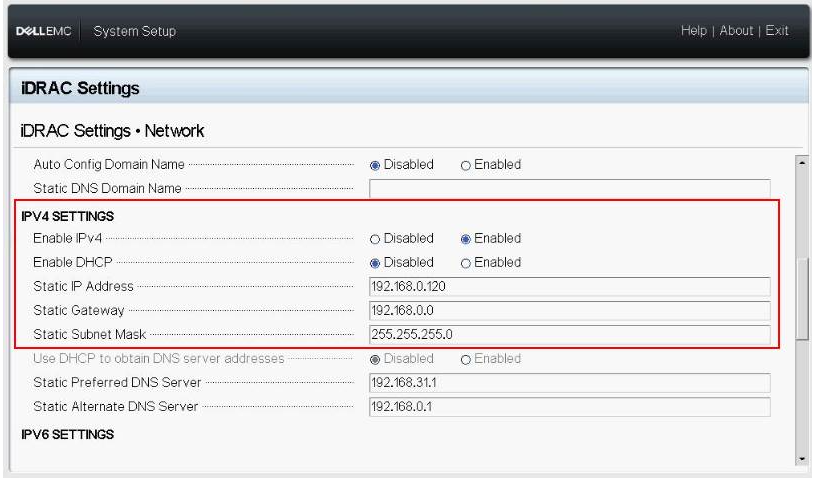

之后不用管,会进入这里:

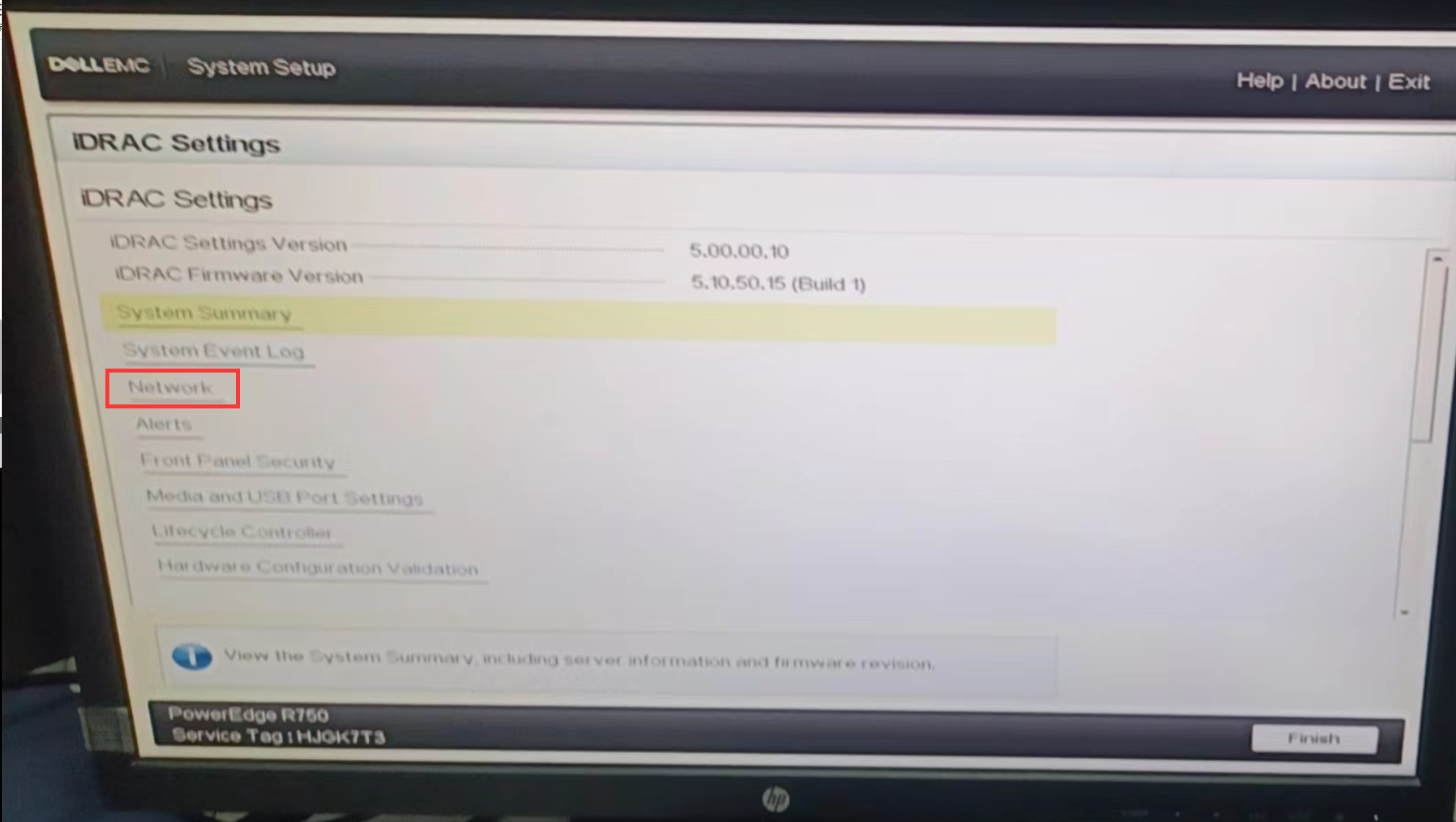

进入iDRAC Settings,之后进入Network:

之后就可以设置iDRAC的IP地址了:

这里将服务器的iDRAC IP设置为了192.168.0.120

之后使用笔记本 通过网线连接服务器iDRAC接口

笔记本以太网地址手动设置为类似192.168.0.100这种

然后再笔记本上

ping 192.168.0.120 -t

应该就可以ping得通

用笔记本的浏览器访问192.168.0.120就能进行服务器硬件的各种管理了

恢复iDRAC出厂配置

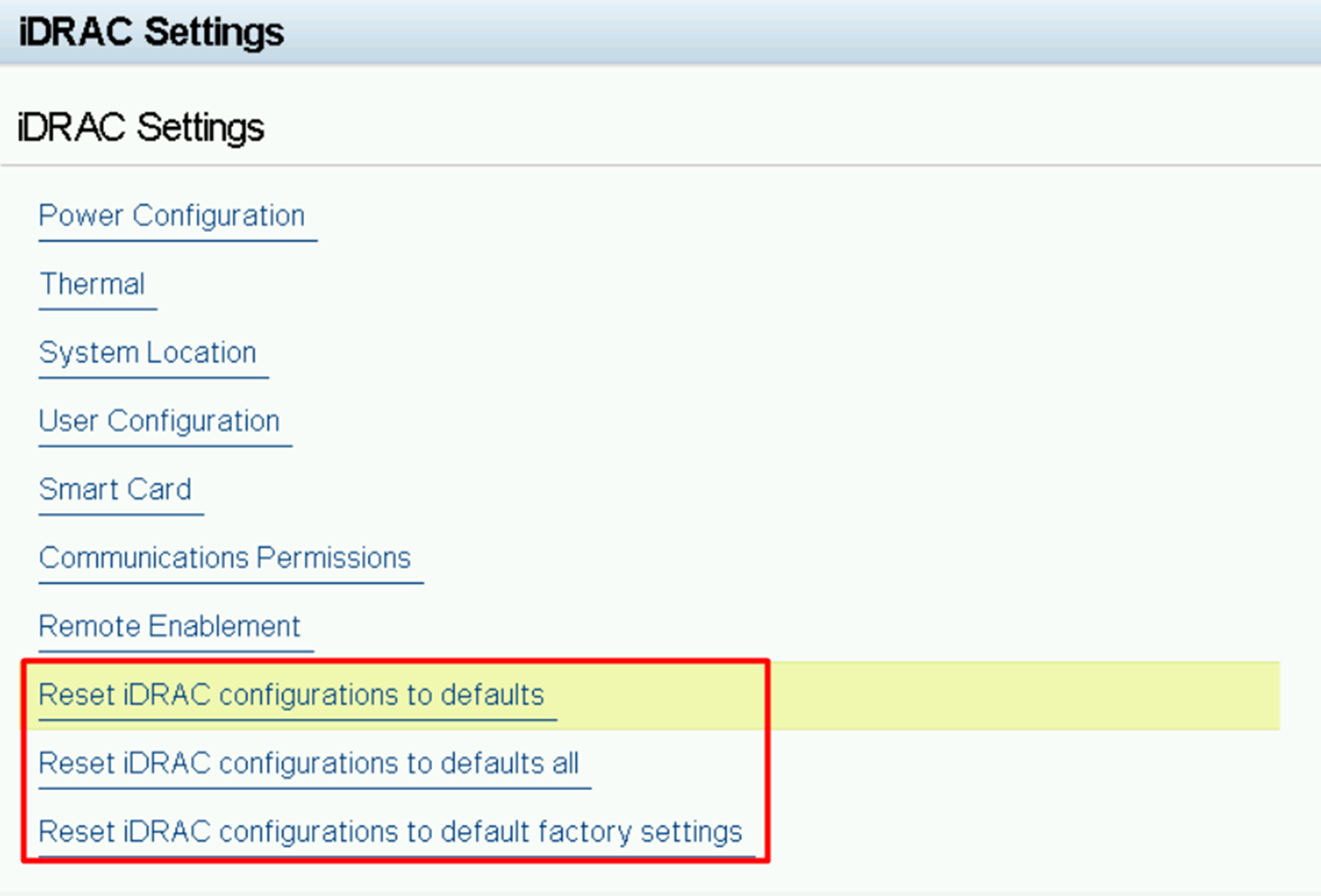

机器重启按F2进BIOS ,选择iDRAC Settings

重置iDRAC(根据实际情况选择)

- 选择Reset iDRAC configurations to defaults 将iDRAC重置为出厂默认值将从非易失性存储设置恢复。但保留iDRAC网络设置和用户帐户

- 选择Reset iDRAC configurations to defaults all 将iDRAC重置为出厂默认值将从非易失性存储设置恢复。注意:(iDRAC Settings的所有设置都恢复成默认值)

- 选择Reset iDRAC configurations to default factory settings 将iDRAC配置重置为默认出厂设置将从非易失性存储设置中恢复。注意:用户名和密码重置为系统前面板上系统信息标签上的默认装运值

我这次选的是第二个

我这次选的是第二个

重置之后,iDRAC的IP配置会回到DHCP状态

这之后需要重新配置为静态IP

R750 消费者级NVIDIA显卡风扇异响

Dell R750 机架式服务器安装NVIDIA消费者级显卡后,显卡一使用,显卡风扇就发出异响:间歇性啸叫。

可以通过iDRAC进行硬件配置,来缓解此问题:

笔记本接入iDRAC接口,笔记本配置好静态IP,使用ssh连接iDRAC:

ssh [email protected]

其中root为用户名,口令为BIOS中设置的iDRAC口令,也就是192.168.0.120网页界面所使用的口令

之后:

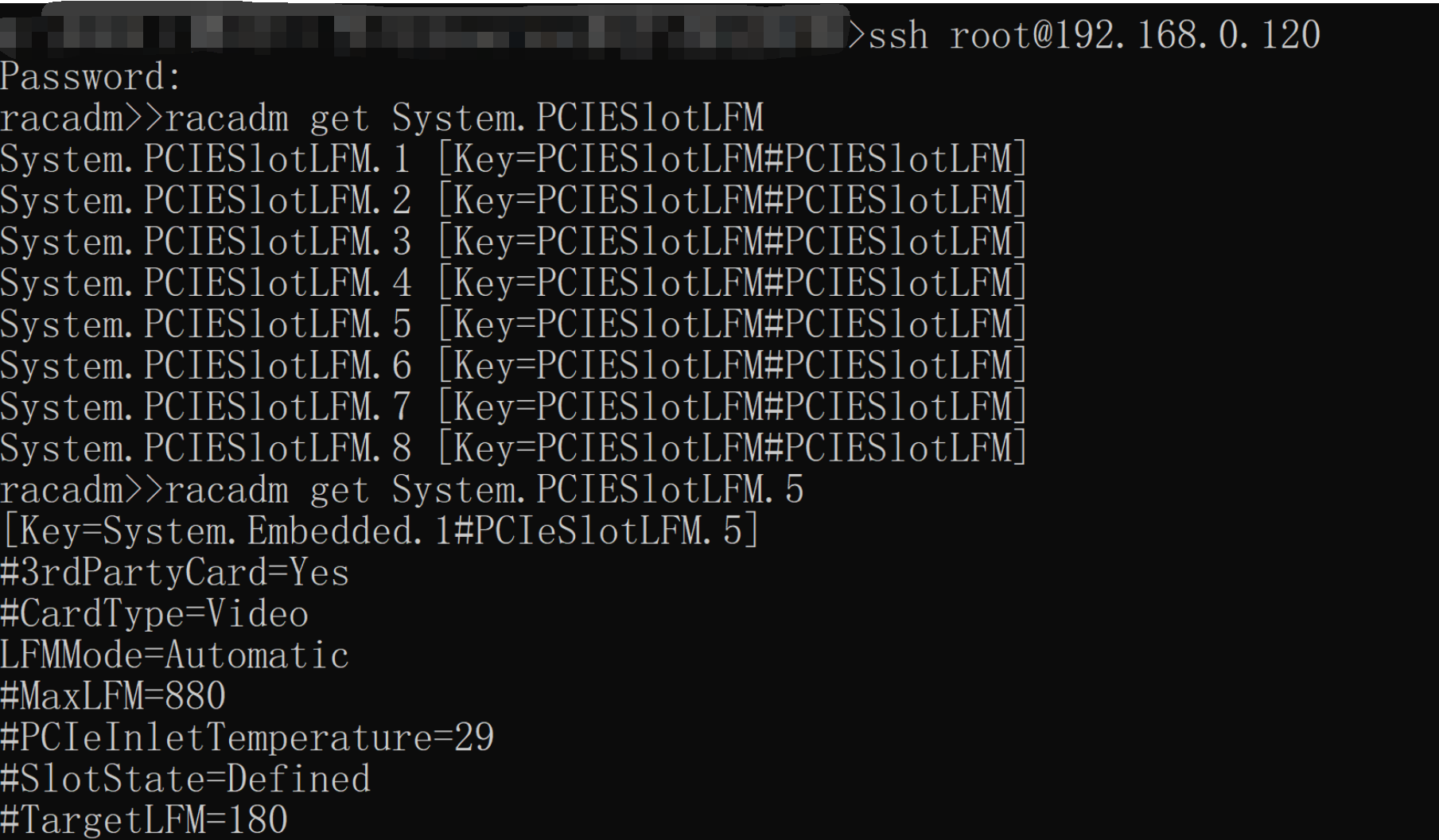

racadm get System.PCIESlotLFM //查看所有槽位信息

racadm get System.PCIESlotLFM.5// get对应槽位的信息,8 代表需要设定的具体槽位

racadm set System.PCIESlotLFM.5.LFMMode 2//对PCIe Slot8 的LFM mode设置成custom, 0 auto(默认), 1 disabled , 2 custom.

其中

System.PCIESlotLFM.5

要换成实际有显卡的槽位

再次

racadm get System.PCIESlotLFM.5

,应该可以看到

LFMMode

变为

Custom

:

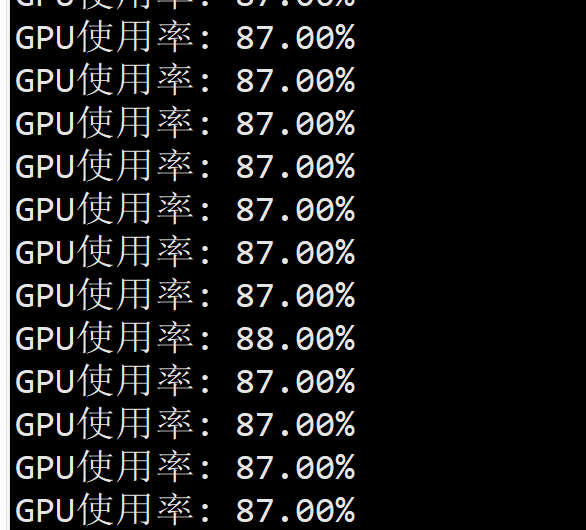

测试显卡风扇情况

(请ChatGPT帮忙)写了一小段代码,用来提高GPU使用率,观察显卡情况:

conda activate project

python testfan.py

testfan.py内容如下:

import subprocess

import torch

# 检查GPU是否可用

device = torch.device("cuda"if torch.cuda.is_available()else"cpu")

def get_gpu_utilization():

try:

result = subprocess.check_output(['nvidia-smi','--query-gpu=utilization.gpu','--format=csv,noheader'], universal_newlines=True)

utilization =float(result.split('\n')[0].strip().rstrip('%'))return utilization

except(subprocess.CalledProcessError, OSError):return0.0

def test_gpu_fan():

# 设置GPU设备

torch.cuda.set_device(0)

# 使用一个大型的矩阵进行计算,以增加GPU使用率

matrix_size =10000

matrix = torch.randn(matrix_size, matrix_size).to(device)while True:

# 连续计算两个随机矩阵的乘积

result = torch.mm(matrix, matrix)

result = torch.mm(result, matrix)

# 同步当前设备,确保所有计算已完成

torch.cuda.synchronize()

# 输出GPU使用率

utilization =get_gpu_utilization()print("GPU使用率: {:.2f}%".format(utilization))if __name__ =="__main__":print("开始测试GPU风扇...")test_gpu_fan()

此时GPU利用率很高,如果此过程中显卡不异响,说明没问题了。

版权归原作者 Jouzzy 所有, 如有侵权,请联系我们删除。