云计算Spark环境搭建并搭建conda环境

第一部分:搭建Spark

- 将Spark和Miniconda传进容器并解压

- 修改Spark下/spark/conf/spark_env.sh 如果是template模板 可以复制一份改名

下面路径需要修改为自己的路径

export HADOOP_CONF_DIR=/root/hadooptar/hadoop/etc/hadoop

export YARN_CONF_DIR=/root/hadooptar/hadoop/etc/hadoop

export SPARK_PID_DIR=/root/hadooptar/hadoop/pid

export JAVA_HOME=/opt/hadooptar/jdk

- 修改conf下的workers文件,同样如果是模板可以复制一份

写上从节点的名字

将修改后的spark同步到其他容器

在主节点的Spark/sbin/下启动

Start-all.sh

如果你发现从节点worker无法启动,可能因为地址需找不到,可以去指定一个

在下面加上export SPARK_LOCAL_IP=......... (最好默认 不设置)

启动完毕后会出现以下界面

Jps中会出现master

从节点会出现如下:worker

- 进入192.168.81.132:8080可以进入Spark,如下界面即是启动成功

第二部分:搭建miniconda的环境

- 将自己的miniconda解压的sh文件运行

一直确定确定即可,后面填写yes

第二步:这里是安装的miniconda环境的默认路径

这里你是可以修改了,这里我没有修改直接确定就是默认路径

第三步:创建conda envs的test环境

Conda activate test

就可以进入test环境

并且pip install pyspark==3.2 -v

第四步: 配置.bashrc文件

export PYSPARK_PYTHON=/root/miniconda3/envs/test/bin/python

export PYSAPR_DRIVER_PYTHON=/root/miniconda3/envs/test/bin/python

export PYTHONPATH=$(ZIPS=(/root/spark/python/lib/*.zip);

IFS=:;echo "${ZIPS[*]}"):$PYTHONPATH

第五步:source 一下.barshrc 并更换到conda activate test

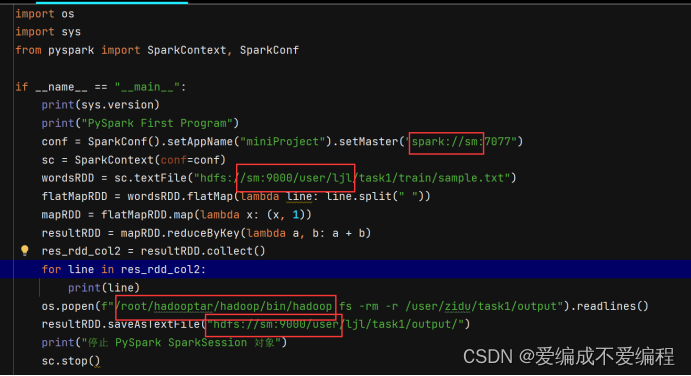

第六步:将pyspark_word_count.py 如下 更改自己的地址

第七步:在自己的test env环境下 以及spark/bin路径下运行这个pyspark_word_count.py代码

Spark_submit /opt/spark/pyspark_word_count.py

至此运行完毕 spark成功运行pyspark_word_count.py

版权归原作者 爱编成不爱编程 所有, 如有侵权,请联系我们删除。