第一步,首先使用命令启动你配置的Hadoop环境

start-dfs.sh

第二步,启动完成之后就可以来练习你的HDFS常用命令了

首先,使用以下命令查看当前服务端HDFS根目录下的文件

hadoop fs -ls /

(由于是新环境,执行完里面应该是什么都没有的)

第三步,如何在本地创建readme.txt文件并使用put命令上传到服务端

echo helloworld >> readme.txt

hadoop fs -put readme.txt /

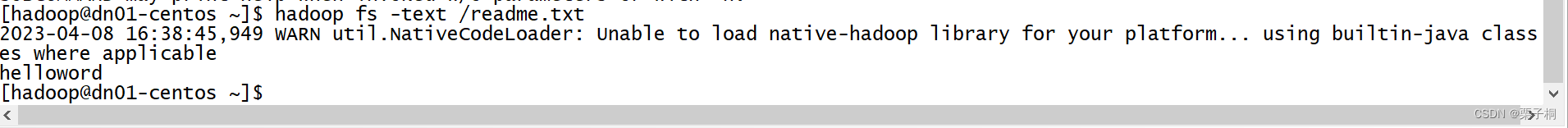

第四步,如何查看readme.txt文件内容(以下命令二选一)

hadoop fs -text /readme.txt

hadoop fs -cat /readme.txt

第五步,如何从本地拷贝文件到HDFS

echo hadoop is bigdata >> bigdata.txt

hadoop fs -copyFromLocal bigdata.txt /

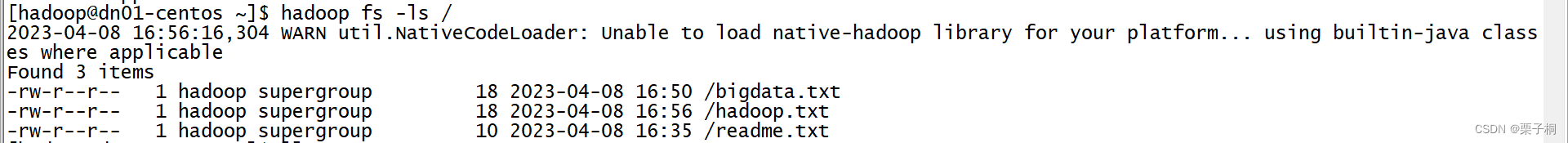

最后查看一手是否成功

hadoop fs -ls /

第六步,如何移动本地文件到HDFS

首先我们将bigdata.txt拷贝一份命名为hadoop.txt

cp bigdata.txt hadoop.txt

接着将hadoop.txt移动至hdfs服务端

hadoop fs -moveFromLocal hadoop.txt /

完成之后我们可以看一下是否移动成功

hadoop fs -ls /

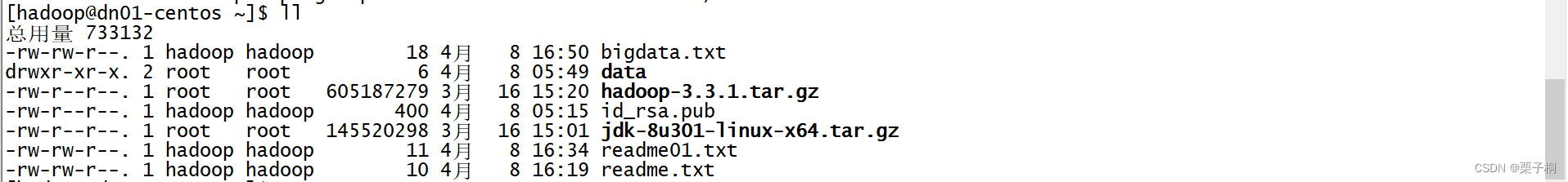

再看一下原目录是否还有hadoop.txt

ll

这样就成功将hadoop.txt移动至hdfs服务端了。

第七步,如何从HDFS上获取文件

首先我们要创建一个hdfs目录,然后进入此目录

mkdir hdfs

cd hdfs

接下来就可以将HDFS服务端上的read.txt获取到此目录

hadoop fs -get /readme.txt

最后我们ll命令看一下是否成功

ll

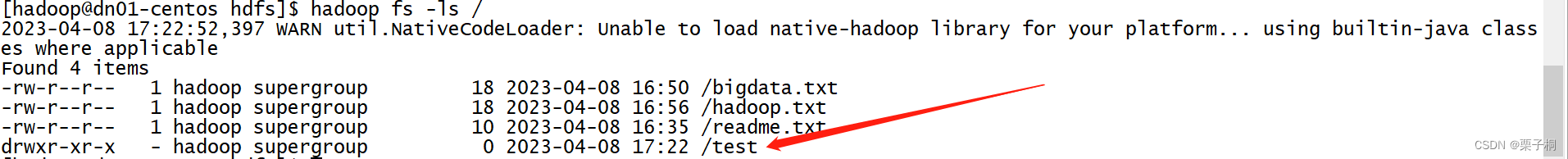

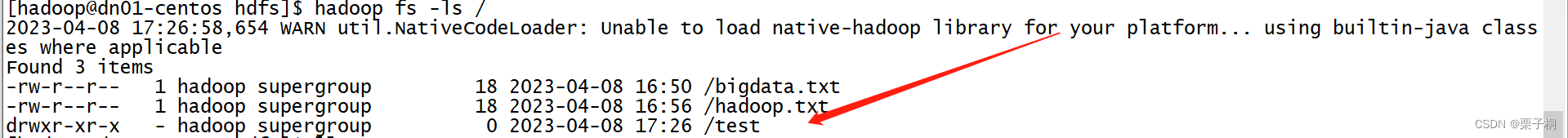

第八步,如何在HDFS上创建文件夹

hadoop fs -mkdir /test

可以查看一手是否成功

hadoop fs -ls /

第九步,如何将HDFS上readme.txt移动到test文件夹中

hadoop fs -mv /readme.txt /test

我们可以看一下是否成功,先看HDFS服务端是否还有readme.txt

hadoop fs -ls /

再看一下当前目录是否有readme.txt

ll

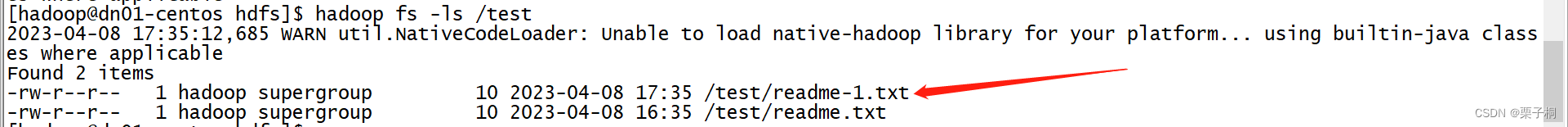

第十步,如何将HDFS上test文件夹中readme.txt拷贝

hadoop fs -cp /test/readme.txt /test/readme-1.txt

查看一下是否成功

hadoop fs -ls /test

第十一步,如何从HDFS上获取并合并文件

hadoop fs -getmerge /test ./merge.txt

查看一下是否成功

cat merge.txt

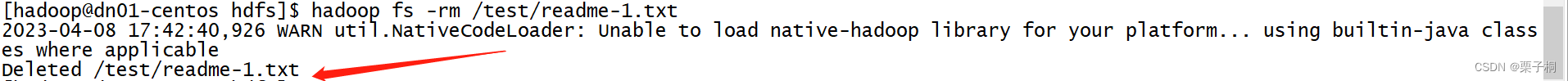

第十二步,如何从HDFS上删除文件和文件夹

hadoop fs -rm /test/readme-1.txt

出现这一行即为成功

版权归原作者 栗子桐 所有, 如有侵权,请联系我们删除。