前文请看Hadoop的搭建

Zookeeper组件

ZooKeeper 的安装包 zookeeper-3.4.8.tar.gz 已放置在 Linux 系统 /opt/software目录下。

解压安装包到指定目标,在 Master 节点执行如下命令。

tar -zxvf /opt/software/zookeeper-3.4.8.tar.gz -C /usr/local/src

mv /usr/local/src/zookeeper-3.4.8 /usr/local/src/zookeeper

配置ZooKeeper

Master 节点的配置

在 ZooKeeper 的安装目录下创建 data 和 logs 文件夹。

cd /usr/local/src/zookeeper

mkdir data && mkdir logs

在每个节点写入该节点的标识编号,每个节点编号不同,master 节点写 入 1,slave1 节点写入 2,slave2 节点写入 3。

echo 1 > /usr/local/src/zookeeper/data/myid

修改配置文件 zoo.cfg

cp /usr/local/src/zookeeper/conf/zoo_sample.cfg /usr/local/src/zookeeper/conf/zoo.cfg

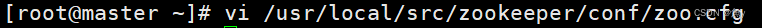

vi /usr/local/src/zookeeper/conf/zoo.cfg

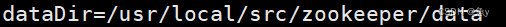

修改dataDir 参数:dataDir=/usr/local/src/zookeeper/data

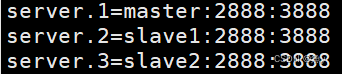

在 zoo.cfg 文件末尾追加以下参数配置,表示三个 ZooKeeper 节点的访 问端口号。

server.1=master:2888:3888

server.2=slave1:2888:3888

server.3=slave2:2888:3888

修改 ZooKeeper 安装目录的归属用户为 hadoop 用户。

chown -R hadoop:hadoop /usr/local/src/zookeeper

Slave 节点的配置

从 Master 节点复制 ZooKeeper 安装目录到两个 Slave 节点。

cd

scp -r /usr/local/src/zookeeper slave1:/usr/local/src/

scp -r /usr/local/src/zookeeper slave2:/usr/local/src/

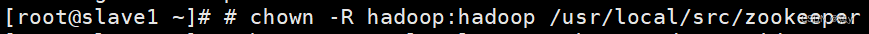

在 slave1 节点上修改 zookeeper 目录的归属用户为 hadoop 用户。

chown -R hadoop:hadoop /usr/local/src/zookeeper

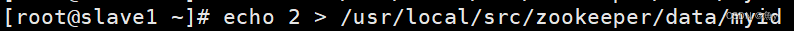

在 slave1 节点上配置该节点的 myid 为 2

echo 2 > /usr/local/src/zookeeper/data/myid

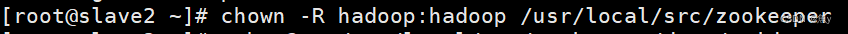

在 slave2 节点上修改 zookeeper 目录的归属用户为 hadoop 用户。

chown -R hadoop:hadoop /usr/local/src/zookeeper

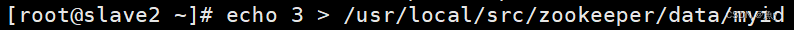

在 slave2 节点上配置该节点的 myid 为 3。

echo 3 > /usr/local/src/zookeeper/data/myid

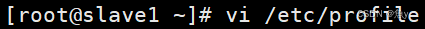

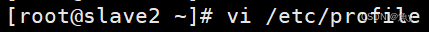

系统环境变量配置

在 master、slave1、slave2 三个节点增加环境变量配置。

vim /etc/profile

在文件末尾添加如下代码:

set zookeeper environment

ZooKeeper 安装目录

export ZOOKEEPER_HOME=/usr/local/src/zookeeper

ZooKeeper 可执行程序目录

export PATH=$PATH:$ZOOKEEPER_HOME/bin

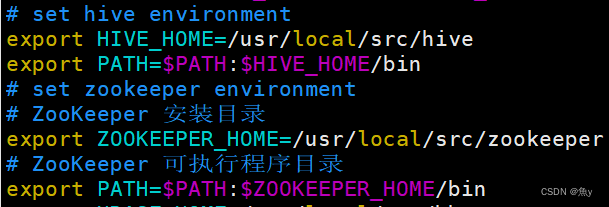

启动 ZooKeeper

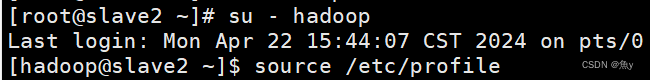

注意:启动 ZooKeeper 需要使用 Hadoop 用户进行操作。

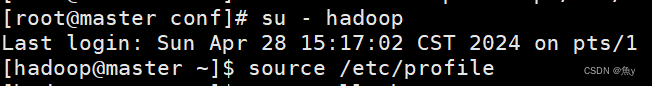

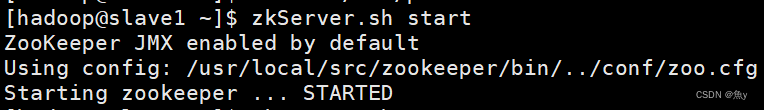

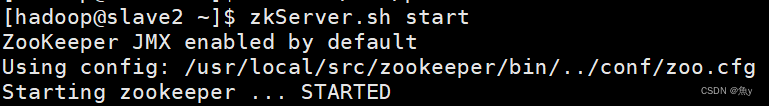

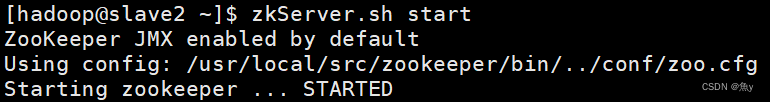

分别在 master、slave1、slave2 三个节点使用 zkServer.sh start 命令启 动ZooKeeper。

su - hadoop

source /etc/profile

启动ZooKeeper

zkServer.sh start

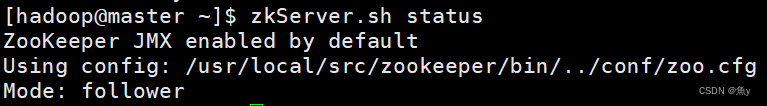

三个节点都启动完成后,再统一查看 ZooKeeper 运行状态。

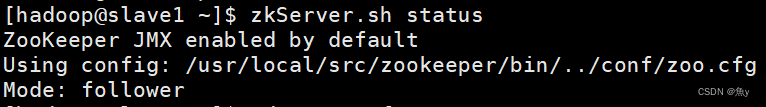

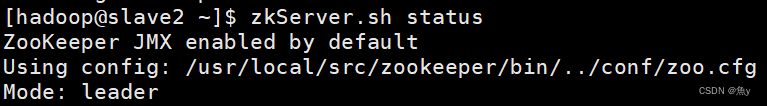

分别在 master、slave1、slave2 三个节点使用 zkServer.sh status 命令查看 ZooKeeper 状态。可以看到三个节点的状态分别为 follower、leader、 follower。三个节点会包括一个 leader 和两个 follower,每个节点地位均等, leader 是根据 ZooKeeper 内部算法进行选举,每个节点的具体状态不固定。

zkServer.sh status

Hbase数据库组件

Hbase小知识

- HBase是一个分布式的、面向列的开源数据库。

- HBase是Google BigTable的开源实现。

- HBase不同于一般的关系数据库, 适合非结构化数据存储。

- HBase是一种分布式、可扩展、支持海量数据存储的 NoSQL数据库。

- HBase在HDFS之上提供了高并发的随机写和支持实时查询。

- 基于「列式存储」,存储数据的“结构”可以地非常灵活。

Hbase 安装与配置

解压缩 HBase 安装包

tar -zxf /opt/software/hbase-1.2.1-bin.tar.gz -C /usr/local/src/

重命名 HBase 安装文件夹

cd /usr/local/src/

mv hbase-1.2.1/ hbase

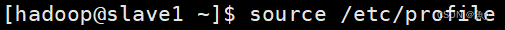

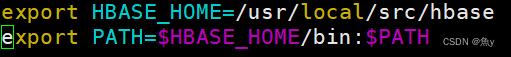

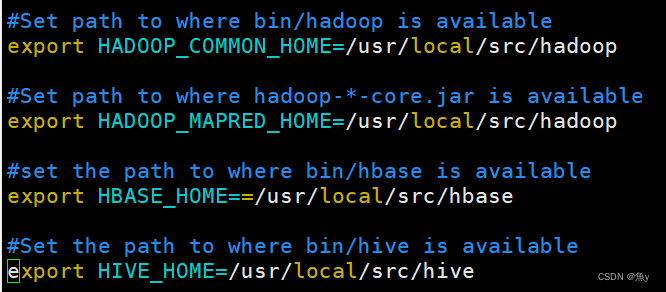

在所有节点添加环境变量(master、slave1、slave2****)

vim /etc/profile

在文件结尾处添加如下代码:

export HBASE_HOME=/usr/local/src/hbase

export PATH=$HBASE_HOME/bin:$PATH

在所有节点使环境变量生效(master、slave1、slave2****)

source /etc/profile

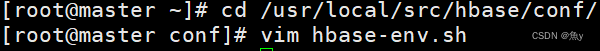

在 master 节点进入配置文件目录

cd /usr/local/src/hbase/conf/

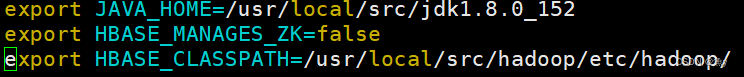

在 master 节点配置 hbase-env.sh 文件

vim hbase-env.sh

在文件结尾处添加如下代码:

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export HBASE_MANAGES_ZK=false

export HBASE_CLASSPATH=/usr/local/src/hadoop/etc/hadoop/

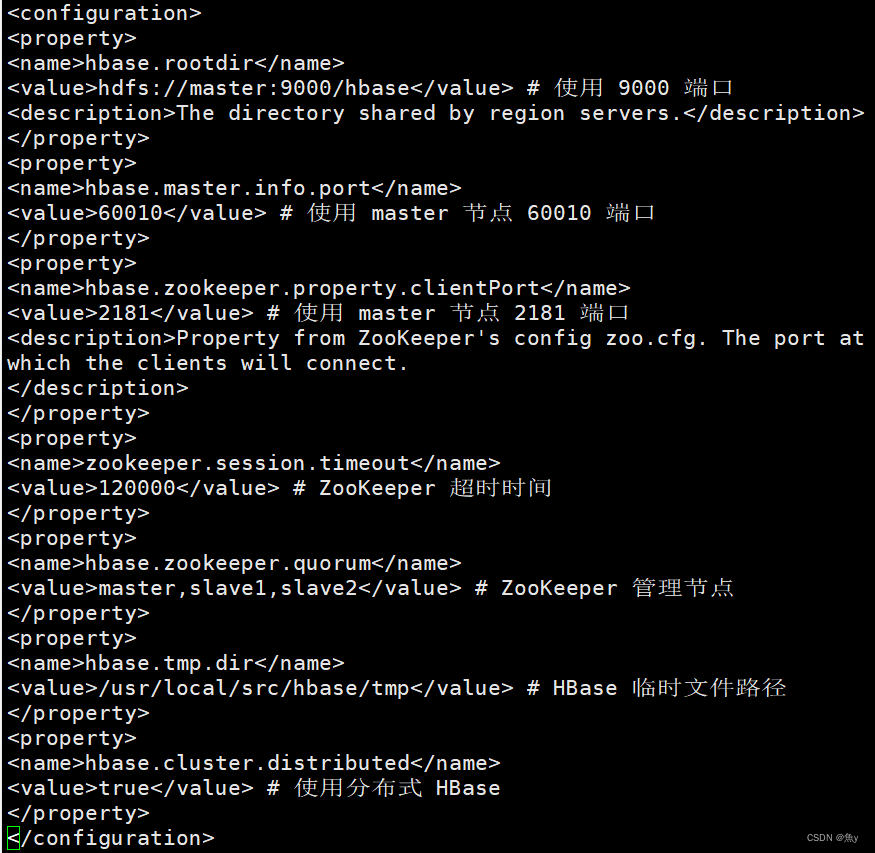

在 master 节点配置 hbase-site.xml

vi hbase-site.xml

<configuration> <property> <name>hbase.rootdir</name> <value>hdfs://master:9000/hbase</value> # 使用 9000 端口 <description>The directory shared by region servers.</description> </property> <property> <name>hbase.master.info.port</name> <value>60010</value> # 使用 master 节点 60010 端口 </property> <property> <name>hbase.zookeeper.property.clientPort</name> <value>2181</value> # 使用 master 节点 2181 端口 <description>Property from ZooKeeper's config zoo.cfg. The port at which the clients will connect. </description> </property> <property> <name>zookeeper.session.timeout</name> <value>120000</value> # ZooKeeper 超时时间 </property> <property> <name>hbase.zookeeper.quorum</name> <value>master,slave1,slave2</value> # ZooKeeper 管理节点 </property> <property> <name>hbase.tmp.dir</name> <value>/usr/local/src/hbase/tmp</value> # HBase 临时文件路径 </property> <property> <name>hbase.cluster.distributed</name> <value>true</value> # 使用分布式 HBase </property> </configuration>

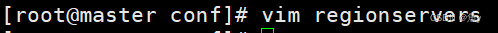

在 master 节点修改 regionservers 文件

vim regionservers

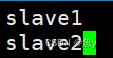

添加如下代码:

slave1

slave2

在 master 节点创建 hbase.tmp.dir 目录

mkdir /usr/local/src/hbase/tmp

将 master 上的 hbase 安装文件同步到 slave1 slave2

scp -r /usr/local/src/hbase/ root@slave1:/usr/local/src/

scp -r /usr/local/src/hbase/ root@slave2:/usr/local/src/

在所有节点修改 hbase 目录权限(master、slave1、slave2****)

chown -R hadoop:hadoop /usr/local/src/hbase/

在所有节点切换到 hadoop 用户(master、slave1、slave2****)

su - hadoop

source /etc/profile

启动 HBase

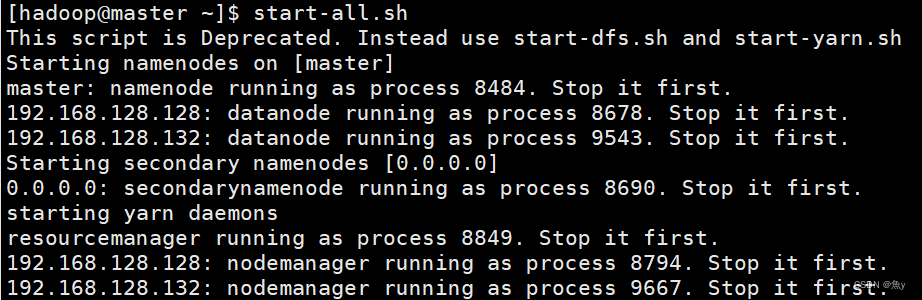

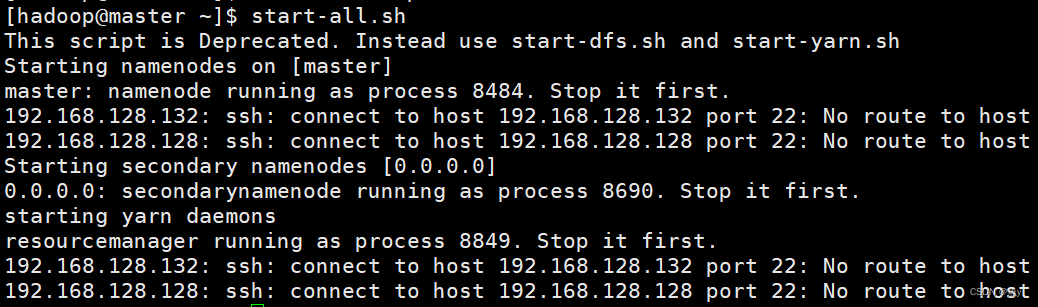

start-all.sh

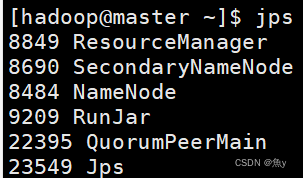

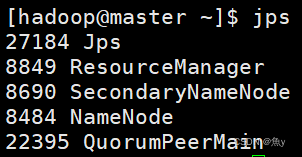

jps

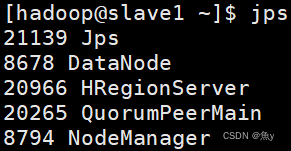

jps

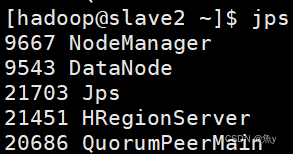

jps

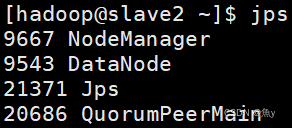

在所有节点启动 ZooKeeper

(master、slave1、slave2****)

zkServer.sh start

jps

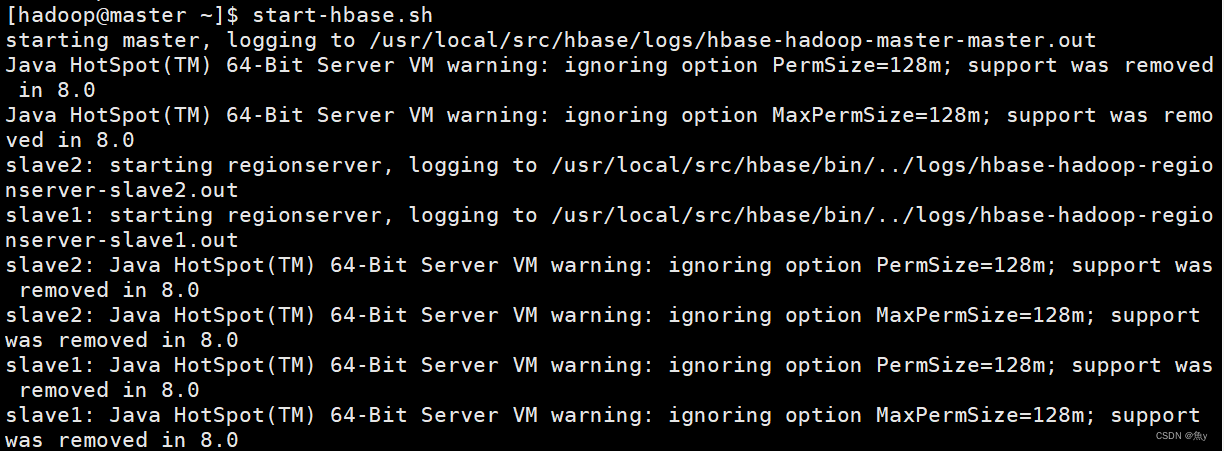

在 master 节点启动 HBase

start-hbase.sh

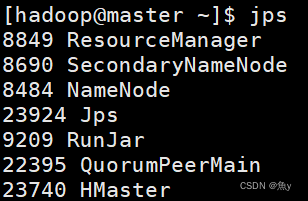

jps

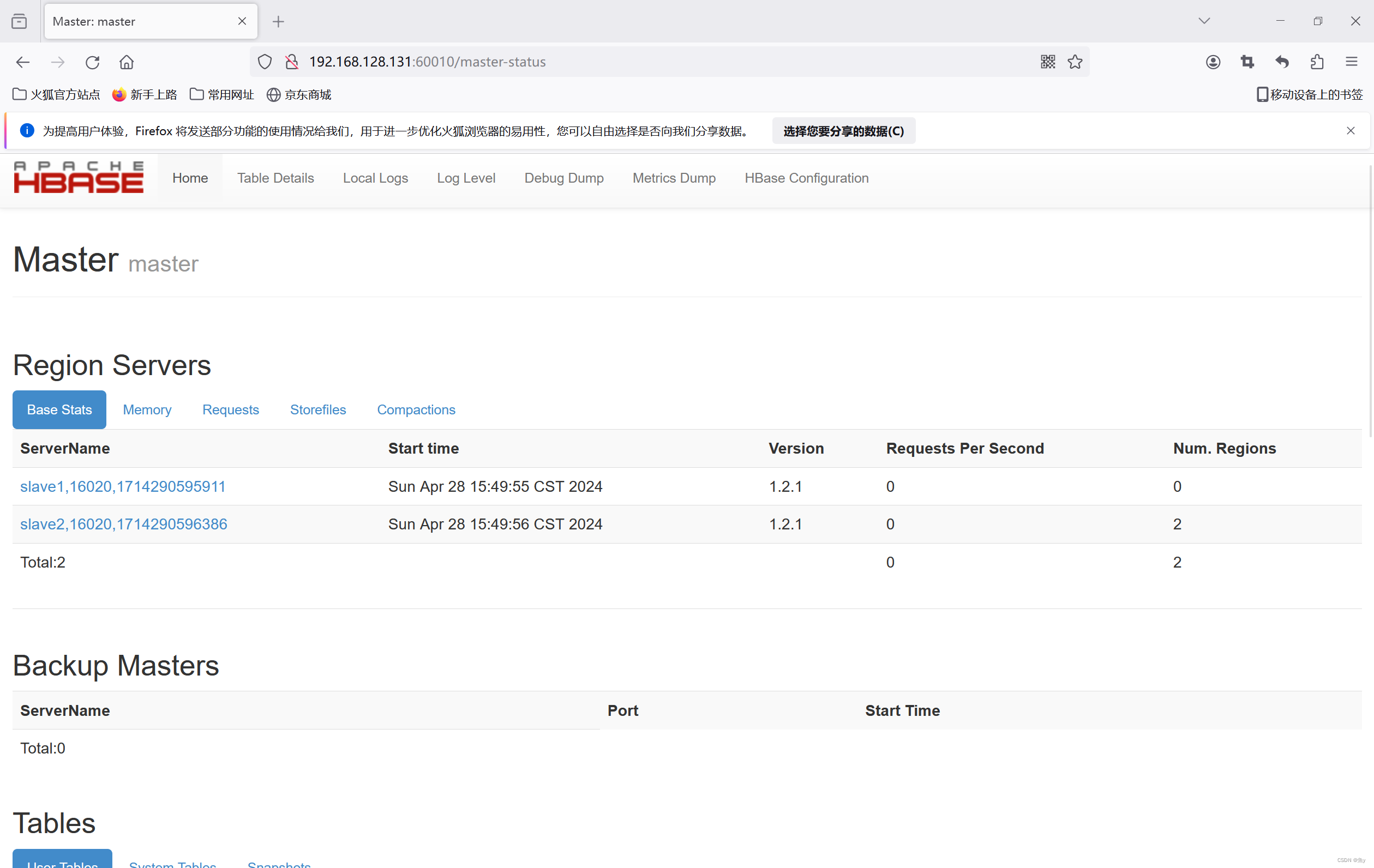

在浏览器输入192.168.128.131:60010 出现如下图所示界面。

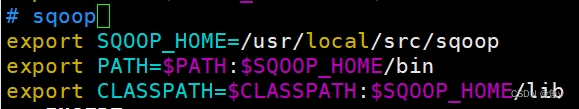

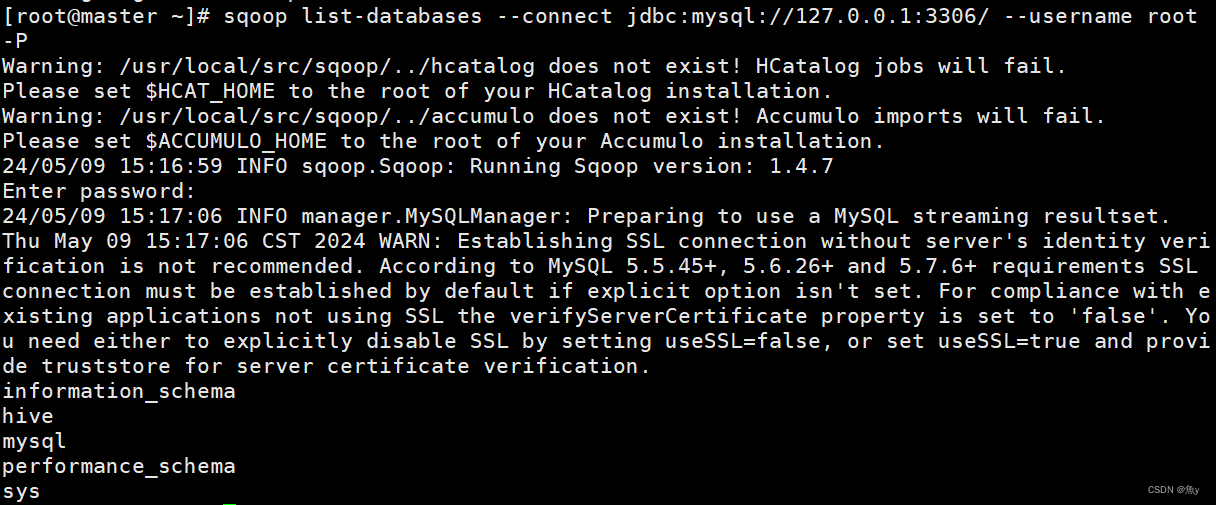

tar -zxf /opt/software/sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz -C /usr/local/src/

cd /usr/local/src/

mv sqoop-1.4.7.bin__hadoop-2.6.0/ sqoop

cd /usr/local/src/sqoop/conf/

cp sqoop-env-template.sh sqoop-env.sh

cp sqoop-env-template.sh sqoop-env.sh

vim /etc/profile

cp /opt/software/mysql-connector-java-5.1.47.jar /usr/local/src/sqoop/lib/

版权归原作者 魚y 所有, 如有侵权,请联系我们删除。