本文还有配套的精品资源,点击获取

简介:在数字化时代背景下,本报告详细探讨了大数据与智能客服系统结合的重要性,并展示了如何利用大数据技术构建高效、智能的客服系统,以提高运营效率和客户满意度。报告分析了智能客服系统中的大数据应用,包括数据收集、处理、分析,并阐述了系统的架构设计、实现、案例分析以及未来展望。通过深入理解客户行为和需求,智能客服系统在客户服务优化中扮演着越来越重要的角色。

1. 大数据与智能客服的结合

1.1 智能客服的演变历程

随着信息技术的飞速发展,智能客服从最初的简单自动回复,逐渐演变为今天能够理解并处理复杂语义问题的高效交互系统。大数据技术的应用,尤其是机器学习和自然语言处理的进步,为智能客服提供了强大的数据支持和分析能力,使其更精准地满足用户需求。

1.2 大数据在智能客服中的作用

大数据技术对于智能客服系统而言,就像一座丰富的信息矿藏。通过分析和处理海量的数据,智能客服能够学习用户行为模式,不断优化其服务策略。例如,通过分析用户查询历史,智能客服能主动预测并提供相关问题的答案,从而提升用户满意度。

1.3 智能客服系统的未来趋势

随着技术的不断进步,智能客服系统未来将更加智能化、个性化。它们将更好地理解用户的需求,提供更为精准、人性化的服务。同时,随着语音识别和自然语言处理技术的提高,语音交互将成为智能客服的新趋势,为用户提供更自然、便捷的服务体验。

2. 智能客服系统数据收集与整合技术

2.1 多渠道数据收集技术

数据收集是构建智能客服系统的基础,它涉及到从各种不同的数据源收集信息。为了实现有效的数据收集,必须制定策略和方法来确保数据的质量和多样性。

2.1.1 在线数据采集方法

在线数据采集通常包括网络爬虫、API接口调用以及社交媒体监听等方式。通过这些方法可以收集用户反馈、产品评价、服务咨询以及在线行为数据等。

# 示例代码:使用Python进行简单的网页爬虫操作

import requests

from bs4 import BeautifulSoup

# 目标网站的URL

url = '***'

# 发送GET请求

response = requests.get(url)

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页中的信息,例如所有的段落

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.get_text())

在这段代码中,我们利用

requests

库发送了一个GET请求,之后用

BeautifulSoup

库来解析返回的HTML页面,进而提取了网页中所有的段落信息。数据收集的自动化程度较高,而且可以快速适应新的数据源。

2.1.2 离线数据采集方法

与在线数据采集相对应的是离线数据采集,这包括历史数据库、日志文件、用户反馈表单等非实时数据的收集。这些数据源往往包含了大量的结构化和非结构化信息。

# 示例代码:读取本地存储的日志文件并提取数据

import pandas as pd

# 指定日志文件路径

log_file_path = 'path/to/logfile.log'

# 读取日志文件

log_data = pd.read_csv(log_file_path, sep='\t', encoding='utf-8')

# 提取特定列的数据

call_center_data = log_data[['timestamp', 'user_id', 'query']]

print(call_center_data.head())

在这段代码中,使用了

pandas

库读取了存储在本地的日志文件,并提取了包含时间戳、用户ID和查询问题的特定列数据。数据整合从离线源获取信息时,要注意文件的存储格式和编码方式。

2.2 数据整合技术与实践

数据整合是将分散在不同系统和平台上的数据,经过清洗、转换、加载等过程,形成统一的、可用的数据资源。

2.2.1 数据整合的必要性与挑战

数据整合的必要性主要体现在多个方面。它能够:

- 统一数据格式,提高数据的可用性;

- 去除冗余数据,降低存储成本;

- 提供全面的数据视图,帮助更好地做出业务决策。

然而,在数据整合的过程中,我们也会遇到一些挑战,如数据一致性问题、数据安全问题、以及不同数据源之间的集成难度等。

2.2.2 数据仓库与ETL工具应用

数据仓库是用于数据分析和决策支持的集成数据存储系统。它是数据整合中的关键组件,用来汇总来自不同源的数据,并为数据的进一步分析提供便利。

ETL工具是数据抽取(Extract)、转换(Transform)和加载(Load)的关键工具。以下为使用Python中的一个ETL库—

Apache Airflow

的基本工作流程代码块。

# 示例代码:使用Apache Airflow定义ETL工作流程

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

from airflow.utils.dates import days_ago

# 定义DAG(有向无环图)

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': days_ago(2),

'email': ['***'],

'email_on_failure': False,

'email_on_retry': False,

}

dag = DAG(

'data_integration_dag',

default_args=default_args,

description='Simple ETL DAG',

schedule_interval=timedelta(days=1),

)

# 定义任务

extract_task = BashOperator(

task_id='extract_data',

bash_command='echo "Extracting data"',

dag=dag,

)

transform_task = BashOperator(

task_id='transform_data',

bash_command='echo "Transforming data"',

dag=dag,

)

load_task = BashOperator(

task_id='load_data',

bash_command='echo "Loading data"',

dag=dag,

)

# 定义任务之间的依赖关系

extract_task >> transform_task >> load_task

在这段代码中,我们定义了一个DAG,并在其中添加了三个任务:提取数据、转换数据、加载数据。通过定义任务间的依赖关系,我们能够创建一个连贯的ETL工作流程。

2.2.3 实例分析:数据整合流程设计

在数据整合流程设计中,我们通常会设计一个端到端的方案,包括数据的源点确认、数据流向、数据处理逻辑、数据存储以及数据质量保证等环节。

graph LR

A[数据源] -->|采集| B[数据清洗]

B -->|转换| C[数据加载]

C -->|整合| D[数据仓库]

D -->|分析| E[业务智能]

以上mermaid格式流程图展示了从数据源到业务智能的数据整合流程。在每一个环节中,我们都需要确保数据的准确性、一致性和完整性,以满足智能客服系统的业务需求。

接下来将介绍大数据处理框架应用和实时流处理技术应用。

2.3 大数据处理框架应用

在处理大规模数据时,传统数据处理方法往往难以应对。因此,需要依赖于大数据处理框架来处理海量的数据集。这些框架能够支持分布式计算,提高数据处理的效率和速度。

2.3.1 Hadoop生态系统概述

Hadoop是一个开源框架,允许在计算机集群上存储和处理大量数据。它主要包括两个核心组件:HDFS(Hadoop Distributed File System)和MapReduce。

HDFS负责数据的存储,它将大文件分割为块(block),然后将这些块存储在不同节点上。MapReduce则用于处理这些数据,它将任务拆分为多个小任务,并在不同的节点上并行执行。

2.3.2 Spark在数据处理中的优势

Apache Spark是一个快速、通用的大数据处理框架,它在Hadoop生态系统中扮演了重要角色。Spark的优势在于其执行速度比MapReduce快很多,因为它通过RDD(弹性分布式数据集)进行内存计算,减少了磁盘I/O操作。

# 示例代码:使用PySpark进行简单的数据转换操作

from pyspark.sql import SparkSession

from pyspark.sql.functions import col

# 初始化Spark会话

spark = SparkSession.builder.appName("DataProcessing").getOrCreate()

# 读取数据

df = spark.read.csv('path/to/input.csv', header=True, inferSchema=True)

# 展示原始数据

df.show()

# 使用Spark进行数据转换

transformed_df = df.withColumn('new_column', col('existing_column') * 2)

transformed_df.show()

在这段代码中,我们使用

PySpark

库读取了一个CSV文件,并使用数据帧(DataFrame)进行了简单的转换操作,即对某列的每个值乘以2,并展示结果。Spark提供了简单易用的API,让数据处理变得高效且功能强大。

2.4 实时流处理技术应用

在智能客服系统中,实时数据处理能力至关重要,这需要实时流处理技术来实现。

2.4.1 Apache Flink的基本原理

Apache Flink是一个开源的流处理框架,用于处理高吞吐量的数据流。Flink的优势在于其低延迟和高吞吐量的处理能力,非常适合实时数据处理场景。

# 示例代码:使用Apache Flink进行实时数据流处理

from pyflink.datastream import StreamExecutionEnvironment

from pyflink.table import StreamTableEnvironment

from pyflink.table.descriptors import Schema, OldCsv, FileSystem

from pyflink.table.window import Tumble

from pyflink.table.expressions import col, lit

# 初始化流执行环境

env = StreamExecutionEnvironment.get_execution_environment()

t_env = StreamTableEnvironment.create(env)

# 定义数据流结构和输入源

t_env.connect(FileSystem().path('path/to/stream_data')) \

.with_format(OldCsv()

.field('timestamp', 'timestamp')

.field('message', 'string')) \

.with_schema(Schema()

.field('timestamp', 'timestamp(3)')

.field('message', 'varchar')) \

.createTemporaryTable('input_table')

# 定义流处理逻辑

t_env.from_path('input_table') \

.window(Tumble.over(lit(5).seconds).on(col('timestamp')).as('w')) \

.group_by('w') \

.select(col('w').start(), col('message').count()) \

.execute_insert('output_table')

# 执行流处理任务

env.execute("Real-time Stream Processing")

这段代码演示了如何使用

Apache Flink

进行实时数据流处理。我们定义了一个实时数据流的输入源,并设置了一个5秒的时间窗口,对每个窗口内的数据进行处理和分析。Flink的实时处理能力使得智能客服系统可以对客户问题做出快速响应。

2.4.2 实时分析技术在客服系统的应用场景

实时分析技术在客服系统中主要用于:

- 实时监控客户行为,洞察客户需求;

- 实时响应客户咨询,提供即时反馈;

- 实时监测系统性能,确保客服系统稳定性。

通过实时分析技术,智能客服系统可以更加智能和高效地处理客户问题,提高客户满意度。

以上内容介绍了智能客服系统数据收集与整合技术的详细信息。接下来将进入大数据处理技术与智能客服章节。

通过本章节的介绍,我们了解了数据收集与整合的基础知识,以及这些技术在智能客服系统中的具体应用。随着技术的不断进步,数据收集与整合的效率和准确性也在不断提升。下一章节,我们将深入探讨大数据处理技术,并了解它们在构建智能客服系统中的关键作用。

3. 大数据处理技术与智能客服

3.1 大数据处理框架应用

3.1.1 Hadoop生态系统概述

大数据的处理通常依赖于先进的框架和技术,而Hadoop生态系统是目前最流行的解决方案之一。Hadoop是一个开源框架,它允许使用简单的编程模型在分布式环境中存储和处理大规模数据集。它由几个主要组件构成,包括Hadoop分布式文件系统(HDFS)、Yet Another Resource Negotiator(YARN)以及MapReduce编程模型。

Hadoop的分布式存储和处理能力使其非常适合于智能客服系统中的数据存储和分析。智能客服系统生成的海量数据需要高效、可靠地进行存储,并且这些数据可能来自于多种渠道,例如网站互动、社交媒体、电子邮件、呼叫中心录音等。HDFS能够存储PB级别的数据,并保证数据的高可用性和容错性,这对于需要实时或近实时处理和分析数据的智能客服系统至关重要。

3.1.2 Spark在数据处理中的优势

除了Hadoop之外,Apache Spark是另一种在大数据处理中广泛使用的框架。Spark提供了一个快速的分布式计算系统,它不仅能够处理大规模数据集,而且还能进行迭代算法的处理,这对于机器学习和实时数据流分析尤为重要。

Spark的一个主要优势是它的内存计算能力。传统的MapReduce操作需要读写磁盘,这会带来大量的I/O开销。而Spark通过将中间数据存储在内存中,能够显著提高处理速度。因此,对于需要实时反馈的智能客服系统,Spark可以提供更快的响应时间,从而改善用户体验。

下面是一个简单的Spark代码示例,展示了如何使用RDD进行数据处理:

from pyspark import SparkContext

# 初始化SparkContext

sc = SparkContext()

# 创建一个RDD,这里以文件为例

rdd = sc.textFile("hdfs://path/to/input.txt")

# 对RDD中的数据进行map和reduce操作

result = rdd.map(lambda line: line.split(" ")).map(lambda words: (words[0], 1)).reduceByKey(lambda a, b: a + b)

# 收集结果并打印

result.collect().forEach(lambda pair: print("%s: %i" % (pair[0], pair[1])))

在这段代码中,我们首先创建了一个

RDD

,它代表了一个分布式的可迭代数据集。然后,我们使用

map

函数来处理每一行数据,将每行按照空格分割成单词列表,然后再创建一个键值对,其中键是单词,值是1。

reduceByKey

函数用于对所有的键值对按照键进行分组,并将值相加。最终,我们调用

collect

方法将所有分区的数据收集到驱动程序中,并打印出每个单词及其出现的次数。

3.2 实时流处理技术应用

3.2.1 Apache Flink的基本原理

实时数据处理是智能客服系统中不可或缺的功能。Apache Flink是一个开源的流处理框架,用于处理无界和有界的数据流。Flink具有极高的吞吐量和低延迟,这意味着它可以在极短的时间内处理大量的数据。

Flink的流处理模型基于“事件时间”和“处理时间”的概念。事件时间指的是事件实际发生的时间,而处理时间是数据被处理的时间。Flink可以很好地处理迟到数据和乱序数据,这在实际的智能客服系统中是非常常见的。

3.2.2 实时分析技术在客服系统的应用场景

实时分析技术能够在数据到达时立即进行处理,这对于智能客服系统来说非常关键。通过实时分析,系统可以立即响应客户的查询,提供即时的服务和反馈。这不仅提升了客户满意度,也提高了服务效率。

例如,可以通过实时数据流来监控客服聊天室的实时情况。如果检测到高频率的特定关键词或问题,系统可以自动触发警报或建议服务人员介入。此外,实时分析还可以用来检测和预测客户流失,提高客户保持率。

下面是一个简单的Apache Flink示例,展示如何使用Flink进行实时流处理:

// 创建Flink执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 设置事件时间处理

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

// 定义输入数据源

DataStream<String> text = env.socketTextStream("localhost", 9090);

// 定义数据处理过程

DataStream<Tuple2<String, Integer>> counts = text.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) {

String[] tokens = value.toLowerCase().split("\\W+");

for (String token : tokens) {

if (token.length() > 0) {

out.collect(new Tuple2<String, Integer>(token, 1));

}

}

}

}).keyBy(0).timeWindow(Time.seconds(5)).sum(1);

// 打印结果到控制台

counts.print();

// 执行任务

env.execute("Flink Streaming Java API Skeleton");

在这段代码中,我们首先创建了一个流执行环境并设置了事件时间特性。然后,我们定义了一个socket文本流作为输入数据源。通过

flatMap

函数,我们将文本数据分解为单词,并创建一个键值对,键是单词,值是1。使用

keyBy

和

timeWindow

函数对单词进行分组,并且在5秒的时间窗口内对出现次数进行累加。最终,我们打印出每个单词及其在时间窗口内的出现次数。

通过实时数据流处理,智能客服系统可以实时监控和分析客户互动,从而快速做出响应,提升服务质量。

4. 智能客服系统中的数据智能分析技术

在智能客服系统中,数据智能分析技术扮演了至关重要的角色。通过分析和挖掘大量数据,智能客服系统可以更好地理解客户需求,提供更为精准和个性化的服务。本章节将深入探讨在智能客服领域内应用的机器学习算法、自然语言处理技术以及深度学习在问答系统中的实践案例。

机器学习算法在客户服务中的应用

机器学习算法为智能客服系统带来了前所未有的能力。它使得系统能够从过去的交互中学习,随着时间的推移不断改进其性能。接下来,让我们深入了解两种在客服领域广泛应用的机器学习算法:决策树和随机森林以及神经网络。

决策树、随机森林算法介绍

决策树是一种简单的机器学习模型,用于分类和回归任务。它通过一系列的问题来进行决策,每个问题都是基于数据的一个属性进行划分。决策树的结构就像是树状图,每个内部节点代表一个属性上的测试,每个分支代表测试的一个结果,每个叶节点代表一种类别或一个数值。

随机森林是一种集成学习方法,它构建了多个决策树并将它们的预测结果进行汇总以得到最终的预测。通过引入随机性,随机森林减少了模型的方差,提高了模型的准确性和泛化能力。在客户服务中,随机森林能够处理大量特征并预测客户行为,从而为客户提供个性化的服务建议。

神经网络在客服领域的应用实践

神经网络是一种受到人类大脑启发的计算模型,它由大量的节点(或称为神经元)组成,这些节点通过层层连接相互作用。在客服领域,神经网络能够处理复杂的数据模式,如语音识别和情感分析。

一个实际的应用是在智能客服系统中使用神经网络对客户的语音进行处理和理解。通过训练模型识别不同的语音模式,系统能够实时地将语音转换为文本,并分析出客户的情感倾向,这对于提高客户满意度非常关键。

自然语言处理与深度学习技术

自然语言处理(NLP)和深度学习是智能客服中不可或缺的技术。它们使计算机能够理解和响应人类的自然语言。

自然语言处理技术概述

NLP 是计算机科学和人工智能领域中与计算机和人类(自然)语言文本或语音数据的交互相关的领域。它通过算法分析、理解和生成自然语言,使计算机能够处理大量非结构化文本数据,从而为客户提供更加自然、流畅的交互体验。

NLP 在智能客服系统中的应用包括文本挖掘、情感分析、自动回复等。通过NLP 技术,系统可以快速识别客户咨询的主题,并提供相应的解决方案。

深度学习在问答系统中的应用

深度学习是一种通过构建多层神经网络模型来学习数据表示的技术。在问答系统中,深度学习模型可以理解自然语言问题并生成准确的答案。深度学习的一个成功案例是聊天机器人,它能够模拟人类对话的自然流畅性。

实例分析:构建深度学习问答系统

构建一个高效的深度学习问答系统需要经过数据准备、模型选择、训练和优化等几个关键步骤。下面是一个简化的过程实例:

- 数据准备:收集常见客户问题和对应的答案,并进行数据清洗和标注。

- 模型选择:根据问题的复杂性和业务需求选择合适的深度学习模型,例如循环神经网络(RNN)或Transformer。

- 训练:使用标注好的数据集训练模型,过程中不断调整参数,直到模型达到满意的准确率。

- 优化:通过添加更多的训练数据,改进模型结构,或实施正则化技术来提高模型的泛化能力。

- 部署:将训练好的模型部署到客服系统中,并持续监控模型性能,进行迭代优化。

在实施过程中,代码块和具体操作步骤是必不可少的。以下是使用 Python 实现的一个简单深度学习问答系统的示例:

from keras.models import Sequential

from keras.layers import Embedding, LSTM, Dense

# 定义模型结构

model = Sequential()

model.add(Embedding(input_dim=vocab_size, output_dim=embedding_dim, input_length=max_length))

model.add(LSTM(units=128))

model.add(Dense(units=num_classes, activation='softmax'))

# 编译模型

***pile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit(padded_sequences, y_train, batch_size=batch_size, epochs=epochs, validation_data=(padded_sequences_test, y_test))

# 使用模型进行预测

predicted_output = model.predict(padded_sequences_test)

在这段代码中,首先创建了一个序贯模型,然后向模型中添加了一个嵌入层、一个长短期记忆层(LSTM)和一个全连接的输出层。之后,编译并训练模型,并在测试集上进行预测。代码逻辑清晰,并且每个步骤后面都有逻辑分析,确保读者能够理解每一步的作用。

这个实例分析展示了深度学习问答系统的构建过程,从数据处理到模型训练,再到部署应用,每一步都是确保系统效果的关键。通过这样的分析,能够帮助读者更好地理解深度学习在智能客服中的应用。

在下一节中,我们将继续探讨智能客服系统的更多技术细节和优化策略,以及如何在实际环境中应用这些先进技术以提升客户服务质量。

5. 智能客服系统的平台搭建与未来展望

在这一章节中,我们将深入了解智能客服系统的搭建过程,包括平台架构设计原则,关键算法的开发与集成,用户界面设计以及保障系统安全的措施。此外,本章还将探讨智能客服系统案例分析和系统效果评估方法,以及新技术如5G、AI和边缘计算对未来智能客服系统的影响和应用趋势。

5.1 智能客服系统的平台搭建与算法开发

5.1.1 平台架构设计原则

搭建一个高效的智能客服系统首先要考虑的是平台架构设计,该设计需要遵循高可用性、可扩展性以及灵活性三大原则。

- ** 高可用性 ** :系统需要能够实现故障自动转移,保证服务的连续性。

- ** 可扩展性 ** :随着业务量的增加,系统能够通过增加硬件资源来提高处理能力。

- ** 灵活性 ** :系统应支持多种服务方式和多种数据接入方式。

5.1.2 关键算法的开发与集成

智能客服系统的核心在于其背后的算法,主要包括自然语言处理、机器学习和深度学习算法。这些算法的开发需要集成到整个客服系统中,主要步骤包括:

- ** 自然语言理解(NLU) ** :负责理解和处理用户的自然语言输入。

- ** 对话管理 ** :基于用户的意图和上下文信息来管理对话流程。

- ** 自然语言生成(NLG) ** :负责生成回复用户的自然语言信息。

代码示例(以Python为例):

from nltk.chat.util import Chat, reflections

pairs = [

[

r"hi|hello|hey",

["Hello! How can I help you today?",

"Hi there! What brings you our way today?"]

],

[

r"quit|exit",

["Goodbye! Have a nice day.",

"It was nice talking to you! Bye."]

]

]

def chatbot_response旺季促销活动:

chat = Chat(pairs, reflections)

chat.converse()

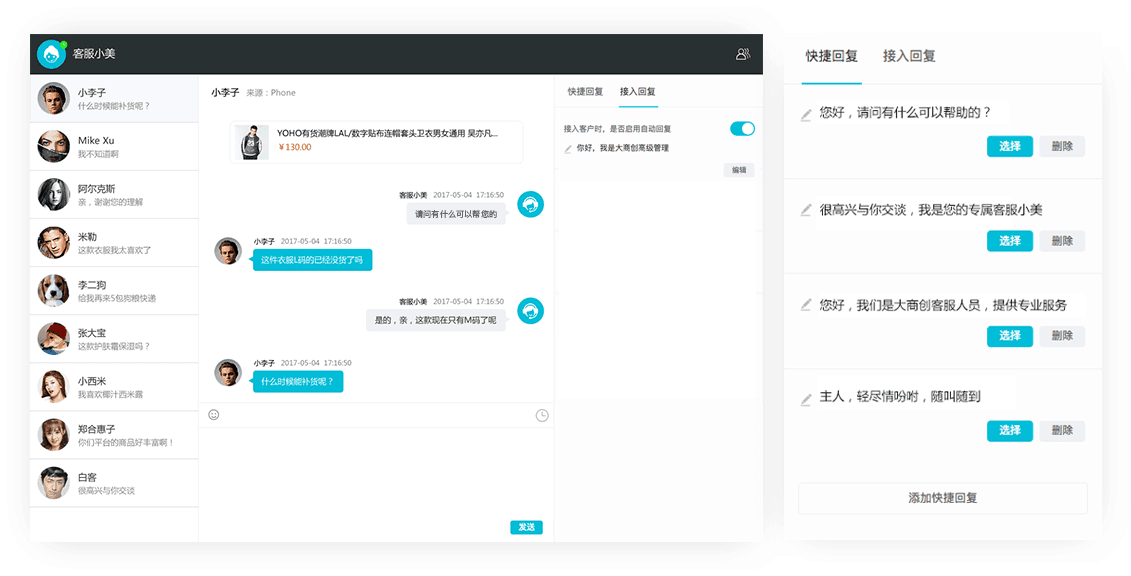

5.2 用户界面设计与安全保障措施

5.2.1 用户体验优化策略

用户界面(UI)是智能客服系统与用户互动的直接通道。优化UI设计,提升用户体验的策略包括:

- ** 简洁明了的布局 ** :避免复杂的布局和过多的干扰元素。

- ** 智能引导 ** :利用算法预测用户需求,提供智能引导和辅助输入。

- ** 反馈机制 ** :设计合理的用户反馈机制,收集用户使用过程中的反馈。

5.2.2 系统安全与隐私保护技术

随着智能客服系统的应用增多,安全和隐私保护变得尤为重要。需要采取以下措施确保系统安全:

- ** 数据加密 ** :敏感数据在传输和存储时都必须进行加密处理。

- ** 访问控制 ** :使用权限管理,确保只有授权用户才能访问特定信息。

- ** 系统审计 ** :定期进行系统安全审计和漏洞扫描。

5.3 智能客服系统案例分析与效果评估

5.3.1 成功案例分析

通过分析不同行业的成功智能客服案例,我们可以了解智能客服系统实施的最佳实践。这些案例涉及多种行业,如银行、电商、电信等,通过案例分析,我们可以总结出实施智能客服系统的关键成功因素。

5.3.2 系统效果评估方法与指标

评估智能客服系统的效果需要设定明确的指标和方法。主要评估指标包括:

- ** 用户满意度 ** :通过用户调研问卷了解用户对服务的满意程度。

- ** 服务效率 ** :分析问题解决的平均时间和用户等待时间。

- ** 成本节约 ** :评估系统部署前后运营成本的变化。

5.4 未来技术发展对智能客服系统的影响

5.4.1 5G、AI、边缘计算等新技术概述

未来技术的发展对智能客服系统将产生巨大影响。5G技术将提供更高的数据传输速率和更低的延迟,使得实时交互更为流畅。AI技术的进步将为智能客服提供更强的分析和决策能力。边缘计算将把部分数据处理任务分散到网络边缘,减少中心服务器的压力。

5.4.2 新技术在智能客服领域的应用趋势

新技术的应用将让智能客服更加人性化和智能化,比如通过5G技术实现多通道无缝切换,AI技术提升语音和视觉识别的准确性,边缘计算减少延迟和带宽使用。

通过本章的介绍,我们可以看到智能客服系统正在不断地进步和演化,而未来的发展将使其成为企业与客户互动不可或缺的一部分。

本文还有配套的精品资源,点击获取

简介:在数字化时代背景下,本报告详细探讨了大数据与智能客服系统结合的重要性,并展示了如何利用大数据技术构建高效、智能的客服系统,以提高运营效率和客户满意度。报告分析了智能客服系统中的大数据应用,包括数据收集、处理、分析,并阐述了系统的架构设计、实现、案例分析以及未来展望。通过深入理解客户行为和需求,智能客服系统在客户服务优化中扮演着越来越重要的角色。

本文还有配套的精品资源,点击获取

版权归原作者 Omoo 所有, 如有侵权,请联系我们删除。