24.4k Star!Flowise :LLM开源低代码工具、可视化的LangChain实现、可定制AI Agent

Aitrainee | 公众号:AI进修生:AI算法工程师 / Prompt工程师 / ROS机器人开发者 | 分享AI动态与算法应用资讯,提升技术效率。

排版不佳,公众号阅读原文:24.4k Star!Flowise :LLM开源低代码工具、可视化的LangChain实现、可定制AI Agent

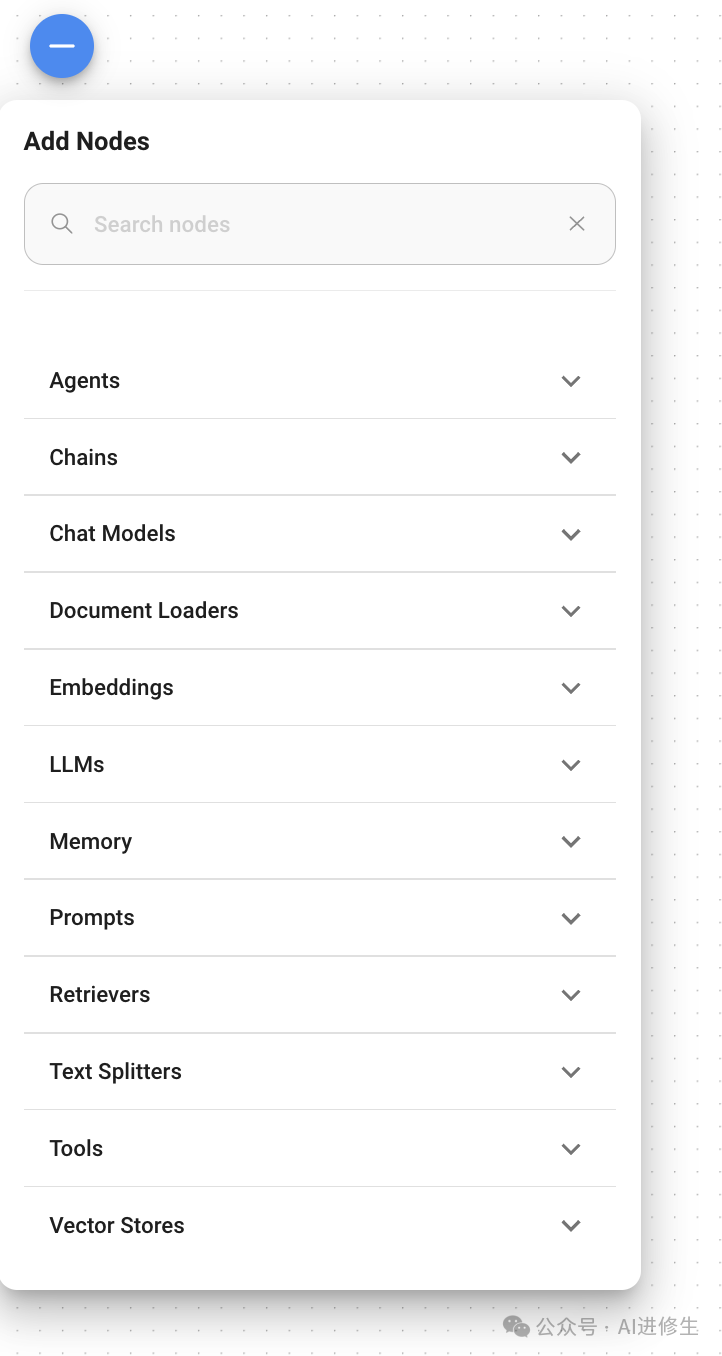

🌟拖放 UI 以构建您的定制 LLM 流程:

Flowise,一个用户友好的、无代码的平台,它简化了构建LangChain工作流的过程, 允许开 发人员创建LLM应用程序,而无需编写代码。

F lowise的关键特性,包括拖放式UI、用户友好性和多功能性。

通过直观的拖放界面简化LangChain流程开发

Flowise为开发人员提供了一个特殊的工具,旨在构建LLM应用程序,而无需深入研究编码。

对于努力以敏捷方式快速构建原型并开发LLM应用程序的组织来说,这同样是有益的。让我们来看看Flowise AI的一些突出功能:

- • 拖放式UI: Flowise使设计自己的自定义LLM流程变得简单。

- • 开源: 作为一个开源项目,Flowise可以自由使用和修改。

- • 用户友好: Flowise很容易上手,即使对那些没有编码经验的人也是如此。

- • 通用: Flowise AI可用于创建各种LLM应用程序。

示例1: 构建基本LLM链

遵循以下步骤:

- 在空白画布上,单击”+ Add New”按钮以调出左侧的”Add Nodes”面板。

- 从“Add Nodes”面板中选择以下组件,它们将出现在画布上:

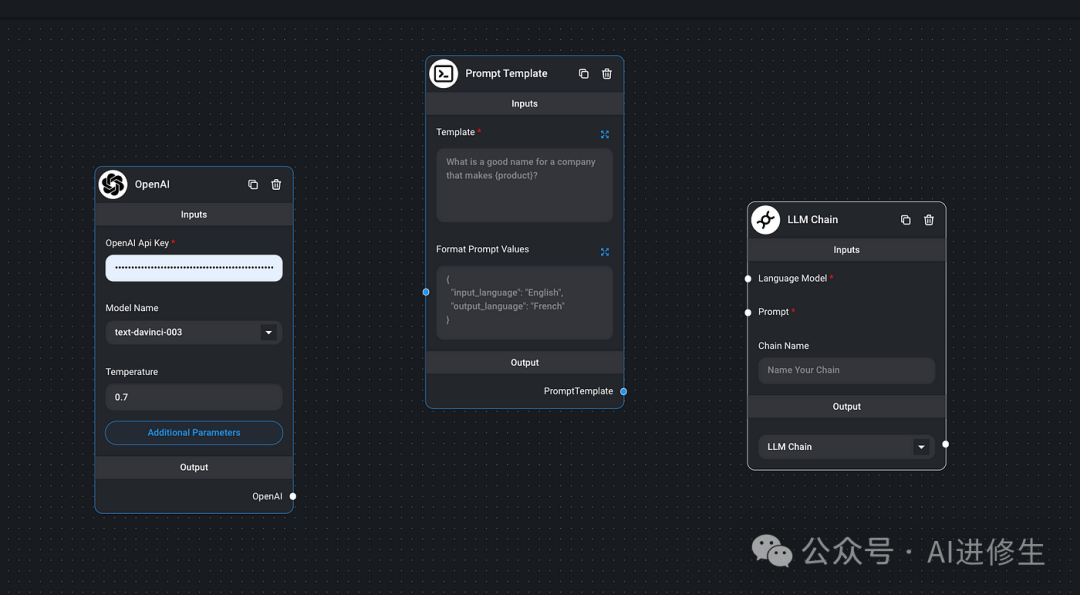

* • 从LLMs中将OpenAI拖到面板

* • 从Chains分类中拖出LLM chain

* • 从Promps分类中拖出Prompt Template

现在,画布应该是这样的:

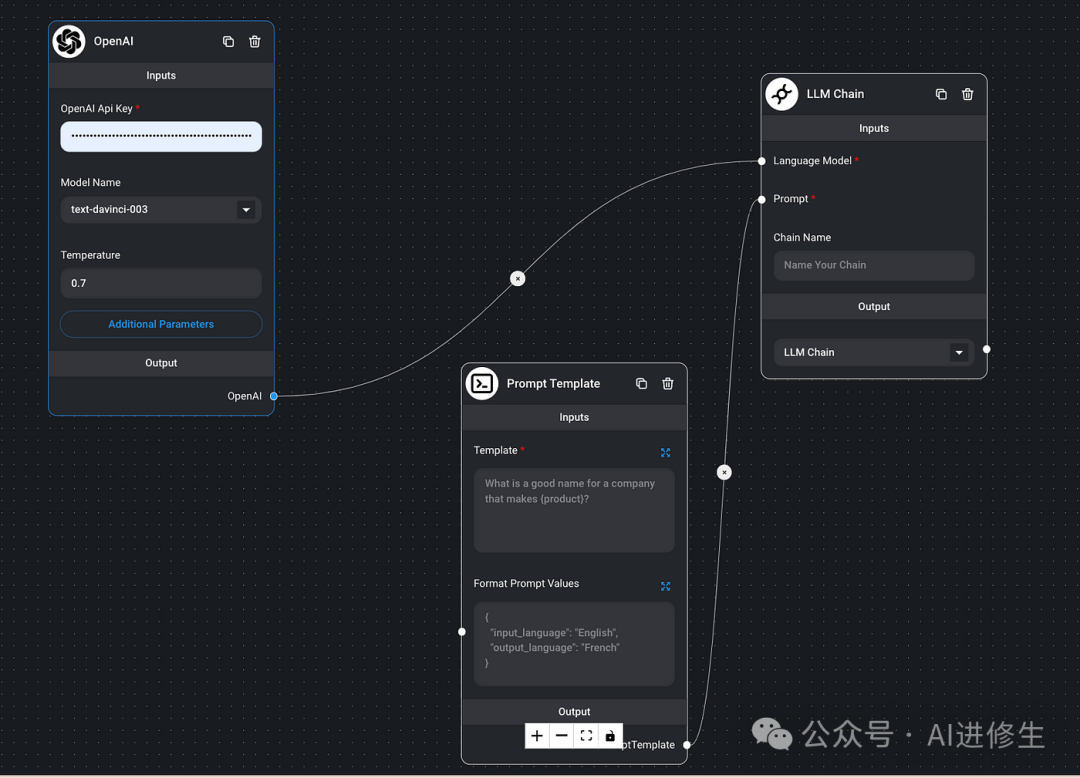

- 连接组件

* • 将OpenAI的输出(output)链接到LLM Chain的语言模型(input)

* • 将Prompt Template的输出(output)链接到LLM Chain的Prompt(input)

- 输入必要的信息

• 在OpenAI的字段中输入OpenAI密钥

• 将以下prompt模板写入“Prompt Template”的Template字段中:

What is a good name for a company that makes {product }?

* • 给LLM Chain一个名字.

* • 单击右上角的“保存”图标进行保存.

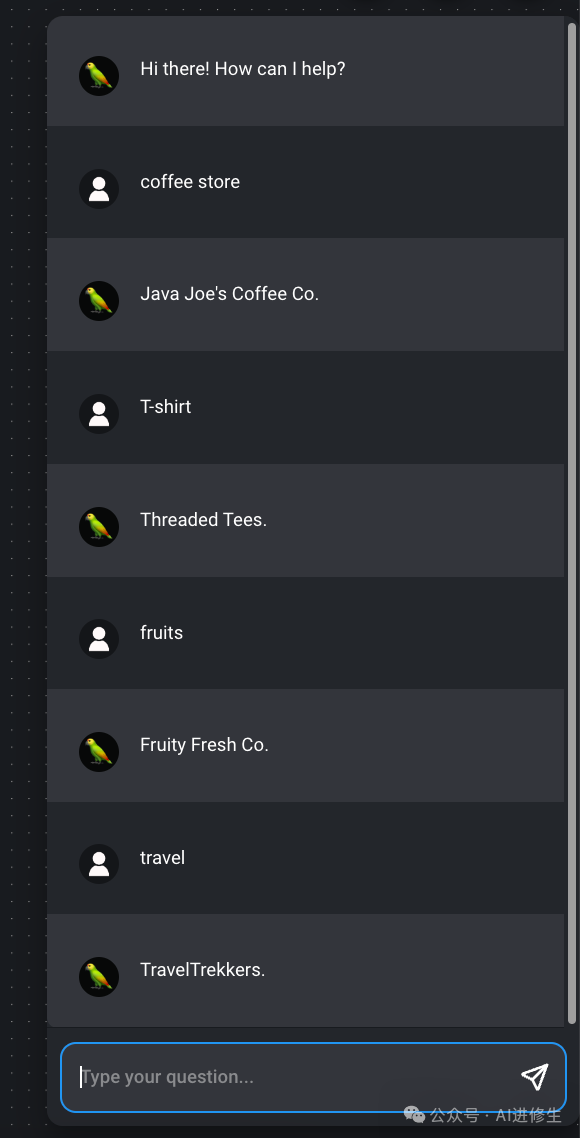

* • 点击右上角的聊天图标,就可以开始发送“产品名称”了。在这里,我们得到了预期的答案.

示例2: 构建PDF阅读器Bot

在之前的一篇博文中,我演示了如何使用LangFlow创建PDF Reader Bot。现在,让我们使用Flowise创建相同的机器人。

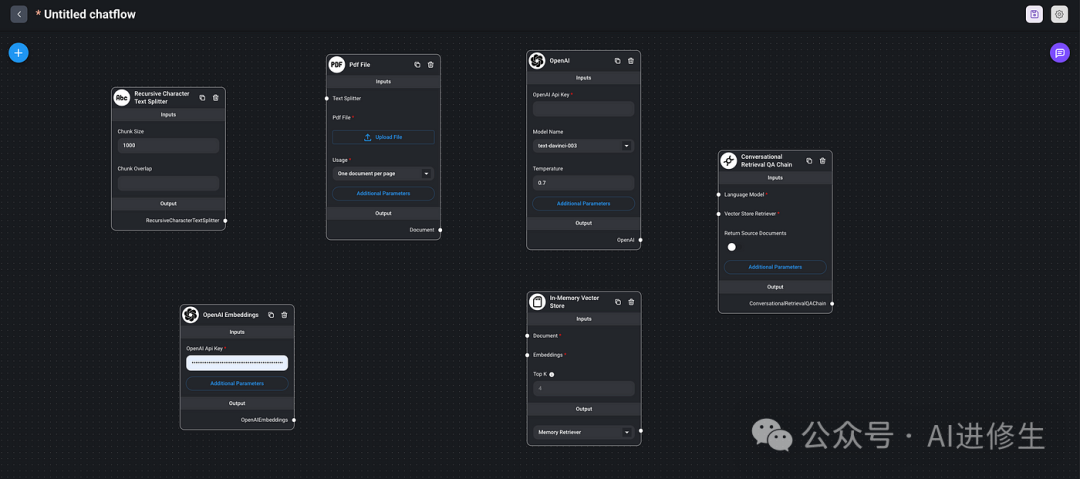

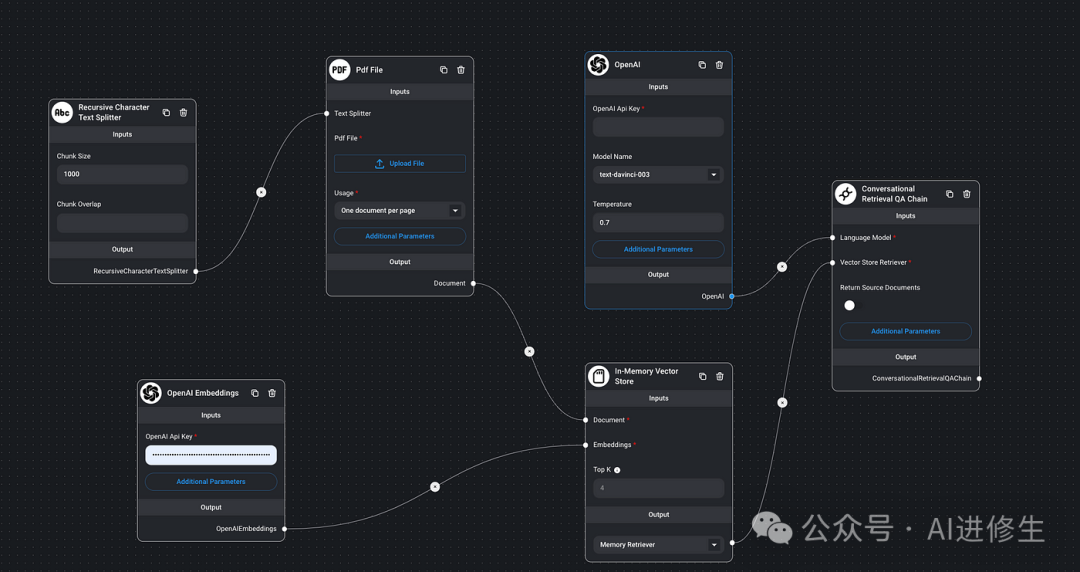

将以下组件添加到空白画布中:

- • 从“Text Splitters”中选择“Recursive Character Text Splitter”(递归字符文本分割器)

- • 从“Document Loaders”中选择“PDF file”

- • 从“Embeddings”中选择“OpenAI Embeddings”

- • 从“Vector Stores”中选择“In-memory Vector Store”(内存向量存储)

- • 从“LLMs”中选择“OpenAI”

- • 从“Chains”中选择“Conversational Retrieval QA Chain”(对话检索QA Chain)

现在我们在画布中拥有了所有必需的组件。

连接组件

- 链接“Recursive Character Text Splitter” 的输出和 “PDF file” 的输入

- 链接“PDF file” 的输出和 “In-memory Vector Store”的输入

- 链接“OpenAI Embeddings” 的输出和“In-memory Vector Store” 的输入

- 链接“In-memory Vector Store” 的输出和 “Conversational Retrieval QA Chain”的输入

- 链接“OpenAI” 的输出和 “Conversational Retrieval QA Chain” 的输入

输入必要的信息

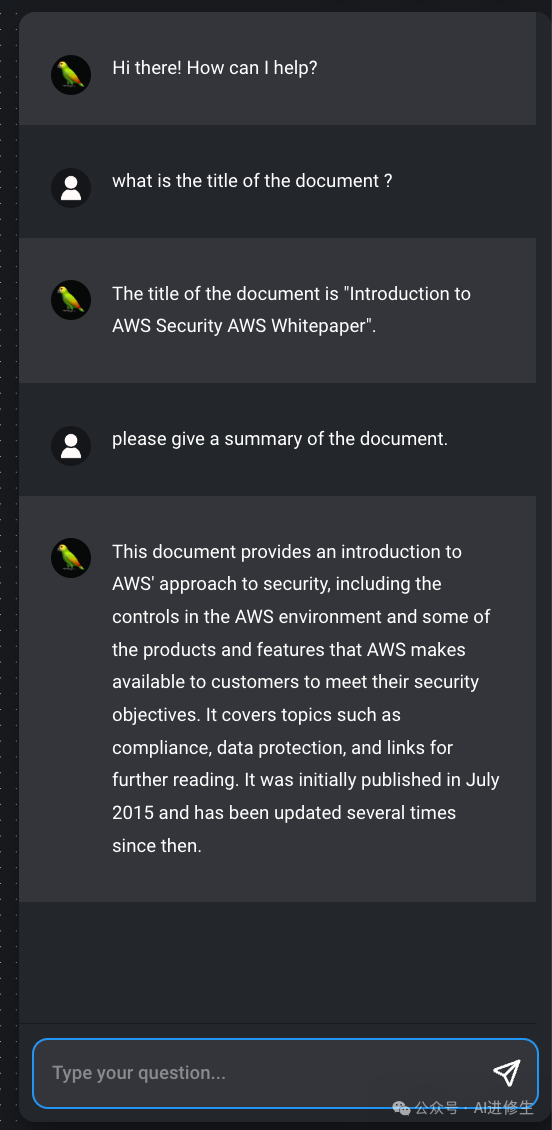

- 点击“PDF File”中的“Upload File”,上传标题为“Introduction to AWS Security”的示例PDF文件。

- 在“OpenAI”和“OpenAIEmbeddings”字段中输入您的OpenAI密钥

- 单击“save”按钮,然后单击聊天按钮开始发送请求。

⚡ 快速入门

下载并安装 NodeJS >= 18.15.0

- 安装 Flowisenpm install -g flowise

- 启动 Flowisenpx flowise start

使用用户名和密码

npx flowise start --FLOWISE_USERNAME=user --FLOWISE_PASSWORD=1234

🐳 Docker

Docker Compose

- 进入项目根目录下的

docker文件夹

- 进入项目根目录下的

- 创建

.env文件并指定PORT(参考.env.example)

- 创建

- 运行

docker-compose up -d

- 运行

- 可以通过

docker-compose stop停止容器

- 可以通过

Docker 镜像

- 本地构建镜像:docker build --no-cache -t flowise .

- 运行镜像:docker run -d --name flowise -p 3000:3000 flowise

- 停止镜像:docker stop flowise

👨💻 开发者

Flowise 在一个单一的代码库中有 3 个不同的模块。

- •

server:用于提供 API 逻辑的 Node 后端 - •

ui:React 前端 - •

components:第三方节点集成

先决条件

- • 安装 PNPM

npm i -g pnpm

设置

- 克隆仓库git clone https://github.com/FlowiseAI/Flowise.git

- 进入仓库文件夹cd Flowise

- 安装所有模块的依赖:pnpm install

- 构建所有代码:pnpm build

- 启动应用:pnpm start

现在可以在 http://localhost:3000 访问应用

- 用于开发构建:任何代码更改都会自动重新加载应用程序,访问 http://localhost:8080

* • 在 ` packages/ui ` 中创建 ` .env ` 文件并指定 ` VITE_PORT ` (参考 ` .env.example ` )

* • 在 ` packages/server ` 中创建 ` .env ` 文件并指定 ` PORT ` (参考 ` .env.example ` )

* • 运行

pnpm dev

🔒 认证

要启用应用程序级身份验证,在

packages/server

的

.env

文件中添加

FLOWISE_USERNAME

和

FLOWISE_PASSWORD

:

FLOWISE_USERNAME=user

FLOWISE_PASSWORD=1234

🌱 环境变量

Flowise 支持不同的环境变量来配置您的实例。您可以在

packages/server

文件夹中的

.env

文件中指定以下变量。了解更多信息,请阅读 文档

📖 文档

[Flowise 文档]:(https://docs.flowiseai.com/)

🌐 自托管

在您现有的基础设施中部署自托管的 Flowise,我们支持各种 部署

- • AWS

- • Azure

- • Digital Ocean

- • GCP

— 完 —

版权归原作者 Aitrainee 所有, 如有侵权,请联系我们删除。