实验

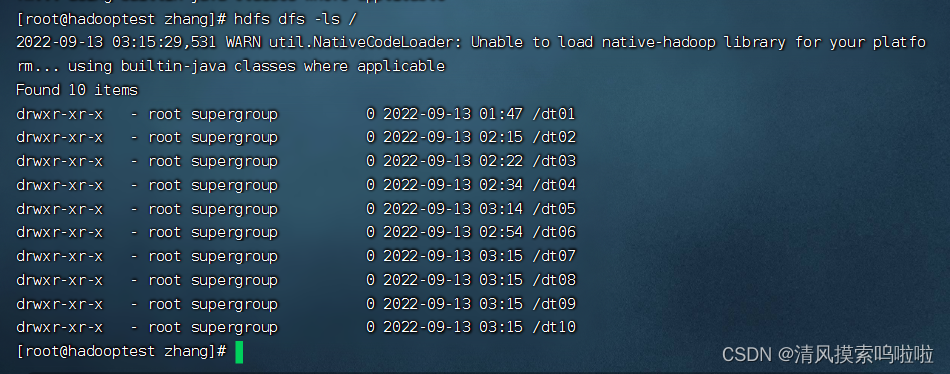

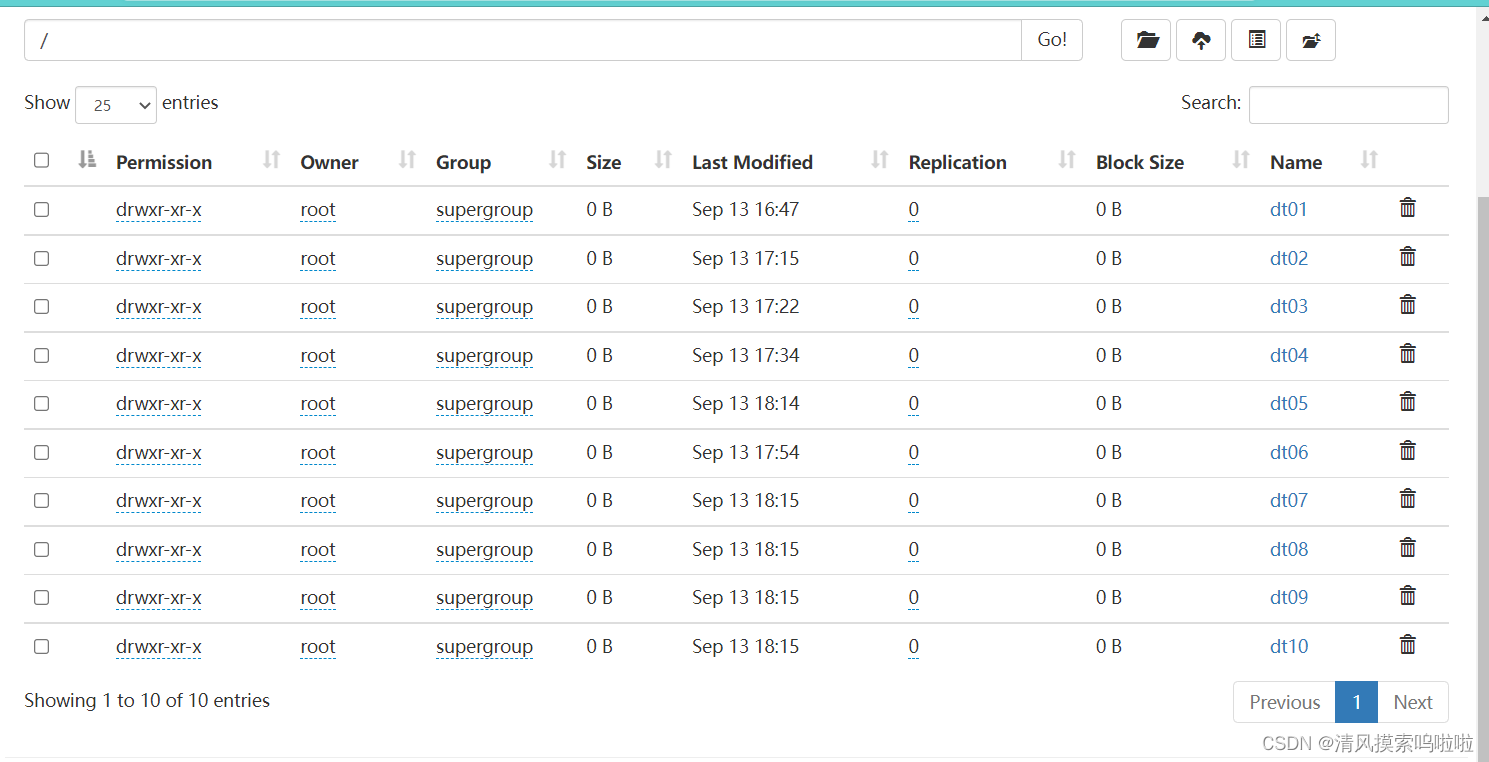

1.在HDFS的/上创建10目录(data01~data10)

在浏览器上查看:

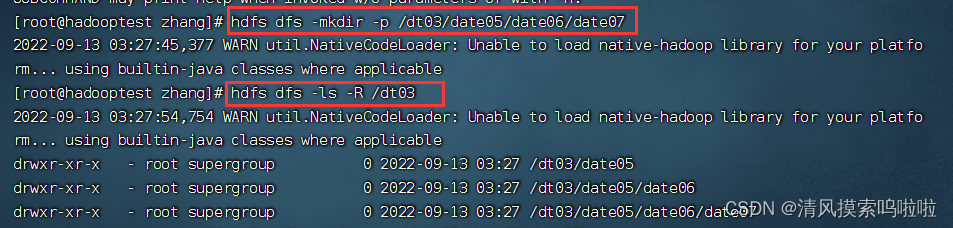

2.在HDFS/data03下递归创建/data05/data06/data07

递归创建,使用命令:

hdfs fs -mkdir -p /xx1/xx2/xx3

如:hdfs dfs -mkdir -p /dt03/date05/date06/date07

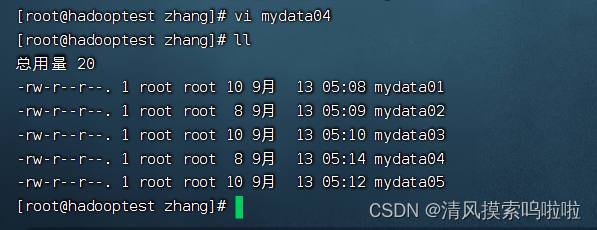

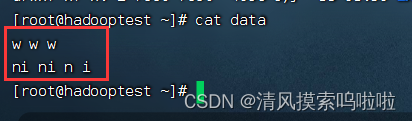

3.在/home/hadoop/software/自己名字命名目录下创建5分有数据的文件(mydata01-mydata05)文件内容自定义。

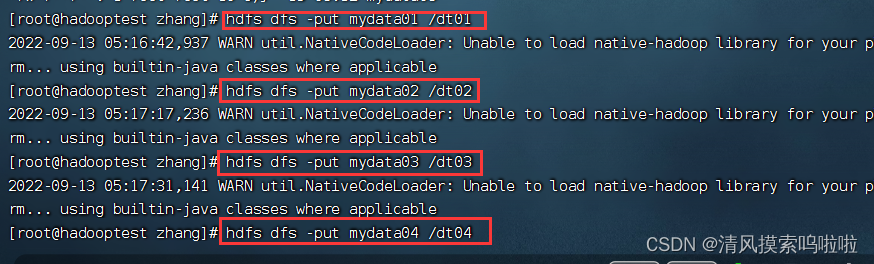

4.把mydata01上传到HDFS的/data01,把mydata02上传到HDFS的/data02,以此类推,把5份文件都上传到大数据平台的HDFS上。

上传使用put,如:hdfs dfs -put mydata01 /dt01

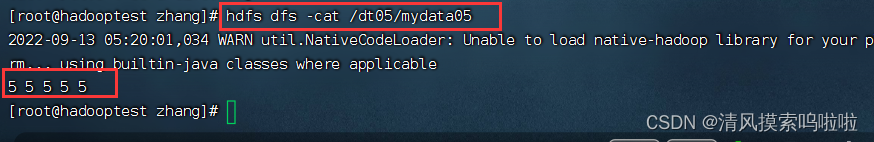

查看上传的数据里的数据:

hdfs dfs -cat /dt05/mydata05

(附加部分)

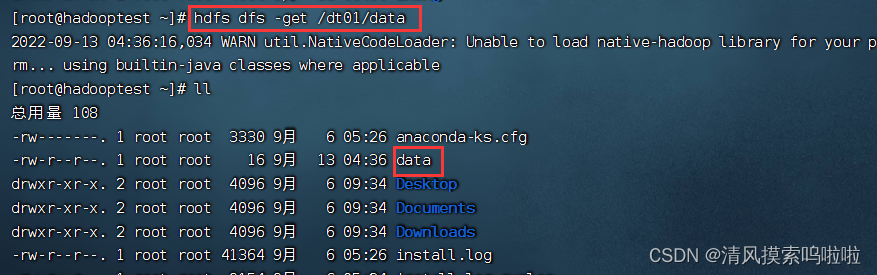

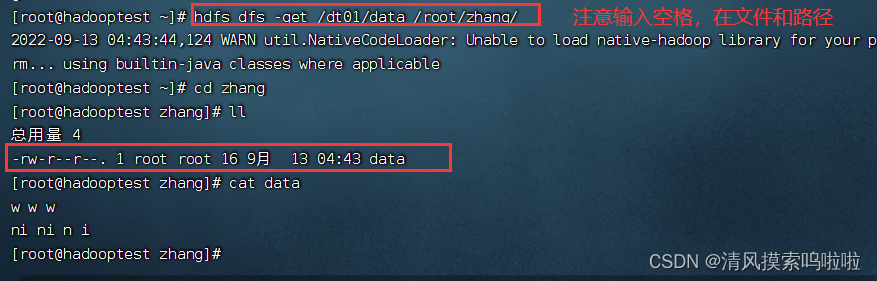

把数据取出来:hdfs dfs -get /dt01/data

查看数据内容:

将文件取下至zhang这个目录下:

hdfs dfs -get /dt01/data /root/zhang/ (注意中间有空格 )

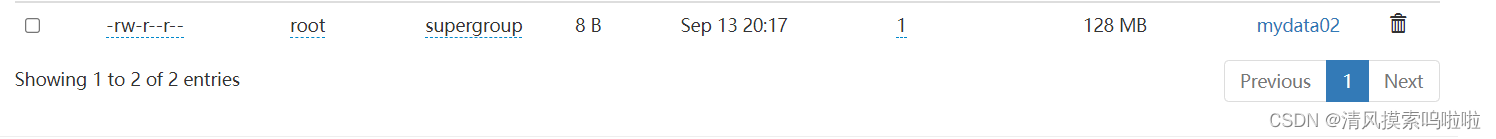

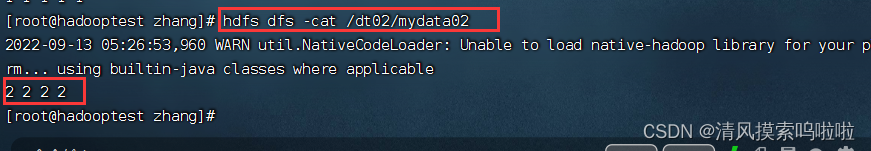

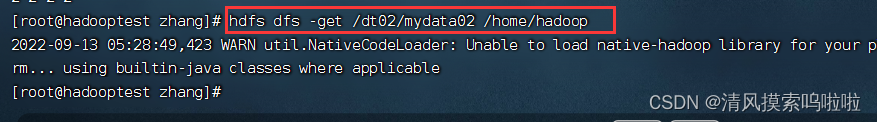

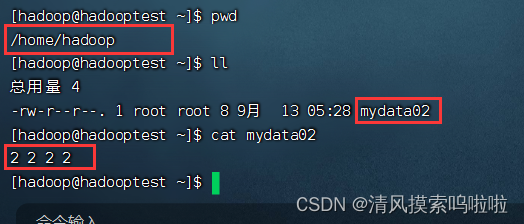

5.把大数据平台HDFSI/data02/mydata02文件下载到/home/hadoop

查看到的文件内容如下:

将文件取下至/home/hadoop下:

在/home/hadoop下查看:

版权归原作者 墨染盛夏呀 所有, 如有侵权,请联系我们删除。