hadoop伪分布式环境搭建,完整的详细步骤

一、搭建伪分布式本次实验环境:

1、VMware14

2、一台ubtuntu 18 64位

3、主机名位master

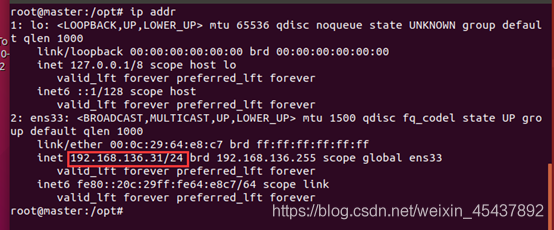

4、ip 地址:192.168.136.31

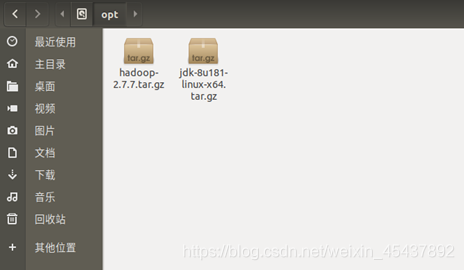

5、本次实验需要的安装包

二、 伪分布式搭建前的准备

1、 查看id 地址

ip addr

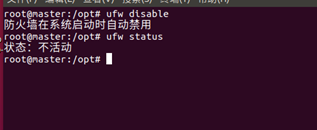

2、 关闭防火墙

命令来关闭防火墙

ufw disable

命令查看当前防火墙状态

ufw status

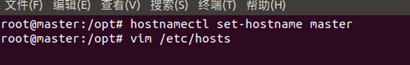

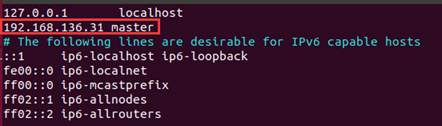

3、 修改主机名、 添加主机映射

hostnamectl set-hostname master

修改虚拟机hosts文件,将ip地址添加进来

vim /etc/hosts

192.168.136.21 master

使用 :wq 保存

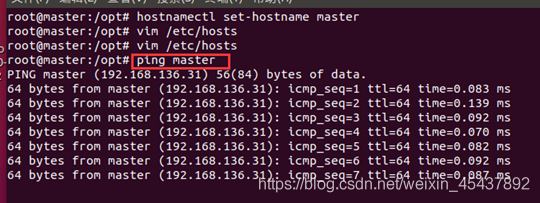

测试是否修改成功

Ping master

能ping通就修改成功

4、 设置免密(这里是伪分布式不是完全分布式,只需要能免密自己,此步骤也可以忽略)

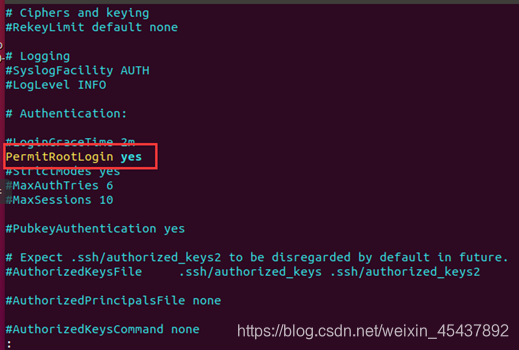

○1打开SSH远程登录配置文件sshd_config

vim /etc/ssh/sshd_config

PermitRootLogin用来设置能不能直接以超级用户ssh登录

然后重启服务

service sshd restart

○2生成密钥

ssh-keygen -t rsa

回车四下

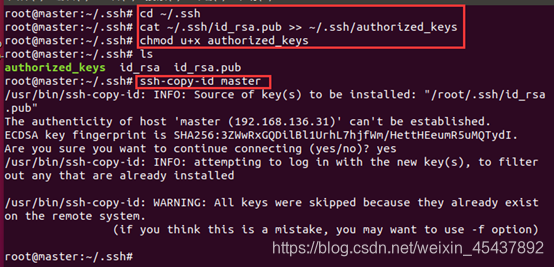

○3authorized_keys文件存放自己和目标的公钥,要自己手动复制文件,命令如下:

cd ~/.ssh

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

给复制的文件添加可执行权限(chmod u+x authorized_keys)

添加master的密码

ssh-copy-id master

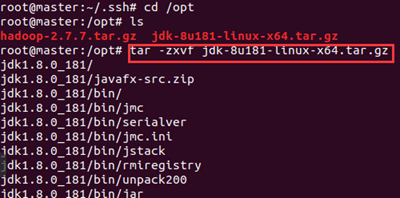

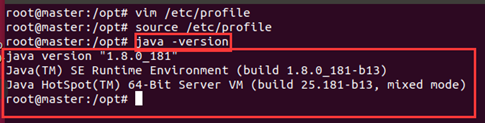

三、安装jdk

回到opt目录

cd /opt

tar -zxvf jdk-8u181-linux-x64.tar.gz

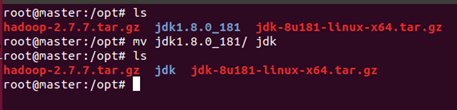

进行重命名

mv jdk1.8.0_181/ jdk

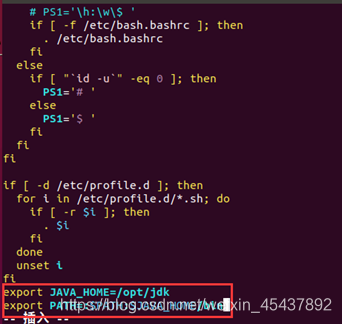

修改环境变量

vi /etc/profile

export JAVA_HOME=/opt/jdk #这里是opt目录

export PATH=:$PATH:$JAVA_HOME/bin

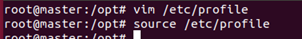

使环境变量生效

source /etc/profile

验证是否安装成功

验证:

java -version

到这里jdk 就安装成功了

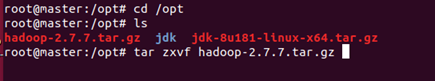

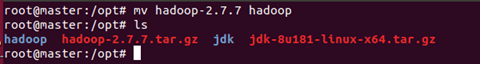

四、搭建hadoop伪分布式

1、 解压 重命名

cd /opt

tar -zxvf hadoop-2.7.6.tar.gz

mv hadoop-2.7.6 hadoop

2、 修改配置文件

cd /opt/hadoop/etc/hadoop

a、修改 hadoop-env.sh

加上一句

export JAVA_HOME=/opt/jdk

jdk 的安装目录

b、修改 core-site.xml

将下面的配置参数加入进去修改成对应自己的

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

</configuration>

c、修改 hdfs-site.xml 将dfs.replication设置为1

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

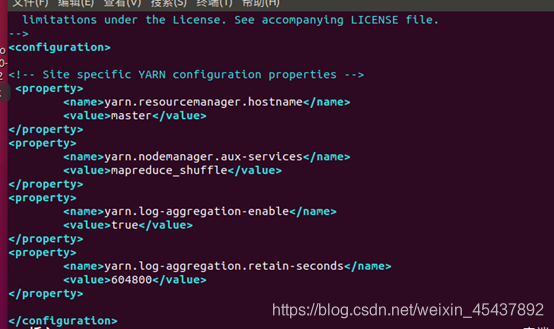

d、修改文件yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

e、修改 mapred-site.xml(将mapred-site.xml.template 复制一份为 mapred-site.xml

命令:cp mapred-site.xml.template mapred-site.xml)

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

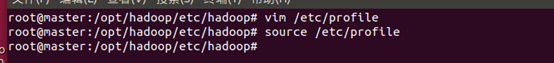

修改环境变量

Vim /etc/profile

使环境变量生效

source /etc/proflie

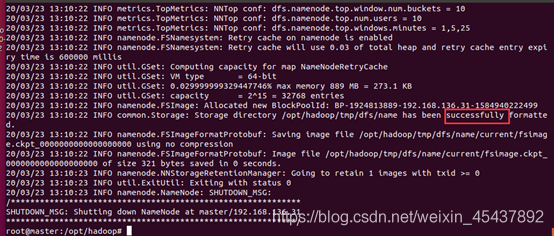

初始化hadoop集群

hadoop namenode -format

初始化成功

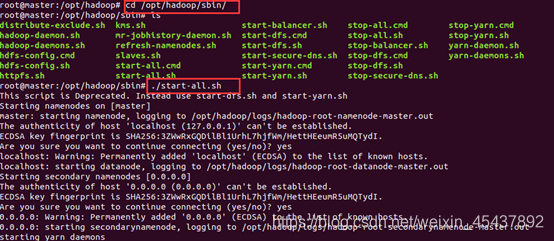

到 hadoop 的sbin目录启动hadoop

cd /opt/hadoop/sbin/

./start-all.sh

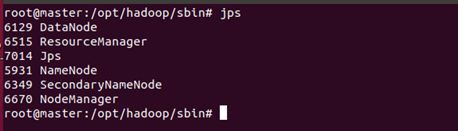

验证

jps

出现以上java节点 Hadoop伪分布式就搭建成功了

HDFS节点:namenode datanode

主节点,最多可以有1个:namenode

从节点,有多个:datanode

namenode负责接收用户操作请求,是用户操作的入口。维护文件系统的目录结构,称作命名空间

datanode负责存储数据

secondaryNamenode :第二名称节点 可以理解位namenode的助理

YARN 节点 ResourceManager NodeManager

主节点,最多可以有1个:ResourceManager

从节点,有很多个: NodeManager

ResourceManager负责集群资源的分配与调度MapReduce、Storm、Spark等应用,必须实现ApplicationMaster接口,才能被RM管理。NodeManager负责单节点资源的管理

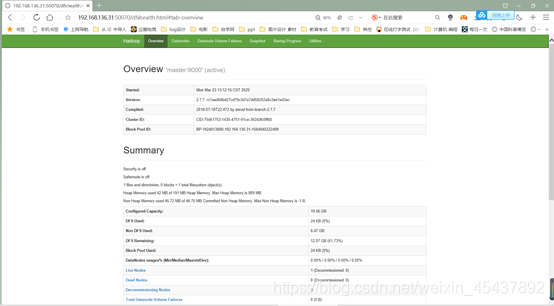

验证hdfs:

可以登录浏览器地址:192.168.136.31:50070 (ip地址是master的地址)

看到下面页面证明 hdfs装好了

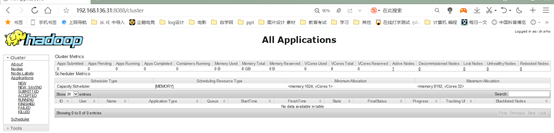

验证yarn

http://192.168.136.21:8088/

这里写上自己配置的IP地址

版权归原作者 咩咩咩咩没 所有, 如有侵权,请联系我们删除。