文章目录

Spark 简介

Apache Spark 是一个快速的通用集群计算系统。它提供了Java, Scala, Python ,R 四种编程语言的 API 编程接口和基于 DAG 图执行的优化引擎。它还支持一系列丰富的高级工具:处理结构化数据的 Spark SQL,用于机器学习的 MLlib,控制图、并行图操作和计算的一组算法和工具的集合 GraphX,数据流处理 Spark Streaming。

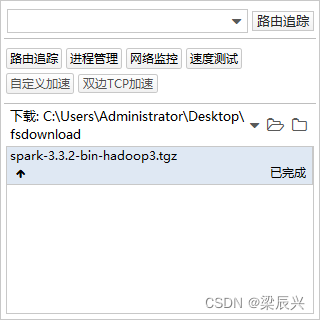

一,Spark 下载

1.进入spark官网:https://spark.apache.org/

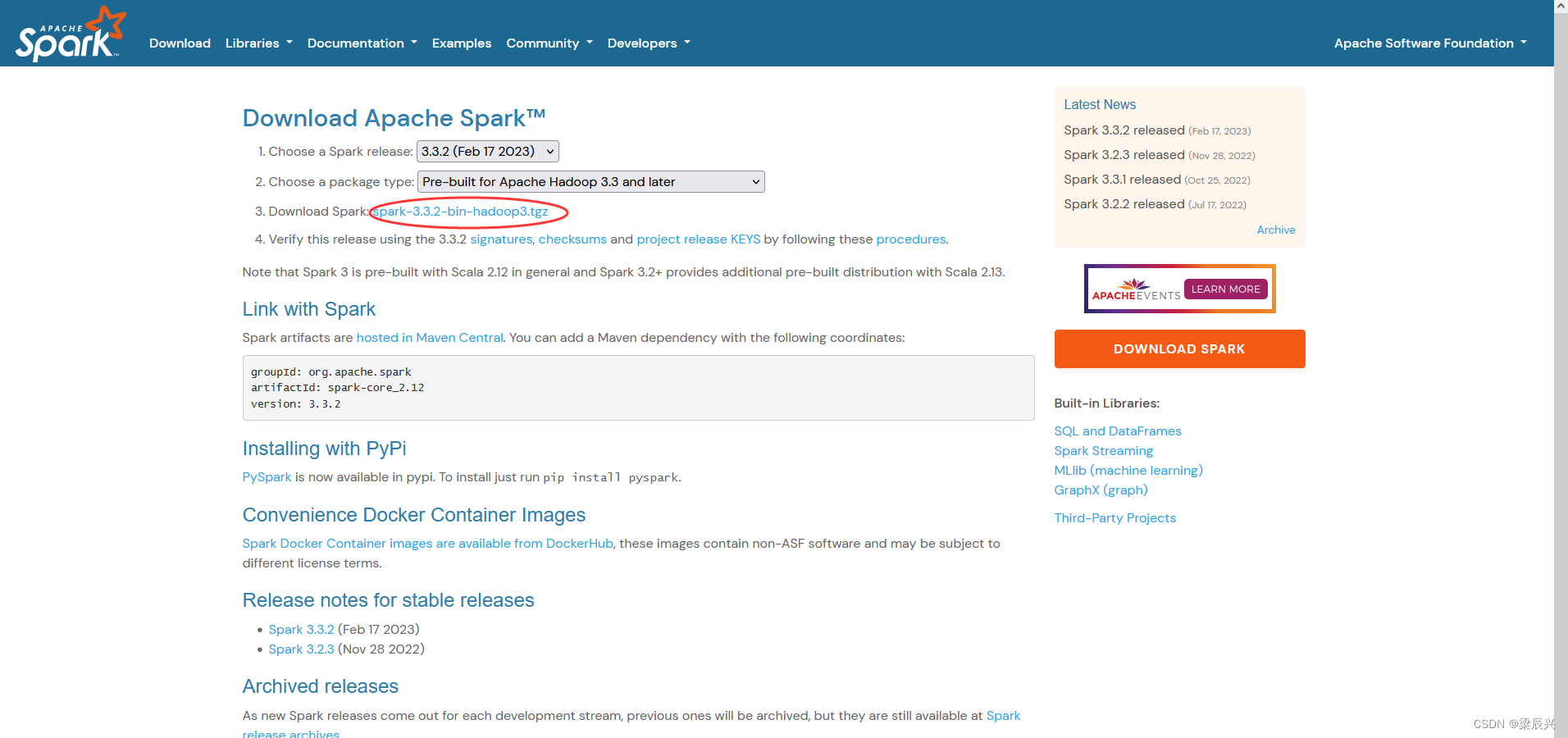

2.单击download标签,进入下载页 3.单击 spark-3.3.2-bin-hadoop3.tgz 进入版本下载页

3.单击 spark-3.3.2-bin-hadoop3.tgz 进入版本下载页

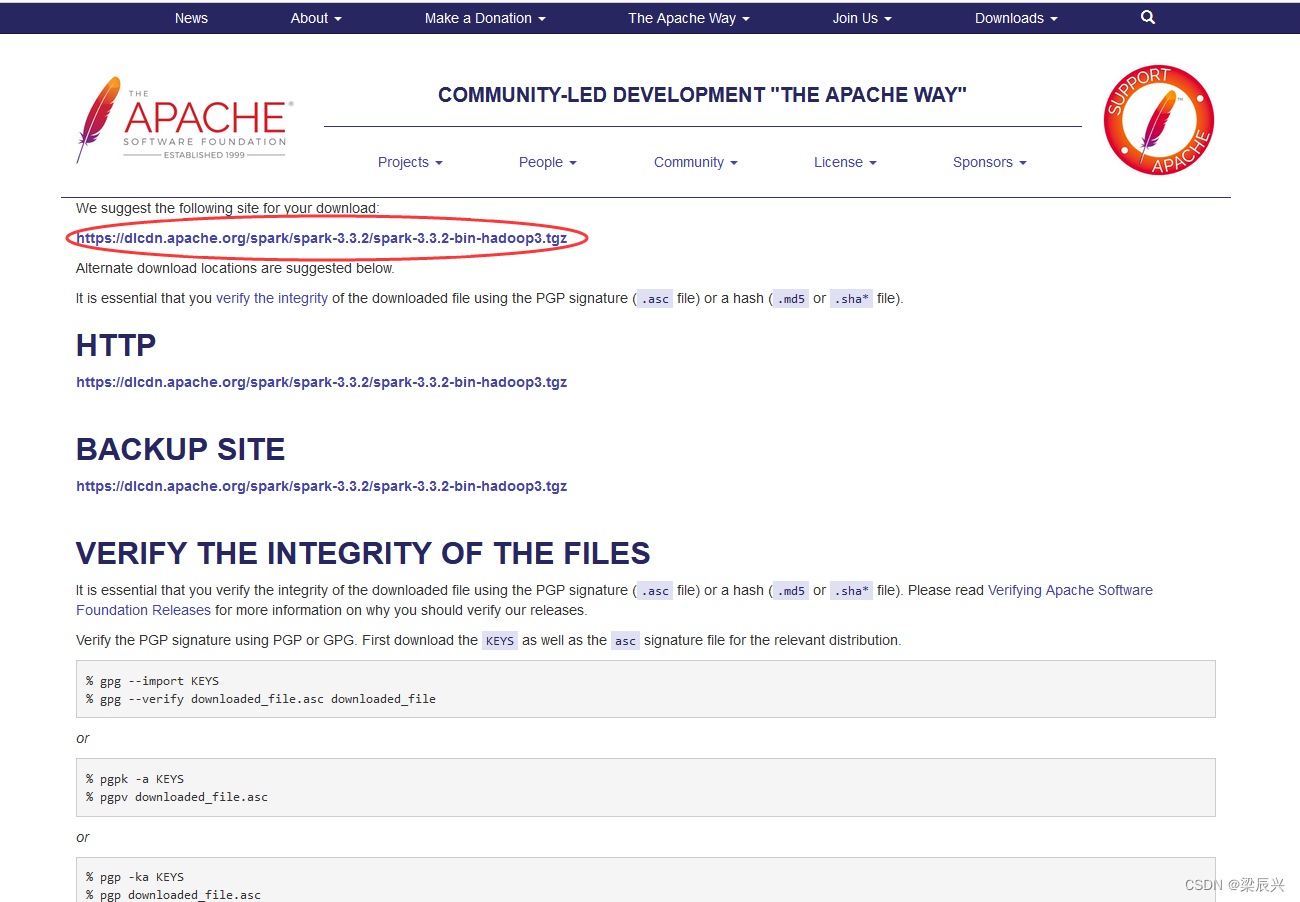

4.单击链接开始下载

二,Spark 安装

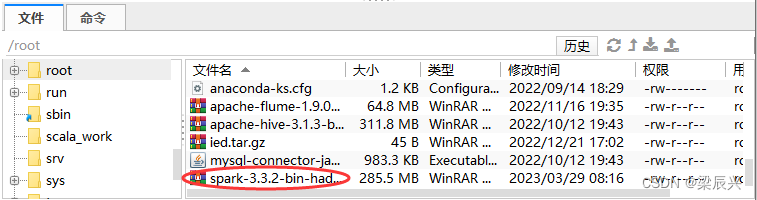

1.将下载好的spark包上传到centos中

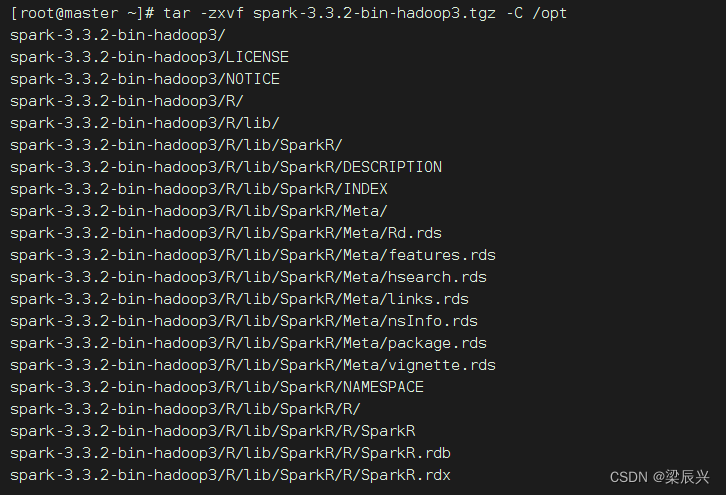

2.上传完成后进行解压到/opt目录中,执行命令:

tar -zxvf spark-3.3.2-bin-hadoop3.tgz -C /opt

三,Spark 配置

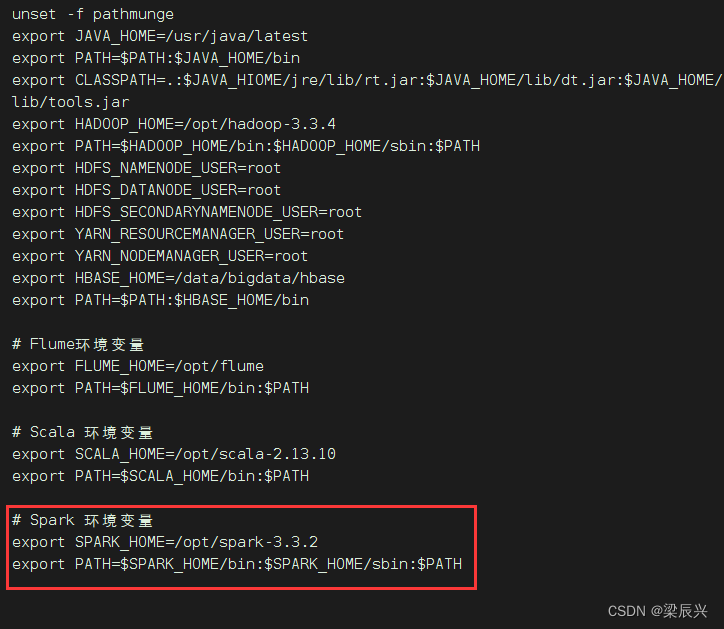

Spark环境配置

1.执行命令:

vi etc/profile

2.添加如下内容

# Spark 环境变量

export SPARK_HOME=/opt/spark-3.3.2

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

3.执行

!wq

,保存后退出

4.更新环境变量配置,执行命令:

source etc/profile

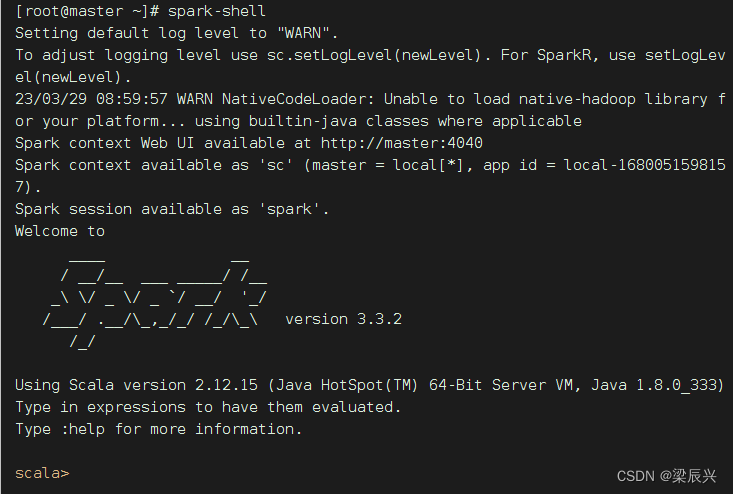

5.执行命令:

spark-shell

,检查配置是否成功

版权归原作者 梁辰兴 所有, 如有侵权,请联系我们删除。