今天分享的大模型系列深度研究报告:《大模型报告专题:2023大模型安全解决方案白皮书》。

(报告出品方:百度安全)

报告共计:61页

前言

在当今迅速发展的数字化时代,人工智能技术正引领着科技创新的浪潮而其中的大模型技术则被视为人工智能的一大突破。大模型是指参数量巨大能力强大的人工神经网络模型,以其卓越的表现在自然语言处理、计算机视觉、语音识别等领域赢得了持续的关注和青睐。这些模型的出现,不仅在学术界引起了研究者们的广泛兴趣,也在商业应用领域带来了一系列创新和变革。大模型技术的崛起,首要得益于深度学习的发展以及硬件计算能力的提升。深度学习模型,尤其是基于 Transformer 架构的模型,如 BERT、GPT和T5,通过在海量数据上进行训练,学习到了丰富的语义和特征表示,使得其在多项人工智能任务中展现出远超以往的性能。例如,在自然语言处理领域,这些大模型能够实现更准确、更流畅的语言生成、机器翻译和情感分析等任务,大大提升了人机交互和信息处理的能力。伴随着大模型的不断演进和不断优化,其在商业领域的应用也愈发广泛,金融行业可以利用大模型进行风险评估和市场预测,医疗领域可以通过大模型实现图像识别和疾病诊断,而广告、营销等领域也能够通过大模型实现更精准的用户推荐和个性化服务。同时,大模型还在科学研究、文化创意和娱乐产业中发挥着积极作用,为人类创造了更多可能性.但伴随着大模型技术的迅猛发展,一系列安全风险和伦理挑战也开始浮现。大规模数据的采集和存储,可能导致个人隐私的泄露和滥用。模型的强大能力也可能被恶意利用,用于虚假信息生成、社会工程和网络攻击。对抗样本攻击则可能使得模型产生误导性结果,严重影响决策的准确性。在社会伦理层面,大模型的使用引发了关于人工智能责任、算法歧视等诸多争议。

因此,建立稳固的大模型安全风控体系势在必行。本白皮书旨在全面探讨大模型安全风险,并为各界提供指导,以确保大模型在广泛应用中的安全性和可信度。通过深入剖析大模型领域的安全挑战,我们可以制定切实可行的措施,确保大模型在为人类创造价值的同时,也能够保障个人隐私、社会稳定和信息安全。

大模型安全的重要性

安全风险引发的重要性

随着大模型技术的高速发展,其在各个领域的应用日益广泛,从科研到商业,再到日常生活、办公等方方面面。但随之而来的是一系列潜在的安全风险,这些风险的引发和应对不仅关乎企业的声誉,还牵涉到个人隐私的保护和社会的稳定。正因如此,深入了解和应对这些安全风险变得至关重要。首先,大模型在许多应用场景中处理大量敏感数据和个人信息,如用户的搜索记录、社交媒体互动和金融交易等。这使得数据泄露和隐私侵犯的风险不容忽视。一旦这些敏感信息遭受泄露,个人隐私权益可能会受到严重损害,甚至被用于恶意行为,如身份盗窃、诈骗和社会工程攻击。这不仅会对受害者造成经济损失,还可能导致社会的恐慌和不信任

其次,大模型的强大能力也可能被用于进行各种形式的恶意攻击。模型的对抗性样本攻击,即针对模型的输入进行微小改动,从而欺骗模型产生错误预测,已成为一种常见的威胁。恶意使用者可以通过这种方式制造虚假信息,影响决策结果,如将误导性的信息传播到社交媒体平台,从而扰乱社会秩序。此外,大模型的生成能力也可能被用于生成虚假的内容,威胁到媒体的可信度和新闻的真实性。

另外,模型本身也可能成为攻击者的目标。模型参数和权重的泄露可能导致知识产权的损失,甚至使恶意使用者能够复制或修改模型,进一步恶化风险。对模型的针对性攻击,如投毒攻击,可能使模型的输出产生不良影响,从而影响到正常的业务运行。这些威胁可能在不经意间对企业和社会造成巨大的损失。

大模型应用面临的安全挑战与潜在威胁

ChatGPT 引爆的生成式人工智能热潮,让 Al 模型在过去几个月成为行业瞩目的焦点,并且在国内引发“百模大战”,在大模型高速发展的同时,大模型应用所面临的安全挑战、与潜在的威胁也不能够忽视,本文将依托百度安全大模型安全实践与总结,分别从数据安全与隐私问题、模型流转/部署过程中的安全问题、AIGC 的内容合规问题、以及大模型运营过程中的业务安全问题在内共计四个方向,详细介绍一下相关的安全挑战。

数据安全与隐私问题

1、传输截获风险:在进行大模型非私有化的预训练、精调、推理服务时,数据需要在不同的主体或部门之间进行传输。这些数据通常包括各种敏感信息和隐私,如个人身份信息、金融数据等。在数据传输过程中,如果没有采取足够的安全措施,攻击者可能会截获这些数据,从而获取敏感信息,给用户和组织带来安全和隐私问题。因此,在使用大模型服务时,必须采取适当的安全措施来保护数据的机密性和完整性,以防止传输截获风险。

2、运营方窥探风险: 在精调与推理阶段,通常需要使用个人身份信息、企业数据等敏感数据来提高模型的准确性和性能。然而,如果这些数据被大模型运营机构窥视或收集,就可能存在被滥用的风险。运营方可能会利用这些数据来了解用户的隐私信息,例如个人偏好、行为习惯、社交网络等,从而进行有针对性的广告投放或者推销策略。此外,运营方还可能将数据泄露给第三方,这些第三方可能是合作伙伴、数据分析公司、广告公司等,从而获取不正当的利益。

3、模型记忆风险: 经过模型的训练和推理后,模型会形成记忆。这些记忆包括各种历史数据和相关信息,如果这些模型被泄露或共享使用,则可能存在模型记忆甚至记忆内容泄密的风险。攻击者可能会利用这些记忆信息来实施恶意行为,例如针对性攻击、诈骗等。此外,如果记忆内容被泄露,也会对用户的隐私和安全造成威胁。因此,在使用大模型服务时,必须采取适当的安全措施来保护模型的机密性和隐私性,例如加密和访问控制等。同时,应该定期对模型进行评估和更新,以减少模型记忆风险。

模型流转/部署过程中的安全问题

大模型本身也是一种重要的资产,它包含了大量的知识和技能,如果没有合理的管理和控制,就可能被盗取、复制或篡改,导致模型的性能下降或功能失效。此外,大模型也可能受到对抗攻击的威胁,如对抗样本、对抗训练等这些攻击可以使模型产生错误的输出;本白皮书围绕数据、模型、网络通信等多个方面所面临的安全问题做一下介绍:

1、模型知识泄漏: 在将模型部署到生产环境中,模型的输出可能会暴露训练数据的一些信息。攻击者可以通过分析模型的输出,推断出训练数据的特征和分布,进而构建类似的数据集,甚至还原部分原始数据。

2、模型逆向工程: 攻击者可能尝试通过逆向工程技术还原部署模型的架构、权重和训练数据。这可能导致知识产权盗窃、模型盗用和安全漏洞的暴露。逆向工程可能通过模型推理结果、输入输出分析以及梯度攻击等方式进行。

3、输入数据的合法性和安全性:在模型部署阶段,恶意用户可能试图通过提供恶意输入来攻击系统。例如,输入中可能包含恶意代码、命令执行、注入语句或文件包含路径,从而导致安全漏洞。

4、模型更新和演化: 模型需要定期更新以保持性能和适应新的数据分布。然而,模型更新可能引入新的漏洞和问题。安全地更新模型需要考虑版本控制、验证新模型的安全性和稳定性,以及备份机制以防产生不良影响。

AIGC 的内容合规问题

- 个人隐私问题:隐私问题涉及到生成式人工智能技术在使用用户个人数据时可能引发的隐 私泄露和滥用问题。生成技术通常需要大量的数据来提供更准确的内容生成, 这可能包括用户的文本、图像、音频等信息。然而,当个人数据被用于生成内 容时,可能导致用户的隐私权受到侵犯。此外,生成的内容可能会反映用户的 个人喜好、兴趣等,从而进一步加剧隐私问题,例如:

⚫ Smart Compose 隐私问题: 谷歌的 Smart Compose 功能可以根据 用户的输入预测邮件的内容。然而,这可能意味着谷歌能够访问用户的 邮件内容,引发了用户隐私泄露的担忧。

⚫ 语音助手隐私问题: 语音助手如 Siri、Alexa 等需要收集和分析用户的 语音指令,以提供更个性化的服务。但这也涉及对用户的语音数据进行 收集和存储,引发了关于隐私和数据安全的问题。

⚫ 个性化内容生成隐私问题: 生成技术可能会根据用户的浏览历史、社 交媒体活动等生成个性化的内容,涉及用户个人数据的使用。这可能让 用户感到他们的隐私受到了侵犯。

- 虚假信息和误导性内容: 虚假信息和误导性内容是指生成技术产生的信息在形式或内容上误导受 众,可能违背事实真相,损害信息的可信度和准确性。这种问题可能出现在各 种内容中,包括文字、图像、音视频等多模态内容。虚假信息和误导性内容可 能导致社会的混乱、信息泛滥和不信任的情况。人们可能不再能够确定何时可 以相信所看到的内容,这可能削弱媒体的权威性和信息的真实性。此外,虚假信息也可能对政治、商业和社会产生重大影响,导致不稳定和不确定性。例如:

⚫ Deepfake 虚假视频: Deepfake 技术可以制作逼真的虚假视频,使 人物出现在他们实际未出现的场景中。例如,有人可能使用 Deepfake 技术将名人的脸部特征添加到不实的视频中,以制造虚假事件。

⚫ 虚假新闻和评论: 生成技术可以产生看似真实的新闻报道、评论和社交媒体帖子,但这些内容可能缺乏事实支持,误导受众。这可能对公共 舆论、政策制定和个人信任产生负面影响。

⚫ 制造虚假证据: 生成技术可能用于制造虚假的证据,例如在法庭上使 用虚假的文件或录音。这可能导致司法领域的不公正判决。

大模型安全解决方案

百度二十余年安全对抗的总结与提炼,围绕百度【文心大模型】安全实践 经验,推出以 AI 安全为核心的大模型安全风控解决方案,从大模型全生命周期 视角出发,方案涵盖大模型训练/精调/推理、大模型部署、大模型业务运营等关键阶段所面临的安全风险与业务挑战,提供全套安全产品与服务,助力企业 构建平稳健康、可信、可靠的大模型服务。

本方案针对大模型训练阶段、部署阶段和业务运营阶段所面 临的安全挑战,给出了完整的应对方案,本章节将会围绕数据安全与隐私保护 方案、模型保护方案、AIGC 内容合规方案、以及业务运营风控方案四个维度 详细阐述大模型安全能力建设;同时结合以攻促防的思路详细阐述如何建立 AIGC 内容安全蓝军评测能力,对大模型实现例行化的安全评估。

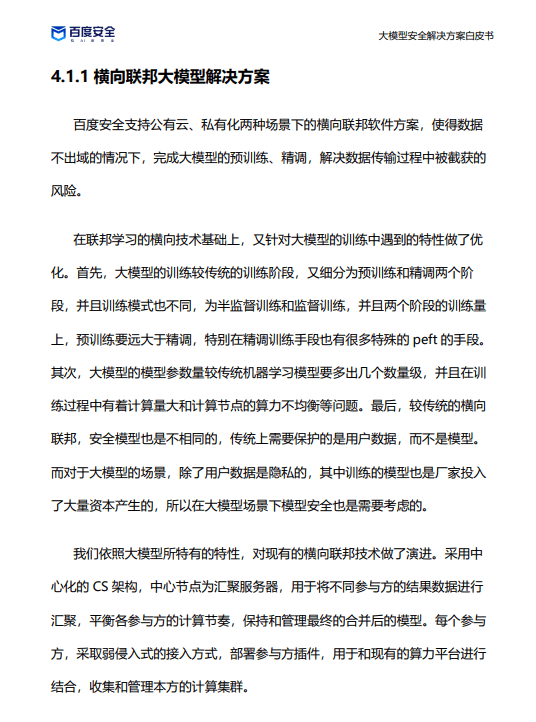

模型保护方案

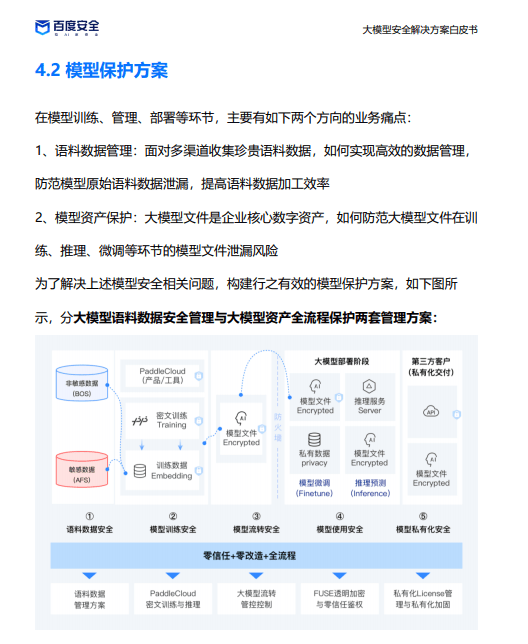

在模型训练、管理、部署等环节,主要有如下两个方向的业务痛点:

1、语料数据管理:面对多渠道收集珍贵语料数据,如何实现高效的数据管理, 防范模型原始语料数据泄漏,提高语料数据加工效率。

2、模型资产保护:大模型文件是企业核心数字资产,如何防范大模型文件在训 练、推理、微调等环节的模型文件泄漏风险。

报告共计:61页

版权归原作者 AIGC学派 所有, 如有侵权,请联系我们删除。