Scrapy_下载中间件介绍

下载中间件是Scrapy请求/响应处理的钩子框架。这是一个轻、低层次的应用。

通过可下载中间件,可以处理请求之前和请求之后的数据。

每个中间件组件都是一个Python类,它定义了一个或多个以下方法,我们可能需要使用方法如下:

- process_request()

- process_response()

1 process_request(self, request, spider)

当每个request通过下载中间件时,该方法被调用

必须返回以下其中之一

- 返回 None- Scrapy 将继续处理该 request,执行其他的中间件的相应方法,直到合适的下载器处理函数(download handler)被调用,该 request 被执行(其 response 被下载)

- 返回一个 Response 对象- Scrapy 将不会调用 任何 其他的 process_request()或 process_exception()方法,或相应地下载函数; 其将返回该 response。已安装的中间件的 process_response()方法则会在每个 response 返回时被调用

- 返回一个 Request 对象- Scrapy 则停止调用 process_request 方法并重新调度返回的 request。当新返回的 request 被执行后, 相应地中间件链将会根据下载的 response 被调用

- raise IgnoreRequest- 如果抛出 一个 IgnoreRequest 异常,则安装的下载中间件的 process_exception() 方法会被调用。如果没有任何一个方法处理该异常, 则 request 的 errback(Request.errback)方法会被调用。如果没有代码处理抛出的异常, 则该异常被忽略且不记录(不同于其他异常那样)

参数:

- request (Request 对象) – 处理的request

- spider (Spider 对象) – 该request对应的spider

2 process_response(self, request, response, spider)

当下载器完成http请求,传递响应给引擎的时候调用

process_response()应该是:返回一个

Response

对象,则返回一个

Request

对象或引发

IgnoreRequest

例外情况。

- 如果它返回

Response(可能是相同的给定响应,也可能是全新的响应),该响应将继续使用process_response()链中的下一个中间件 - 如果它返回一个

Request对象时,中间件链将暂停,返回的请求将重新计划为将来下载。这与从返回请求的行为相同process_request() - 如果它引发了

IgnoreRequest异常,请求的errback函数 (Request.errback)。如果没有代码处理引发的异常,则忽略该异常,不记录该异常(与其他异常不同)。 - 参数- request (is a

Requestobject) – 发起响应的请求- response (Responseobject) – 正在处理的响应- spider (Spiderobject) – 此响应所针对的蜘蛛

Scrapy_下载中间件设置UserAgent

下载中间件是Scrapy请求/响应处理的钩子框架。这是一个轻、低层次的应用。

通过可下载中间件,可以处理请求之前和请求之后的数据。

如果使用下载中间件需要在Scrapy中的setting.py的配置DOWNLOADER_MIDDLEWARES才可以使用,

比如:

DOWNLOADER_MIDDLEWARES ={'myproject.middlewares.CustomDownloaderMiddleware':543,}

1 开发UserAgent下载中间件

问题

每次创建项目后,需要自己复制UserAgent到settings,比较繁琐

解决方案

开发下载中间件,设置UserAgent

from fake_useragent import UserAgent

classMyUserAgentMiddleware:defprocess_request(self, request, spider):

request.headers.setdefault(b'User-Agent', UserAgent().chrome)

2 三方模块

pip install scrapy-fake-useragent==1.4.4

配置模块到Setting文件

DOWNLOADER_MIDDLEWARES ={'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware':None,'scrapy.downloadermiddlewares.retry.RetryMiddleware':None,'scrapy_fake_useragent.middleware.RandomUserAgentMiddleware':400,'scrapy_fake_useragent.middleware.RetryUserAgentMiddleware':401,}

Scrapy_下载中间件设置代理

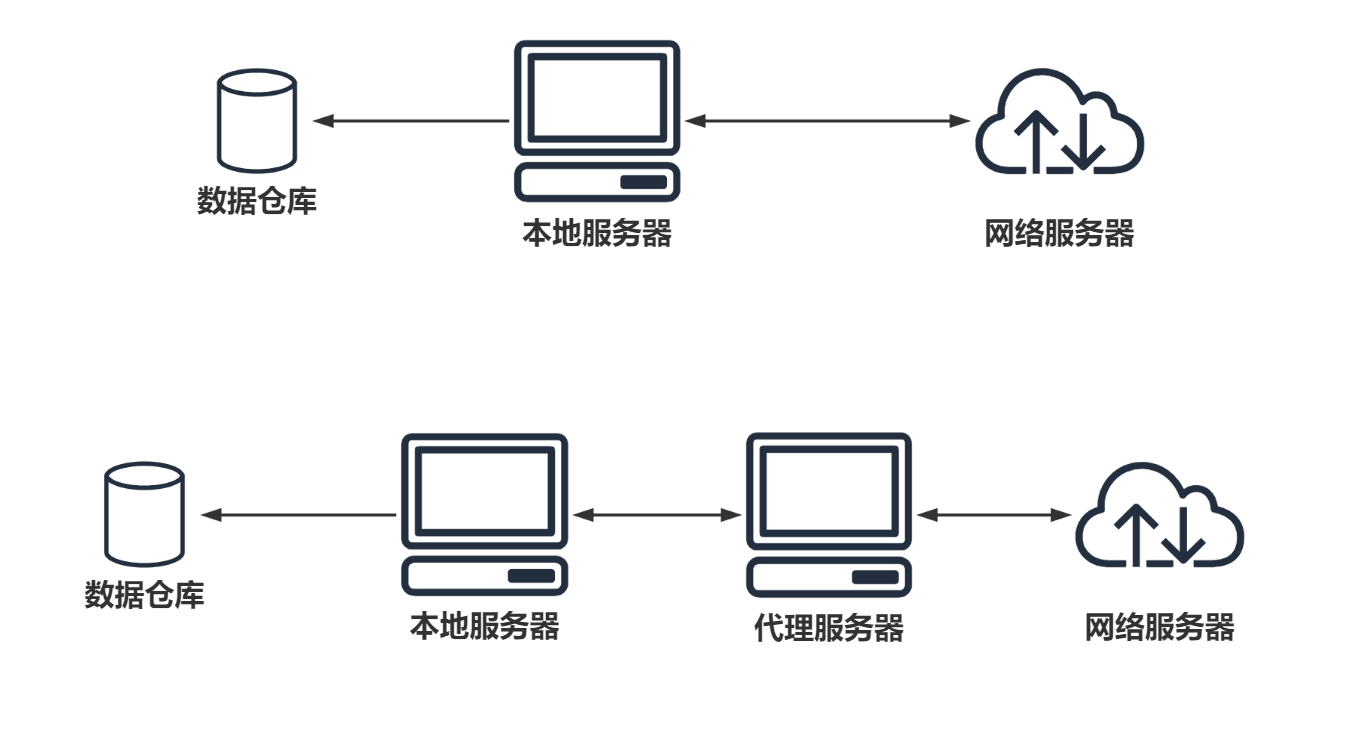

爬虫设置代理就是让别的服务器或电脑代替自己的服务器去获取数据

1 爬虫代理原理

2 代码

通过

request.meta['proxy']

可以设置代理,如下:

classMyProxyDownloaderMiddleware:defprocess_request(self, request, spider):# request.meta['proxy'] ='http://ip:port'# request.meta['proxy'] ='http://name:pwd@ip:port'

request.meta['proxy']='http://139.224.211.212:8080'

Scrapy_下载中间件结合selenium使用

有的页面反爬技术比较高端,一时破解不了,这时我们就是可以考虑使用selenium来降低爬取的难度。

问题来了,如何将Scrapy与Selenium结合使用呢?

思考的思路: 只是用Selenium来帮助下载数据。因此可以考虑通过下载中间件来处理这块内容。

具体代码如下:

Spider文件

@classmethoddeffrom_crawler(cls, crawler,*args,**kwargs):

spider =super(BaiduSpider, cls).from_crawler(crawler,*args,**kwargs)

spider.chrome = webdriver.Chrome(executable_path='../tools/chromedriver.exe')

crawler.signals.connect(spider.spider_closed, signal=signals.spider_closed)# connect里的参数 # 1. 处罚事件后用哪个函数处理# 2. 捕捉哪个事件return spider

defspider_closed(self, spider):

spider.chrome.close()

middlewares文件

defprocess_request(self, request, spider):

spider.chrome.get(request.url)

html = spider.chrome.page_source

return HtmlResponse(url = request.url,body = html,request = request,encoding='utf-8')

版权归原作者 留不住的人 所有, 如有侵权,请联系我们删除。