metastore为Hive CLI或Hiveserver2提供元数据访问接口。

1 metastore运行模式

metastore运行模式有两种,嵌入式模式和独立服务模式。

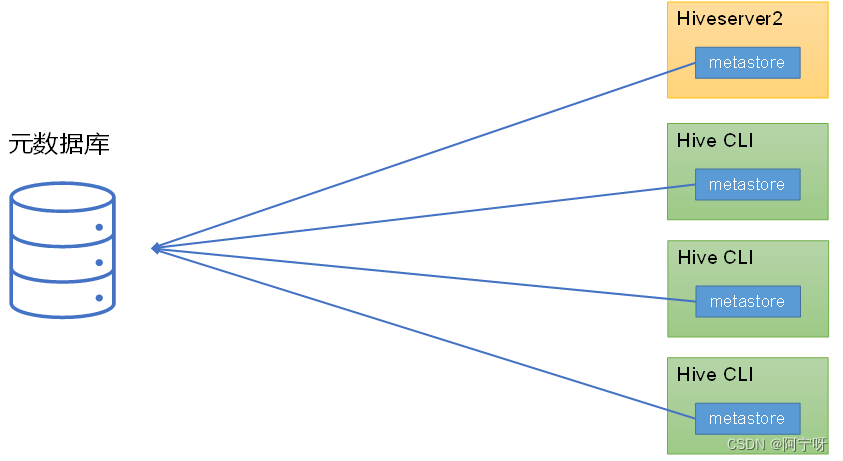

(1)嵌入式模式

将metastore看作一个依赖嵌入到Hiveserver2和每一个HiveCLI客户端进程,使得Hiveserver2和HiveCLI客户端直接连接访问数据库。

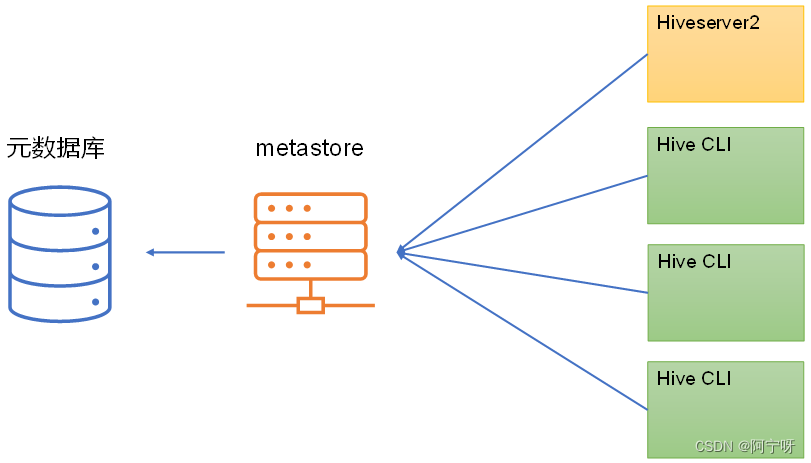

(2)独立服务模式

把metastore服务独立出来单独启动,Hiveserver2和Hive命令行客户端都访问metastore服务,然后再由metastore访问元数据库。

Metastore不负责存储元数据,只负责提供访问元数据的接口。

生产环境中,不推荐使用嵌入式模式。因为其存在以下两个问题:

(i)嵌入式模式下,每个Hive CLI都需要直接连接元数据库,当Hive CLI较多时,数据库压力会比较大。

(ii)每个客户端都需要用户元数据库的读写权限,元数据库的安全得不到很好的保证。

2 metastore部署

(1)嵌入式部署

嵌入式模式下,只需保证Hiveserver2和每个Hive CLI的配置文件hive-site.xml中包含连接元数据库所需要的以下参数即可:

<!-- jdbc连接的URL--><property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://hadoop102:3306/metastore?useSSL=false</value></property><!-- jdbc连接的Driver--><property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.cj.jdbc.Driver</value></property><!--jdbc连接的username--><property><name>javax.jdo.option.ConnectionUserName</name><value>root</value></property><!-- jdbc连接的password--><property><name>javax.jdo.option.ConnectionPassword</name><value>123456</value></property>

(2)独立服务模式

需求:Metastore服务部署到hadoop102机器上,客户端部署在hadoop103、hadoop104上。

(i)在hadoop102把hive发送到hadoop103和hadoop104上:

scp -r /opt/module/hive/ hadoop103:/opt/module/

scp -r /opt/module/hive/ hadoop104:/opt/module/

在hadoop102上把/etc/profilr.d/my_env.sh分发,再分别在hadoop103和hadoop104source一下环境:

cd /etc/profile.d

xsync my_env.sh

hadoop103和hadoop104下:

source /etc/profile.d/my_env.sh

(ii)保证metastore服务的配置文件hive-site.xml中包含连接元数据库所需的以下参数,在hadoop102下的HIVE_HOME/conf的hive.site.xml配置:

<!-- jdbc连接的URL--><property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://hadoop102:3306/metastore?useSSL=false</value></property><!-- jdbc连接的Driver--><property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.cj.jdbc.Driver</value></property><!--jdbc连接的username--><property><name>javax.jdo.option.ConnectionUserName</name><value>root</value></property><!-- jdbc连接的password--><property><name>javax.jdo.option.ConnectionPassword</name><value>123456</value></property>

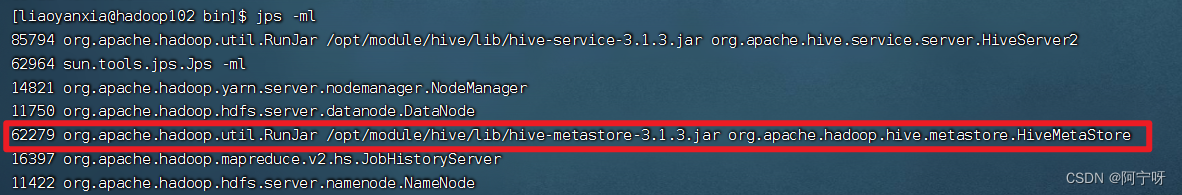

(iii)在hadoop102中启动metastore服务:

nohup hive –-service metastore &

用jps -ml查看进程:

(iv)配置hive客户端:

保证Hiveserver2和每个Hive CLI的配置文件hive-site.xml中包含访问metastore服务所需的参数。

在hadoop103和104下的HIVE_HOME/conf/的hive-site.xml中删除与jdbs有关的配置。

如果不删除直接添加的话进入到hive客户端执行语句会报错:不能初始化metastore客户端:

hive (default)> show databases;

FAILED:HiveExceptionjava.lang.RuntimeException:Unabletoinstantiateorg.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

这是因为在Hive CLI(客户端)的配置文件中配置了hive.metastore.uris参数,此时Hive CLI会去请求执行的metastore服务地址,所以必须启动metastore服务才能正常使用。

也即给同一个节点同时配置metastore服务和客户端时,客户端是访问metastore服务的。

hadoop103和hadoop104的hive-site.xml中添加:

<!-- 指定metastore服务的地址,只要在客户端中配了metastore地址就会访问metastore服务地址 --><property><name>hive.metastore.uris</name><value>thrift://hadoop102:9083</value></property>

主机名改为metastore服务所在节点,metastore服务的默认端口为9083。

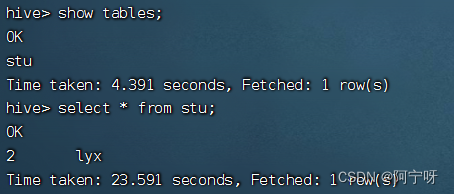

(v)在hadoop103进入到hive的客户端:

cd HIVE_HOME

bin/hive

hive>show tables;

hive>select * from stu;

可以看到能查出数据,即客户端表示能够访问metastore服务。

版权归原作者 阿宁呀 所有, 如有侵权,请联系我们删除。