Hadoop入门(十)——集群配置(图文详解步骤2021)

系列文章传送门

这个系列文章传送门:

Hadoop入门(一)——CentOS7下载+VM上安装(手动分区)图文步骤详解(2021)

Hadoop入门(二)——VMware虚拟网络设置+Windows10的IP地址配置+CentOS静态IP设置(图文详解步骤2021)

Hadoop入门(三)——XSHELL7远程访问工具+XFTP7文件传输(图文步骤详解2021)

Hadoop入门(四)——模板虚拟机环境准备(图文步骤详解2021)

Hadoop入门(五)——Hadoop集群搭建-克隆三台虚拟机(图文步骤详解2021)

Hadoop入门(六)——JDK安装(图文步骤详解2021)

Hadoop入门(七)——Hadoop安装(图文详解步骤2021)

Hadoop入门(八)——本地运行模式+完全分布模式案例详解,实现WordCount和集群分发脚本xsync快速配置环境变量 (图文详解步骤2021)

Hadoop入门(九)——SSH免密登录 配置

Hadoop入门(十)——集群配置(图文详解步骤2021)

Hadoop入门(十一)——集群崩溃的处理方法(图文详解步骤2021)

Hadoop入门(十二)——配置历史服务器及日志的聚集(图文详解步骤2021)

Hadoop入门(十三)——集群常用知识(面试题)与技巧总结

Hadoop入门(十四)——集群时间同步(图文详解步骤2021)

Hadoop入门(十五)——集群常见错误及解决方案

文章目录

(一)集群配置

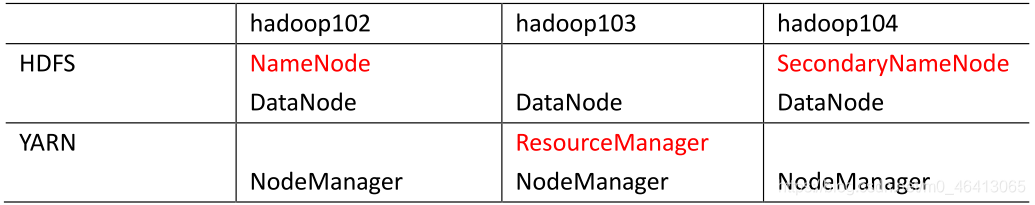

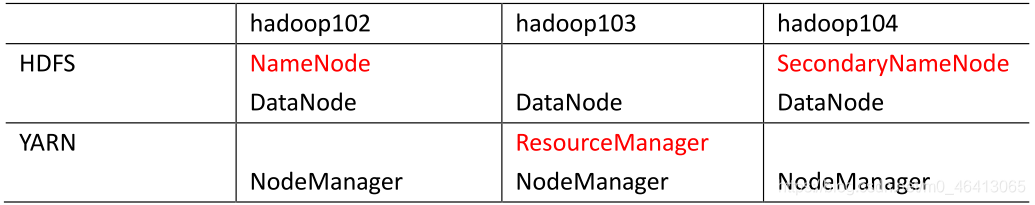

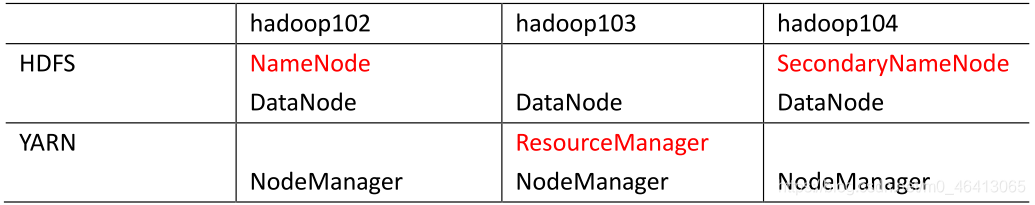

1 ) 集群部署规划

注意:

- NameNode 和 SecondaryNameNode 不要安装在同一台服务器 。 (它们两个都需要耗内存,分开减少集群的压力)

- ResourceManager 也很消耗内存,不要和 NameNode、SecondaryNameNode 配置在同一台机器上。

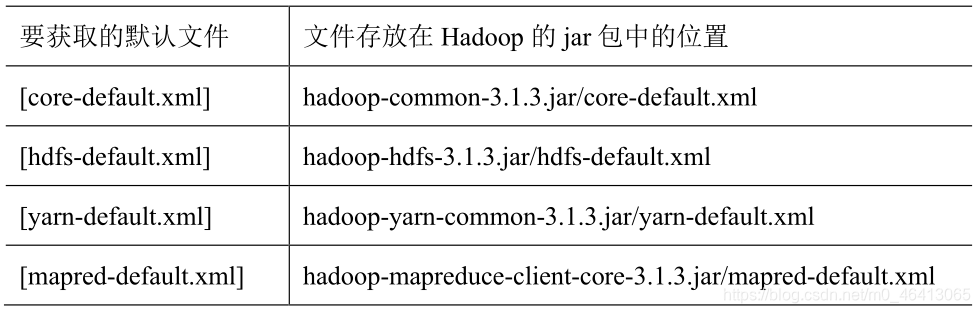

2 )配置文件说明

Hadoop 配置文件分两类:默认配置文件和自定义配置文件,只有用户想修改某一默认配置值时,才需要修改自定义配置文件,更改相应属性值。

(1)默认配置文件:

(2)自定义配置文件:

core-site.xml 、hdfs-site.xml 、yarn-site.xml 、mapred-site.xml 四个配置文件存放在

$HADOOP_HOME/etc/hadoop 这个路径上,用户可以根据项目需求重新进行修改配置。

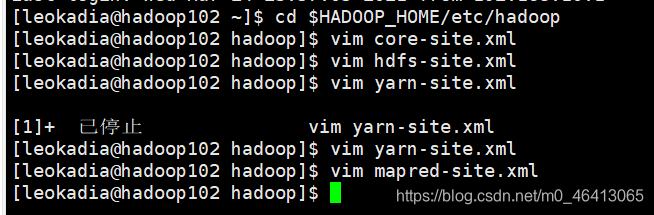

3 ) 配置 集群

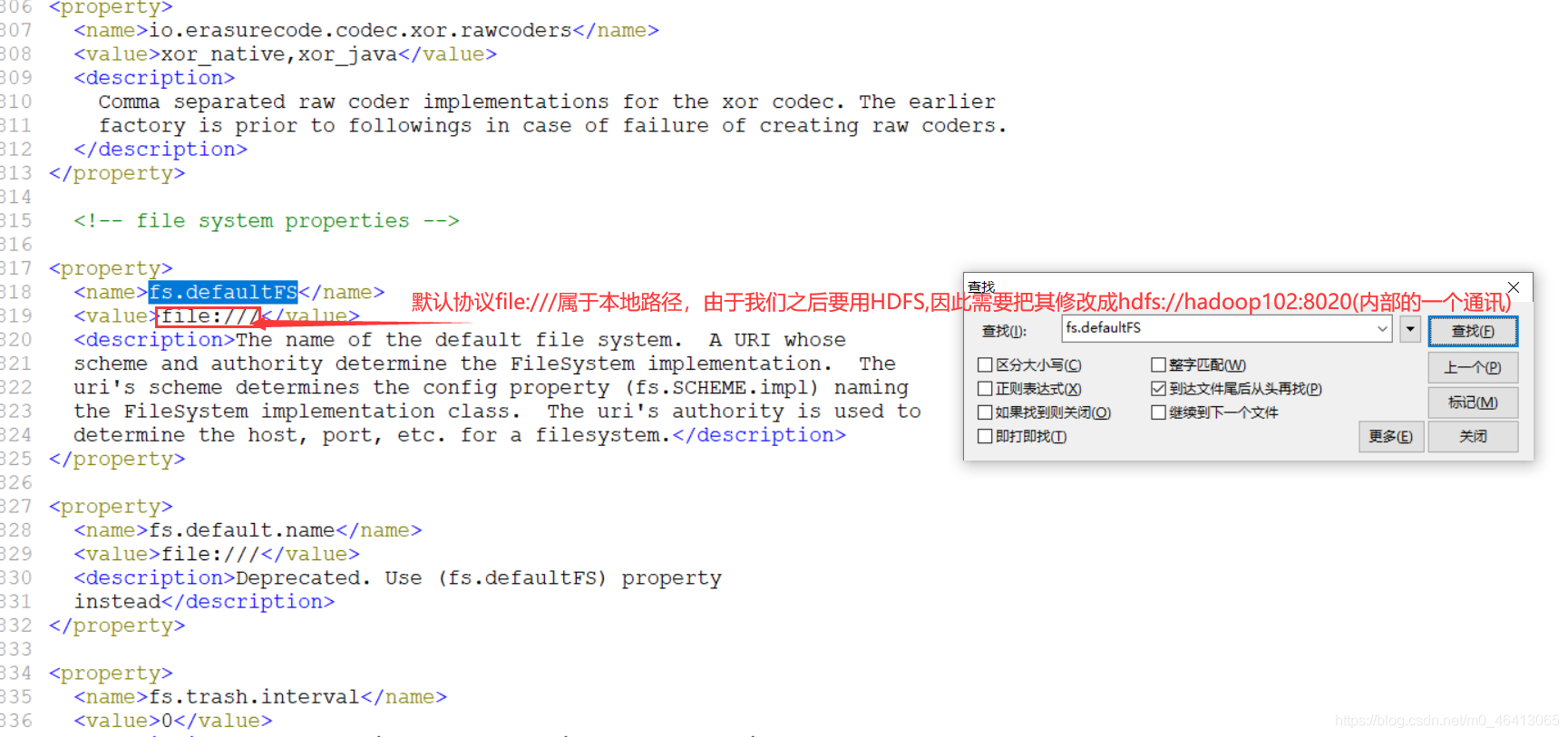

(1)核心配置文件

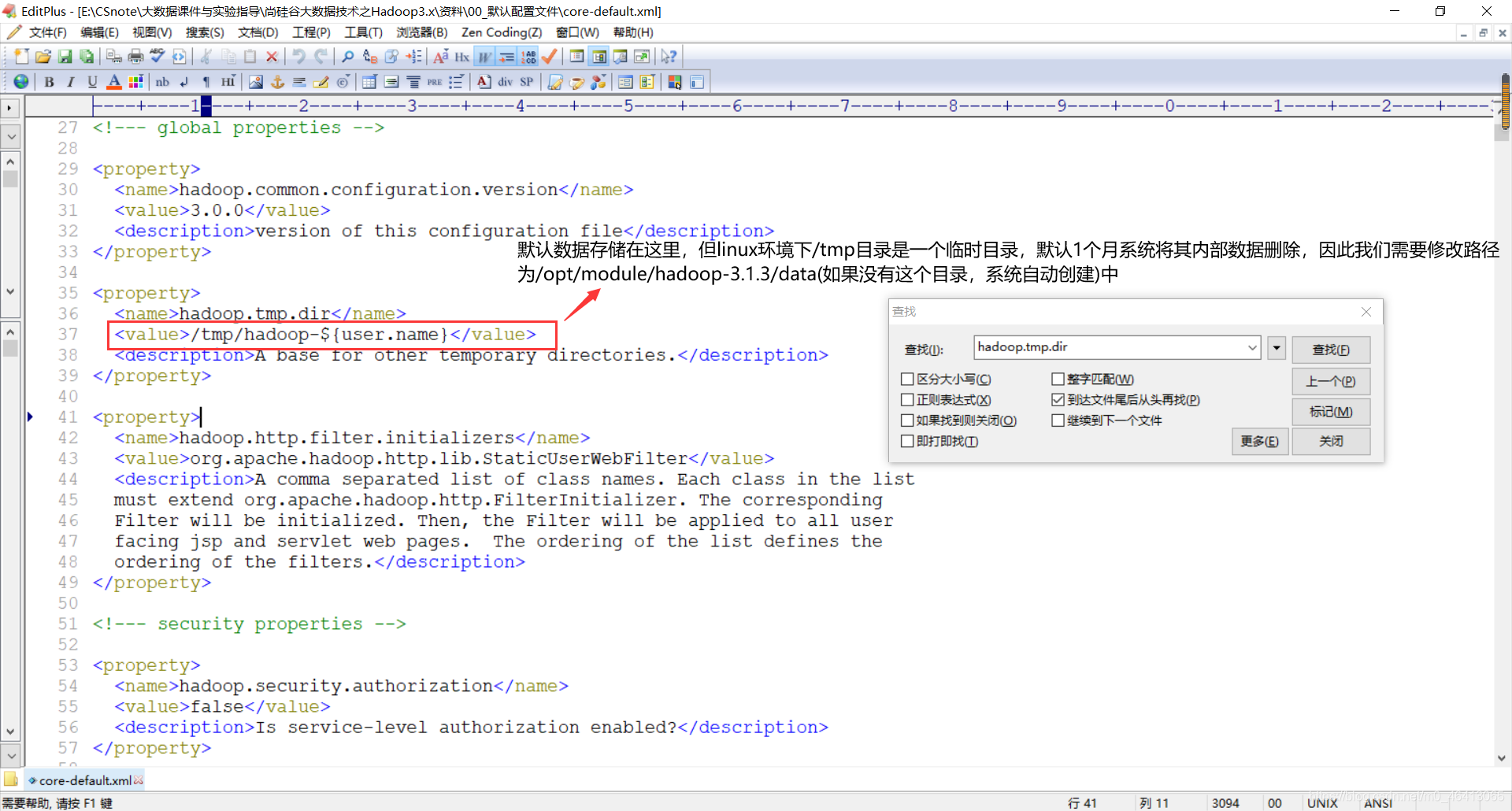

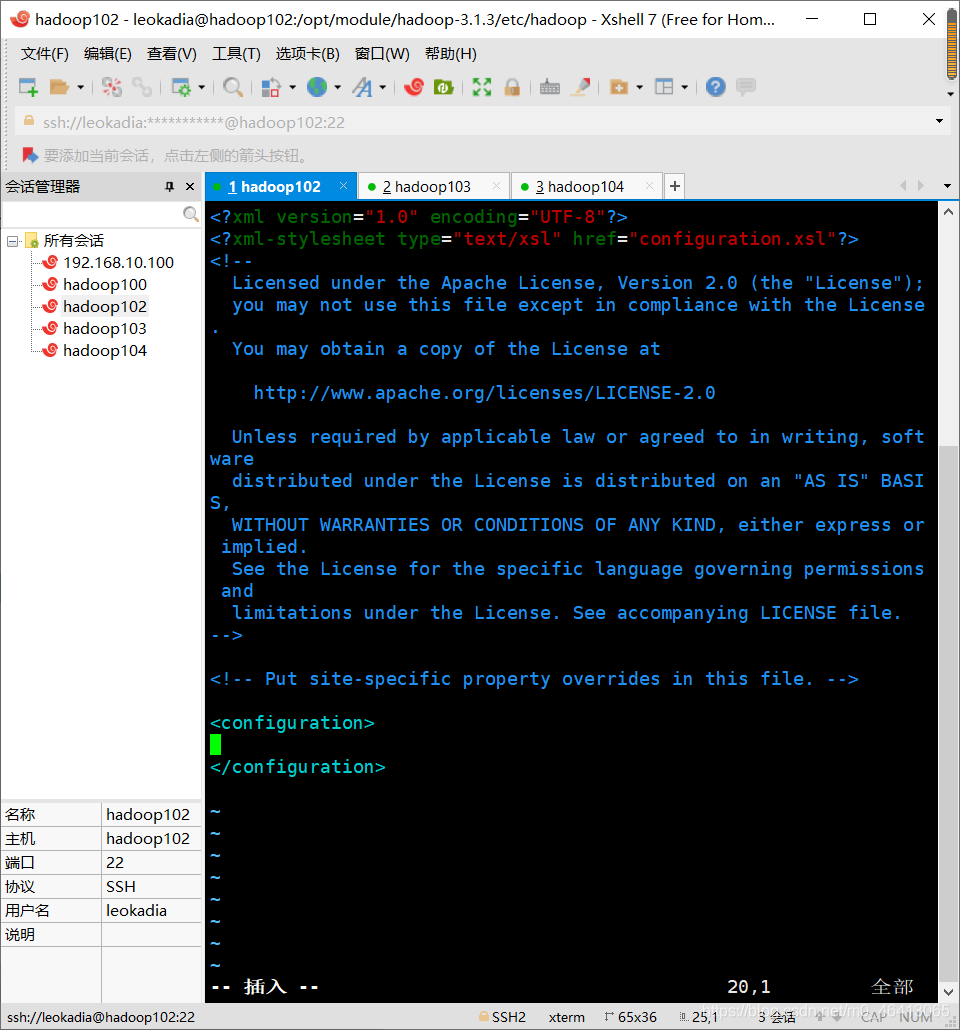

配置 core-site.xml

[leokadia@hadoop102 ~] $

cd $HADOOP_HOME/etc/hadoop

[leokadia@hadoop102 hadoop]$

vim core-site.xml

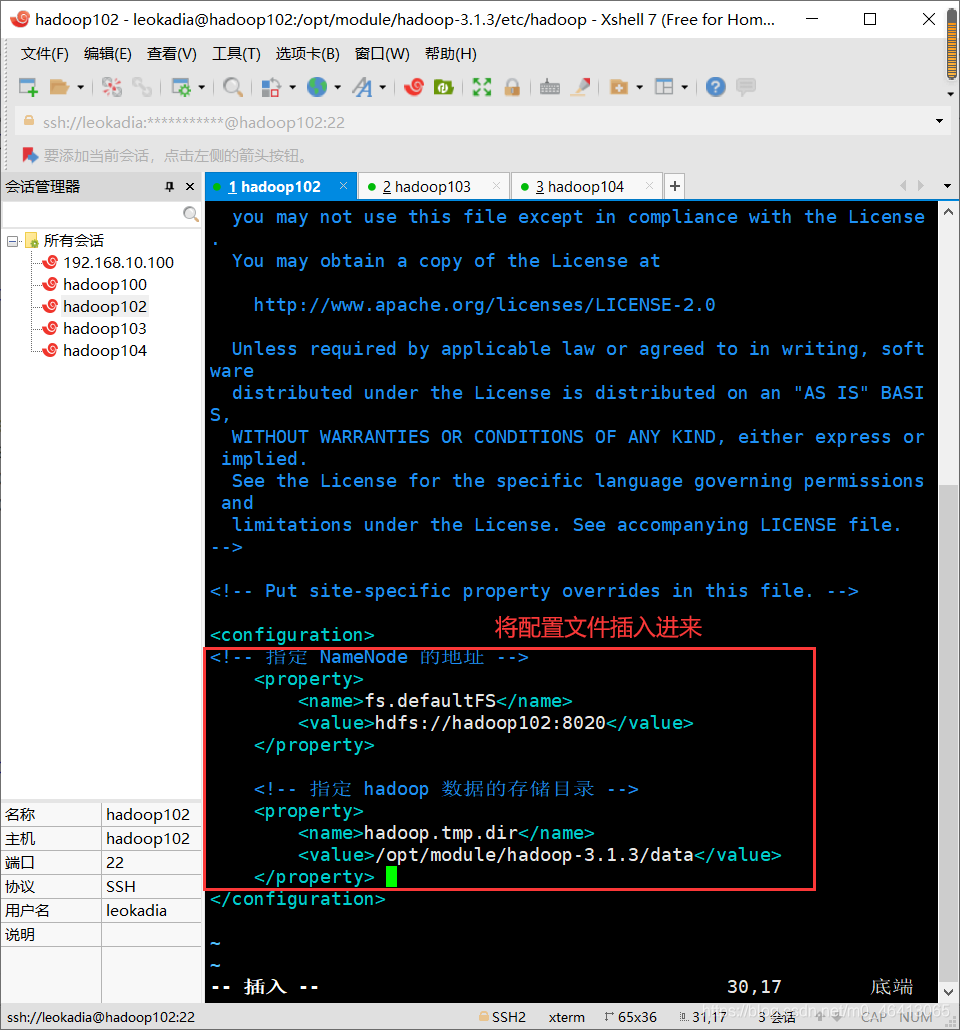

文件内容如下:

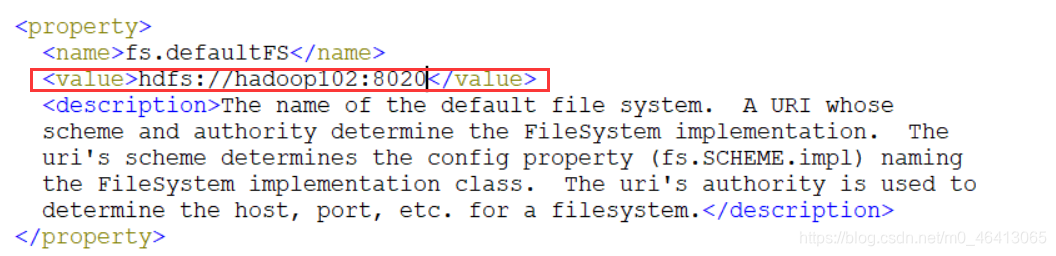

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 指定 NameNode 的地址 --><property><name>fs.defaultFS</name><value>hdfs://hadoop102:8020</value></property></configuration>

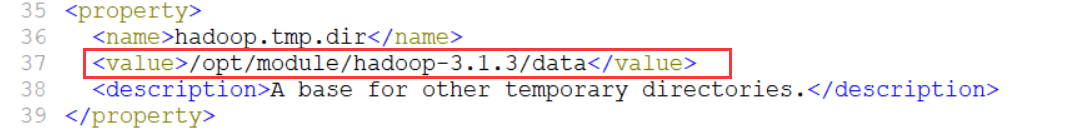

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 指定 hadoop 数据的存储目录 --><property><name>hadoop.tmp.dir</name><value>/opt/module/hadoop-3.1.3/data</value></property></configuration>

先配置前面两个,后面这个我们先不配置,看看之后会出现什么问题

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 配置 HDFS 网页登录使用的静态用户为 leokadia --><property><name>hadoop.http.staticuser.user</name><value>leokadia</value></property></configuration>

也就是说我们总共要插入配置文件的东西一共有这三个

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 指定 NameNode 的地址 --><property><name>fs.defaultFS</name><value>hdfs://hadoop102:8020</value></property><!-- 指定 hadoop 数据的存储目录 --><property><name>hadoop.tmp.dir</name><value>/opt/module/hadoop-3.1.3/data</value></property><!-- 配置 HDFS 网页登录使用的静态用户为 atguigu --><property><name>hadoop.http.staticuser.user</name><value>atguigu</value></property></configuration>

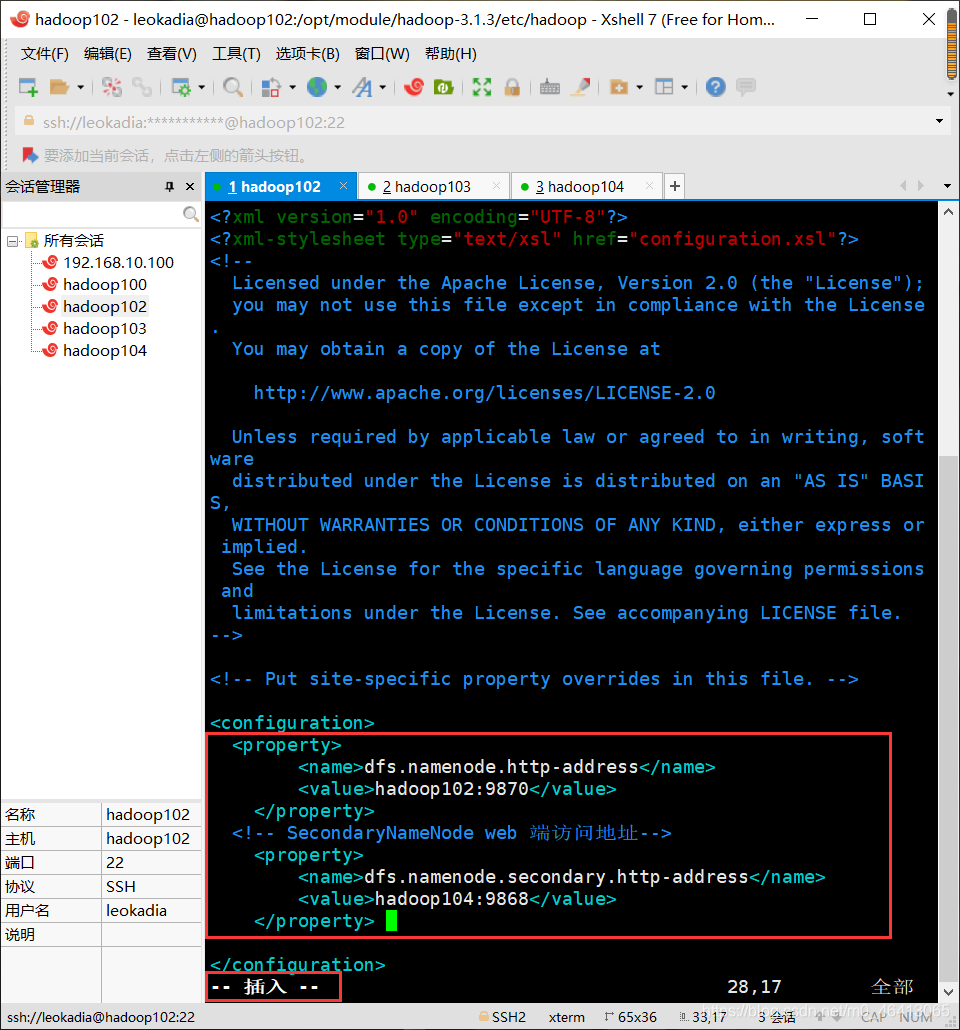

(2)HDFS 配置文件

配置 hdfs-site.xml

[leokadia@hadoop102 hadoop]$

vim hdfs-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- NameNode web 端访问地址--><property><name>dfs.namenode.http-address</name><value>hadoop102:9870</value></property><!-- SecondaryNameNode web 端访问地址--><property><name>dfs.namenode.secondary.http-address</name><value>hadoop104:9868</value></property></configuration>

p.s.之前核心配置文件中NameNode地址hdfs://hadoop102:8020相当于是hadoop内部通讯地址,

现在NameNode是HDFS需要用户在web界面上访问,不需要操作命令行,即也需要对外暴露一个接口hadoop102:9870

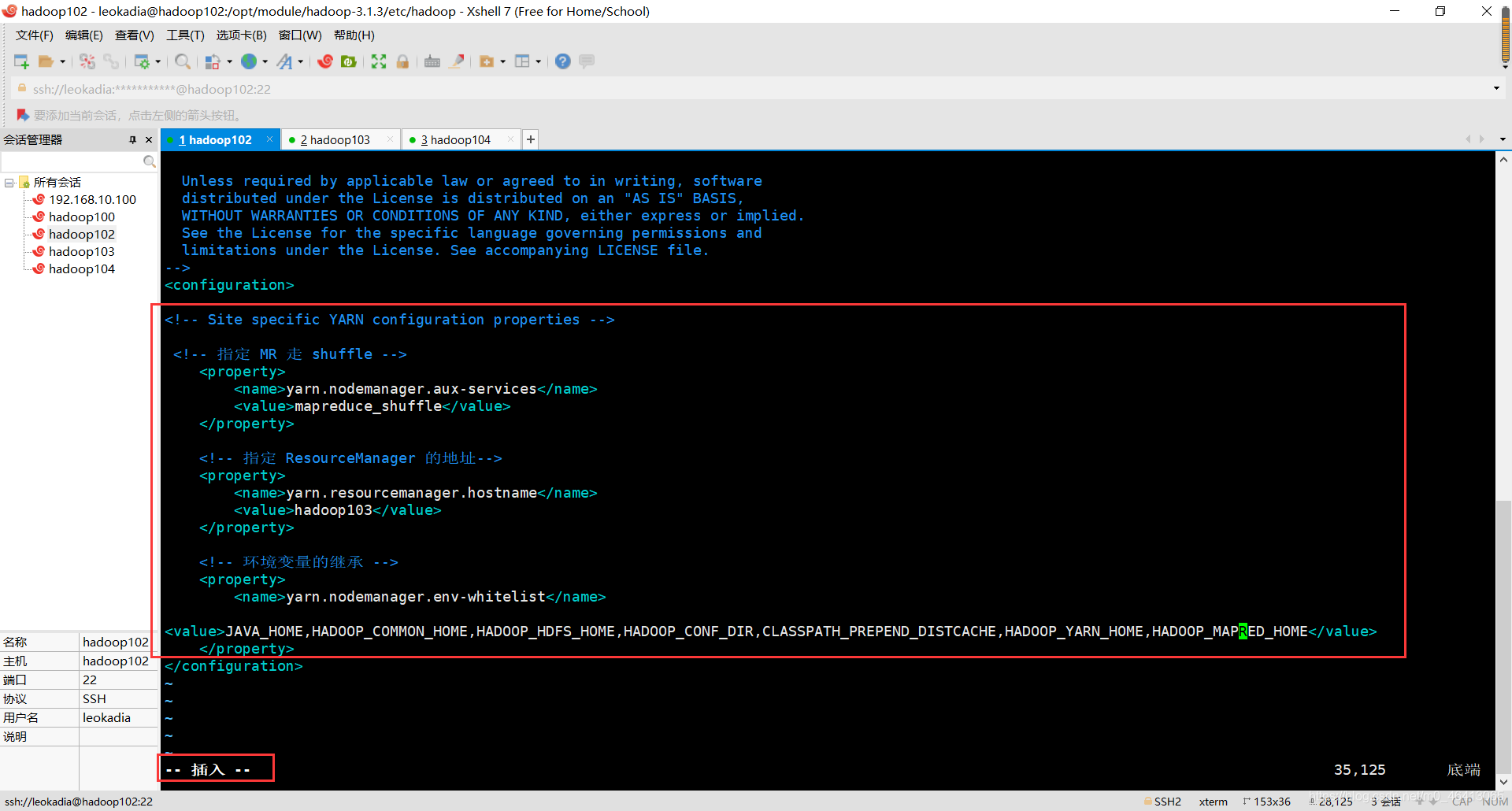

(3)YARN 配置文件

配置 yarn-site.xml

[leokadia@hadoop102 hadoop]$

vim yarn-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 指定 MR 走 shuffle --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!-- 指定 ResourceManager 的地址--><property><name>yarn.resourcemanager.hostname</name><value>hadoop103</value></property><!-- 环境变量的继承 --><property><name>yarn.nodemanager.env-whitelist</name><value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value></property></configuration>

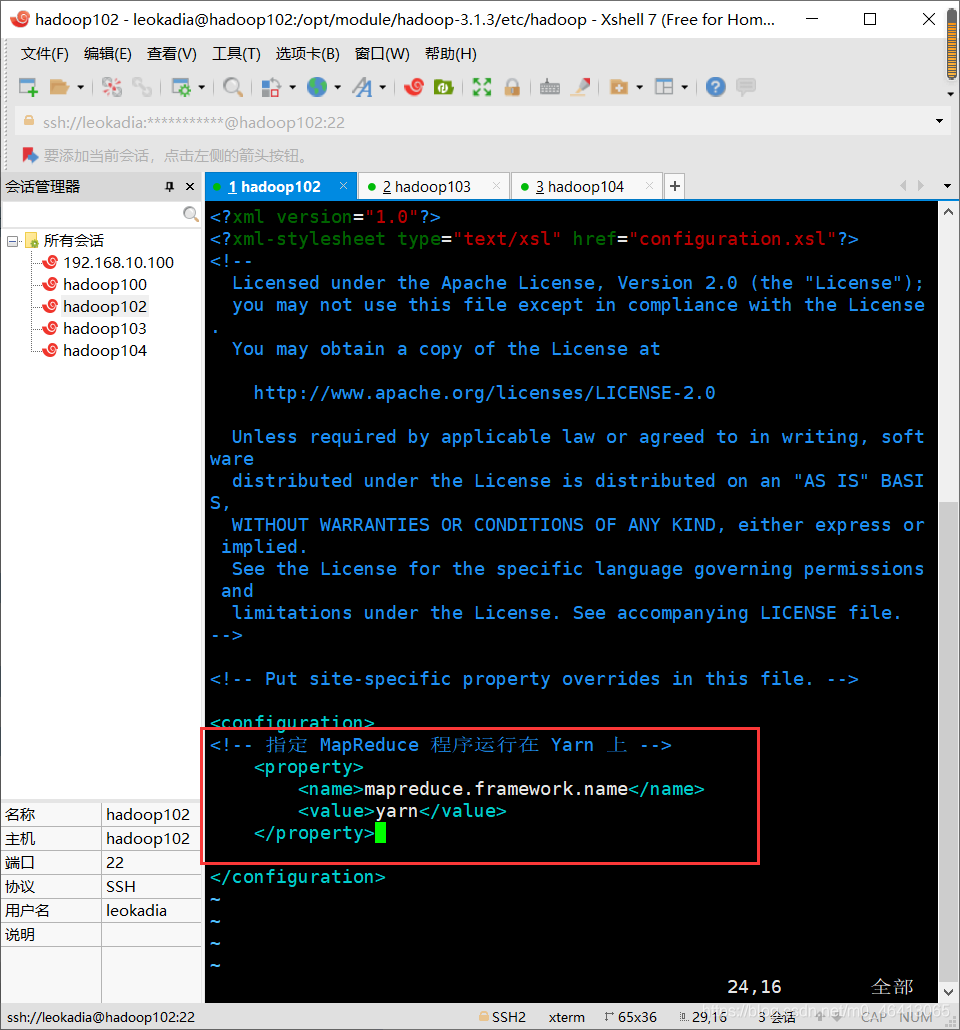

(4)MapReduce 配置文件

配置 mapred-site.xml

[leokadia@hadoop102 hadoop]$

vim mapred-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 指定 MapReduce 程序运行在 Yarn 上 --><property><name>mapreduce.framework.name</name><value>yarn</value></property></configuration>

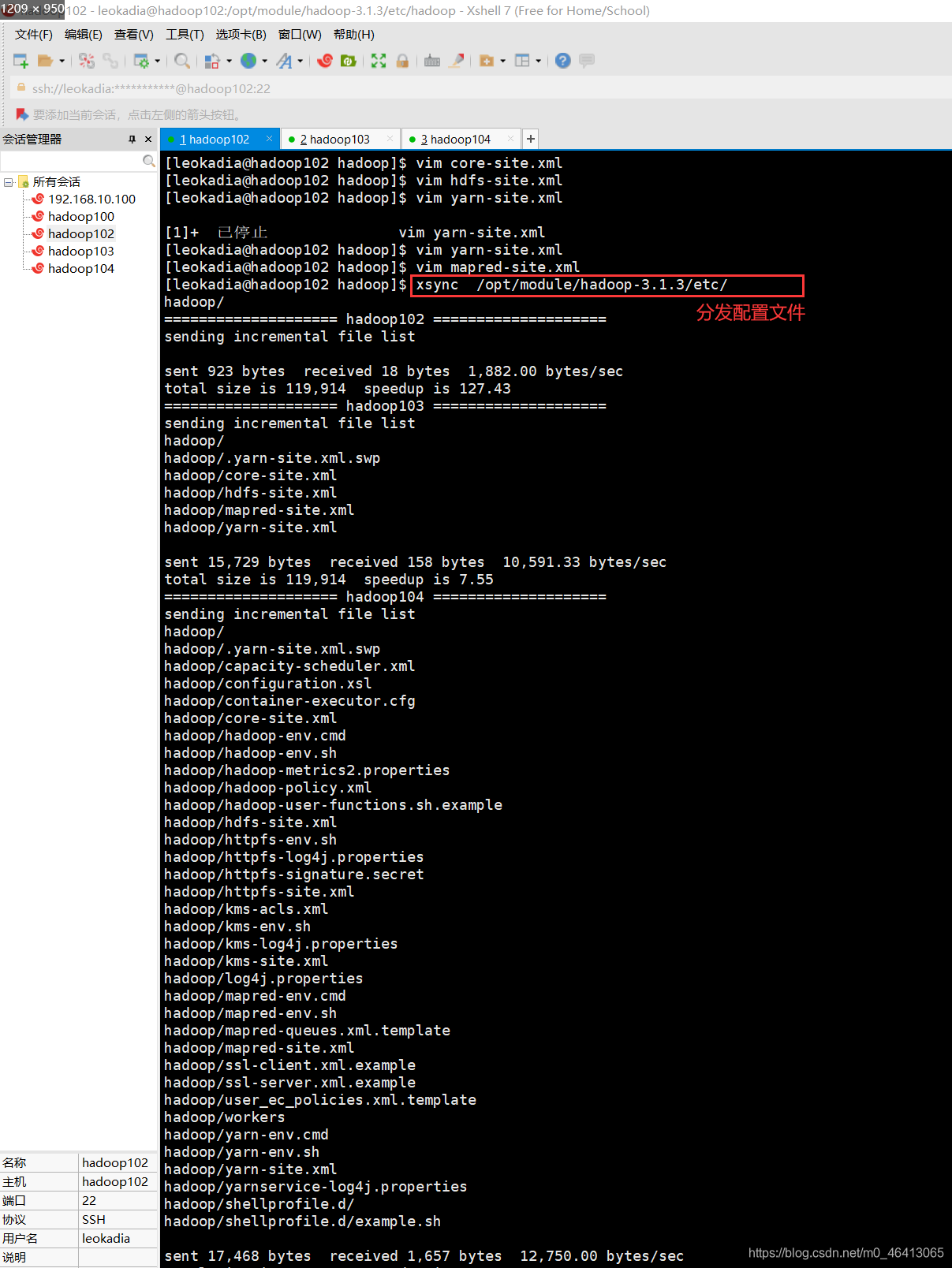

分别配置好上述文件,hadoop102的所有配置文件均配置完了。

但我们需要将这个配置文件分发给hadoop103,hadoop104

4 ) 在集群上分发配置好的 Hadoop 配置文件

[leokadia@hadoop102 hadoop]$

xsync /opt/module/hadoop-3.1.3/etc/hadoop/

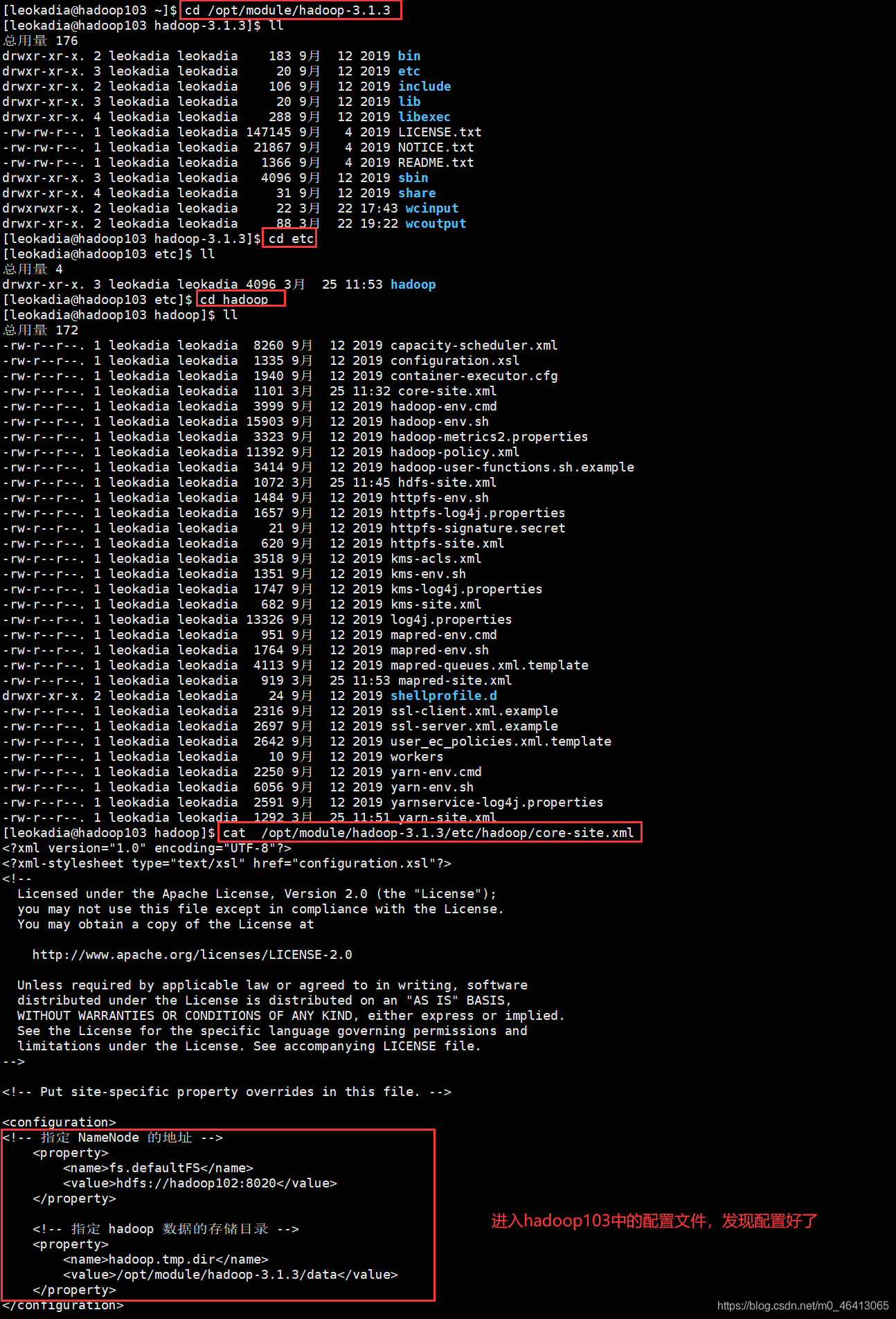

5 ) 去 103 和 104 上 查看文件分发情况

[leokadia@hadoop103 ~]$

cat /opt/module/hadoop-3.1.3/etc/hadoop/core-site.xml

[leokadia@hadoop104 ~]$

cat /opt/module/hadoop-3.1.3/etc/hadoop/core-site.xml

至此,整个集群的配置就搞定了!

(二)群起集群并测试

刚才已经把集群都配置完毕了,现在需要启动集群

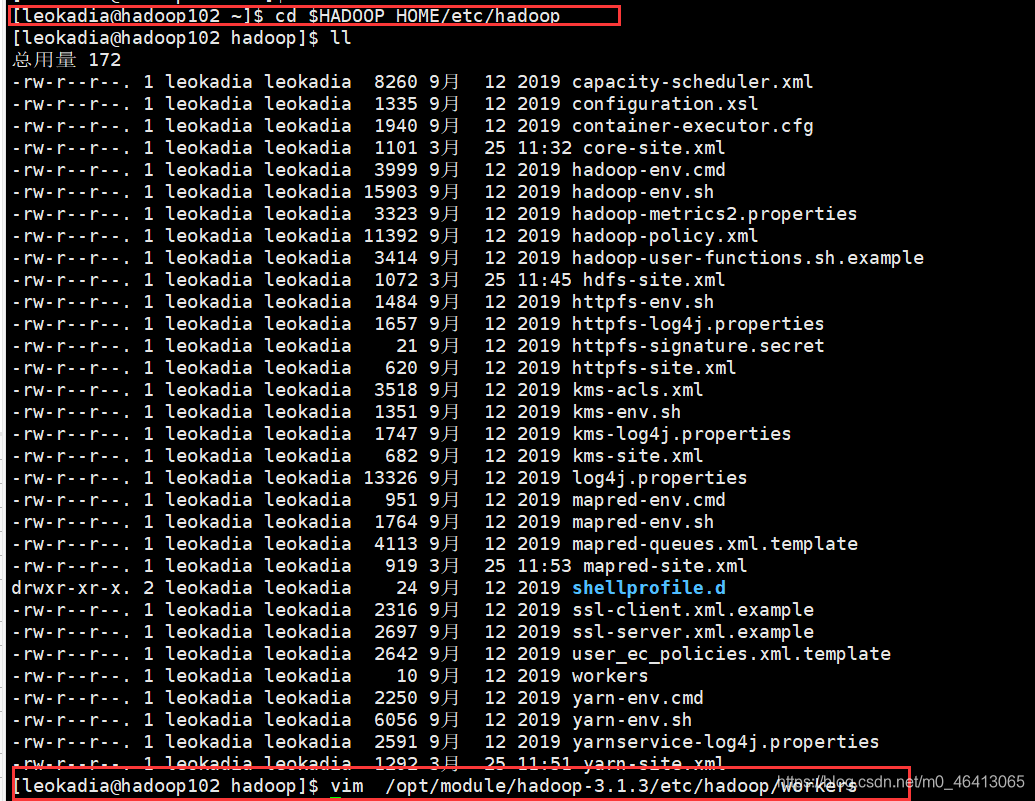

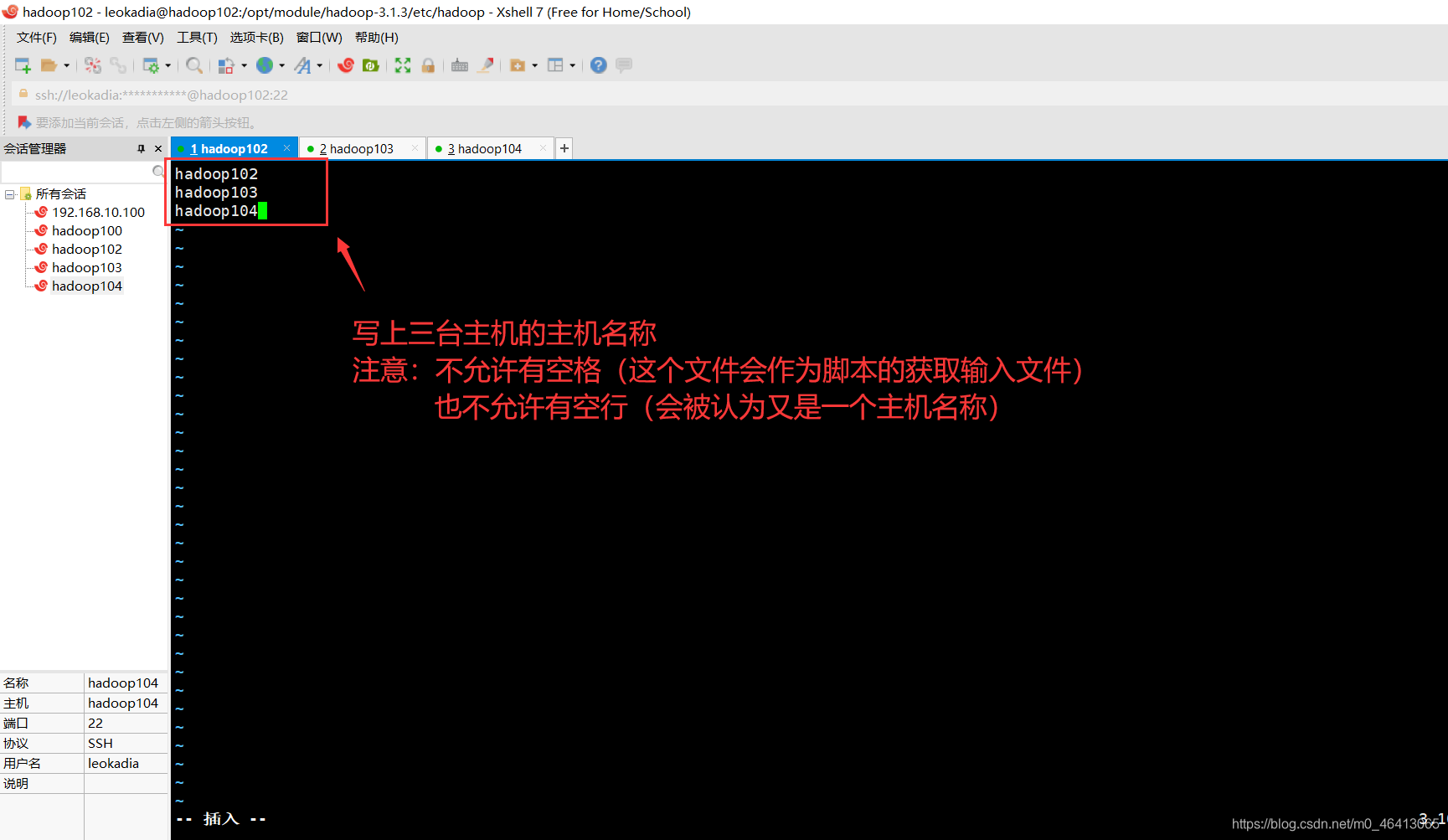

1 ) 配置 workers

在启动集群前需要配置workers

先进入hadoop目录

[leokadia@hadoop102 ~]$

cd $HADOOP_HOME/etc/hadoop

[leokadia@hadoop102 hadoop]$

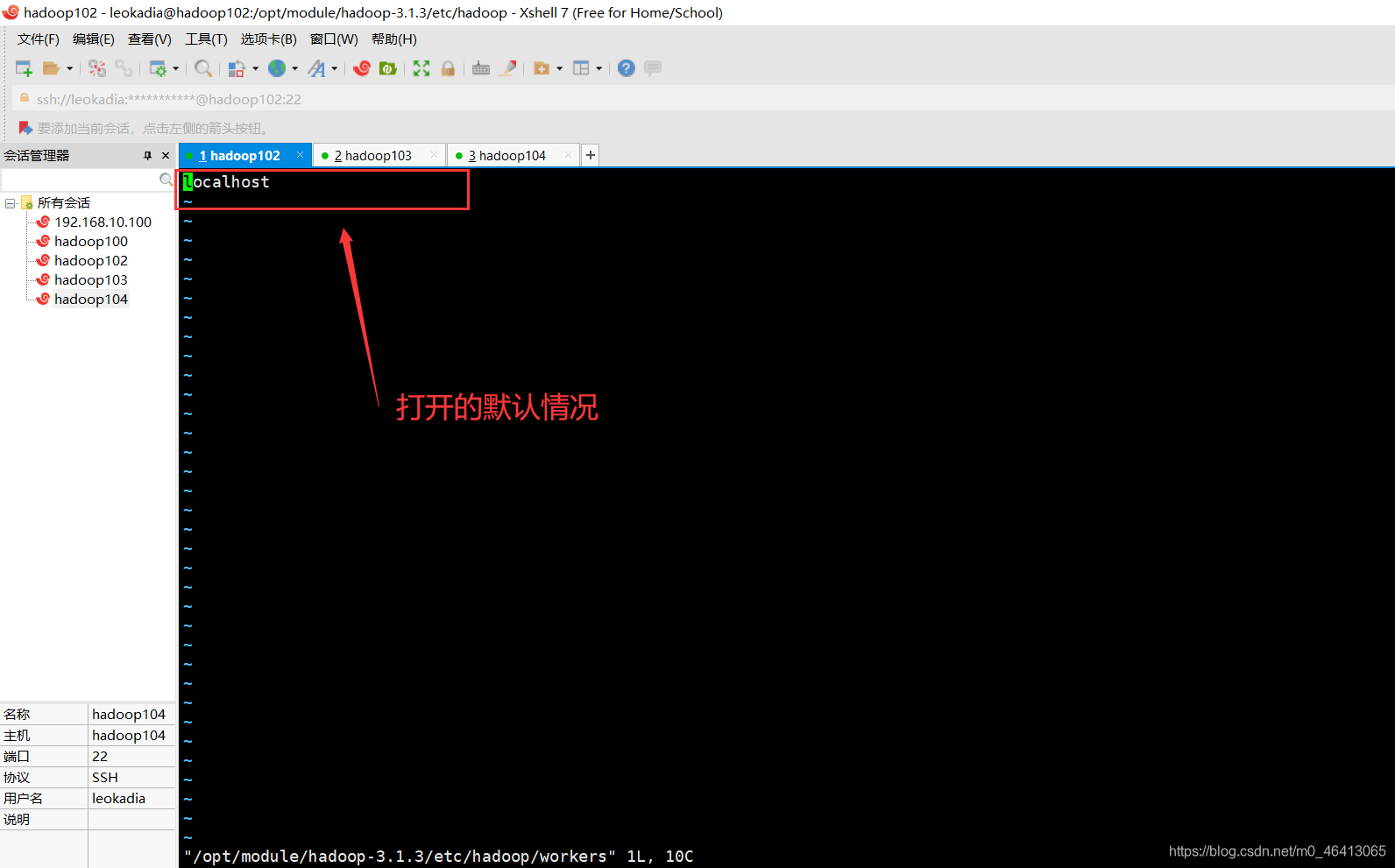

vim /opt/module/hadoop-3.1.3/etc/hadoop/workers

在该文件中增加如下内容:(有几个节点就配置几个主机名称)

hadoop102

hadoop103

hadoop104

注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行。

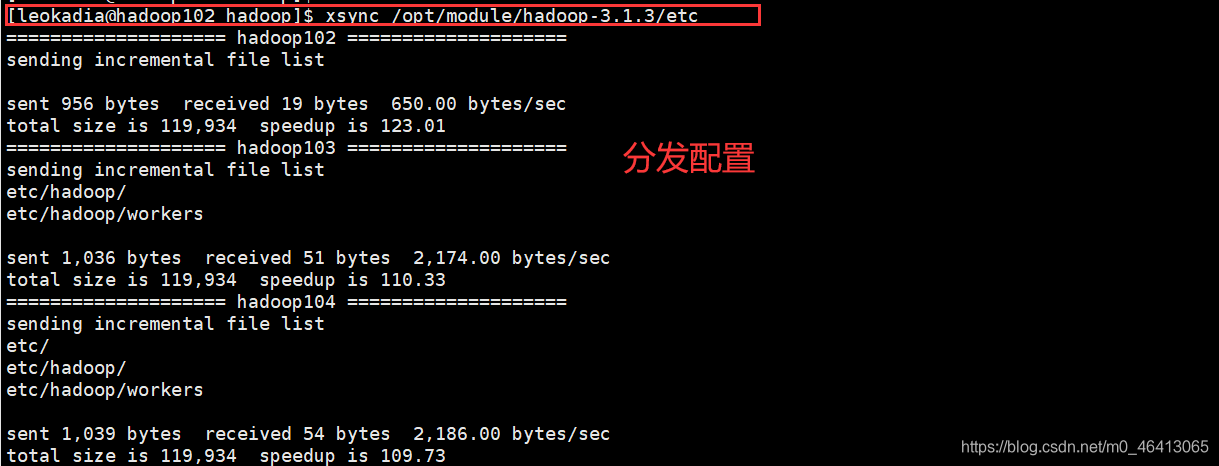

同步所有节点配置文件

[leokadia@hadoop102 hadoop]$

xsync /opt/module/hadoop-3.1.3/etc

分发配置,将三台节点配置完毕,回到家目录,准备启动集群

2 ) 启动集群

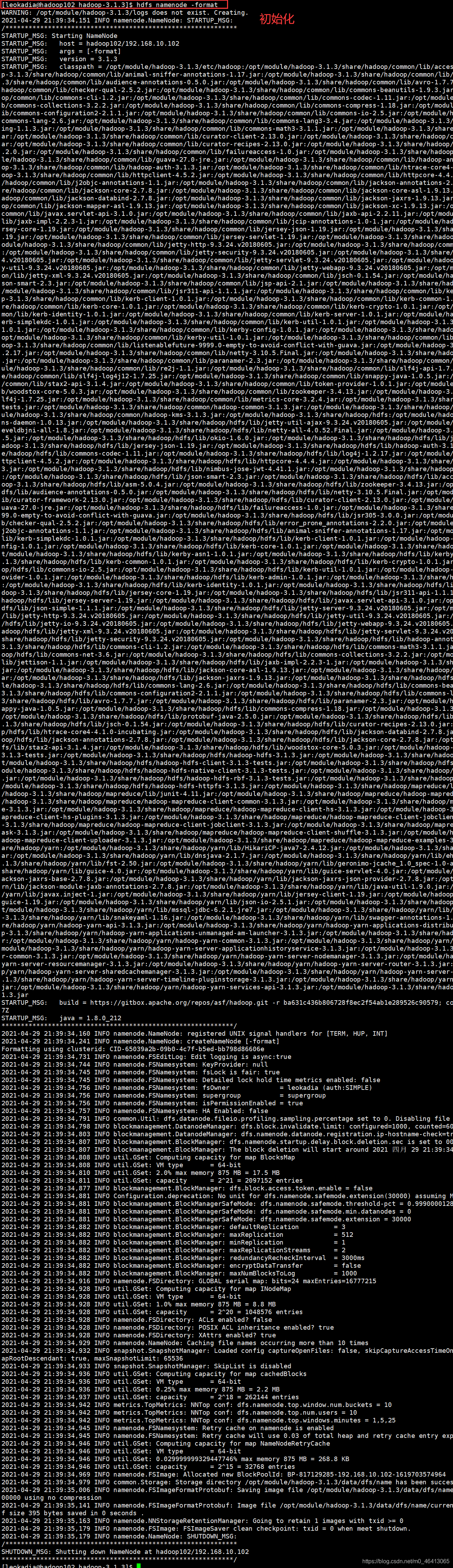

(1)初始化(注意:只有第一次的时候才需要)

如果集群是第一次启动,需要在 hadoop102 节点格式化 NameNode(注意:格式化 NameNode,会产生新的集群 id,导致 NameNode 和 DataNode 的集群 id 不一致,集群找不到已往数据。如果集群在运行过程中报错,需要重新格式化 NameNode 的话,一定要先停止 namenode 和 datanode 进程,并且要删除所有机器的 data 和 logs 目录,然后再进行格式化。)

[leokadia@hadoop102 hadoop-3.1.3]$

hdfs namenode -format

相当于将整个记账本清空,重新开始记录

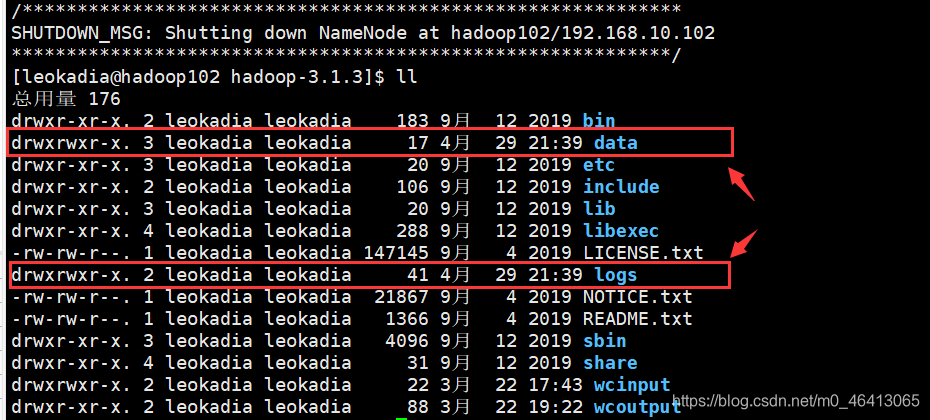

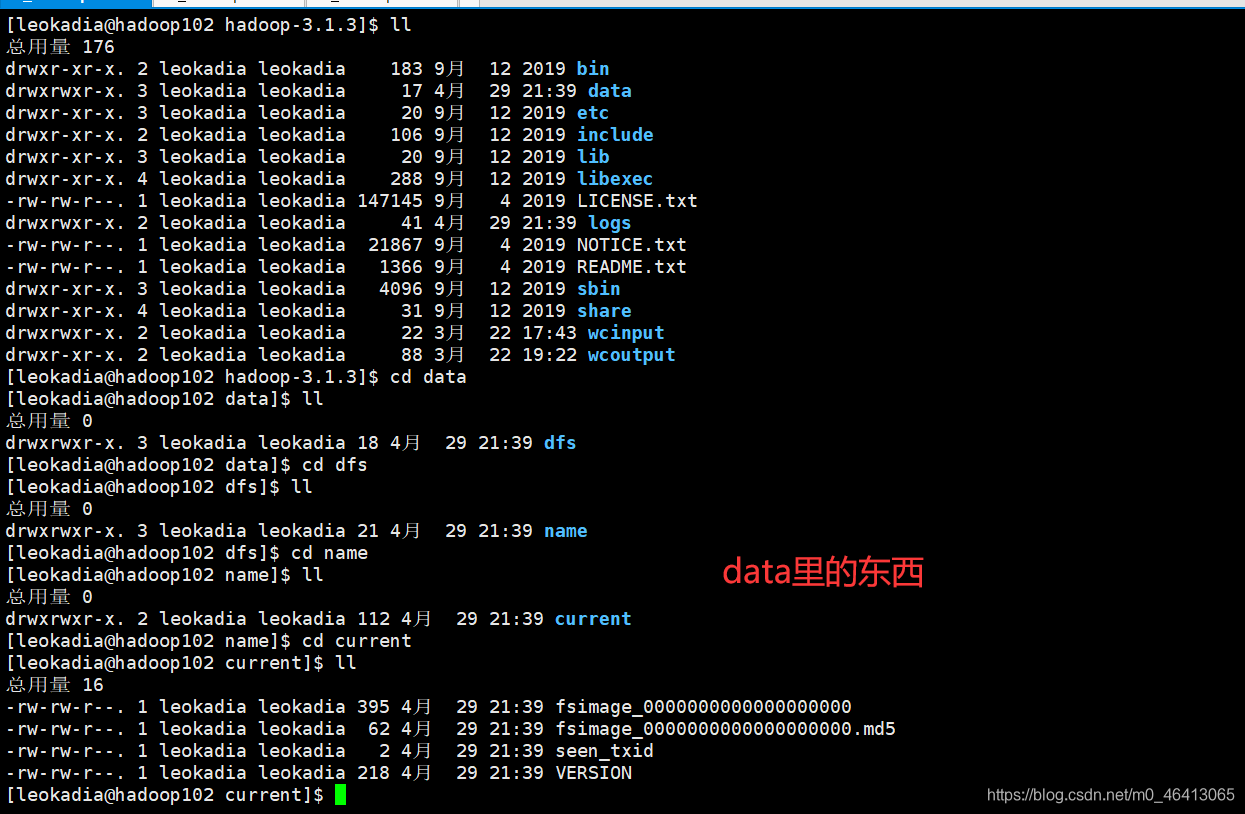

初始化完毕后,源路径就多了两个路径data合logs

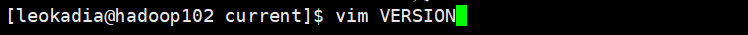

其中VERSION里面的东西

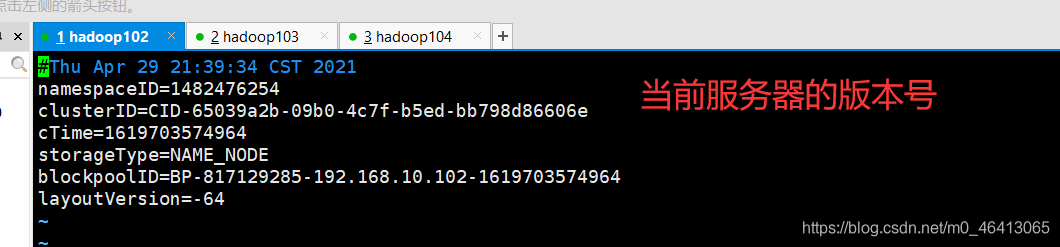

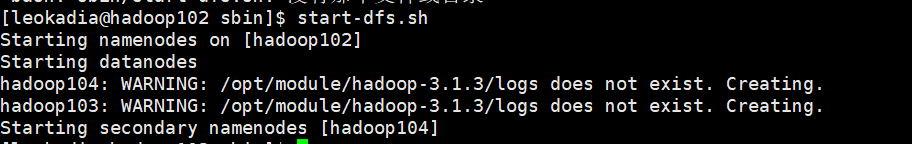

(2)启动 HDFS

[leokadia@hadoop102 hadoop-3.1.3]$

sbin/start-dfs.sh

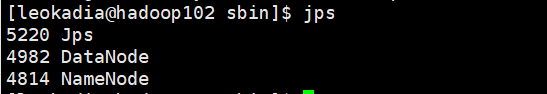

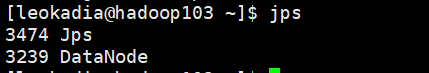

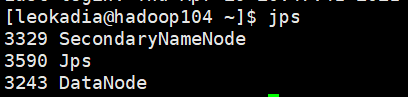

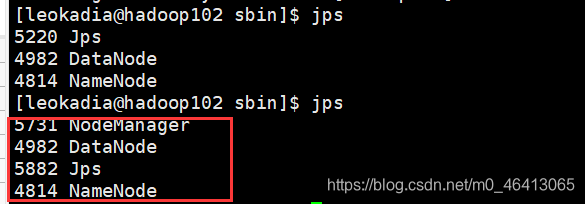

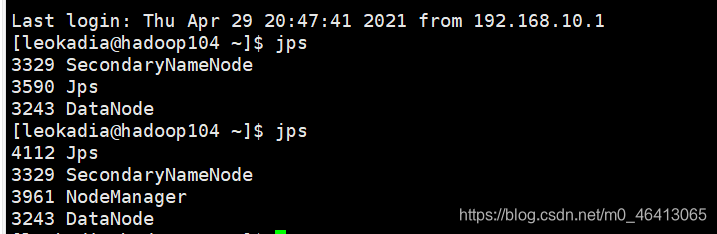

用jps查看102,103,104

跟之前的集群部署规划一致!

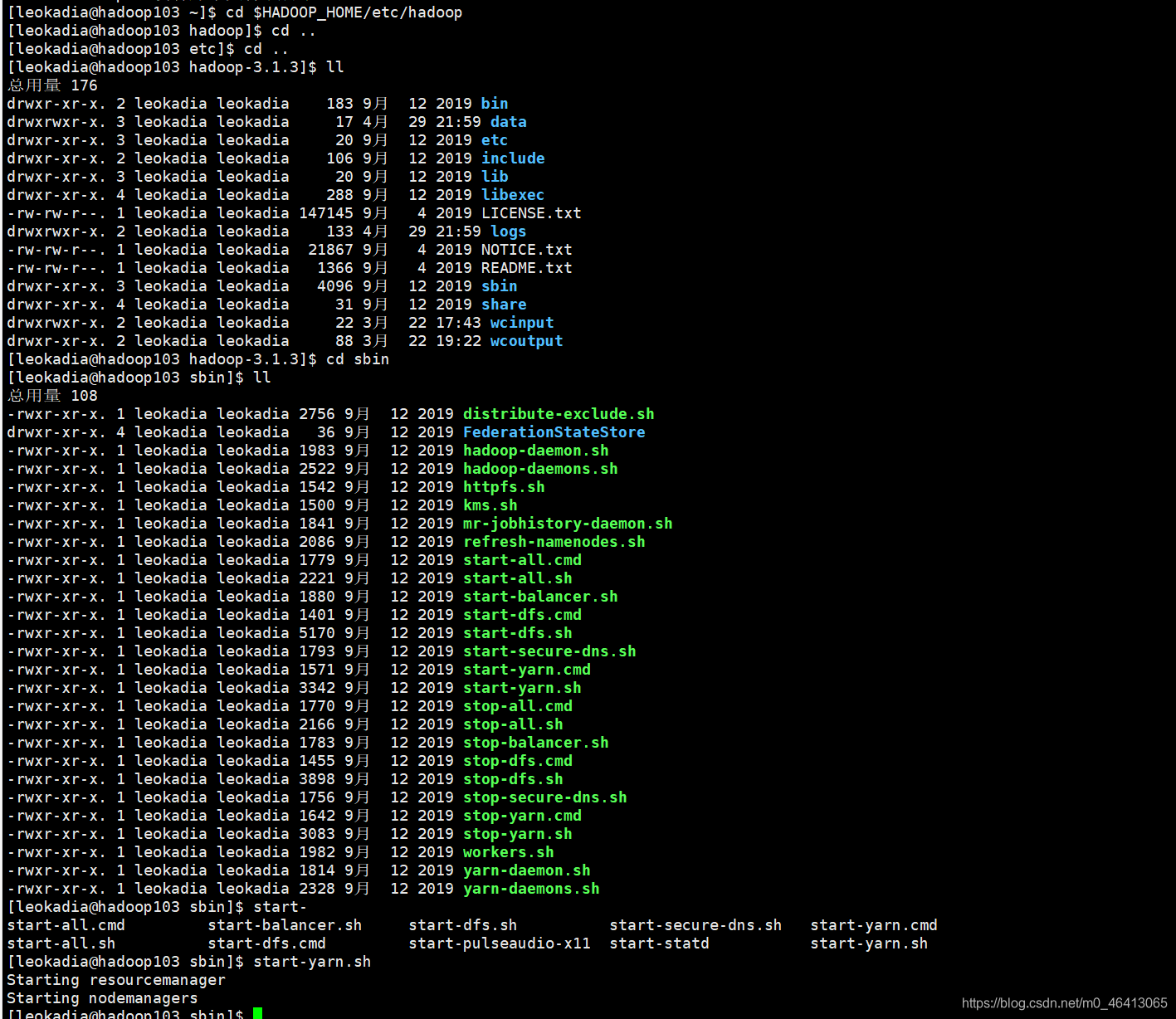

(3) 在配置了 ResourceManager 的节点 (hadoop103 )启动 YARN

[leokadia@hadoop103 hadoop-3.1.3]$

sbin/start-yarn.sh

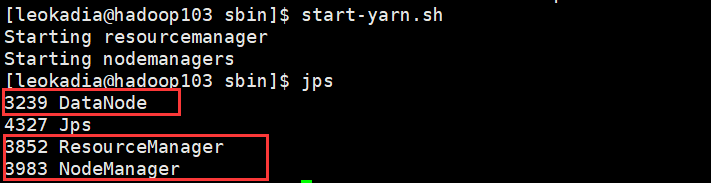

用jps查看102,103,104

跟之前的集群部署规划一致!

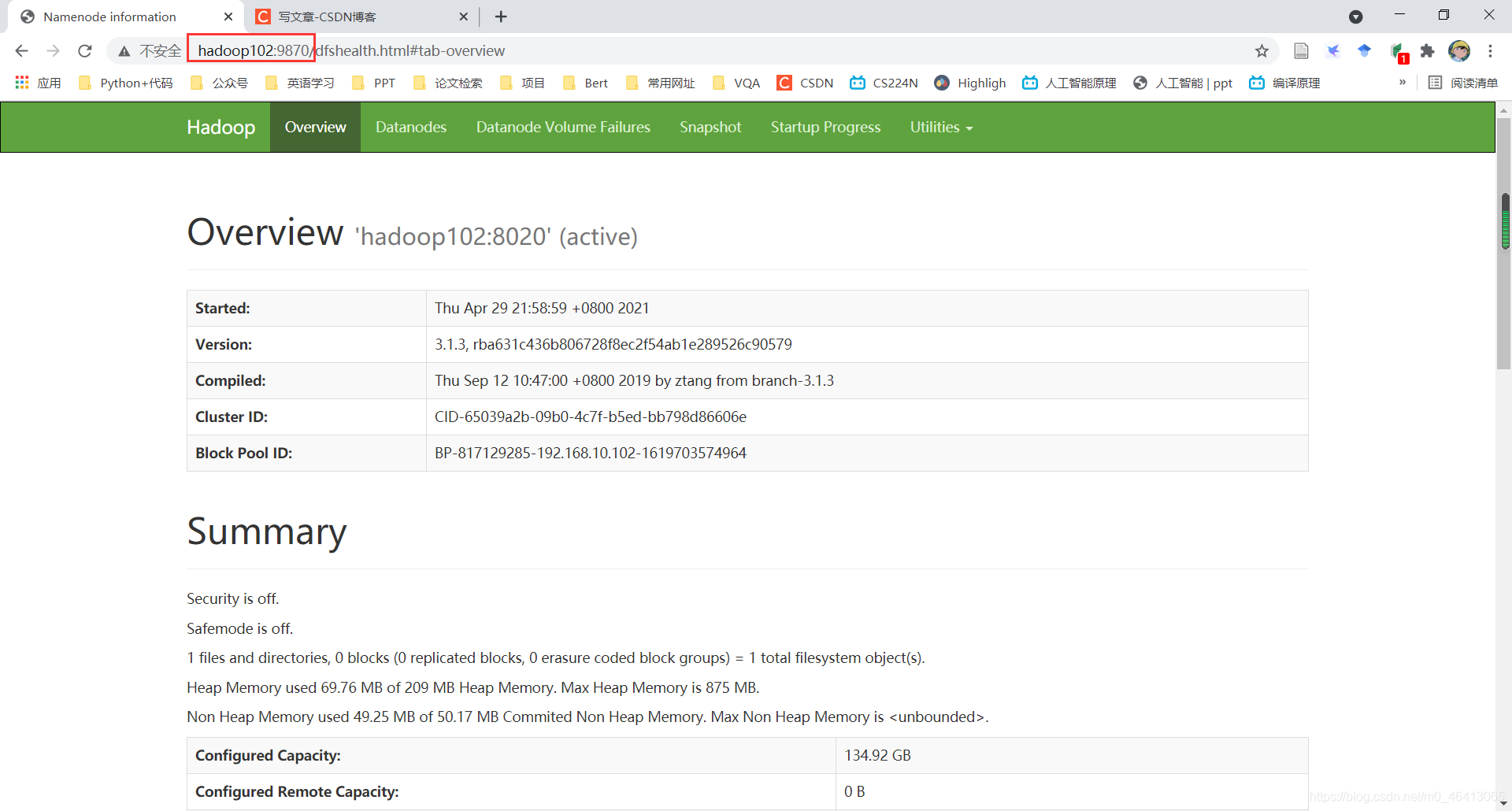

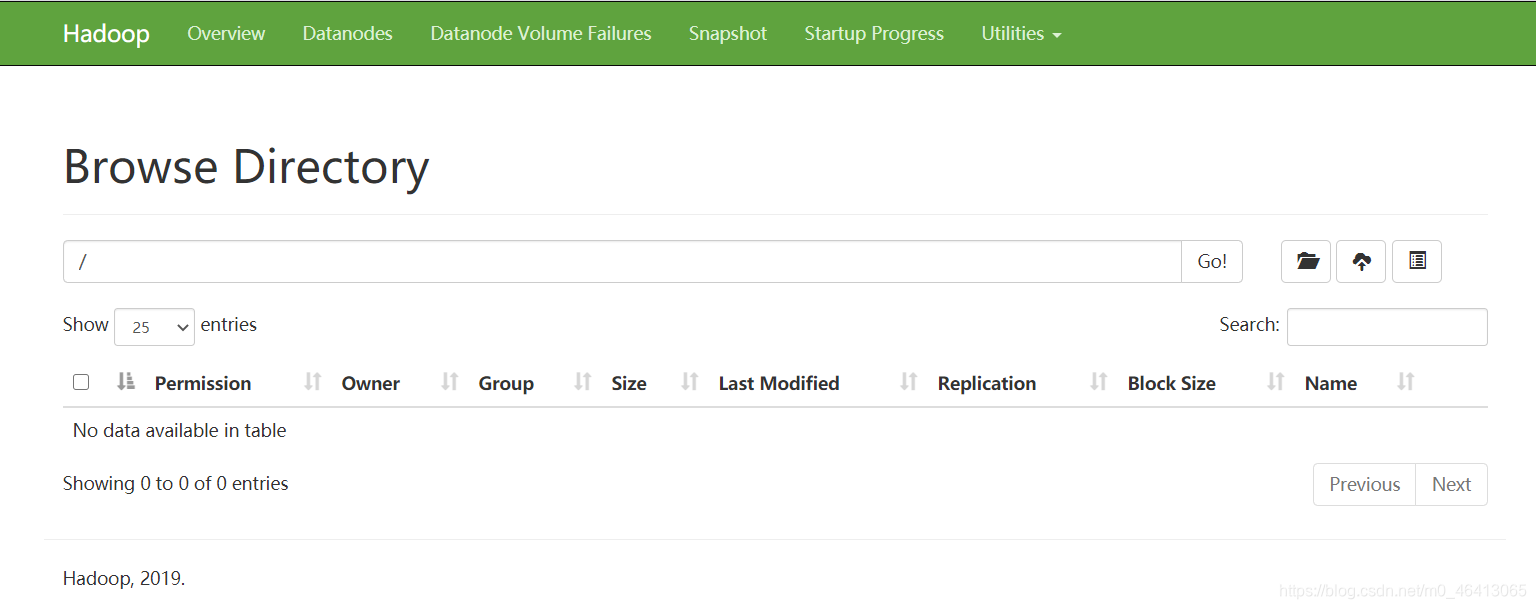

(4)Web 端查看 HDFS 的 NameNode

(a)浏览器中输入:http://hadoop102:9870

(b)查看 HDFS 上存储的数据信息

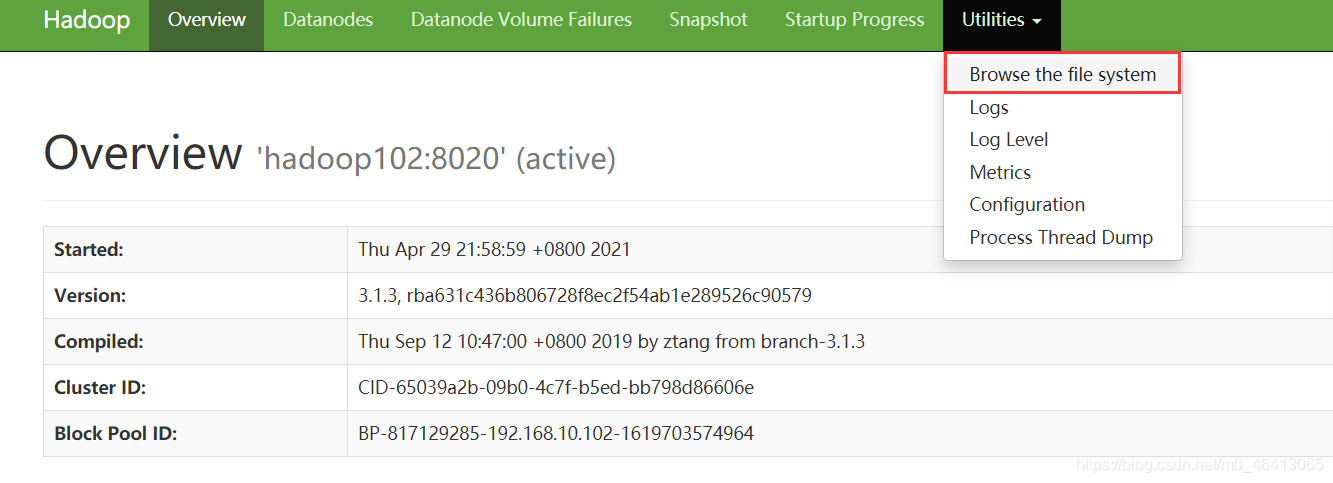

此外HDFS还给我们准备了一个HDFS web页面

输入hadoop102:9870

其中用的最多的是:

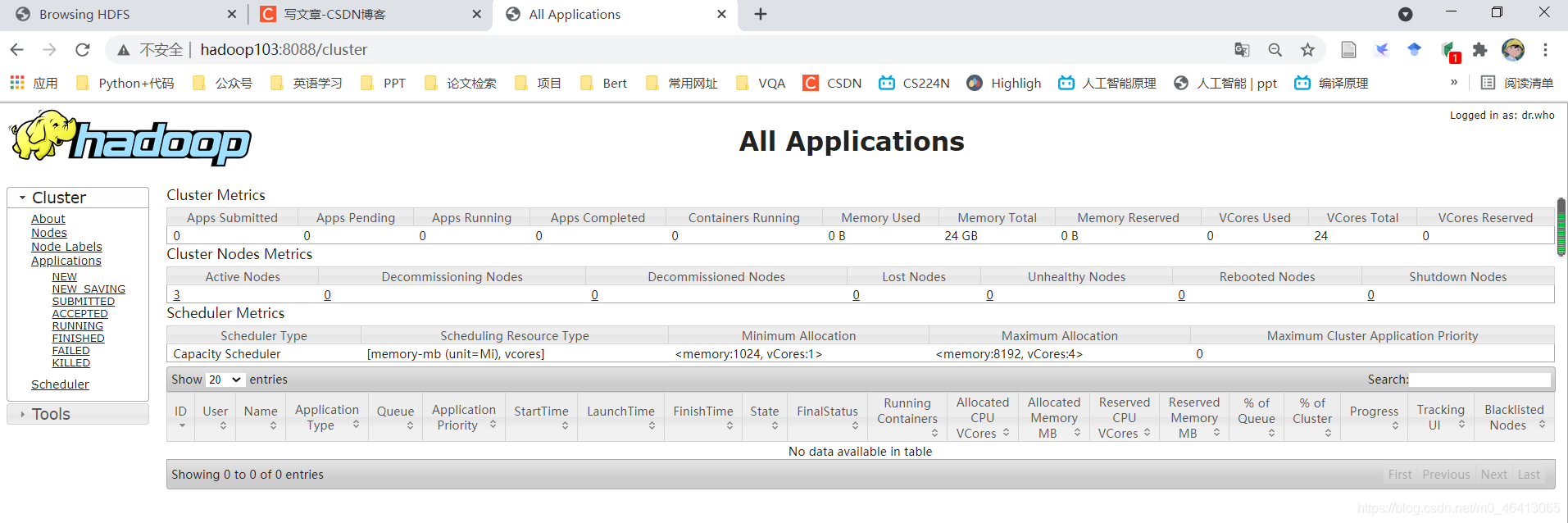

(5)Web 端查看 YARN 的 ResourceManager

(a)浏览器中输入:

http://hadoop103:8088

(b)查看 YARN 上运行的 Job 信息

3 ) 集群基本测试

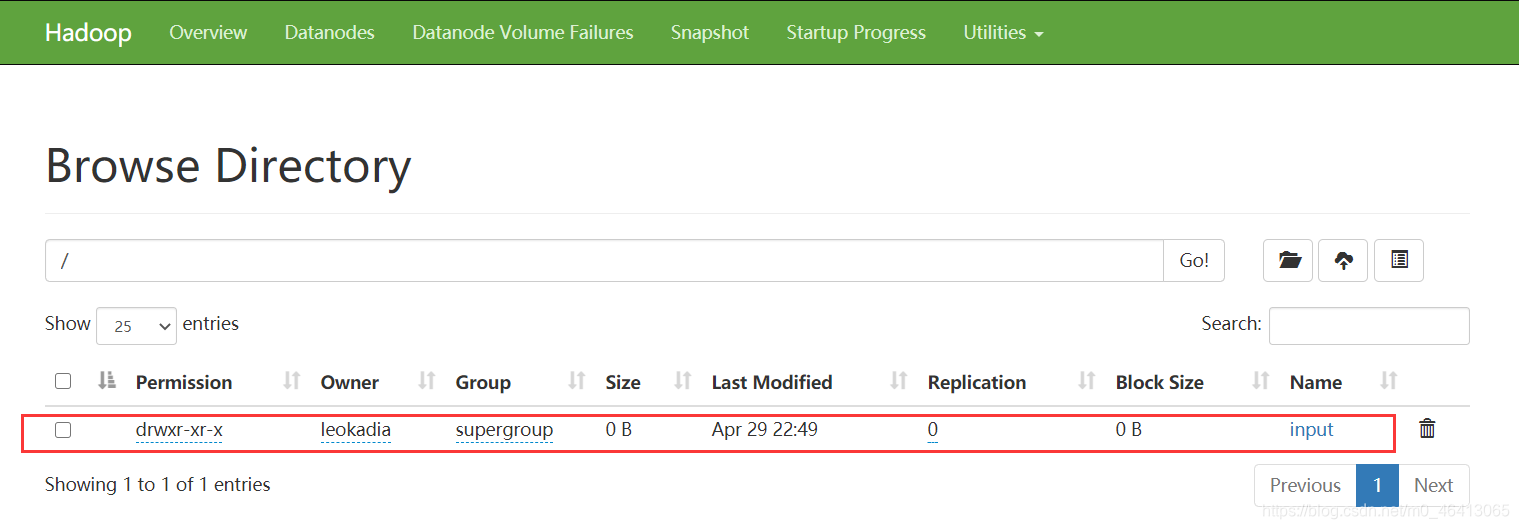

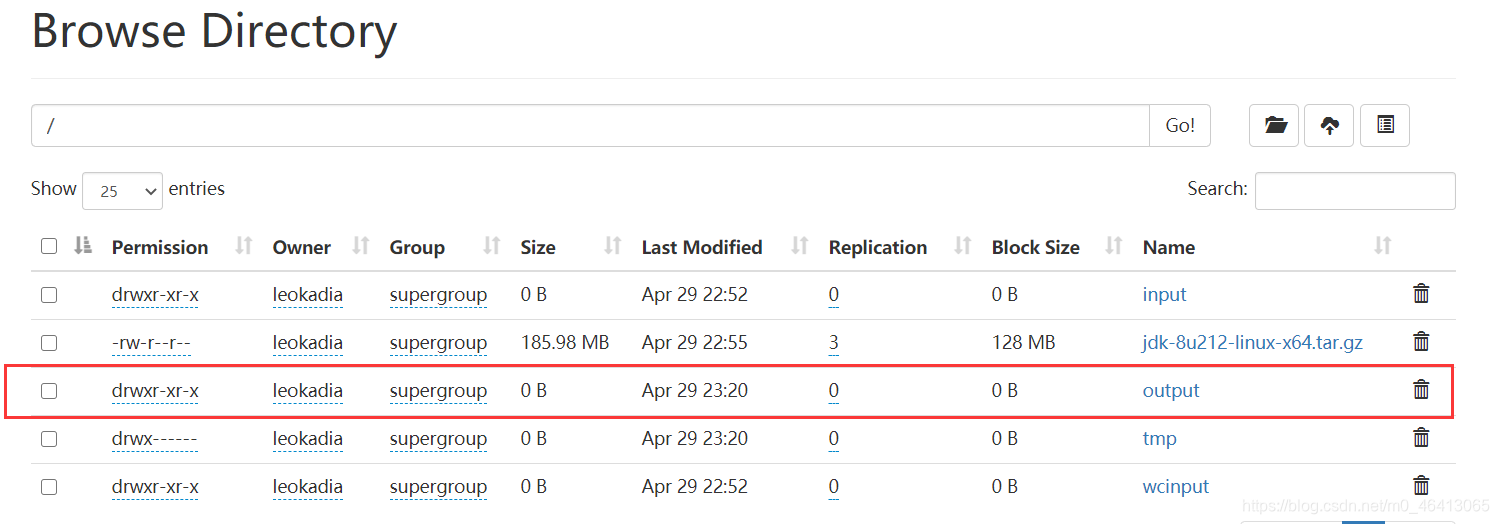

(1)上传文件到集群

➢ 上传小文件

[leokadia@hadoop102 ~]$

hadoop fs -mkdir /input

执行完后,HDFS网页种多了个文件

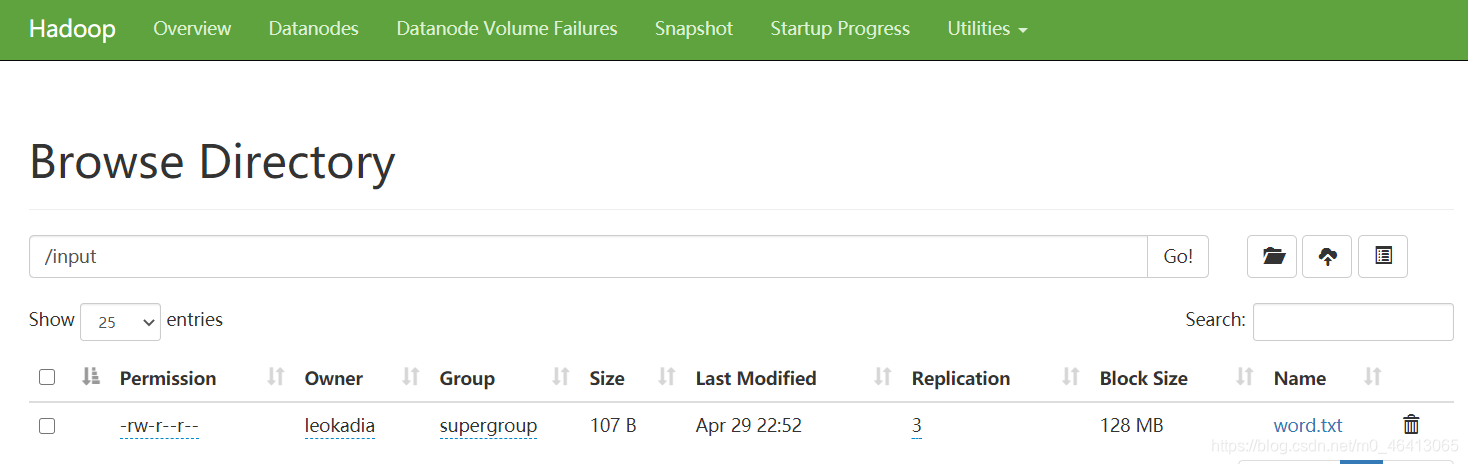

➢ 传递一个本地文件

[leokadia@hadoop102 ~]$

hadoop fs -put $HADOOP_HOME/wcinput/word.txt /input

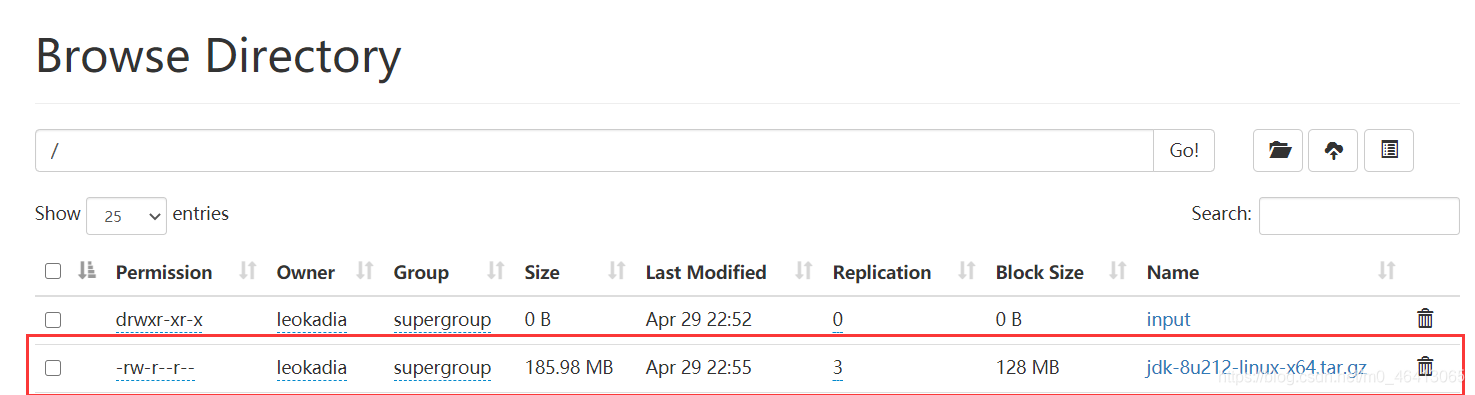

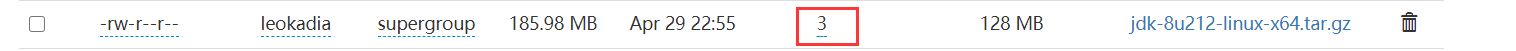

➢ 上传大文件

[leokadia@hadoop102 ~]$

hadoop fs -put /opt/software/jdk-8u212-linux-x64.tar.gz /

这里面实际只存储了一个链接,实际存储的数据在datanode节点

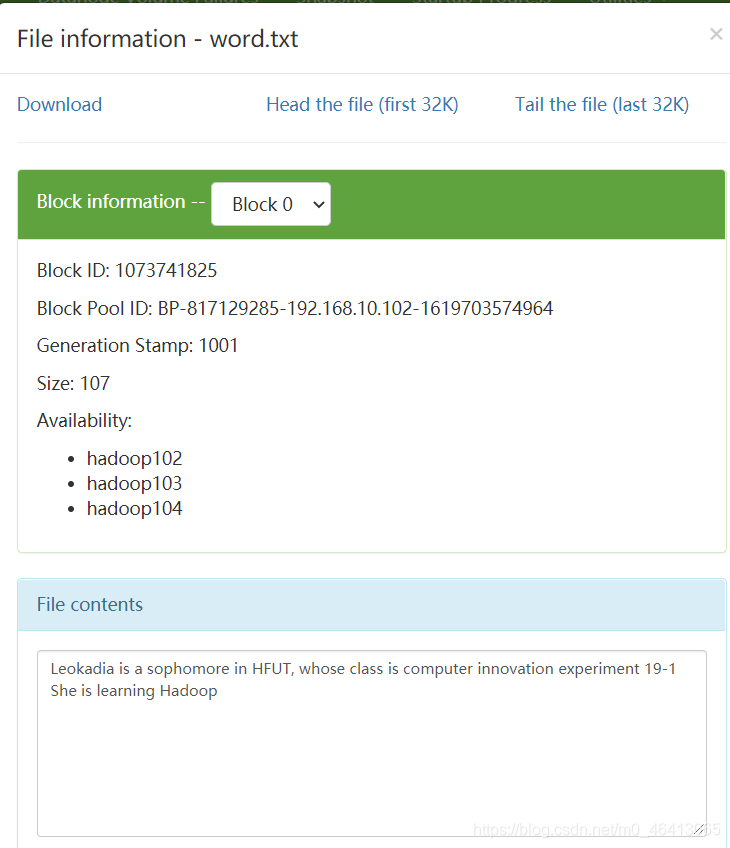

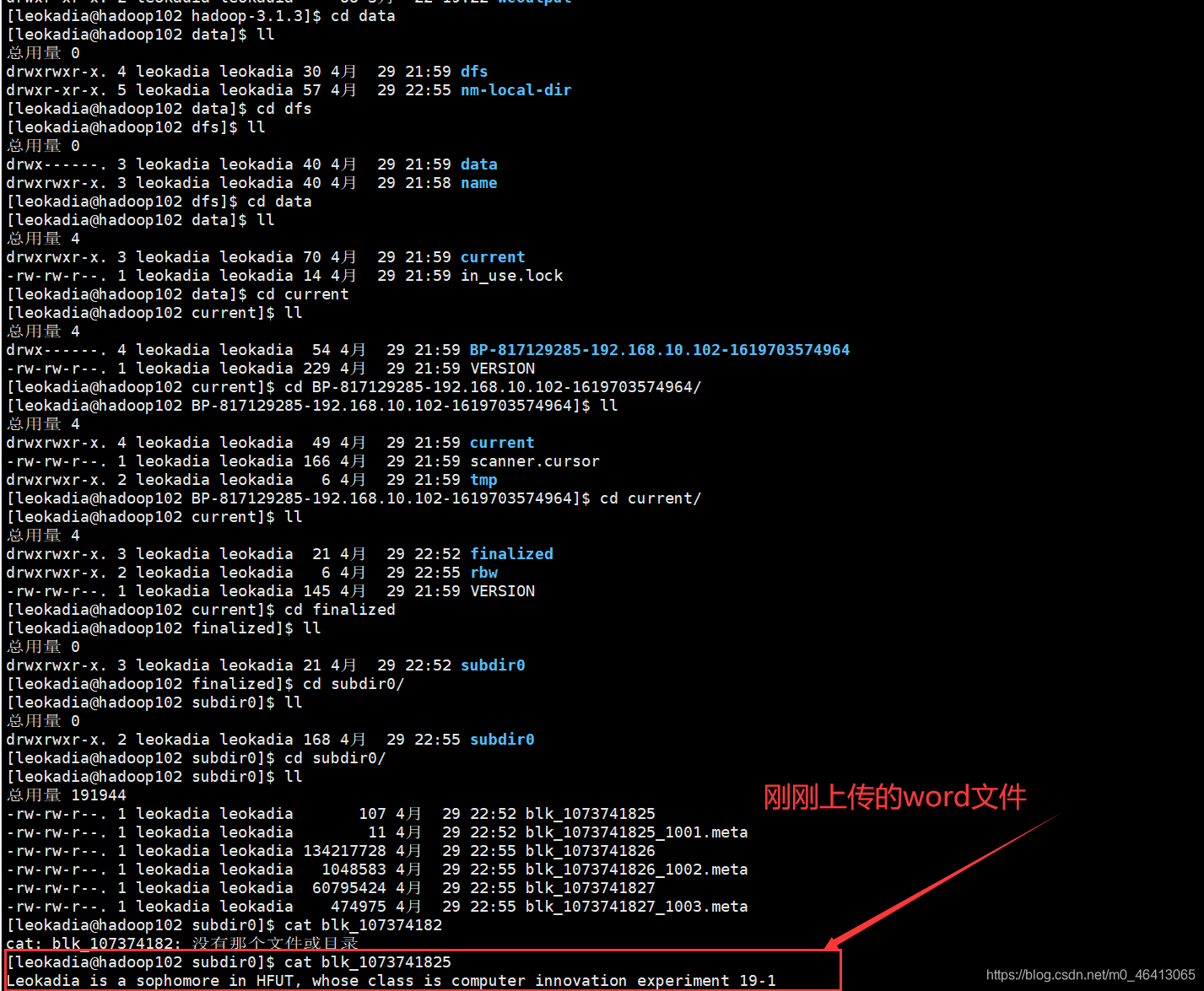

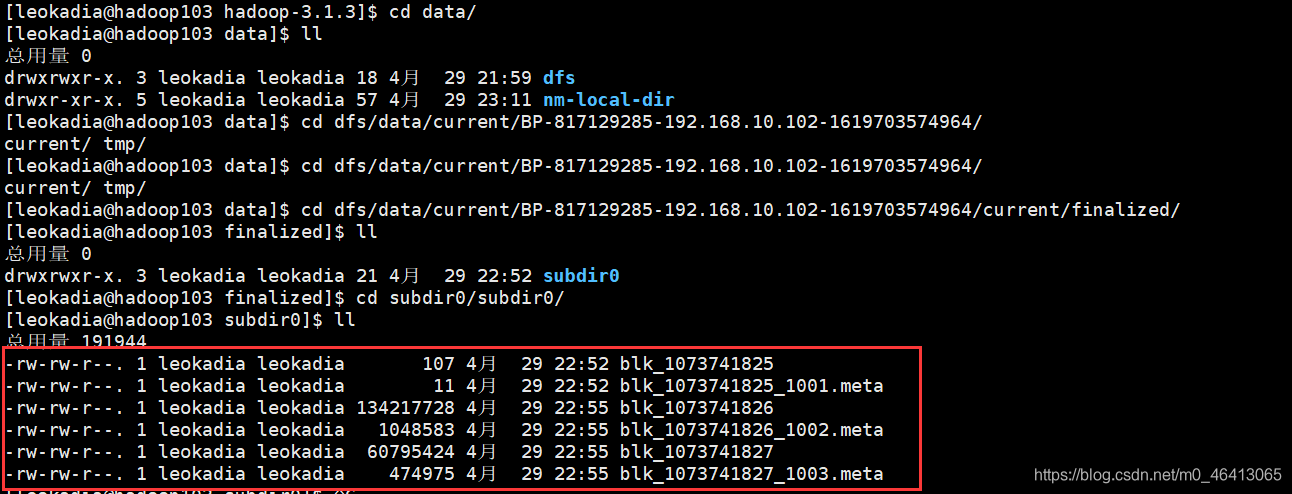

(2)上传文件后查看文件存放在什么位置

➢ 查看 HDFS 文件存储路径

[leokadia@hadoop102 subdir0]$

pwd /opt/module/hadoop-3.1.3/data/dfs/data/current/BP-1436128598-192.168.10.102-1610603650062/current/finalized/subdir0/subdir0

➢ 查看 HDFS 在磁盘存储文件内容

[leokadia@hadoop102 subdir0]$

cat blk_1073741825

Leokadia is a sophomore in HFUT, whose class is computer innovation experiment 19-1

She is learning Hadoop

(3)拼接

-rw-rw-r--.1 leokadia leokadia 1074月 2922:52 blk_1073741825

-rw-rw-r--.1 leokadia leokadia 114月 2922:52 blk_1073741825_1001.meta

-rw-rw-r--.1 leokadia leokadia 1342177284月 2922:55 blk_1073741826

-rw-rw-r--.1 leokadia leokadia 10485834月 2922:55 blk_1073741826_1002.meta

-rw-rw-r--.1 leokadia leokadia 607954244月 2922:55 blk_1073741827

-rw-rw-r--.1 leokadia leokadia 4749754月 2922:55 blk_1073741827_1003.meta

[leokadia@hadoop102 subdir0]$

cat blk_1073741826>>tmp.tar.gz

查看一个文件,追加到文件后缀

[leokadia@hadoop102 subdir0]$

cat blk_1073741827>>tmp.tar.gz

[leokadia@hadoop102 subdir0]$

tar -zxvf tmp.tar.gz

解压到当前路径

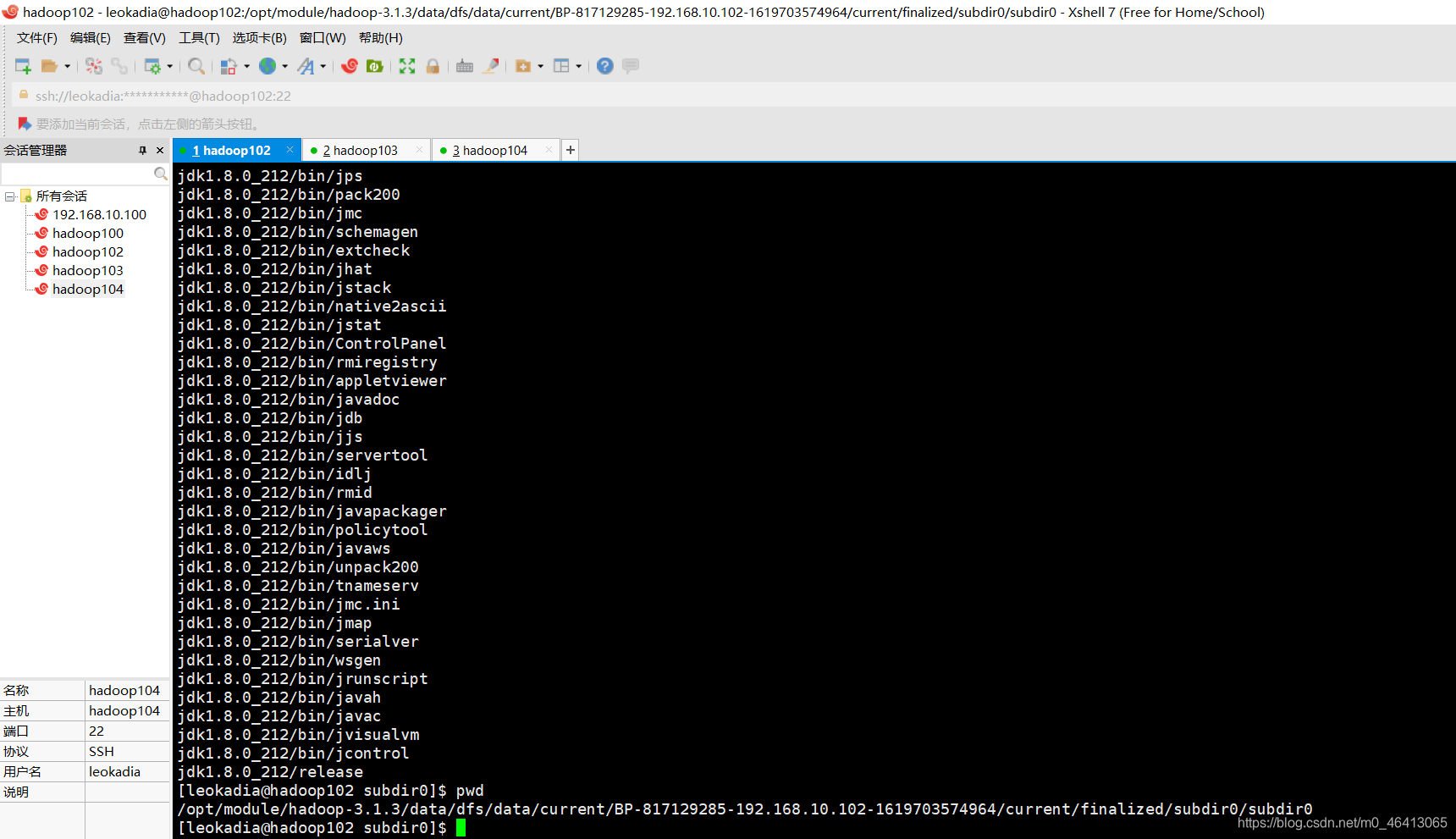

即HDFS存储的文件就在

/opt/module/hadoop-3.1.3/data/dfs/data/current/BP-817129285-192.168.10.102-1619703574964/current/finalized/subdir0/subdir0

路径上

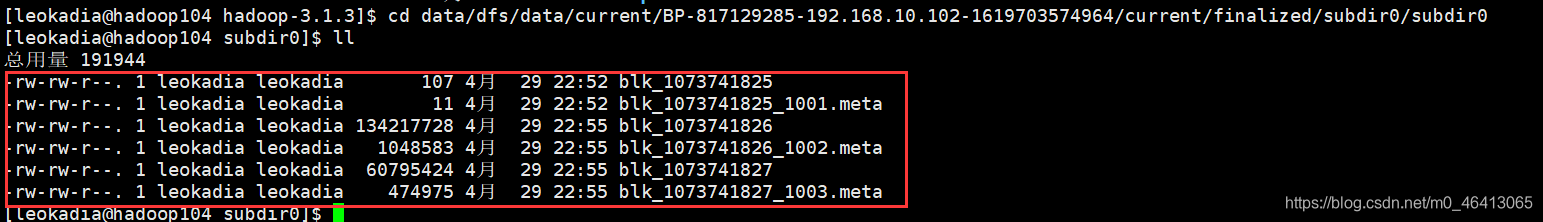

Hadoop高可用,任何一个服务器挂了还有两份副本

求证是否真的有三个副本

在hadoop103上再找一次路径,发现跟102上存储的数据一模一样

(4)下载

[leokadia@hadoop104 software]$

hadoop fs -get /jdk-8u212-linux-x64.tar.gz ./

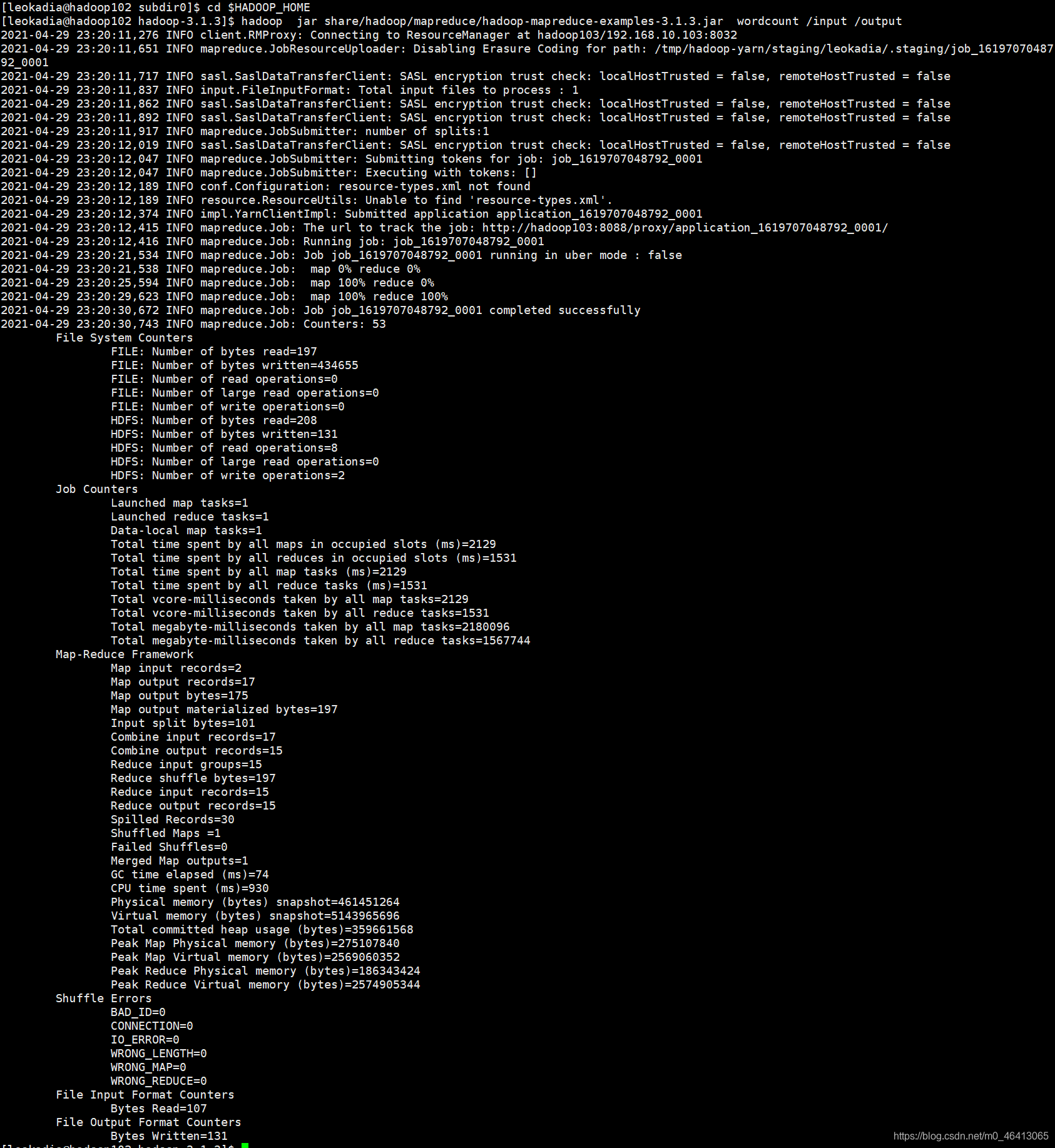

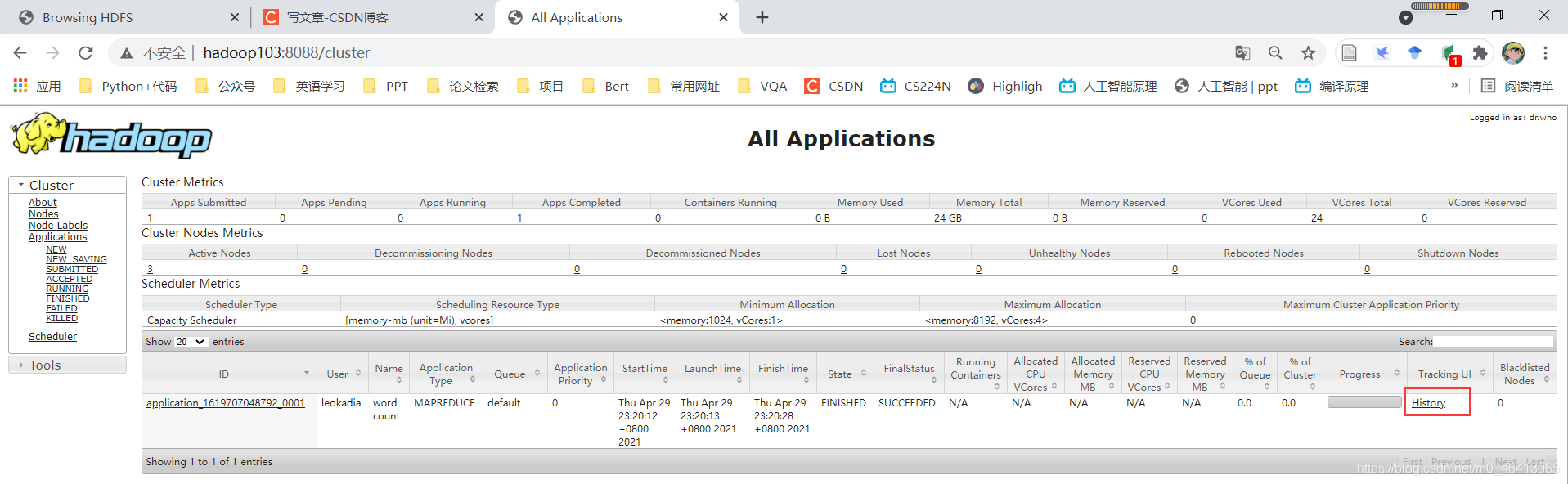

(5)执行 wordcount 程序

[leokadia@hadoop102 hadoop-3.1.3]$

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output

Web 端查看 YARN 的 ResourceManager 是这样的,我们发现有了我们刚刚的任务

同时我们注意到有个History

但是点进去无效,因此,我们需要对历史服务器进行配置,这个在后续博客中讲到。

这篇博客就讲了关于集群的配置,运行,与测试的相关内容!

创作不易,要不三连一下?

版权归原作者 程序媛小哨 所有, 如有侵权,请联系我们删除。