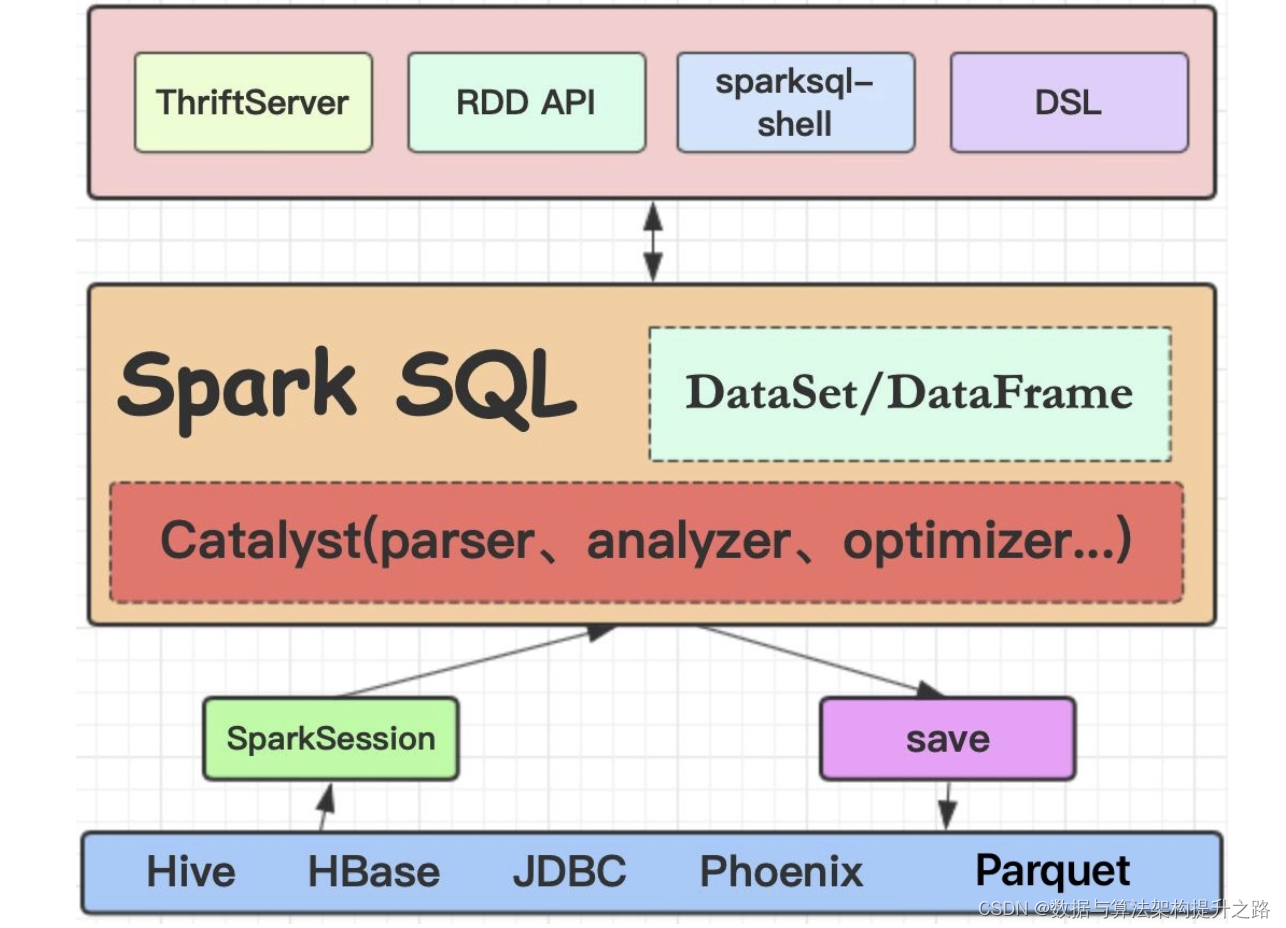

Spark SQL 是 Apache Spark 的一个模块,它提供了处理结构化和半结构化数据的能力。通过 Spark SQL,用户可以使用 SQL 语言或 DataFrame API 来执行数据查询和分析。这个模块允许开发者将 SQL 查询与 Spark 的数据处理能力结合起来,实现高效、优化的数据处理。下面是 Spark SQL 的总体工作过程:

1. 数据输入

Spark SQL 可以从各种数据源读取数据,包括但不限于:

- 文件系统(如 HDFS, S3等)

- 数据库(如 Hive, HBase, JDBC等)

- 其他数据格式(如 JSON, Parquet, ORC等)

2. DataFrame 和 Dataset

读入的数据被转换为 DataFrame 或 Dataset,这是 Spark 中用于数据操作的主要数据结构:

- DataFrame:一个分布式数据集合,类似于关系数据库中的表,但具有更丰富的优化操作。

- Dataset:是 DataFrame 的一个扩展,提供了类型安全的特性,它在 Scala 和 Java API 中可用。

3. 查询解析

当执行 SQL 查询或 DataFrame API 操作时,Spark SQL

版权归原作者 数据与算法架构提升之路 所有, 如有侵权,请联系我们删除。