下载llama3-8B模型权重

喵两句

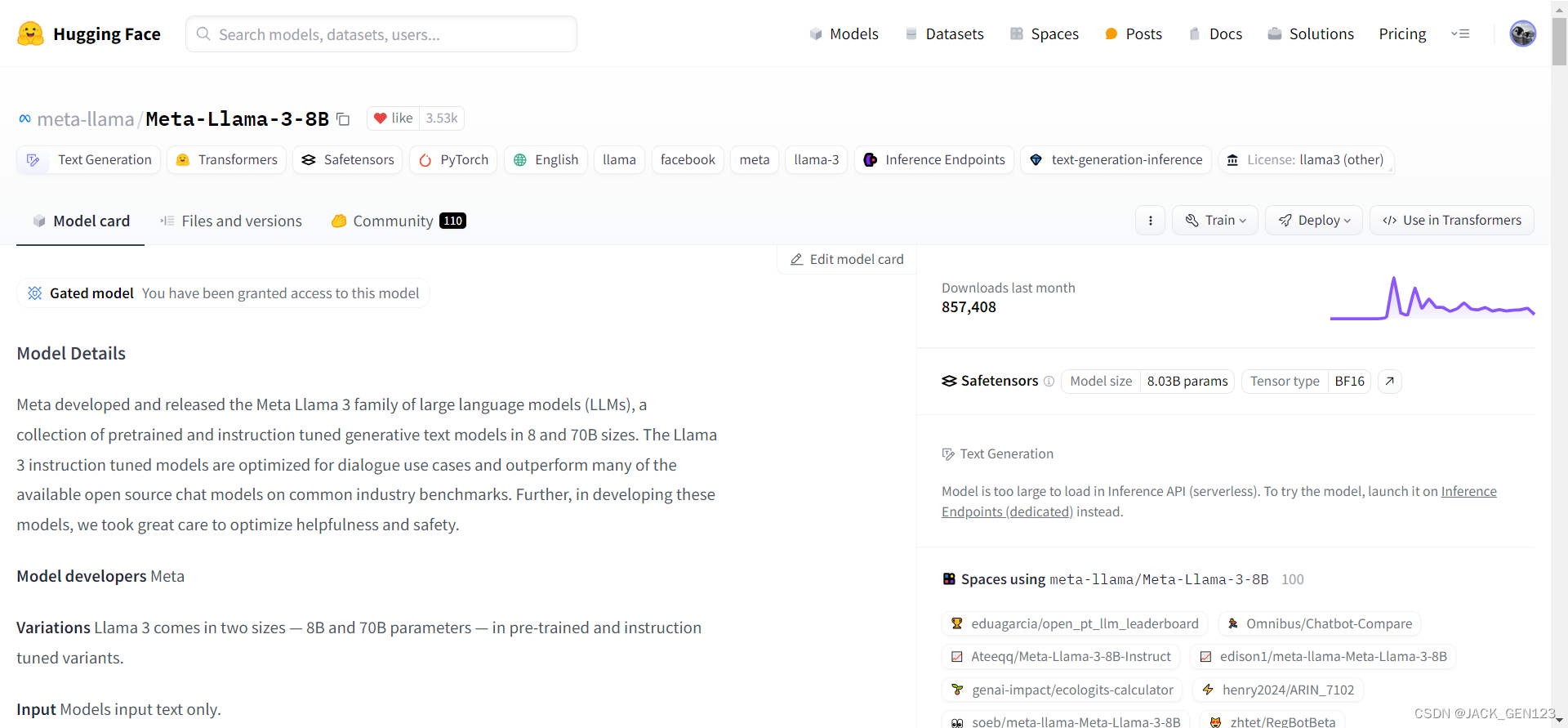

Meta公司在前不久发布了llama3开源大语言模型,今天介绍一下如何通过huggingface-cli命令行工具下载模型8B参数量的模型权重文件。

从huggingface上下载模型权重

- 登录huggingface网站,网址是https://huggingface.co/;

- 找到meta-llama/Meta-Llama-3-8B模型库,点击左上角复制按钮,复制模型仓库名称;

- 点击右上角个人头像,点击settings,页面跳转后点击左边列Access Tokens,获取你专属的连接huggingface网站的token,后面登录会用到;

- 在Linux服务器上用conda创一个python环境,并安装huggingface-cli命令行工具;

pip install --upgrade huggingface_hub - 在linux服务器上的/etc/profile(~/.bash_profile也可以,是给当前用户设置环境变量;/etc/profile是给任意linux用户设置共用的环境变量,即系统环境变量)文件中,添加hf-mirror镜像代理地址,添加完后记得source /etc/profile;

export HF_ENDPOINT=https://hf-mirror.com - 在linux服务器下命令,登录huggingface网站;

huggingface-cli login --token <你刚才复制的帐号token> - 使用命令行下载模型权重;

huggingface-cli download --resume-download meta-llama/Meta-Llama-3-8B --include "original/*" --local-dir /data/jack/Meta-Llama-3-8B --cache-dir /data/jack/.cache参数解释: –resume-download 一定要带上,防止链路断开后重新下载,浪费你的时间 –include llama-8B只需要下载original文件夹里的三个文件 –local-dir 你的模型权重存储的路径 –cache-dir 如果linux服务器的.cache空间不太够,最好指定一下缓存文件夹路径 - 等待模型下载完毕,就可以愉快的进行测试了;

- 如果本文点赞超过1,下期更新如何测试llama3模型,并介绍llama3和llama3-instruct模型之间的区别。

本文转载自: https://blog.csdn.net/JACK_GEN123/article/details/138663474

版权归原作者 JACK_GEN123 所有, 如有侵权,请联系我们删除。

版权归原作者 JACK_GEN123 所有, 如有侵权,请联系我们删除。