点击上方“Deephub Imba”,关注公众号,好文章不错过 !

**

**

来自谷歌的研究员在一篇题为“Everyone wants to do the model work, not the data work”的论文中指出:数据质量在AI中起到的作用正在被低估,数据质量在高风险AI应用中十分重要,尤其是对癌症检测、野生生物偷猎等下游任务中巨大。

数据是机器学习 (ML) 的一个基本方面,可以影响 ML 系统的性能、公平性、稳健性和可扩展性。矛盾的是,虽然构建 ML 模型的优先级通常很高,但与数据本身相关的工作通常是优先级最低的方面。并且这项数据工作可能需要多个角色(例如数据收集者、标注人员和 ML 开发人员),并且通常涉及多个团队(例如数据库、法律或许可团队)来支持数据基础架构,这会增加任何与数据相关的项目的复杂性.因此,人机交互 (HCI) 领域专注于使技术对人们有用和可用,可以帮助识别潜在问题并评估与数据相关的工作不优先时对模型的影响。

在 2021 年 ACM CHI 会议上发表的“'Everyone wants to do the model work, not the data work’: Data Cascades in High-Stakes AI”中,我们研究并验证了随着时间的推移导致技术债务的数据问题对下游的影响(定义为“数据级联”)。具体来说,我们通过全球 ML 从业者在重要 ML 领域的数据工作来说明数据级联现象,例如癌症检测、滑坡检测、贷款分配等——ML 系统在这些领域取得了进展,但也在那里有机会通过解决数据级联来改进。这项工作是我们所知道的第一个将 ML 中的数据级联应用于实际项目的形式化、测量和讨论。

我们观察到数据级联的起源通常是在机器学习系统生命周期的早期,即数据定义和收集阶段。级联在诊断和表现方面也往往是复杂和不透明的,因此通常没有明确的迹象、工具或指标来检测和衡量其影响。因此,与数据相关的小问题可能会演变成更大、更复杂的挑战,从而影响模型的开发和部署方式。来自数据级联的挑战包括需要在开发过程的后期执行代价高昂的系统级更改,或者由于数据问题导致模型错误预测而导致用户信任度下降。尽管如此,令人鼓舞的是,我们还观察到可以通过对 ML 开发的早期干预来避免这种数据级联。

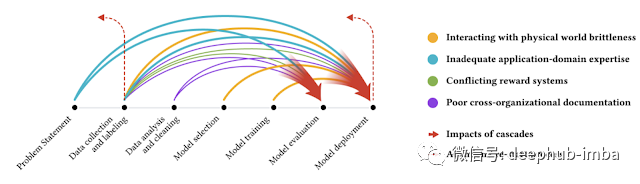

上图为高风险AI中的数据库级联。级联是不透明的,而且会产生长时间的负面影响。级联在上游触发(例如,数据收集),并且对下游产生影响(例如,模型部署)。红色粗箭头表示数据级联开始变得可见之后的复合效果;红色虚线箭头表示ML数据处理的放弃或重新开始。指标在模型评估、系统指标以及故障或用户反馈中最为明显。

数据级联示例

数据级联的最常见原因之一是在无噪声数据集上训练的模型部署在噪声嘈杂的现实世界中。例如,一种常见类型的数据级联源自模型漂移,当目标变量和自变量偏离时会发生这种情况,从而导致模型精度较低。当模型与新的数字环境(包括高风险领域,如空气质量传感、海洋传感和超声波扫描)密切交互时,漂移更为常见,因为这种情况下一般回包含训练时不存在的数据或者出现未处理的异常数据等。这种漂移会导致更多因素进一步降低模型的性能(例如,与硬件、环境和人类知识相关)。在训练时为了确保良好的模型性能,通常在受控的内部环境中收集数据。但在资源受限的真实环境的实时系统中,更常见的是收集带有指纹、阴影、灰尘、不同亮度和笔标记等的数据,这些都是影响模型性能的噪声。在其他情况下,雨和风等环境因素可能会意外移动部署中的图像传感器,这也会触发级联。正如我们采访的一位模型开发人员所报告的那样,即使是一小滴油或水也会影响可用于训练癌症预测模型的数据,从而影响模型的性能。由于漂移通常是由现实环境中的噪声引起的,因此它们也需要最长的时间(最多 2-3 年)才能显现出来,而且几乎总是在生产中。

另一种常见类型的数据级联可能发生在ML从业者管理专业知识有限的领域的数据时。例如,识别偷猎地点或在水下探索期间收集的数据,这种类型的信息依赖于生物科学、社会科学和相关领域方面的专业知识。但是我们研究中的一些开发人员描述了必须采取一系列超出他们领域专业知识的与数据相关的操作——例如,丢弃数据、更正值、合并数据或重新开始数据收集,这些都会导致数据级联,限制模型性能。依赖技术专业知识而不是领域专业知识的做法似乎引发了这些级联。

论文中提到的另外两个级联是由数据收集者、ML 开发人员和其他合作伙伴之间利益冲突造成的。例如,一个级联是由一份不规范的数据集文档引起的。虽然与数据相关的工作需要跨多个团队进行仔细协调,但当利益相关者在优先级或工作流程上不一致时,这尤其具有挑战性。

如何处理数据级联

解决数据级联需要在 ML 研究和实践中采用系统的方法,多步骤的进行:

- ML 系统开始时就要明确数据质量的概念,类似于我们对模型拟性能指标的看法。这包括开发标准化指标并经常使用这些指标来衡量数据,例如现象学中的保真度(数据表示现象的准确度和全面性)和有效性(数据对与数据捕获的现象相关的事物的解释程度),类似于我们如何开发良好的指标来衡量模型性能,例如 F1 分数。

- 建立创新激励机制以认可数据工作,例如奖励数据维护,或奖励组织中数据工作(收集、标签、清洁或维护)的员工。

- 数据工作通常需要跨多个角色和多个团队进行协调,但目前这非常有限(部分但并非全部,因为前面提到的因素)。我们的研究指出了在数据收集者、领域专家和 ML 开发人员之间促进更大的协作、透明度和更公平的利益分配的价值,尤其是对于依赖于收集或标记细分数据集的 ML 系统。

- 最后,我们在多个国家/地区的研究表明,数据稀缺性在低收入国家很明显,在这些国家,ML开发人员面临着定义和手工管理新数据集的额外问题,这使得他们很难开始开发ML系统。所以这里重要的是要开放数据库,制定数据政策,以解决全球当前的数据不平等问题。

总结

在这项工作中,我们既提供了经验证据,又将 ML 系统中数据级联的概念形式化。我们希望让人们意识到数据卓越可能带来的潜在价值。我们还希望为 HCI 引入一个尚未探索但意义重大的新研究议程。

最后这篇论文的地址如下:https://research.google/pubs/pub49953/

本文是与 Shivani Kapania、Hannah Highfill、Diana Akrong、Praveen Paritosh 和 Lora Aroyo 合作撰写的。

原文地址:https://ai.googleblog.com/2021/06/data-cascades-in-machine-learning.html