在eclipse运行MapReduce程序的常见问题

1. CentOS运行eclipse卡死,如何杀死eclipse的进程

CentOS运行eclipse卡死,如何杀死eclipse的进程

引用:https://blog.csdn.net/while0/article/details/8215353

记住杀死java程序之后,看看hdfs程序是否还在正常运行,用jps命令查看当前进程,可以看到NameNode、DataNode等才能正常运行MapReduce程序。

2. DFS连接错误(java.net.ConnectionException)

java.net.ConnectionException

主机名和端口号没配置正确

主机名和端口在 hadoop/etc/hadoop/core-site.xml 可以看到 fs.defaultFS 的值为 hdfs://主机名:端口号 。

1、这个主机名M/R Master和DFS Master一般是一样的,一般是localhost或者node几。

2、M/R的端口号不要改它,依旧是50020,DFS的端口号就是在 core-site.xml 查到的端口号。

3、User Name填你正在登录的账号即可,比如root。

这里附上Hadoop常用端口:

https://blog.csdn.net/zhao2chen3/article/details/109896760

3. 报错The import org.apache.hadoop.conf cannot be resolved

报错The import org.apache.hadoop.conf cannot be resolved(有红色波浪线)

只要是在代码import处出现报错的,都要导入相应的jar包

把MapReduce需要的jar包导进来

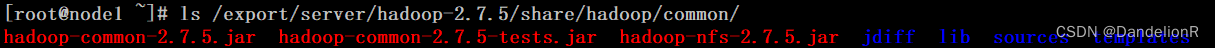

还有common的包

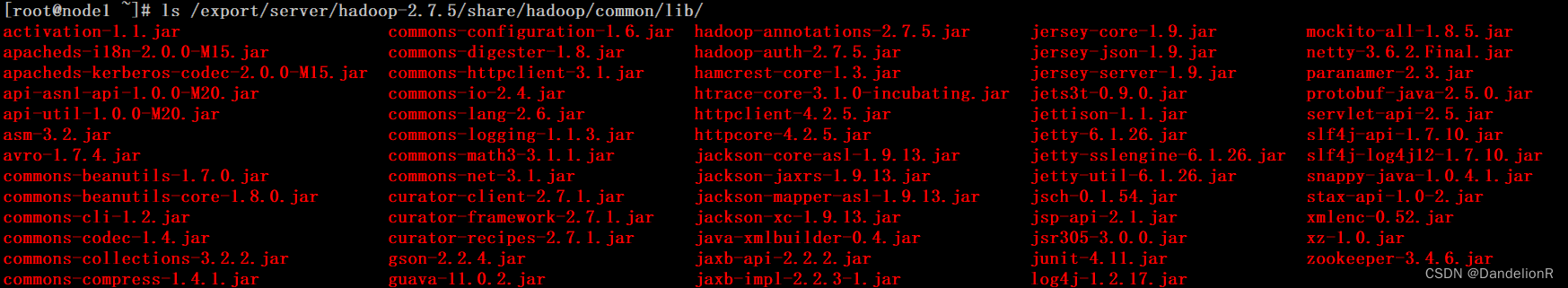

以及common中lib的jar包

还要hdfs和yarn的jar包

导入方法请参考:

https://www.crifan.com/tutorial_eclipse_add_external_jar_library/

或

https://blog.csdn.net/wdk1011/article/details/75912798

4. 报错Syntax error, parameterized types are only available if source level is 1.5 or greater

Syntax error, parameterized types are only available if source level is 1.5 or greater

原因为编译版本不匹配导致的错误。

参考:https://blog.csdn.net/chogzyo/article/details/79792119

5. The constructor Job(Configuration, String) is deprecated

Warning:The constructor Job(Configuration, String) is deprecated

参考:https://blog.csdn.net/chiclewu/article/details/40507671

6. Input path does not exist

Input path does not exist:{这里是提示你要设置的input路径}

运行代码的 input 路径要设置对,请根据提示设置你的路径。

一般情况下是在 hdfs 上的 /user/root 目录(或者 /user/hadoop )创建 input 文件夹,并把需要统计的文件放里面。

注:

1.一般来讲,这个 root 或者 hadoop 是你在 DFS location 的 user name 。

2.如果该路径下存在output文件夹的话要先删掉该文件夹

7. 其他

- 关于分布式 Hadoop 的 configure 可以根据下面代码设置: 啊,网上查一查,不提供辽

- 运行成功可以看到 successfully 等字眼。

结束 ^_^

版权归原作者 DandelionR 所有, 如有侵权,请联系我们删除。