一、kafka架构

1.1Kafka基础知识

1.1.1 Kafka介绍

Kafka是最初由Linkedin公司开发,是一个分布式、分区的、多副本的、多生产者、多订阅者,基于zookeeper协 调的分布式日志系统(也可以当做MQ系统),常见可以用于webynginx日志、访问日志,消息服务等等,Linkedin于 2010年贡献给了Apache基会并成为顶级开源项目。主要应用场景是:日志收集系统和消息系统。

Kafka主要设计目标如下:

- 以时间复杂度为O(1)的⽅式提供消息持久化能⼒,即使对TB级以上数据也能保证常数时间的访问性能。

- ⾼吞吐率。即使在⾮常廉价的商⽤机器上也能做到单机⽀持每秒100K条消息的传输。

- ⽀持Kafka Server间的消息分区,及分布式消费,同时保证每个partition内的消息顺序传输。

- 同时⽀持离线数据处理和实时数据处理。

- ⽀持在线⽔平扩展

kafka是一种发布-订阅模式, 对于消息中间件,消息分推拉两种模式。Kafka只有消息的拉取,没有推送,可以通过轮询实现消息的推送。

1.Kafka在一个或多个可以跨越多个数据中心的服务器上作为集群运行。

2.Kafka集群中按照主题分类管理,一个主题可以有多个分区,一个分区可以有多个副本分区。

3.每个记录由一个键,一个值和一个时间戳组成。

Kafka具有四个核心API:

1.ProducerAPI:允许应用程序将记录流发布到一个或多个Kafka主题。

2.ConsumerAPI:允许应用程序订阅一个或多个主题并处理为其生成的记录流。

3.StreamsAPI:允许应用程序充当流处理器,使用一个或多个主题的输入流,并生成一个或多个输出主题的输出流,从而有效地将输入流转换为输出流。

4.ConnectorAPI:允许构建和运行将Kafka主题连接到现有应用程序或数据系统的可重用生产者或使用者。例如,关系数据库的连接器可能会捕获对表的所有更改。

1.1.2 Kafka优势

- 高吞吐量:单机每秒处理几十上百万的消息量。即使存储了许多TB的消息,它也保持稳定的性能。

- 高性能:单节点支持上千个客户端,并保证零停机和零数据丢失。

- 持久化数据存储:将消息持久化到磁盘。通过将数据持久化到硬盘以及replication防止数据丢失。

- 分布式系统,无需停机就可扩展机器。

- 可靠性-kafka是分布式,分区,复制和容错的。

- 客户端状态维护:消息被处理的状态是在Consumer端维护,而不是由server端维护。当失败时能自动平衡。

- 支持online和offline的场景。

- 支持多种客户端语言。Kafka支持Java、.NET、PHP、Python等多种语言。

1.1.3 Kafka应用场景

- 日志收集一个公司可以用Kafka可以收集各种服务的Log,通过Kafka以统一接口服务的方式开放给各种Consumer。

- 消息系统解耦生产者和消费者、缓存消息等。

- 用户活动跟踪用来记录web用户或者APP用户的各种活动,如网页搜索、搜索、点击,用户数据收集然后进行用户行为分析。

- 运营指标Kafka也经常用来记录运营监控数据。包括收集各种分布式应用的数据,生产各种操作的集中反馈,比如报警和报告;

- 流式处理比如Spark Streaming和Storm。

1.1.4 Kafka核心概念

消息和批次

Kafka的数据单元称为消息。可以把消息看成是数据库里的一个“数据行”或一条“记录”,消息由字节数组组成。

消息有键,键也是⼀个字节数组。当消息以⼀种可控的⽅式写⼊不同的分区时,会⽤到键。

为了提⾼效率,消息被分批写⼊Kafka。批次就是⼀组消息,这些消息属于同⼀个主题和分区。

把消息分成批次可以减少⽹络开销。批次越⼤,单位时间内处理的消息就越多,单个消息的传输时间就越⻓。批次数据会被压缩,这样可以提升数据的传输和存储能⼒,但是需要更多的计算处理

模式

消息模式(schema)有许多可用的选项,以便于理解。如JSON和XML,但是它们缺乏强类型处理能力。Kafka的

许多开发者喜欢使用Apache Avro。Avro提供了一种紧凑的序列化格式,模式和消息体分开。当模式发生变化时,不需要重新生成代码,它还支持强类型和模式进化,其版本既向前兼容,也向后兼容。

topic

每条发布到Kafka集群的消息都有⼀个类别,这个类别被称为Topic。

物理上不同Topic的消息分开存储。

主题就好⽐数据库的表,尤其是分库分表之后的逻辑表。

主题可以被分为若干分区,一个主题通过分区分布于Kafka集群中,提供了横向扩展的能力。

Partition

- 主题可以被分为若干个分区,一个分区就是一个提交日志。

- 消息以追加的方式写入分区,然后以先入先出的顺序读取。

- 无法在整个主题范围内保证消息的顺序,但可以保证消息在单个分区内的顺序。

- Kafka 通过分区来实现数据冗余和伸缩性。

- 在需要严格保证消息的消费顺序的场景下,需要将partition数目设为1。

- 一个主题的不同partition,可以在一个broker上

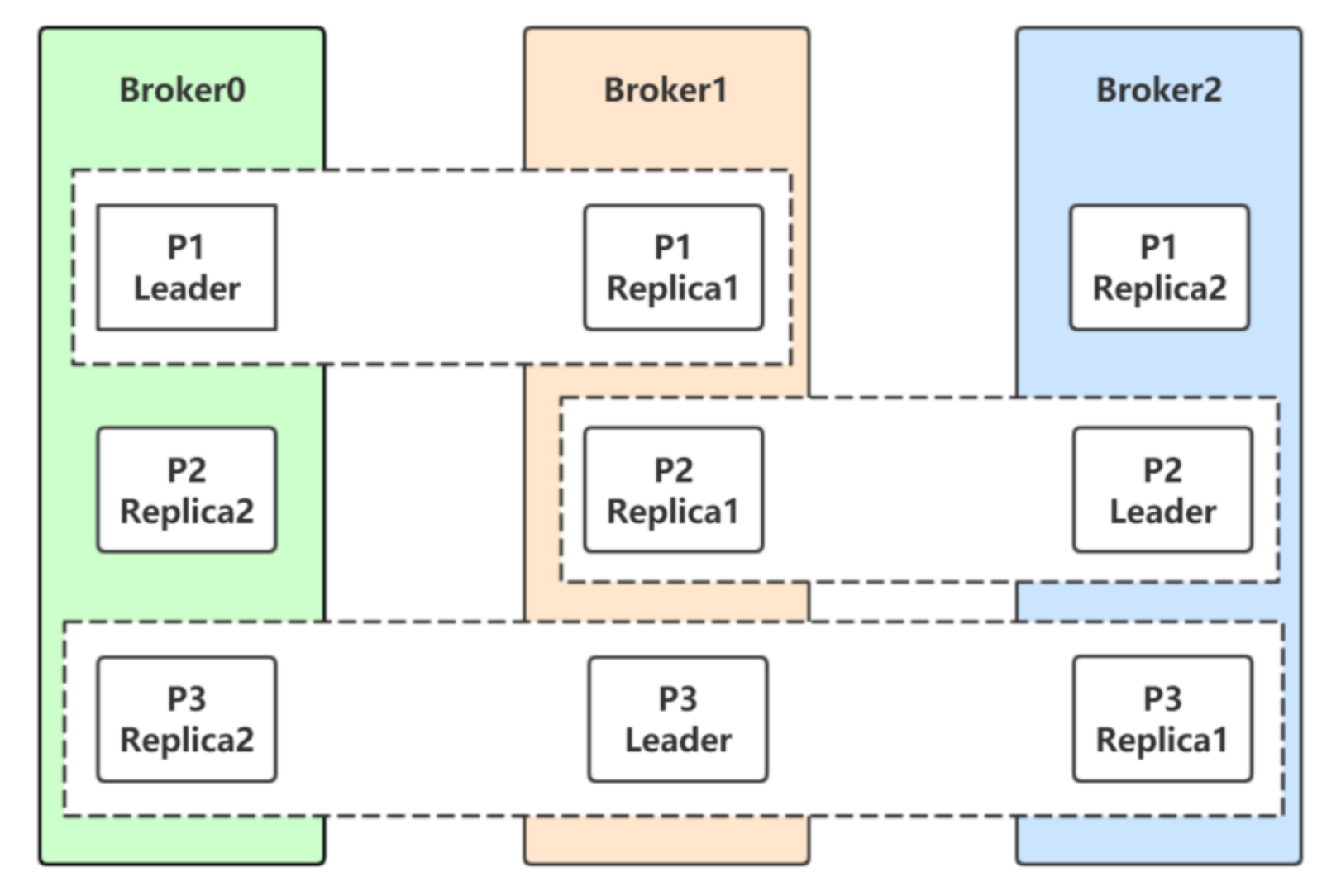

Replicas

Kafka 使⽤主题来组织数据,每个主题被分为若⼲个分区,每个分区有多个副本。那些副本被保存在broker 上,每个broker 可以保存成百上千个属于不同主题和分区的副本。

同一个分区的副本分布在不同的broker上,所以副本数不能超过broker数

副本有以下两种类型:

- ⾸领副本每个分区都有⼀个⾸领副本。为了保证⼀致性,所有⽣产者请求和消费者请求都会经过这个副本。

- 跟随者副本⾸领以外的副本都是跟随者副本。跟随者副本不处理来⾃客户端的请求,它们唯⼀的任务就是从⾸领那⾥复制消息,保持与⾸领⼀致的状态。如果⾸领发⽣崩溃,其中的⼀个跟随者会被提升为新⾸领。跟随者副本包括同步副本和不同步副本,在发⽣⾸领副本切换的时候,只有同步副本可以切换为⾸领副本。

Broker和集群

一个独立的Kafka 服务器被称为broker,是集群的组成部分。

broker接收来自生产者的消息,为消息设置偏移量,并提交消息到磁盘保存

broker 为消费者提供服务,对读取分区的请求作出响应,返回已经提交到磁盘上的消息。

单个broker可以轻松处理数千个分区以及每秒百万级的消息量。

broker 是集群的组成部分。每个集群都有⼀个broker 同时充当了集群控制器的⻆⾊(⾃动从集群的活跃成员中选举出来)。

如果某topic有N个partition,集群有N个broker,那么每个broker存储该topic的⼀个partition。

如果某topic有N个partition,集群有(N+M)个broker,那么其中有N个broker存储该topic的⼀个partition,剩下的M个broker不存储该topic的partition数据。

如果某topic有N个partition,集群中broker数⽬少于N个,那么⼀个broker存储该topic的⼀个或多个partition。在实际⽣产环境中,尽量避免这种情况的发⽣,这种情况容易导致Kafka集群数据不均衡。

控制器负责管理⼯作:

- 将分区分配给broker

- 监控broker

在集群中,⼀个分区从属于⼀个broker,该broker 被称为分区的⾸领。一个分区在其他broker上可能还存在副本分区,分区的复制提供了消息冗余,⾼可⽤。副本分区不负责处理消息的读写。

Producer

生产者创建消息。

该⻆⾊将消息发布到Kafka的topic中。broker接收到⽣产者发送的消息后,将该消息追加到当前⽤于追加数据的 segment ⽂件中。

⼀般情况下,⼀个消息会被发布到⼀个特定的主题上。

- 默认情况下通过轮询把消息均衡地分布到主题的所有分区上。

- 在某些情况下,⽣产者会把消息直接写到指定的分区。这通常是通过消息键和分区器来实现的,分区器为键⽣成⼀个散列值,并将其映射到指定的分区上。这样可以保证包含同⼀个键的消息会被写到同⼀个分区上。

- ⽣产者也可以使⽤⾃定义的分区器,根据不同的业务规则将消息映射到分区。

Consumer

消费者读取消息

- 消费者订阅⼀个或多个主题,并按照消息⽣成的顺序读取它们。

- 消费者通过检查消息的偏移量来区分已经读取过的消息。偏移量是另⼀种元数据,它是⼀个不断递增的整数值,在创建消息时,Kafka 会把它添加到消息⾥。对于某个消费组,在给定的分区⾥,每个消息的偏移量都是唯⼀的。消费者把每个分区最后读取的消息偏移量保存在Zookeeper 或Kafka 上,如果消费者关闭或重启,它的读取状态不会丢失。

- 消费者是消费组的⼀部分。群组保证每个分区只能被⼀个消费者使⽤。

- 如果⼀个消费者失效,消费组⾥的其他消费者可以接管失效消费者的⼯作,再平衡,分区重新分配。

Offset

生产者Offset:消息写入的时候,每一个分区都有一个offset,这个offset就是生产者的offset,同时也是这个分区的最新最大的offset。

消费者Offset:某个分区的offset情况,生产者写入的offset是最新最大的值是12,而当Consumer A进行消费时,从0开始消费,一直消费到了9,消费者的offset就记录在9,Consumer B就纪录在了11。等下⼀次他们再来消费时,他们可以选择接着上⼀次的位置消费,当然也可以选择从头消费,或者跳到最近的记录并从“现在”开始消费。

AR

分区中的所有副本统称为AR(Assigned Repllicas),AR=ISR+OSR。

ISR

所有与leader副本保持一定程度同步的副本(包括Leader)组成ISR(In-Sync Replicas),ISR集合是AR集合中的一个子集。

消息会先发送到leader副本,然后follower副本才能从leader副本中拉取消息进⾏同步,同步期间内follower副本相对于leader副本⽽⾔会有⼀定程度的滞后。对于这种滞后可以有“⼀定程度”忍受,这个忍受的范围可以通过参数进⾏配置

OSR

与leader副本同步滞后过多的副本(不包括leader)副本,组成OSR(Out-Sync Relipcas)。

在正常情况下,所有的follower副本都应该与leader副本保持⼀定程度的同步,即AR=ISR,OSR集合为空

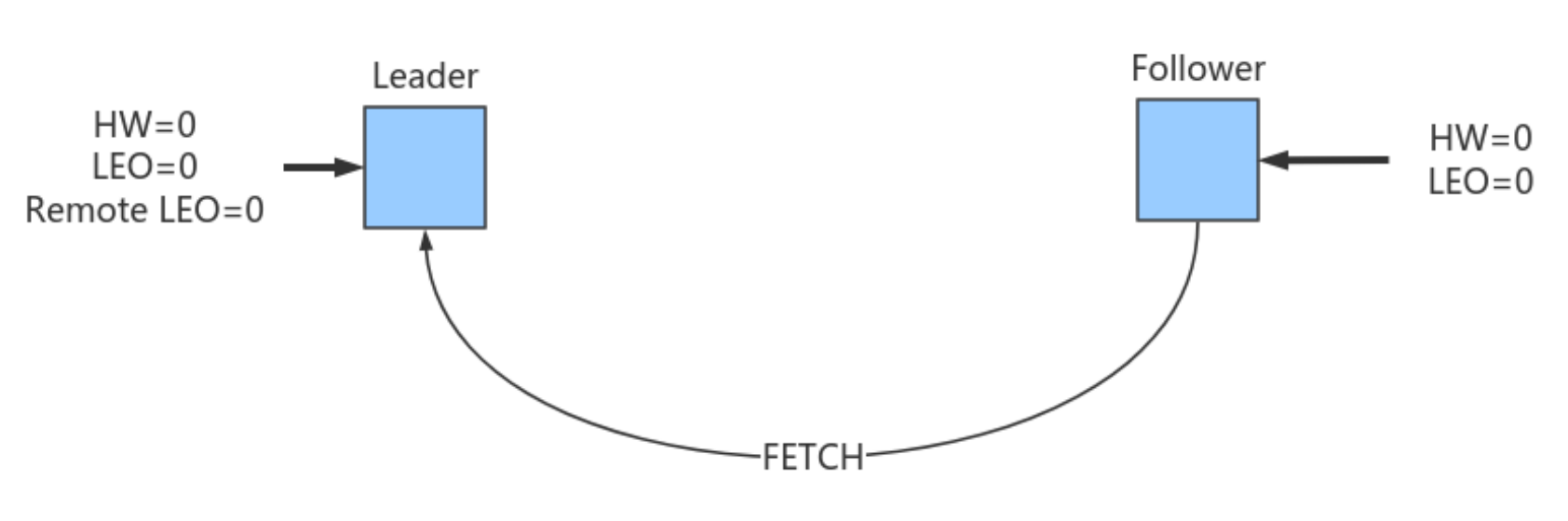

HW

HW是High Watermak的缩写, 俗称⾼⽔位,它表示了⼀个特定消息的偏移量(offset),是该分区的所有副本集中最小的LEO

LEO

LEO是Log End Offset的缩写,它表示了当前⽇志⽂件中下⼀条待写⼊消息的offset。

1.2 Kafka配置

1.2.1 生产者配置

KafkaProducer 的创建需要指定的参数和含义:

参数名称描述retry.backoff.ms在向⼀个指定的主题分区重发消息的时候,重试之间的等待时间。⽐如3次重试,每次重试之后等待该时间⻓度,再接着重试。在⼀些失败的场景,避免了密集循环的重新发送请求。long型值,默认100。可选值:[0,…]retriesretries重试次数当消息发送出现错误的时候,系统会重发消息。跟客户端收到错误时重发⼀样。如果设置了重试,还想保证消息的有序性,需要设置

MAX_IN_FLIGHT_REQUESTS_PER_CONNECTION=1

否则在重试此失败消息的时候,其他的消息可能发送成功了request.timeout.ms客户端等待请求响应的最⼤时⻓。如果服务端响应超时,则会重发请求,除⾮达到重试次数。该设置应该⽐

replica.lag.time.max.ms (a broker configuration)

要⼤,以免在服务器延迟时间内重发消息。int类型值,默认:30000,可选值:[0,…]interceptor.classes在⽣产者接收到该消息,向Kafka集群传输之前,由序列化器处理之前,可以通过拦截器对消息进⾏处理。要求拦截器类必须实现

org.apache.kafka.clients.producer.ProducerInterceptor

接⼝。默认没有拦截器。

Map<String, Object> configs

中通过List集合配置多个拦截器类名。acks默认值:all。acks=0:⽣产者不等待broker对消息的确认,只要将消息放到缓冲区,就认为消息已经发送完成。该情形不能保证broker是否真的收到了消息,retries配置也不会⽣效。发送的消息的返回的消息偏移量永远是-1。 acks=1表示消息只需要写到主分区即可,然后就响应客户端,⽽不等待副本分区的确认。在该情形下,如果主分区收到消息确认之后就宕机了,⽽副本分区还没来得及同步该消息,则该消息丢失。 acks=all⾸领分区会等待所有的ISR副本分区确认记录。该处理保证了只要有⼀个ISR副本分区存活,消息就不会丢失。这是Kafka最强的可靠性保证,等效于acks=-1batch.size当多个消息发送到同⼀个分区的时候,⽣产者尝试将多个记录作为⼀个批来处理。批处理提⾼了客户端和服务器的处理效率。该配置项以字节为单位控制默认批的⼤⼩。所有的批⼩于等于该值。发送给broker的请求将包含多个批次,每个分区⼀个,并包含可发送的数据。如果该值设置的⽐较⼩,会限制吞吐量(设置为0会完全禁⽤批处理)。如果设置的很⼤,⼜有⼀点浪费内存,因为Kafka会永远分配这么⼤的内存来参与到消息的批整合中。client.id⽣产者发送请求的时候传递给broker的id字符串。⽤于在broker的请求⽇志中追踪什么应⽤发送了什么消息。⼀般该id是跟业务有关的字符串。compression.type⽣产者发送的所有数据的压缩⽅式。默认是none,也就是不压缩。⽀持的值:none、gzip、snappy和lz4。压缩是对于整个批来讲的,所以批处理的效率也会影响到压缩的⽐例。send.buffer.bytesTCP发送数据的时候使⽤的缓冲区(SO_SNDBUF)⼤⼩。如果设置为0,则使⽤操作系统默认的。buffer.memory⽣产者可以⽤来缓存等待发送到服务器的记录的总内存字节。如果记录的发送速度超过了将记录发送到服务器的速度,则⽣产者将阻塞

max.block.ms

的时间,此后它将引发异常。此设置应⼤致对应于⽣产者将使⽤的总内存,但并⾮⽣产者使⽤的所有内存都⽤于缓冲。⼀些额外的内存将⽤于压缩(如果启⽤了压缩)以及维护运⾏中的请求。long型数据。默认值:33554432,可选值:[0,…]connections.max.idle.ms当连接空闲时间达到这个值,就关闭连接。long型数据,默认:540000linger.ms⽣产者在发送请求传输间隔会对需要发送的消息进⾏累积,然后作为⼀个批次发送。⼀般情况是消息的发送的速度⽐消息累积的速度慢。有时客户端需要减少请求的次数,即使是在发送负载不⼤的情况下。该配置设置了⼀个延迟,⽣产者不会⽴即将消息发送到broker,⽽是等待这么⼀段时间以累积消息,然后将这段时间之内的消息作为⼀个批次发送。该设置是批处理的另⼀个上限:⼀旦批消息达到了

batch.size

指定的值,消息批会⽴即发送,如果积累的消息字节数达不到

batch.size

的值,可以设置该毫秒值,等待这么⻓时间之后,也会发送消息批。该属性默认值是0(没有延迟)。如果设置

linger.ms=5

,则在⼀个请求发送之前先等待5ms。long型值,默认:0,可选值:[0,…]max.block.ms控制

KafkaProducer.send()

和

KafkaProducer.partitionsFor()

阻塞的时⻓。当缓存满了或元数据不可⽤的时候,这些⽅法阻塞。在⽤户提供的序列化器和分区器的阻塞时间不计⼊。long型值,默认:60000,可选值:[0,…]max.request.size单个请求的最⼤字节数。该设置会限制单个请求中消息批的消息个数,以免单个请求发送太多的数据。服务器有⾃⼰的限制批⼤⼩的设置,与该配置可能不⼀样。int类型值,默认1048576,可选值:[0,…]partitioner.class实现了接⼝

org.apache.kafka.clients.producer.Partitioner

的分区器实现类。默认值为:

org.apache.kafka.clients.producer.internals.DefaultPartitioner

receive.buffer.bytesTCP接收缓存(SO_RCVBUF),如果设置为-1,则使⽤操作系统默认的值。int类型值,默认32768,可选值:[-1,…]security.protocol跟broker通信的协议:PLAINTEXT, SSL, SASL_PLAINTEXT, SASL_SSL.string类型值,默认:PLAINTEXTmax.in.flight.requests.per.connection单个连接上未确认请求的最⼤数量。达到这个数量,客户端阻塞。如果该值⼤于1,且存在失败的请求,在重试的时候消息顺序不能保证。int类型值,默认5。可选值:[1,…]reconnect.backoff.max.ms对于每个连续的连接失败,每台主机的退避将成倍增加,直⾄达到此最⼤值。在计算退避增量之后,添加20%的随机抖动以避免连接⻛暴。long型值,默认1000,可选值:[0,…]reconnect.backoff.ms尝试重连指定主机的基础等待时间。避免了到该主机的密集重连。该退避时间应⽤于该客户端到broker的所有连接。long型值,默认50。可选值:[0,…]key.serializer实现了接⼝org.apache.kafka.common.serialization.Serializer的key序列化类。value.serializer实现了接⼝org.apache.kafka.common.serialization.Serializer的value序列化类。

其他参数可以从

org.apache.kafka.clients.producer.ProducerConfig

中找到。

1.2.2 服务端参数配置

$KAFKA_HOME/config/server.properties⽂件中的配置

参数说明zookeeper.connect该参数⽤于配置Kafka要连接的Zookeeper/集群的地址。

它的值是⼀个字符串,使⽤逗号分隔Zookeeper的多个地址。Zookeeper的单个地址是host:port形式的,可以在最后添加Kafka在Zookeeper中的根节点路径

zookeeper.connect=192.168.0.102:2181,192.168.0.103:2181,192.168.0.104:2181/kafka

listeners⽤于配置broker监听的URI以及监听器名称列表,使⽤逗号隔开多个URI及监听器名称。如果监听器名称代表的不是安全协议,必须配置

listener.security.protocol.map

。每个监听器必须使⽤不同的⽹络端⼝。inter.broker.listener.name⽤于配置broker之间通信使⽤的监听器名称,该名称必须在advertised.listeners列表中。

inter.broker.listener.name=EXTERNAL

listener.security.protocol.map监听器名称和安全协议的映射配置。⽐如,可以将内外⽹隔离,即使它们都使⽤SSL。

listener.security.protocol.map=INTERNAL:SSL,EXTERNAL:SSL

每个监听器的名称只能在map中出现⼀次。advertised.listeners需要将该地址发布到zookeeper供客户端使⽤。

可以在zookeeper的

get /myKafka/brokers/ids/<broker.id>

中找到。

如果不设置此条⽬,就使⽤listeners的配置。

跟listeners不同,该条⽬不能使⽤0.0.0.0⽹络端⼝。

advertised.listeners的地址必须是listeners中配置的或配置的⼀部分。broker.id该属性⽤于唯⼀标记⼀个Kafka的Broker,它的值是⼀个任意integer值。

当Kafka以分布式集群运⾏的时候,尤为重要。

最好该值跟该Broker所在的物理主机有关的,如果主机名为

192.168.100.101

,则

broker.id=101

等等。log.dirs通过该属性的值,指定Kafka在磁盘上保存消息的⽇志⽚段的⽬录。

它是⼀组⽤逗号分隔的本地⽂件系统路径。如果指定了多个路径,那么broker 会根据“最少使⽤”原则,把同⼀个分区的⽇志⽚段保存到同⼀个路径下。

broker 会往拥有最少数⽬分区的路径新增分区,⽽不是往拥有最⼩磁盘空间的路径新增分区。

1.2.3 消费者参数配置

配置项说明bootstrap.servers建⽴到Kafka集群的初始连接⽤到的host/port列表。 客户端会使⽤这⾥指定的所有的host/port来建⽴初始连接。 这个配置仅会影响发现集群所有节点的初始连接。 形式:host1:port1,host2:port2… 这个配置中不需要包含集群中所有的节点信息。 最好不要配置⼀个,以免配置的这个节点宕机的时候连不上。group.id⽤于定义当前消费者所属的消费组的唯⼀字符串。 如果使⽤了消费组的功能

subscribe(topic)

,或使⽤了基于Kafka的偏移量管理机制,则应该配置group.id。auto.commit.interval.ms如果设置了

enable.auto.commit

的值为true,则该值定义了消费者偏移量向Kafka提交的频率。auto.offset.reset如果Kafka中没有初始偏移量或当前偏移量在服务器中不存在(⽐如数据被删掉了): earliest:⾃动重置偏移量到最早的偏移量。 latest:⾃动重置偏移量到最后⼀个 none:如果没有找到该消费组以前的偏移量没有找到,就抛异常。 其他值:向消费者抛异常。fetch.min.bytes服务器对每个拉取消息的请求返回的数据量最⼩值。 如果数据量达不到这个值,请求等待,以让更多的数据累积,达到这个值之后响应请求。 默认设置是1个字节,表示只要有⼀个字节的数据,就⽴即响应请求,或者在没有数据的时候请求超时。 将该值设置为⼤⼀点⼉的数字,会让服务器等待稍微⻓⼀点⼉的时间以累积数据。 如此则可以提⾼服务器的吞吐量,代价是额外的延迟时间。fetch.max.wait.ms如果服务器端的数据量达不到

fetch.min.bytes

的话,服务器端不能⽴即响应请求。该时间⽤于配置服务器端阻塞请求的最⼤时⻓。fetch.max.bytes服务器给单个拉取请求返回的最⼤数据量。 消费者批量拉取消息,如果第⼀个⾮空消息批次的值⽐该值⼤,消息批也会返回,以让消费者可以接着进⾏。 即该配置并不是绝对的最⼤值。 broker可以接收的消息批最⼤值通过

message.max.bytes

(broker配置)或

max.message.bytes

(主题配置)来指定。需要注意的是,消费者⼀般会并发拉取请求。enable.auto.commit如果设置为true,则消费者的偏移量会周期性地在后台提交。connections.max.idle.ms在这个时间之后关闭空闲的连接。check.crcs⾃动计算被消费的消息的CRC32校验值。 可以确保在传输过程中或磁盘存储过程中消息没有被破坏。 它会增加额外的负载,在追求极致性能的场合禁⽤。exclude.internal.topics是否内部主题应该暴露给消费者。如果该条⽬设置为true,则只能先订阅再拉取。isolation.level控制如何读取事务消息。 如果设置了

read_committed

,消费者的

poll()

⽅法只会返回已经提交的事务消息。如果设置了

read_uncommitted

(默认值),消费者的poll⽅法返回所有的消息,即使是已经取消的事务消息。⾮事务消息以上两种情况都返回。 消息总是以偏移量的顺序返回。

read_committed

只能返回到达LSO的消息。在LSO之后出现的消息只能等待相关的事务提交之后才能看到。结果,

read_committed

模式,如果有为提交的事务,消费者不能读取到直到HW的消息。

read_committed

的

seekToEnd

⽅法返回LSO。heartbeat.interval.ms当使⽤消费组的时候,该条⽬指定消费者向消费者协调器发送⼼跳的时间间隔。 ⼼跳是为了确保消费者会话的活跃状态,同时在消费者加⼊或离开消费组的时候⽅便进⾏再平衡。 该条⽬的值必须⼩于

session.timeout.ms

,也不应该⾼于

session.timeout.ms

的1/3。可以将其调整得更⼩,以控制正常重新平衡的预期时间。session.timeout.ms当使⽤Kafka的消费组的时候,消费者周期性地向broker发送⼼跳数据,表明⾃⼰的存在。 如果经过该超时时间还没有收到消费者的⼼跳,则broker将消费者从消费组移除,并启动再平衡。 该值必须在broker配置

group.min.session.timeout.ms

和

group.max.session.timeout.ms

之间。max.poll.records⼀次调⽤

poll()

⽅法返回的记录最⼤数量。max.poll.interval.ms使⽤消费组的时候调⽤poll()⽅法的时间间隔。 该条⽬指定了消费者调⽤poll()⽅法的最⼤时间间隔。 如果在此时间内消费者没有调⽤poll()⽅法,则broker认为消费者失败,触发再平衡,将分区分配给消费组中其他消费者。max.partition.fetch.bytes对每个分区,服务器返回的最⼤数量。消费者按批次拉取数据。 如果⾮空分区的第⼀个记录⼤于这个值,批处理依然可以返回,以保证消费者可以进⾏下去。 broker接收批的⼤⼩由

message.max.bytes

(broker参数)或

max.message.bytes

(主题参数)指定。

fetch.max.bytes

⽤于限制消费者单次请求的数据量。send.buffer.bytes⽤于TCP发送数据时使⽤的缓冲⼤⼩(SO_SNDBUF),-1表示使⽤OS默认的缓冲区⼤⼩。retry.backoff.ms在发⽣失败的时候如果需要重试,则该配置表示客户端等待多⻓时间再发起重试。 该时间的存在避免了密集循环。request.timeout.ms客户端等待服务端响应的最⼤时间。如果该时间超时,则客户端要么重新发起请求,要么如果重试耗尽,请求失败。reconnect.backoff.ms重新连接主机的等待时间。避免了重连的密集循环。 该等待时间应⽤于该客户端到broker的所有连接。reconnect.backoff.max.ms重新连接到反复连接失败的broker时要等待的最⻓时间(以毫秒为单位)。 如果提供此选项,则对于每个连续的连接失败,每台主机的退避将成倍增加,直⾄达到此最⼤值。 在计算退避增量之后,添加20%的随机抖动以避免连接⻛暴。receive.buffer.bytesTCP连接接收数据的缓存(SO_RCVBUF)。-1表示使⽤操作系统的默认值。partition.assignment.strategy当使⽤消费组的时候,分区分配策略的类名。metrics.sample.window.ms计算指标样本的时间窗⼝。metrics.recording.level指标的最⾼记录级别。metrics.num.samples⽤于计算指标⽽维护的样本数量interceptor.classes拦截器类的列表。默认没有拦截器拦截器是消费者的拦截器,该拦截器需要实现

org.apache.kafka.clients.consumer.ConsumerInterceptor

接⼝。拦截器可⽤于对消费者接收到的消息进⾏拦截处理。

1.2.4 主题配置

1.3 Kafka 使用

1.3.1 Kafka API 使用

⽣产者主要的对象有: KafkaProducer , ProducerRecord 。

其中 KafkaProducer 是⽤于发送消息的类, ProducerRecord 类⽤于封装Kafka的消息。

消费者⽣产消息后,需要broker端的确认,可以同步确认,也可以异步确认。

同步确认效率低,异步确认效率⾼,但是需要设置回调对象。

添加Maven依赖:

<dependency><groupId>org.apache.kafka</groupId><artifactId>kafka-clients</artifactId><!--高版本兼容低版本--><version>1.0.2</version></dependency>1.2.3.4.5.6.

生产者

同步等待消息确认:

public class MyProducer1 {

public static void main(String[] args) throws InterruptedException, ExecutionException, TimeoutException {

Map<String, Object> configs = new HashMap<>();

// 设置连接Kafka的初始连接⽤到的服务器地址

// 如果是集群,则可以通过此初始连接发现集群中的其他broker

configs.put("bootstrap.servers", "192.168.0.102:9092");

// 设置key的序列化器

configs.put("key.serializer", IntegerSerializer.class);

// 设置value的序列化器

configs.put("value.serializer", StringSerializer.class);

configs.put("acks", "1");

KafkaProducer<Integer, String> producer = new KafkaProducer<Integer, String>(configs);

// ⽤于封装Producer的消息

ProducerRecord<Integer, String> record = new ProducerRecord<Integer, String>(

"topic_1", // 主题名称

0, // 分区编号,现在只有⼀个分区,所以是0

0, // 数字作为key

"message 0" // 字符串作为value

);

// 发送消息,同步等待消息的确认

Future<RecordMetadata> future = producer.send(record);

RecordMetadata metadata = future.get(3000, TimeUnit.MILLISECONDS);

System.out.println("主题:" + metadata.topic()

+ "\n分区:" + metadata.partition()

+ "\n偏移量:" + metadata.offset()

+ "\n序列化的key字节:" + metadata.serializedKeySize()

+ "\n序列化的value字节:" + metadata.serializedValueSize()

+ "\n时间戳:" + metadata.timestamp());

// 关闭⽣产者

producer.close();

}

}

异步等待消息确认:

publicclassMyProducer2{publicstaticvoidmain(String[] args){Map<String,Object> configs =newHashMap<>();

configs.put("bootstrap.servers","192.168.0.102:9092");

configs.put("key.serializer",IntegerSerializer.class);

configs.put("value.serializer",StringSerializer.class);KafkaProducer<Integer,String> producer =newKafkaProducer<Integer,String>(configs);ProducerRecord<Integer,String> record =newProducerRecord<Integer,String>("topic_1",0,1,"message 2");// 使⽤回调异步等待消息的确认

producer.send(record,newCallback(){@OverridepublicvoidonCompletion(RecordMetadata metadata,Exception exception){if(exception ==null){System.out.println("主题:"+ metadata.topic()+"\n分区:"+ metadata.partition()+"\n偏移量:"+ metadata.offset()+"\n序列化的key字节:"+ metadata.serializedKeySize()+"\n序列化的value字节:"+ metadata.serializedValueSize()+"\n时间戳:"+ metadata.timestamp());}else{System.out.println("有异常:"+ exception.getMessage());}}});// 关闭连接

producer.close();}}

消费者:

publicclassMyConsumer1{publicstaticvoidmain(String[] args){Map<String,Object> configs =newHashMap<>();// 指定bootstrap.servers属性作为初始化连接Kafka的服务器。// 如果是集群,则会基于此初始化连接发现集群中的其他服务器。

configs.put("bootstrap.servers","192.168.0.102:9092");// key的反序列化器

configs.put("key.deserializer",IntegerDeserializer.class);// value的反序列化器

configs.put("value.deserializer",StringDeserializer.class);// 设置消费组

configs.put("group.id","consumer.demo");// 创建消费者对象KafkaConsumer<Integer,String> consumer =newKafkaConsumer<Integer,String>(configs);// 可以使用正则表达式批量订阅主题// final Pattern pattern = Pattern.compile("topic_\\d")finalPattern pattern =Pattern.compile("topic_[0-9]");finalList<String> topics =Arrays.asList("topic_1");// 消费者订阅主题或分区// consumer.subscribe(pattern);// consumer.subscribe(pattern, new ConsumerRebalanceListener() {

consumer.subscribe(topics,newConsumerRebalanceListener(){@OverridepublicvoidonPartitionsRevoked(Collection<TopicPartition> partitions){

partitions.forEach(tp ->{System.out.println("剥夺的分区:"+ tp.partition());});}@OverridepublicvoidonPartitionsAssigned(Collection<TopicPartition> partitions){

partitions.forEach(tp ->{System.out.println(tp.partition());});}});// 拉取订阅主题的消息finalConsumerRecords<Integer,String> records = consumer.poll(3_000);// 获取topic_1主题的消息finalIterable<ConsumerRecord<Integer,String>> topic1Iterable = records.records("topic_1");// 遍历topic_1主题的消息

topic1Iterable.forEach(record ->{System.out.println("========================================");System.out.println("消息头字段:"+Arrays.toString(record.headers().toArray()));System.out.println("消息的key:"+ record.key());System.out.println("消息的偏移量:"+ record.offset());System.out.println("消息的分区号:"+ record.partition());System.out.println("消息的序列化key字节数:"+ record.serializedKeySize());System.out.println("消息的序列化value字节数:"+ record.serializedValueSize());System.out.println("消息的时间戳:"+ record.timestamp());System.out.println("消息的时间戳类型:"+ record.timestampType());System.out.println("消息的主题:"+ record.topic());System.out.println("消息的值:"+ record.value());});// 关闭消费者

consumer.close();}}

1.3.2 springboot Kafka 使用

pom.xml 依赖

<parent><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-parent</artifactId><version>2.2.8.RELEASE</version><relativePath/><!-- lookup parent from repository --></parent><dependencies><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-web</artifactId></dependency><dependency><groupId>org.springframework.kafka</groupId><artifactId>spring-kafka</artifactId></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-test</artifactId><scope>test</scope><exclusions><exclusion><groupId>org.junit.vintage</groupId><artifactId>junit-vintage-engine</artifactId></exclusion></exclusions></dependency><dependency><groupId>org.springframework.kafka</groupId><artifactId>spring-kafka-test</artifactId><scope>test</scope></dependency></dependencies><build><plugins><plugin><groupId>org.springframework.boot</groupId><artifactId>spring-boot-maven-plugin</artifactId></plugin></plugins></build>

application.properties

spring.application.name=demo-02-producer-consumer

server.port=8080

# ⽤于建⽴初始连接的broker地址

spring.kafka.bootstrap-servers=192.168.0.102:9092

# producer⽤到的key和value的序列化类

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.IntegerSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer

# 默认的批处理记录数

spring.kafka.producer.batch-size=16384

# 32MB的总发送缓存

spring.kafka.producer.buffer-memory=33554432

# consumer⽤到的key和value的反序列化类

spring.kafka.consumer.key-deserializer=org.apache.kafka.common.serialization.IntegerDeserializer

spring.kafka.consumer.value-deserializer=org.apache.kafka.common.serialization.StringDeserializer

# consumer的消费组id

spring.kafka.consumer.group-id=spring-kafka-02-consumer

# 是否⾃动提交消费者偏移量

spring.kafka.consumer.enable-auto-commit=true

# 每隔100ms向broker提交⼀次偏移量

spring.kafka.consumer.auto-commit-interval=100

# 如果该消费者的偏移量不存在,则⾃动设置为最早的偏移量

spring.kafka.consumer.auto-offset-reset=earliest

Application.java 启动类

@SpringBootApplicationpublicclassApplication{publicstaticvoidmain(String[] args){SpringApplication.run(Application.class, args);}}

KafkaConfig.java 配置类,可以在应用启动时创建Topic,这里可以不用,因为主题不存在的时候Kafka可以自动创建

@Configuration

public class KafkaConfig {

@Bean

public NewTopic topic1() {

return new NewTopic("ntp-01", 5, (short) 1);

}

@Bean

public NewTopic topic2() {

return new NewTopic("ntp-02", 3, (short) 1);

}

}

生产者 KafkaSyncProducerController.java

@RestControllerpublicclassKafkaSyncProducerController{@AutowiredprivateKafkaTemplate template;// 同步等待消息发送@GetMapping("/sendSync/{message}")publicStringsendSync(@PathVariableString message)throwsExecutionException,InterruptedException{ProducerRecord<Integer,String> record =newProducerRecord<>("spring-topic-01",0,1, message

);ListenableFuture future = template.send(record);// 同步等待broker的响应Object o = future.get();SendResult<Integer,String> result =(SendResult<Integer,String>) o;System.out.println(result.getRecordMetadata().topic()+ result.getRecordMetadata().partition()+ result.getRecordMetadata().offset());return"success";}// 异步等待消息确认@GetMapping("/sendAsync/{message}")publicStringsendAsync(@PathVariableString message)throwsExecutionException,InterruptedException{ProducerRecord<Integer,String> record =newProducerRecord<>("spring-topic-01",0,1, message

);ListenableFuture<SendResult<Integer,String>> future = template.send(record);// 异步等待broker的响应

future.addCallback(newListenableFutureCallback<SendResult<Integer,String>>(){@OverridepublicvoidonFailure(Throwable throwable){System.out.println("发送失败: "+ throwable.getMessage());}@OverridepublicvoidonSuccess(SendResult<Integer,String> result){System.out.println("发送成功:"+ result.getRecordMetadata().topic()+"\t"+ result.getRecordMetadata().partition()+"\t"+ result.getRecordMetadata().offset());}});return"success";}}

消费者MyConsumer.java

@ComponentpublicclassMyConsumer{@KafkaListener(topics ="spring-topic-01")publicvoidonMessage(ConsumerRecord<Integer,String> record){Optional<ConsumerRecord<Integer,String>> optional =Optional.ofNullable(record);if(optional.isPresent()){System.out.println(record.topic()+"\t"+ record.partition()+"\t"+ record.offset()+"\t"+ record.key()+"\t"+ record.value());}}}

二、Kafka高级特性

2.1 生产者

2.1.1 消息发送

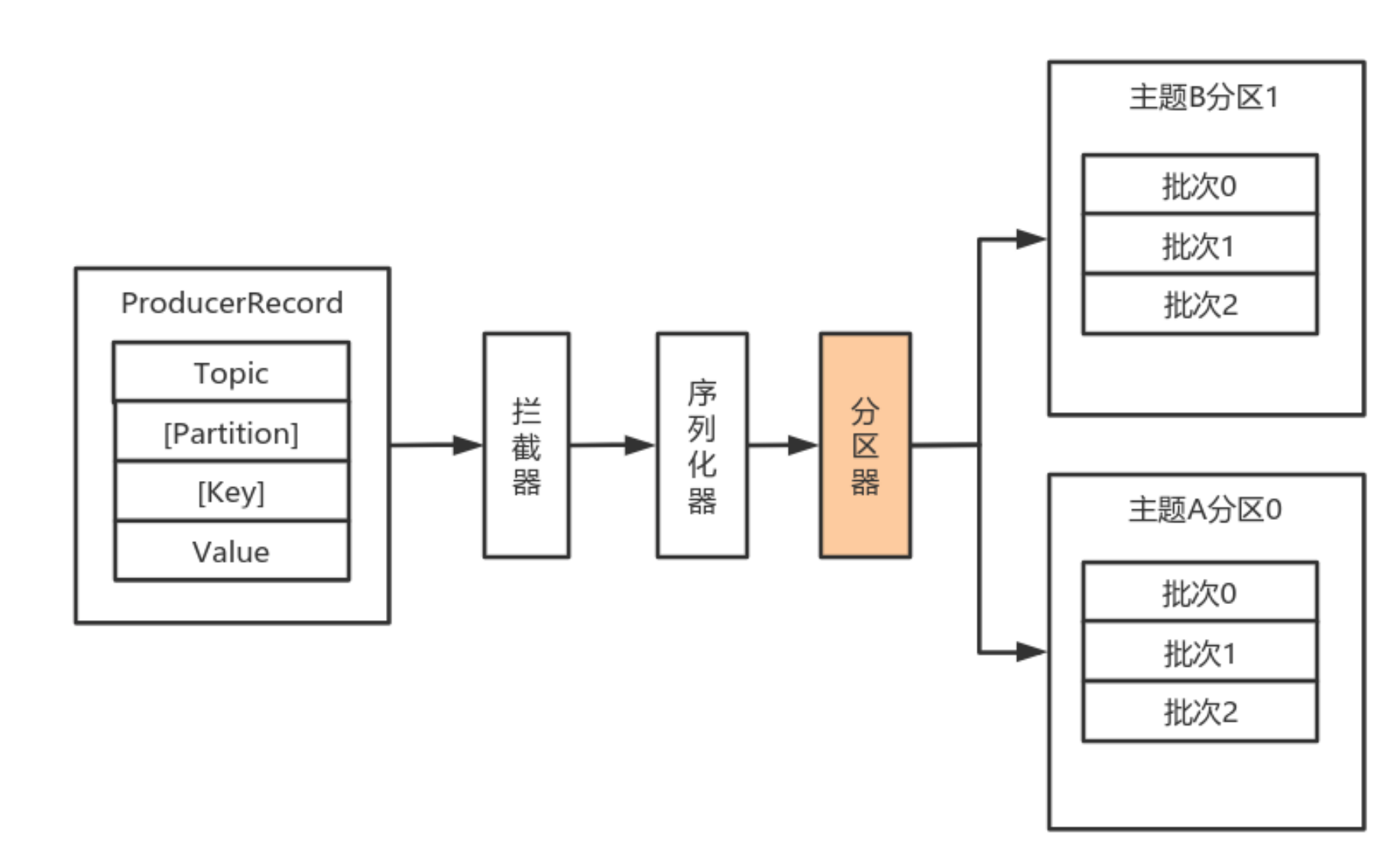

2.1.1.1 数据生产流程

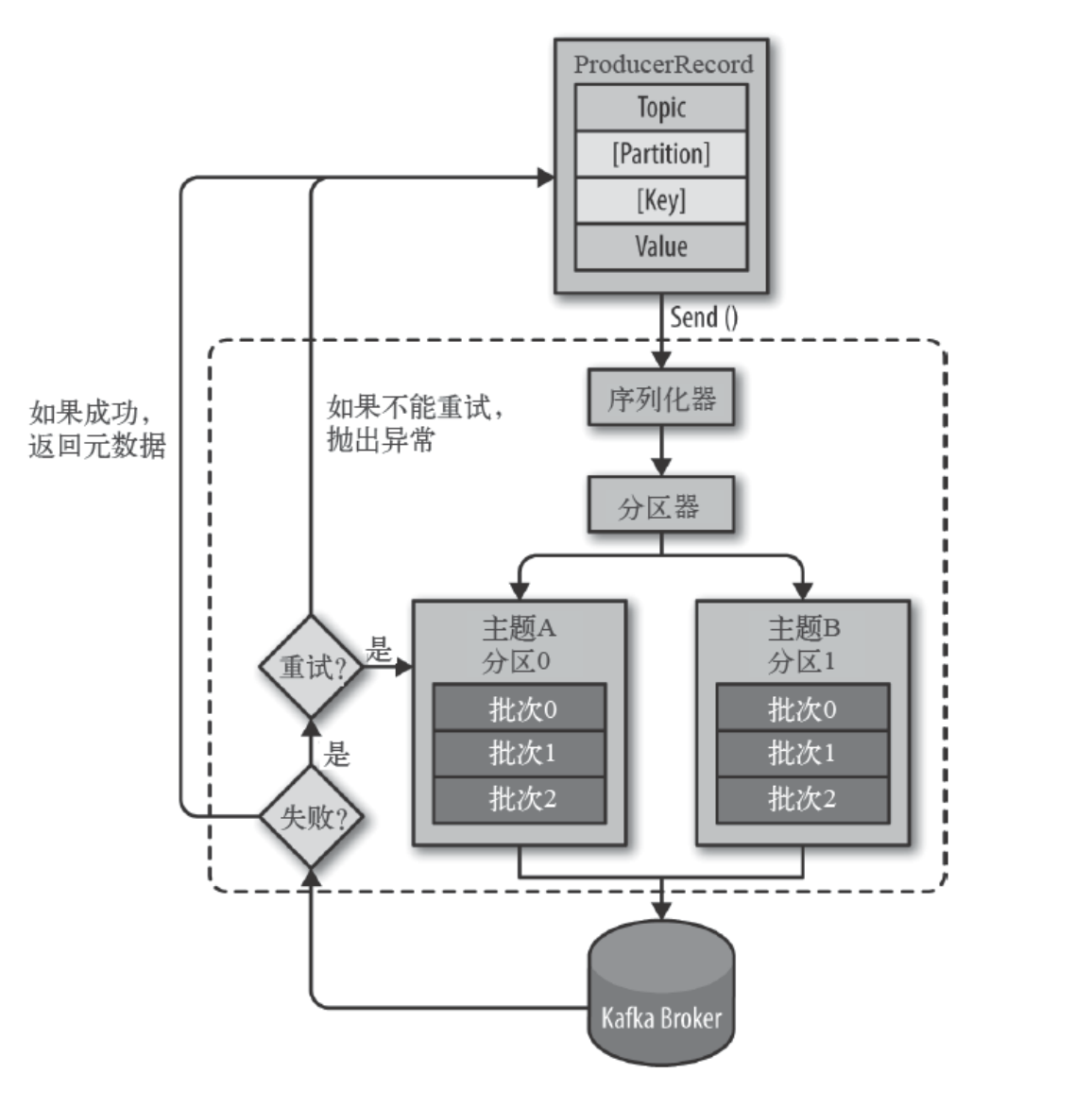

数据生产流程图解:

- Producer创建时,会创建⼀个Sender线程并设置为守护线程

- ⽣产消息时,内部其实是异步流程;⽣产的消息先经过拦截器->序列化器->分区器,然后将消息缓存在缓冲区(该缓冲区也是在Producer创建时创建)

- 批次发送的条件为:缓冲区数据⼤⼩达到

batch.size或者linger.ms达到上限,哪个先达到就算哪个 - 批次发送后,发往指定分区,然后落盘到 broker;如果⽣产者配置了

retrires参数⼤于0并且失败原因允许重试,那么客户端内部会对该消息进⾏重试 - 落盘到broker成功,返回⽣产元数据给⽣产者

- 元数据返回有两种⽅式:⼀种是通过阻塞直接返回,另⼀种是通过回调返回

2.1.1.2 拦截器

Producer 的拦截器(Interceptor)和 Consumer 的 Interceptor 主要⽤于实现Client端的定制化控制逻辑。

对于Producer⽽⾔,Interceptor使得⽤户在消息发送前以及Producer回调逻辑前有机会对消息做⼀些定制化需求,⽐如修改消息等。同时,Producer允许⽤户指定多个Interceptor按序作⽤于同⼀条消息从⽽形成⼀个拦截链(Interceptor Chain)。如果有多个拦截器1,2,3 那发送前的调用顺序是1->2->3,回调的时候顺序还是1->2->3而不是3->2->1,Intercetpor 的实现接⼝是

org.apache.kafka.clients.producer.ProducerInterceptor

,其定义的⽅法包括:

onSend(ProducerRecord):该⽅法封装进KafkaProducer.send⽅法中,即运⾏在⽤户主线程中。Producer确保在消息被序列化以及分区前调⽤该⽅法。⽤户可以在该⽅法中对消息做任何操作,但最好保证不要修改消息所属的topic和分区,否则会影响⽬标分区的计算。onAcknowledgement(RecordMetadata, Exception):该⽅法会在消息被应答之前或消息发送失败时调⽤,并且通常都是在Producer回调逻辑触发之前。onAcknowledgement运⾏在Producer的IO线程中,因此不要在该⽅法中放⼊很重的逻辑,否则会拖慢Producer的消息发送效率。close:关闭Interceptor,主要⽤于执⾏⼀些资源清理⼯作。

如前所述,Interceptor可能被运⾏在多个线程中,因此在具体实现时⽤户需要⾃⾏确保线程安全。另外倘若指定了多个Interceptor,则Producer将按照指定顺序调⽤它们,并仅仅是捕获每个Interceptor可能抛出的异常记录到错误⽇志中⽽⾮在向上传递。这在使⽤过程中要特别留意。

自定义拦截器步骤:

- 实现ProducerInterceptor接⼝,自定义拦截器

- 在KafkaProducer的设置中设置⾃定义的拦截器

自定义拦截器:

public class InterceptorOne<Key, Value> implements ProducerInterceptor<Key, Value> {

private static final Logger LOGGER = LoggerFactory.getLogger(InterceptorOne.class);

/**

*发送前调用

*/

@Override

public ProducerRecord<Key, Value> onSend(ProducerRecord<Key, Value> record) {

System.out.println("拦截器---go");

// 此处可以根据业务需要对相关的数据作修改

String topic = record.topic();

Integer partition = record.partition();

Long timestamp = record.timestamp();

Key key = record.key();

Value value = record.value();

Headers headers = record.headers();

// 添加消息头

headers.add("interceptor", "自定义拦截器".getBytes());

ProducerRecord<Key, Value> newRecord = new ProducerRecord<Key, Value>(topic,

partition, timestamp, key, value, headers);

return newRecord;

}

//异常或者返回结果时调用

@Override

public void onAcknowledgement(RecordMetadata metadata, Exception exception) {

System.out.println("拦截器---back");

if (exception != null) {

// 如果发⽣异常,记录⽇志中

LOGGER.error(exception.getMessage());

}

}

@Override

public void close() {

}

@Override

public void configure(Map<String, ?> configs) {

}

}

生产者

public class MyProducer {

public static void main(String[] args) throws InterruptedException, ExecutionException, TimeoutException {

Map<String, Object> configs = new HashMap<>();

// 设置连接Kafka的初始连接⽤到的服务器地址

// 如果是集群,则可以通过此初始连接发现集群中的其他broker

configs.put("bootstrap.servers", "192.168.0.102:9092");

// 设置key的序列化器

configs.put("key.serializer", IntegerSerializer.class);

// 设置value的序列化类

configs.put("value.serializer", StringSerializer.class);

// 设置自定义拦截器 如果有多个可以以,间隔

configs.put(ProducerConfig.INTERCEPTOR_CLASSES_CONFIG,

"com.edu.interceptor.InterceptorOne");

KafkaProducer<Integer, User> producer = new KafkaProducer<>(configs);

// ⽤于封装Producer的消息

ProducerRecord<Integer, String> record = new ProducerRecord<>(

"topic_1", // 主题名称

0, // 分区编号

1, // 数字作为key

"自定义拦截器" // user 对象作为value

);

producer.send(record, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e == null) {

System.out.println("消息发送成功:" + metadata.topic() + "\t"

+ metadata.partition() + "\t"

+ metadata.offset());

} else {

System.out.println("消息发送异常");

}

}

});

// 关闭⽣产者

producer.close();

}

}

2.1.1.3 序列化器

Kafka使⽤

org.apache.kafka.common.serialization.Serializer

接⼝⽤于定义序列化器,将泛型指定类型的数据转换为字节数组。

package org.apache.kafka.common.serialization;

import java.io.Closeable;

import java.util.Map;

/**

将对象转换为byte数组的接⼝

该接⼝的实现类需要提供⽆参构造器

@param <T> 从哪个类型转换

*/

public interface Serializer<T> extends Closeable {

/*

类的配置信息

@param configs key/value pairs

@param isKey key的序列化还是value的序列化

*/

void configure(Map<String, ?> var1, boolean var2);

/*

将对象转换为字节数组

@param topic 主题名称

@param data 需要转换的对象

@return 序列化的字节数组

*/

byte[] serialize(String var1, T var2);

/*

关闭序列化器

该⽅法需要提供幂等性,因为可能调⽤多次。

*/

void close();

}

系统提供了该接⼝的⼦接⼝以及实现类:

org.apache.kafka.common.serialization.ByteArraySerializer

org.apache.kafka.common.serialization.ByteBufferSerializer

org.apache.kafka.common.serialization.BytesSerializer

org.apache.kafka.common.serialization.DoubleSerializer

org.apache.kafka.common.serialization.FloatSerializer

org.apache.kafka.common.serialization.IntegerSerializer

org.apache.kafka.common.serialization.StringSerializer

org.apache.kafka.common.serialization.LongSerializer

org.apache.kafka.common.serialization.ShortSerializer

自定义序列化器

数据的序列化⼀般⽣产中使⽤

avro

。

⾃定义序列化器需要实现

org.apache.kafka.common.serialization.Serializer<T>

接⼝,并实现其中的

serialize

⽅法。

实体类

public class User {

private Integer userId;

private String username;

// set、get方法省略

}

自定义序列化器

public class UserSerializer implements Serializer<User> {

@Override

public void configure(Map<String, ?> map, boolean b) {

// do Nothing

}

@Override

public byte[] serialize(String topic, User user) {

try {

// 如果数据是null,则返回null

if (user == null) return null;

Integer userId = user.getUserId();

String username = user.getUsername();

int length = 0;

byte[] bytes = null;

if (null != username) {

bytes = username.getBytes("utf-8");

length = bytes.length;

}

//userId+username的字节长度+username的字节

ByteBuffer buffer = ByteBuffer.allocate(4 + 4 + length);

buffer.putInt(userId);

buffer.putInt(length);

buffer.put(bytes);

return buffer.array();

} catch (UnsupportedEncodingException e) {

throw new SerializationException("序列化数据异常");

}

}

@Override

public void close() {

// do Nothing

}

}

生产者:

public class MyProducer1 {

public static void main(String[] args) throws InterruptedException, ExecutionException, TimeoutException {

Map<String, Object> configs = new HashMap<>();

// 设置连接Kafka的初始连接⽤到的服务器地址

// 如果是集群,则可以通过此初始连接发现集群中的其他broker

configs.put("bootstrap.servers", "192.168.0.102:9092");

// 设置key的序列化器

configs.put("key.serializer", IntegerSerializer.class);

// 设置⾃定义的序列化类

configs.put("value.serializer", UserSerializer.class);

KafkaProducer<Integer, User> producer = new KafkaProducer<>(configs);

User user = new User();

user.setUserId(1);

user.setUsername("自定义序列化");

// ⽤于封装Producer的消息

ProducerRecord<Integer, User> record = new ProducerRecord<>(

"topic_1", // 主题名称

0, // 分区编号

user.getUserId(), // 数字作为key

user // user 对象作为value

);

producer.send(record, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e == null) {

System.out.println("消息发送成功:" + metadata.topic() + "\t"

+ metadata.partition() + "\t"

+ metadata.offset());

} else {

System.out.println("消息发送异常");

}

}

});

// 关闭⽣产者

producer.close();

}

}

2.1.1.4 分区器

默认(

DefaultPartitioner

)分区计算:

- 如果record提供了分区号,则使⽤record提供的分区号

- 如果record没有提供分区号,则使⽤key的序列化后的值的hash值对分区数量取模

- 如果record没有提供分区号,也没有提供key,则使⽤轮询的⽅式分配分区号。 - 会⾸先在可⽤的分区中分配分区号- 如果没有可⽤的分区,则在该主题所有分区中分配分区号。

Kafka自带的默认分区器(

DefaultPartitioner

):

默认的分区器实现了

Partitioner

接口:

public interface Partitioner extends Configurable, Closeable {

/**

* 为指定的消息记录计算分区值

*

* @param topic 主题名称

* @param key 根据该key的值进⾏分区计算,如果没有则为null

* @param keyBytes key的序列化字节数组,根据该数组进⾏分区计算。如果没有key,则为null

* @param value 根据value值进⾏分区计算,如果没有,则为null

* @param valueBytes value的序列化字节数组,根据此值进⾏分区计算。如果没有,则为null

* @param cluster 当前集群的元数据

*/

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster);

/**

* 关闭分区器的时候调⽤该⽅法

*/

public void close();

}

自定义分区器

- ⾸先开发Partitioner接⼝的实现类

- 在KafkaProducer中进⾏设置:

configs.put("partitioner.class", "xxx.xx.Xxx.class")

实现Partitioner接⼝⾃定义分区器:

public class MyPartitioner implements Partitioner {

@Override

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

return 0;

}

@Override

public void close() {

}

@Override

public void configure(Map<String, ?> configs) {

}

}

然后在⽣产者中配置:

configs.put("partitioner.class", "com.edu.config.MyPartitioner");

2.1.2 消息发送原理

原理图解:

由上图可以看出:

KafkaProducer

有两个基本线程:

- 主线程:负责消息创建,拦截器,序列化器,分区器等操作,并将消息追加到消息收集器

RecoderAccumulator中; - 消息收集器RecoderAccumulator为每个分区都维护了⼀个Deque<ProducerBatch>类型的双端队列。-ProducerBatch可以理解为是ProducerRecord的集合,批量发送有利于提升吞吐量,降低⽹络影响;- 由于⽣产者客户端使⽤java.io.ByteBuffer在发送消息之前进⾏消息保存,并维护了⼀个BufferPool实现ByteBuffer的复⽤;该缓存池只针对特定⼤⼩(batch.size指定)的ByteBuffer进⾏管理,对于消息过⼤的缓存,不能做到重复利⽤。- 每次追加⼀条ProducerRecord消息,会寻找/新建对应的双端队列,从其尾部获取⼀个ProducerBatch,判断当前消息的⼤⼩是否可以写⼊该批次中。若可以写⼊则写⼊;若不可以写⼊,则新建⼀个ProducerBatch,判断该消息⼤⼩是否超过客户端参数配置batch.size的值,不超过,则以batch.size建⽴新的ProducerBatch,这样⽅便进⾏缓存重复利⽤;若超过,则以计算的消息⼤⼩建⽴对应的ProducerBatch,缺点就是该内存不能被复⽤了。 Sender线程:该线程从消息收集器获取缓存的消息,将其处理为<Node, List<ProducerBatch>的形式, Node 表示集群的broker节点。- 进⼀步将

<Node, List<ProducerBatch>转化为<Node, Request>形式,此时才可以向服务端发送数据。 - 在发送之前,

Sender线程将消息以Map<NodeId, Deque<Request>>的形式保存到InFlightRequests中进⾏缓存,可以通过其获取leastLoadedNode,即当前Node中负载压⼒最⼩的⼀个,以实现消息的尽快发出。

2.2 消费者

2.2.1 相关概念

2.2.1.1 消费组&消费者

消费者:

- 消费者从订阅的主题消费消息,消费消息的偏移量保存在Kafka的名字是

__consumer_offsets的主题中 - 消费者还可以将⾃⼰的偏移量存储到

Zookeeper,需要设置offset.storage=zookeeper - 推荐使⽤Kafka存储消费者的偏移量。因为Zookeeper不适合⾼并发。

消费组:

- 多个从同⼀个主题消费的消费者可以加⼊到⼀个消费组中

- 消费组中的消费者共享group_id。配置方法:

configs.put("group.id", "xxx"); - group_id⼀般设置为应⽤的逻辑名称。⽐如多个订单处理程序组成⼀个消费组,可以设置group_id为"order_process"

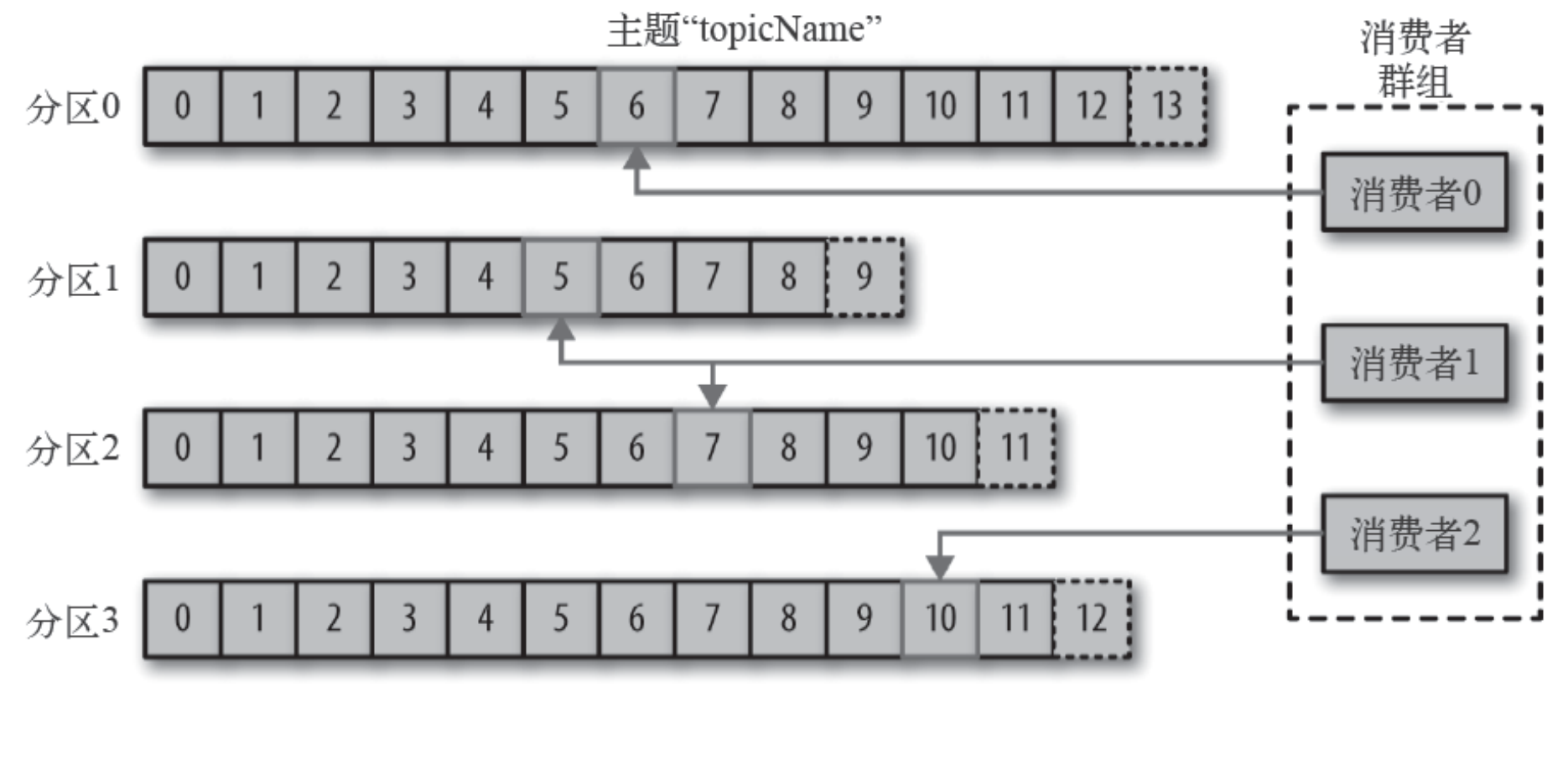

- 消费组均衡地给消费者分配分区,每个分区只由消费组中⼀个消费者消费

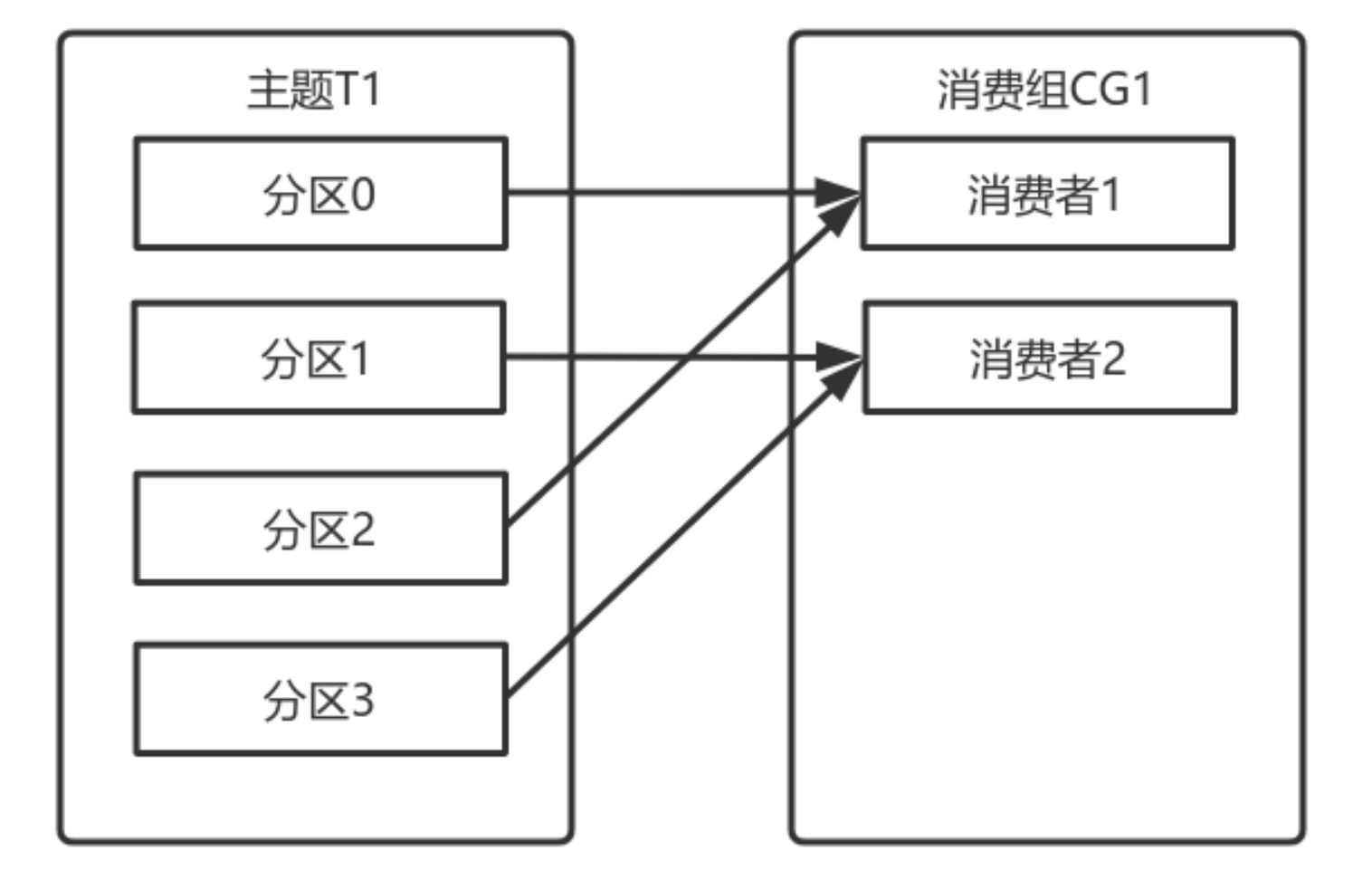

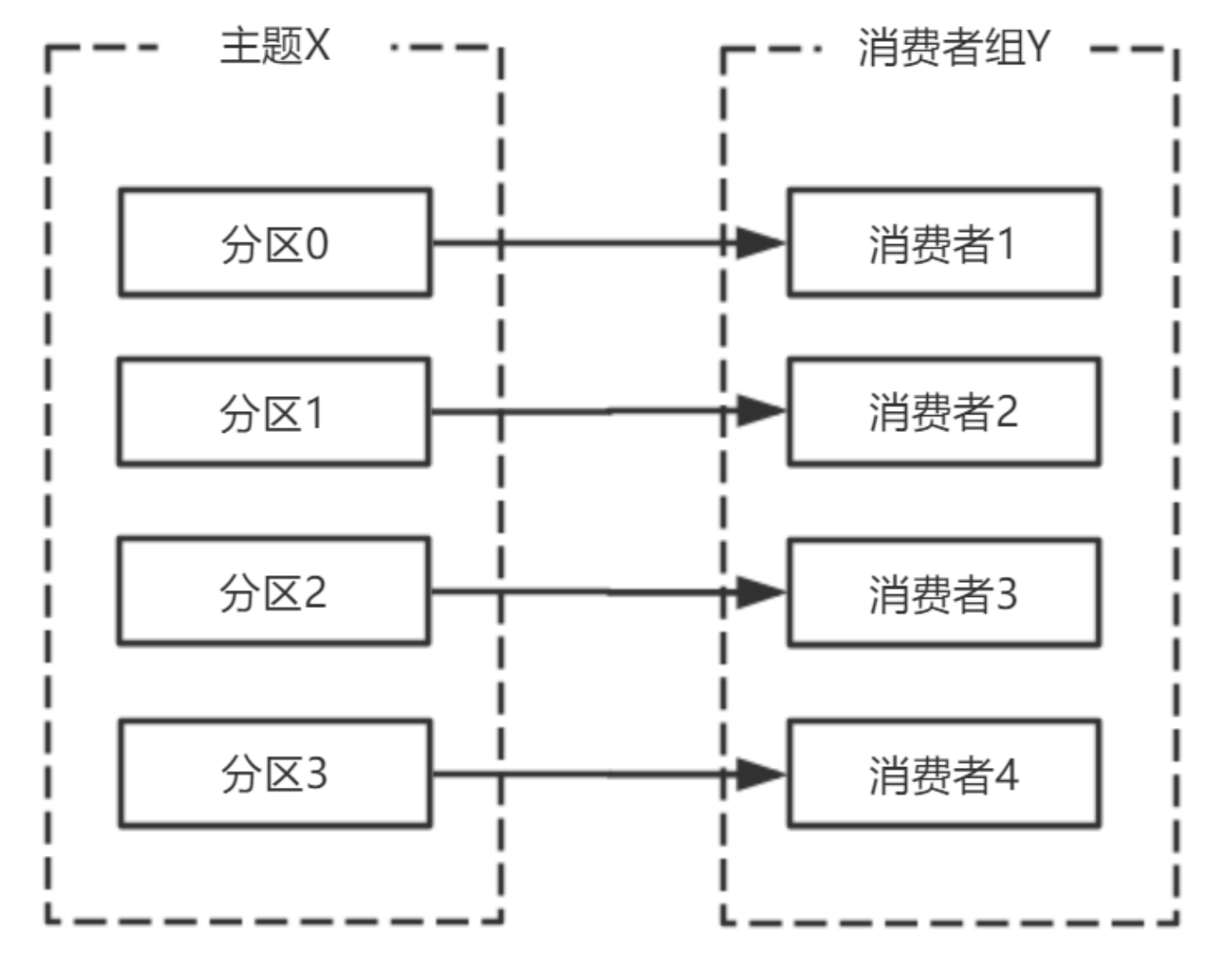

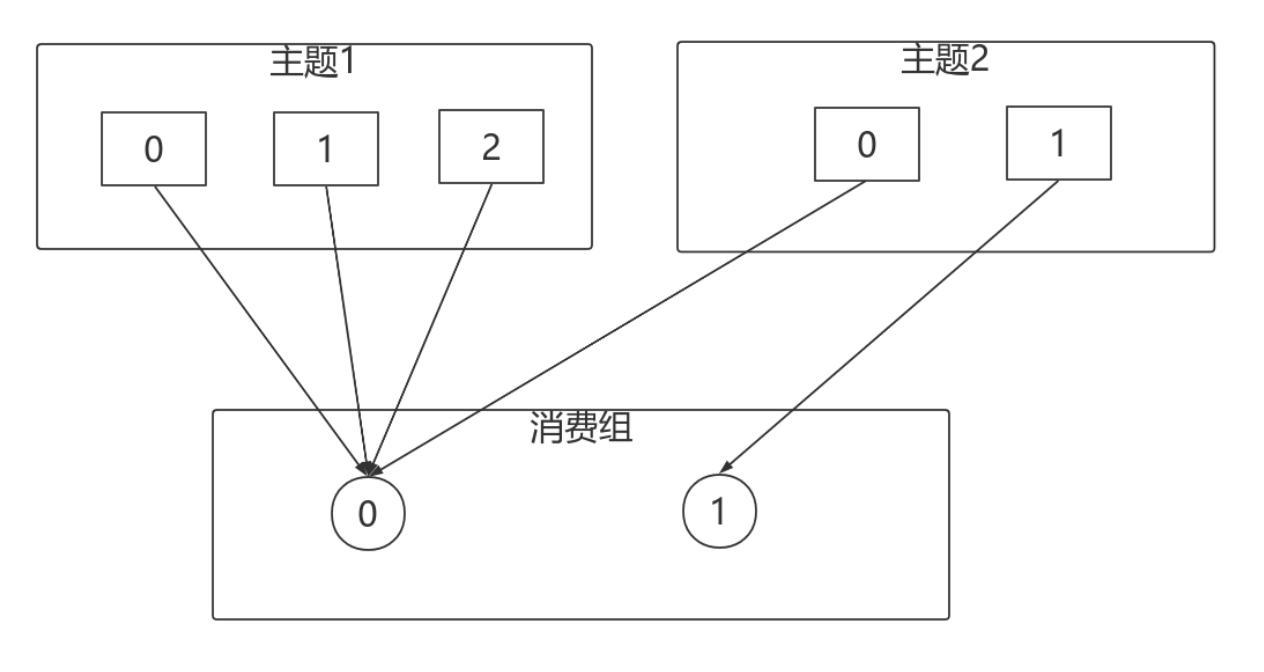

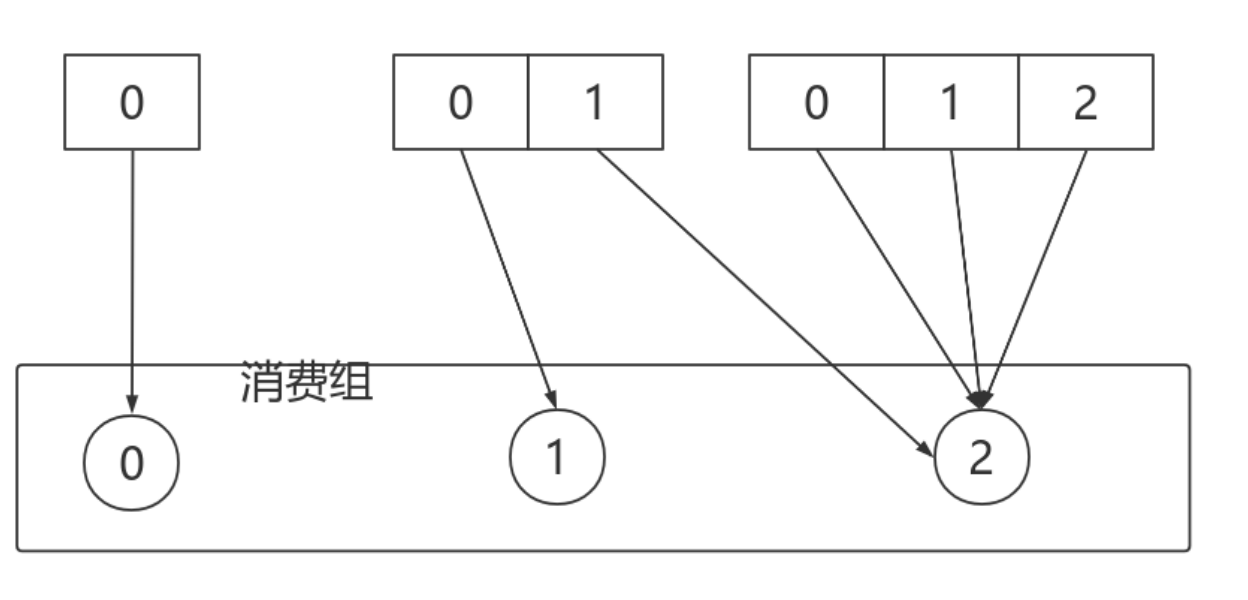

⼀个拥有四个分区的主题,包含⼀个消费者的消费组

此时,消费组中的消费者消费主题中的所有分区。并且没有重复的可能。

如果在消费组中添加⼀个消费者2,则每个消费者分别从两个分区接收消息

如果消费组有四个消费者,则每个消费者可以分配到⼀个分区

如果向消费组中添加更多的消费者,超过主题分区数量,则有⼀部分消费者就会闲置,不会接收任何消息

向消费组添加消费者是横向扩展消费能⼒的主要⽅式。

必要时,需要为主题创建⼤量分区,在负载增⻓时可以加⼊更多的消费者。但是不要让消费者的数量超过主题分区的数量。

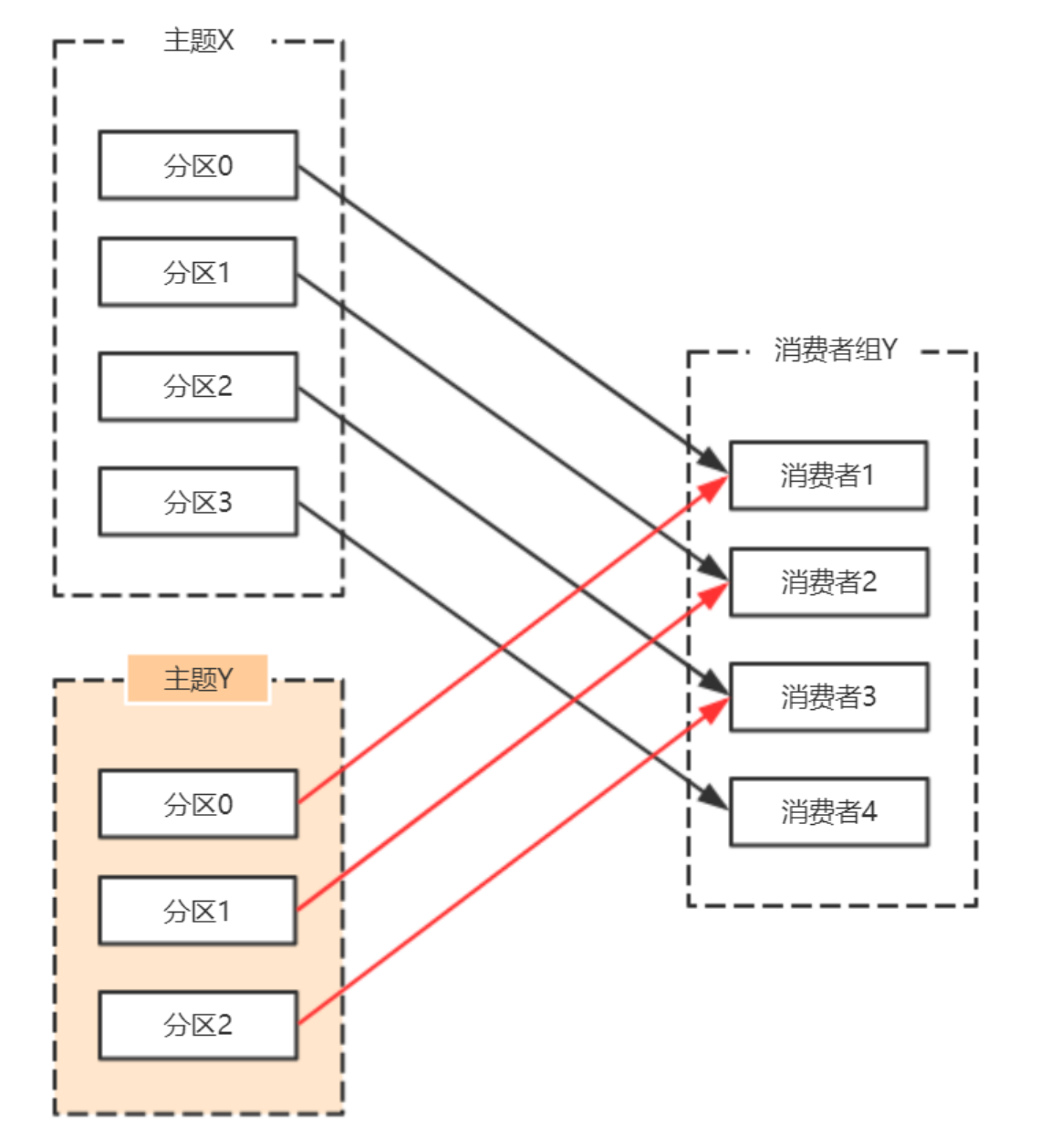

除了通过增加消费者来横向扩展单个应⽤的消费能⼒之外,经常出现多个应⽤程序从同⼀个主题消费的情况。

此时,每个应⽤都可以获取到所有的消息。只要保证每个应⽤都有⾃⼰的消费组,就可以让它们获取到主题所有的消息。

横向扩展消费者和消费组不会对性能造成负⾯影响。

为每个需要获取⼀个或多个主题全部消息的应⽤创建⼀个消费组,然后向消费组添加消费者来横向扩展消费能⼒和应⽤的处理能⼒,则每个消费者只处理⼀部分消息。

2.2.1.2 ⼼跳机制

初始的消费者消费分区:

消费者宕机,退出消费组,触发再平衡,重新给消费组中的消费者分配分区

由于broker宕机,主题X的分区3宕机,此时分区3没有Leader副本,触发再平衡,消费者4没有对应的主题分区,则消费者4闲置

Kafka 的⼼跳是 Kafka Consumer 和 Broker 之间的健康检查,只有当 Broker Coordinator 正常时,Consumer 才会发送⼼跳。

Consumer 和 Rebalance 相关的 2 个配置参数:

参数字段session.timeout.msMemberMetadata.sessionTimeoutMsmax.poll.interval.msMemberMetadata.rebalanceTimeoutMs

broker 端,sessionTimeoutMs 参数

broker 处理⼼跳的逻辑在

GroupCoordinator

类中。如果⼼跳超期, broker coordinator 会把消费者从 group 中移除,并触发 rebalance。

可以看看源码的

kafka.coordinator.group.GroupCoordinator#completeAndScheduleNextHeartbeatExpiration

方法。

如果客户端发现⼼跳超期,客户端会标记 coordinator 为不可⽤,并阻塞⼼跳线程;如果超过了 poll 消息的间隔超过了 rebalanceTimeoutMs,则 consumer 告知 broker 主动离开消费组,也会触发 rebalance

可以看看源码的

org.apache.kafka.clients.consumer.internals.AbstractCoordinator.HeartbeatThread

内部类

2.2.2 消息接收

2.2.2.1 常用参数配置

参数说明bootstrap.servers向Kafka集群建⽴初始连接⽤到的host/port列表。 客户端会使⽤这⾥列出的所有服务器进⾏集群其他服务器的发现,⽽不管是否指定了哪个服务器⽤作引导。 这个列表仅影响⽤来发现集群所有服务器的初始主机。 字符串形式:host1:port1,host2:port2,… 由于这组服务器仅⽤于建⽴初始链接,然后发现集群中的所有服务器,因此没有必要将集群中的所有地址写在这⾥。 ⼀般最好两台,以防其中⼀台宕掉。key.deserializerkey的反序列化类,该类需要实现

org.apache.kafka.common.serialization.Deserializer

接⼝。value.deserializer实现了

org.apache.kafka.common.serialization.Deserializer

接⼝的反序列化器,⽤于对消息的value进⾏反序列化。client.id当从服务器消费消息的时候向服务器发送的id字符串。在ip/port基础上提供应⽤的逻辑名称,记录在服务端的请求⽇志中,⽤于追踪请求的源。group.id⽤于唯⼀标志当前消费者所属的消费组的字符串。 如果消费者使⽤组管理功能如subscribe(topic)或使⽤基于Kafka的偏移量管理策略,该项必须设置。auto.offset.reset当Kafka中没有初始偏移量或当前偏移量在服务器中不存在(如,数据被删除了),该如何处理? earliest:⾃动重置偏移量到最早的偏移量 latest:⾃动重置偏移量为最新的偏移量 none:如果消费组原来的(previous)偏移量不存在,则向消费者抛异常 anything:向消费者抛异常enable.auto.commit如果设置为true,消费者会⾃动周期性地向服务器提交偏移量。

2.2.2.2 订阅

Topic:Kafka⽤于分类管理消息的逻辑单元,类似与MySQL的数据库。

Partition:是Kafka下数据存储的基本单元,这个是物理上的概念。同⼀个topic的数据,会被分散的存储到多个partition中,这些partition可以在同⼀台机器上,也可以是在多台机器上。优势在于:有利于⽔平扩展,避免单台机器在磁盘空间和性能上的限制,同时可以通过复制来增加数据冗余性,提⾼容灾能⼒。为了做到均匀分布,通常partition的数量通常是Broker Server数量的整数倍。

Consumer Group:同样是逻辑上的概念,是Kafka实现单播和⼴播两种消息模型的⼿段。保证⼀个消费组获取到特定主题的全部的消息。在消费组内部,若⼲个消费者消费主题分区的消息,消费组可以保证⼀个主题的每个分区只被消费组中的⼀个消费者消费。

consumer 采⽤ pull 模式从 broker 中读取数据。

采⽤ pull 模式,consumer 可⾃主控制消费消息的速率, 可以⾃⼰控制消费⽅式(批量消费/逐条消费),还可以选择不同的提交⽅式从⽽实现不同的传输语义。

订阅主题:

consumer.subscribe(Arrays.asList("tp_demo_01,tp_demo_02"))

2.2.2.3 反序列化

自带反序列化器

Kafka的broker中所有的消息都是字节数组,消费者获取到消息之后,需要先对消息进⾏反序列化处理,然后才能交给⽤户程序消费处理。

常用的Kafka提供的,反序列化器包括key的和value的反序列化器:

- key.deserializer:IntegerDeserializer

- value.deserializer:StringDeserializer

消费者从订阅的主题拉取消息(

consumer.poll(3_000)

)后在Fetcher类中,对拉取到的消息⾸先进⾏反序列化处理:

privateConsumerRecord<K,V>parseRecord(TopicPartition partition,RecordBatch batch,Record record){try{long offset = record.offset();long timestamp = record.timestamp();Optional<Integer> leaderEpoch =this.maybeLeaderEpoch(batch.partitionLeaderEpoch());TimestampType timestampType = batch.timestampType();Headers headers =newRecordHeaders(record.headers());ByteBuffer keyBytes = record.key();byte[] keyByteArray = keyBytes ==null?null:Utils.toArray(keyBytes);K key = keyBytes ==null?null:this.keyDeserializer.deserialize(partition.topic(), headers, keyByteArray);ByteBuffer valueBytes = record.value();byte[] valueByteArray = valueBytes ==null?null:Utils.toArray(valueBytes);V value = valueBytes ==null?null:this.valueDeserializer.deserialize(partition.topic(), headers, valueByteArray);returnnewConsumerRecord(partition.topic(), partition.partition(), offset, timestamp, timestampType, record.checksumOrNull(), keyByteArray ==null?-1: keyByteArray.length, valueByteArray ==null?-1: valueByteArray.length, key, value, headers, leaderEpoch);}catch(RuntimeException var17){thrownewSerializationException("Error deserializing key/value for partition "+ partition +" at offset "+ record.offset()+". If needed, please seek past the record to continue consumption.", var17);}}

Kafka默认提供了⼏个反序列化的实现:

org.apache.kafka.common.serialization.ByteArrayDeserializer

org.apache.kafka.common.serialization.ByteBufferDeserializer

org.apache.kafka.common.serialization.BytesDeserializer

org.apache.kafka.common.serialization.DoubleDeserializer

org.apache.kafka.common.serialization.FloatDeserializer

org.apache.kafka.common.serialization.IntegerDeserializer

org.apache.kafka.common.serialization.LongDeserializer

org.apache.kafka.common.serialization.ShortDeserializer

org.apache.kafka.common.serialization.StringDeserializer

自定义反序列化器

反序列化器都需要实现

org.apache.kafka.common.serialization.Deserializer<T>

接⼝:

publicclassUserDeserializerimplementsDeserializer<User>{@Overridepublicvoidconfigure(Map<String,?> configs,boolean isKey){// do Nothing}@OverridepublicUserdeserialize(String topic,byte[] data){ByteBuffer allocate =ByteBuffer.allocate(data.length);

allocate.put(data);

allocate.flip();int userId = allocate.getInt();int length = allocate.getInt();String userName =newString(data,8, length);returnnewUser(userId, userName);}@Overridepublicvoidclose(){// do Nothing}}

消费者使用自定义反序列化器:

configs.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG,UserDeserializer.class);

2.2.2.4 拦截器

消费者在拉取了分区消息之后,要⾸先经过反序列化器对key和value进⾏反序列化处理。

处理完之后,如果消费端设置了拦截器,则需要经过拦截器的处理之后,才能返回给消费者应⽤程序进⾏处理。

消费端定义消息拦截器,需要实现

org.apache.kafka.clients.consumer.ConsumerInterceptor<K, V>

接⼝。

- ⼀个可插拔接⼝,允许拦截甚⾄更改消费者接收到的消息。⾸要的⽤例在于将第三⽅组件引⼊消费者应⽤程序,⽤于定制的监控、⽇志处理等.

- 该接⼝的实现类通过

configre⽅法获取消费者配置的属性,如果消费者配置中没有指定clientID,还可以获取KafkaConsumer⽣成的clientId。获取的这个配置是跟其他拦截器共享的,需要保证不会在各个拦截器之间产⽣冲突。 ConsumerInterceptor⽅法抛出的异常会被捕获、记录,但是不会向下传播。如果⽤户配置了错误的key或value类型参数,消费者不会抛出异常,⽽仅仅是记录下来。ConsumerInterceptor回调发⽣在org.apache.kafka.clients.consumer.KafkaConsumer#poll(long)⽅法同⼀个线程

该接⼝中有如下⽅法:

public interface ConsumerInterceptor<K, V> extends Configurable {

/**

* 该⽅法在poll⽅法返回之前调⽤。调⽤结束后poll⽅法就返回消息了。

*

* 该⽅法可以修改消费者消息,返回新的消息。拦截器可以过滤收到的消息或⽣成新的消息。

* 如果有多个拦截器,则该⽅法按照KafkaConsumer的configs中配置的顺序调⽤。

*

* @param records 由上个拦截器返回的由客户端消费的消息。

*/

public ConsumerRecords<K, V> onConsume(ConsumerRecords<K, V> records);

/**

* 当消费者提交偏移量时,调⽤该⽅法

* 该⽅法抛出的任何异常调⽤者都会忽略。

*/

public void onCommit(Map<TopicPartition, OffsetAndMetadata> offsets);

/**

* This is called when interceptor is closed

*/

public void close();

}

代码实现

自定义一个消费者拦截器:

public class OneInterceptor implements ConsumerInterceptor<String, String> {

@Override

public ConsumerRecords<String, String> onConsume(ConsumerRecords<String, String> records) {

// poll⽅法返回结果之前最后要调⽤的⽅法

System.out.println("自定义消费者拦截器,消息回来啦");

// 消息不做处理,直接返回

return records;

}

@Override

public void onCommit(Map<TopicPartition, OffsetAndMetadata> offsets) {

// 消费者提交偏移量的时候,经过该⽅法

System.out.println("自定义消费者拦截器,要提交偏移量啦");

}

@Override

public void close() {

// ⽤于关闭该拦截器⽤到的资源,如打开的⽂件,连接的数据库等

}

@Override

public void configure(Map<String, ?> configs) {

// ⽤于获取消费者的设置参数

configs.forEach((k, v) -> {

System.out.println(k + "\t" + v);

});

}

}

按照

OneInterceptor

拦截器复制两个拦截器,更名为

TwoInterceptor

、

ThreeInterceptor

消费者使用自定义拦截器:

config.setProperty(ConsumerConfig.INTERCEPTOR_CLASSES_CONFIG,com.edu.config.interceptor.OneInterceptor,com.edu.config.interceptor.TwoInterceptor,com.edu.config.interceptor.ThreeInterceptor);

2.2.2.5 位移提交

位移提交介绍:

- Consumer需要向Kafka记录⾃⼰的位移数据,这个汇报过程称为提交位移(

Committing Offsets) - Consumer 需要为分配给它的每个分区提交各⾃的位移数据

- 位移提交的由Consumer端负责的,Kafka只负责保管。

__consumer_offsets - 位移提交分为⾃动提交和⼿动提交

- 位移提交分为同步提交和异步提交

位移自动提交

Kafka Consumer 后台提交

- 开启⾃动提交:

enable.auto.commit=true - 配置⾃动提交间隔:Consumer端:

auto.commit.interval.ms,默认 5s

在消费者中设置自动提交和自动提交间隔:

Map<String,Object> configs =newHashMap<>();

configs.put("bootstrap.servers","192.168.0.102:9092");

configs.put("group.id","mygrp");// 设置偏移量⾃动提交。⾃动提交是默认值。这⾥做示例。

configs.put("enable.auto.commit","true");// 偏移量⾃动提交的时间间隔

configs.put("auto.commit.interval.ms","3000");

configs.put("key.deserializer",StringDeserializer.class);

configs.put("value.deserializer",StringDeserializer.class);KafkaConsumer<String,String> consumer =newKafkaConsumer<String,String>(configs);

Kafka会保证在开始调⽤poll⽅法时,提交上次poll返回的所有消息,因此⾃动提交不会出现消息丢失,但会重复消费

重复消费举例:

- Consumer 每 5s 提交 offset

- 假设提交 offset 后的 3s 发⽣了 Rebalance

- Rebalance 之后的所有 Consumer 从上⼀次提交的 offset 处继续消费

- 因此 Rebalance 发⽣前 3s 的消息会被重复消费

位移手动同步提交

- 使⽤

KafkaConsumer#commitSync():会提交KafkaConsumer#poll()返回的最新 offset - 该⽅法为同步操作,等待直到 offset 被成功提交才返回

- commitSync 在处理完所有消息之后

- ⼿动同步提交可以控制offset提交的时机和频率

while(true){ConsumerRecords<String,String> records = consumer.poll(Duration.ofSeconds(1));process(records);// 处理消息 try{

consumer.commitSync();}catch(CommitFailedException e){handle(e);// 处理提交失败异常 }}

⼿动同步提交会:

- 调⽤ commitSync 时,Consumer 处于阻塞状态,直到 Broker 返回结果

- 会影响 TPS

- 可以选择拉⻓提交间隔,但有以下问题 - 会导致 Consumer 的提交频率下降- Consumer 重启后,会有更多的消息被消费

位移手动异步提交

KafkaConsumer#commitAsync()

while(true){ConsumerRecords<String,String> records = consumer.poll(3_000);process(records);// 处理消息

consumer.commitAsync((offsets, exception)->{if(exception !=null){handle(exception);}});}

- commitAsync出现问题不会⾃动重试

手动异步提交不会自动重试的解决方案:

try{while(true){ConsumerRecords<String,String> records = consumer.poll(Duration.ofSeconds(1));process(records);// 处理消息 commitAysnc();// 使⽤异步提交规避阻塞 }}catch(Exception e){handle(e);// 处理异常}finally{try{

consumer.commitSync();// 最后⼀次提交使⽤同步阻塞式提交}finally{

consumer.close();}}

2.2.2.6 位移管理

Kafka中,消费者根据消息的位移顺序消费消息。

消费者的位移由消费者管理,可以存储于zookeeper中,也可以存储于Kafka主题

__consumer_offsets

中。

Kafka提供了消费者API,让消费者可以管理⾃⼰的位移。

KafkaConsumer<K, V>

的 API如下:

public void assign(Collection<TopicPartition> partitions): 给当前消费者⼿动分配⼀系列主题分区。 ⼿动分配分区不⽀持增量分配,如果先前有分配分区,则该操作会覆盖之前的分配。 如果给出的主题分区是空的,则等价于调⽤unsubscribe⽅法。 ⼿动分配主题分区的⽅法不使⽤消费组管理功能。当消费组成员变了,或者集群或主题的元数据改变了,不会触发分区分配的再平衡。 ⼿动分区分配assign(Collection)不能和⾃动分区分配subscribe(Collection,ConsumerRebalanceListener)⼀起使⽤。 如果启⽤了⾃动提交偏移量,则在新的分区分配替换旧的分区分配之前,会对旧的分区分配中的消费偏移量进⾏异步提交。public Set<TopicPartition> assignment(): 获取给当前消费者分配的分区集合。如果订阅是通过调⽤assign⽅法直接分配主题分区,则返回相同的集合。如果使⽤了主题订阅,该⽅法返回当前分配给该消费者的主题分区集合。如果分区订阅还没开始进⾏分区分配,或者正在重新分配分区,则会返回none。public Map<String, List<PartitionInfo>> listTopics(): 获取对⽤户授权的所有主题分区元数据。该⽅法会对服务器发起远程调⽤。public List<PartitionInfo> partitionsFor(String topic): 获取指定主题的分区元数据。如果当前消费者没有关于该主题的元数据,就会对服务器发起远程调⽤。public Map<TopicPartition, Long> beginningOffsets(Collection<TopicPartition> partitions): 对于给定的主题分区,列出它们第⼀个消息的偏移量。 注意,如果指定的分区不存在,该⽅法可能会永远阻塞。 该⽅法不改变分区的当前消费者偏移量。public void seekToEnd(Collection<TopicPartition> partitions): 将偏移量移动到每个给定分区的最后⼀个。 该⽅法延迟执⾏,只有当调⽤过poll⽅法或position⽅法之后才可以使⽤。 如果没有指定分区,则将当前消费者分配的所有分区的消费者偏移量移动到最后。 如果设置了隔离级别为:isolation.level=read_committed,则会将分区的消费偏移量移动到最后⼀个稳定的偏移量,即下⼀个要消费的消息现在还是未提交状态的事务消息。public void seek(TopicPartition partition, long offset)说明: 将给定主题分区的消费偏移量移动到指定的偏移量,即当前消费者下⼀条要消费的消息偏移量。 若该⽅法多次调⽤,则最后⼀次的覆盖前⾯的。 如果在消费中间随意使⽤,可能会丢失数据。public long position(TopicPartition partition): 检查指定主题分区的消费偏移量public void seekToBeginning(Collection<TopicPartition> partitions): 将给定每个分区的消费者偏移量移动到它们的起始偏移量。该⽅法懒执⾏,只有当调⽤过poll⽅法或position⽅法之后才会执⾏。如果没有提供分区,则将所有分配给当前消费者的分区消费偏移量移动到起始偏移量。

API 实战:

/**

* 消费者位移管理

*/publicclassMyConsumer2{publicstaticvoidmain(String[] args){Map<String,Object> config =newHashMap<>();

config.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG,"192.168.0.102:9092");

config.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG,StringDeserializer.class);

config.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG,StringDeserializer.class);

config.put(ConsumerConfig.GROUP_ID_CONFIG,"myGroup");KafkaConsumer<String,String> consumer =newKafkaConsumer<String,String>(config);// 给当前消费者⼿动分配⼀系列主题分区

consumer.assign(Arrays.asList(newTopicPartition("tp_demo_01",1)));// 获取给当前消费者分配的分区集合Set<TopicPartition> assignment = consumer.assignment();

assignment.forEach(topicPartition ->System.out.println(topicPartition));// 获取对⽤户授权的所有主题分区元数据。该⽅法会对服务器发起远程调⽤Map<String,List<PartitionInfo>> stringListMap = consumer.listTopics();

stringListMap.forEach((k, v)->{System.out.println("主题:"+ k);

v.forEach(info ->System.out.println(info));});Set<String> strings = consumer.listTopics().keySet();

strings.forEach(topicName ->System.out.println(topicName));// 获取指定主题的分区元数据List<PartitionInfo> partitionInfos = consumer.partitionsFor("tp_demo_01");for(PartitionInfo partitionInfo : partitionInfos){Node leader = partitionInfo.leader();System.out.println(leader);System.out.println(partitionInfo);// 当前分区在线副本Node[] nodes = partitionInfo.inSyncReplicas();// 当前分区下线副本Node[] nodes1 = partitionInfo.offlineReplicas();}// 对于给定的主题分区,列出它们第⼀个消息的偏移量。// 注意,如果指定的分区不存在,该⽅法可能会永远阻塞。// 该⽅法不改变分区的当前消费者偏移量。Map<TopicPartition,Long> topicPartitionLongMap = consumer.beginningOffsets(consumer.assignment());

topicPartitionLongMap.forEach((k, v)->{System.out.println("主题:"+ k.topic()+"\t分区:"+ k.partition()+"偏移量\t"+ v);});// 将偏移量移动到每个给定分区的最后⼀个。

consumer.seekToEnd(consumer.assignment());//将给定主题分区的消费偏移量移动到指定的偏移量,即当前消费者下⼀条要消费的消息偏移量。

consumer.seek(newTopicPartition("tp_demo_01",1),10);// 检查指定主题分区的消费偏移量long position = consumer.position(newTopicPartition("tp_demo_01",1));System.out.println(position);// 将偏移量移动到每个给定分区的最后⼀个。

consumer.seekToEnd(Arrays.asList(newTopicPartition("tp_demo_01",1)));// 关闭⽣产者

consumer.close();}}

2.2.2.7 重平衡

重平衡介绍

重平衡可以说是kafka为⼈诟病最多的⼀个点了。

重平衡其实就是⼀个协议,它规定了如何让消费者组下的所有消费者来分配topic中的每⼀个分区。⽐如⼀个topic有100个分区,⼀个消费者组内有20个消费者,在协调者的控制下让组内每⼀个消费者分配到5个分区,这个分配的过程就是重平衡。

如何进行组内分区分配:

三种分配策略:

RangeAssignor

和

RoundRobinAssignor

以及

StickyAssignor

谁来执⾏重均衡和消费组管理:

Kafka提供了⼀个⻆⾊:Group Coordinator来执⾏对于消费组的管理。

Group Coordinator——每个消费组分配⼀个消费组协调器(是一个broker)⽤于组管理和位移管理。当消费组的第⼀个消费者启动的时候,它会去和Kafka Broker确定谁是它们组的组协调器。之后该消费组内所有消费者和该组协调器协调通信。

如何确定coordinator:

- 确定消费组位移信息写⼊

__consumers_offsets的哪个分区。具体计算公式: _consumers_offsets partition# = Math.abs(groupId.hashCode() % groupMetadataTopicPartitionCount) 注意:groupMetadataTopicPartitionCount由offsets.topic.num.partitions指定,默认是50个分区。 - 该分区leader所在的broker就是组协调器。

重平衡的触发条件主要有三个:

- 消费者组内成员发⽣变更,这个变更包括了增加和减少消费者,⽐如消费者宕机退出消费组。

- 主题的分区数发⽣变更,kafka⽬前只⽀持增加分区,当增加的时候就会触发重平衡

- 订阅的主题发⽣变化,当消费者组使⽤正则表达式订阅主题,⽽恰好⼜新建了对应的主题,就会触发重平衡

消费者宕机,退出消费组,触发再平衡,重新给消费组中的消费者分配分区。

由于broker宕机,主题X的分区3宕机,此时分区3没有Leader副本,触发再平衡,消费者4没有对应的主题分区,则消费者4闲置

主题增加分区,需要主题分区和消费组进⾏再均衡。

由于使⽤正则表达式订阅主题,当增加的主题匹配正则表达式的时候,也要进⾏再均衡。

Rebalance Generation:

它表示Rebalance之后主题分区到消费组中消费者映射关系的⼀个版本,主要是⽤于保护消费组,隔离⽆效偏移量提交的。如上⼀个版本的消费者⽆法提交位移到新版本的消费组中,因为映射关系变了,你消费的或许已经不是原来的那个分区了。每次group进⾏Rebalance之后,Generation号都会加1,表示消费组和分区的映射关系到了⼀个新版本,如下图所示: Generation 1时group有3个成员,随后成员2退出组,消费组协调器触发Rebalance,消费组进⼊Generation 2,之后成员4加⼊,再次触发Rebalance,消费组进⼊Generation 3.

协议(protocol)

kafka提供了5个协议来处理与消费组协调相关的问题:

- Heartbeat请求:consumer需要定期给组协调器发送⼼跳来表明⾃⼰还活着

- LeaveGroup请求:主动告诉组协调器我要离开消费组

- SyncGroup请求:消费组Leader把分配⽅案告诉组内所有成员

- JoinGroup请求:成员请求加⼊组

- DescribeGroup请求:显示组的所有信息,包括成员信息,协议名称,分配⽅案,订阅信息等。通常该请求是给管理员使⽤

组协调器在再均衡的时候主要⽤到了前⾯4种请求。

liveness

消费者如何向消费组协调器证明⾃⼰还活着?

通过定时向消费组协调器发送Heartbeat请求。如果超过了设定的超时时间,那么协调器认为该消费者已经挂了。⼀旦协调器认为某个消费者挂了,那么它就会开启新⼀轮再均衡,并且在当前其他消费者的⼼跳响应中添加

“REBALANCE_IN_PROGRESS”

,告诉其他消费者:重新分配分区。

重平衡过程

重平衡分为2步:Join和Sync

- Join, 加⼊组。所有成员都向消费组协调器发送JoinGroup请求,请求加⼊消费组。⼀旦所有成员都发送了JoinGroup请求,协调器从中选择⼀个消费者担任Leader的⻆⾊,并把组成员信息以及订阅信息发给Leader。

- Sync,Leader开始分配消费⽅案,即哪个消费者负责消费哪些主题的哪些分区。⼀旦完成分配,Leader会将这个⽅案封装进SyncGroup请求中发给消费组协调器,⾮Leader也会发SyncGroup请求,只是内容为空。消费组协调器接收到分配⽅案之后会把⽅案塞进SyncGroup的response中发给各个消费者。

注意:在协调器收集到所有成员请求前,它会把已收到请求放⼊⼀个叫purgatory(炼狱)的地⽅。然后是分发分配⽅案的过程,即SyncGroup请求:

注意:消费组的分区分配⽅案在客户端执⾏。Kafka交给客户端可以有更好的灵活性。Kafka默认提供三种分配策略:range和round-robin和sticky。可以通过消费者的参数: partition.assignment.strategy 来实现⾃⼰分配策略。

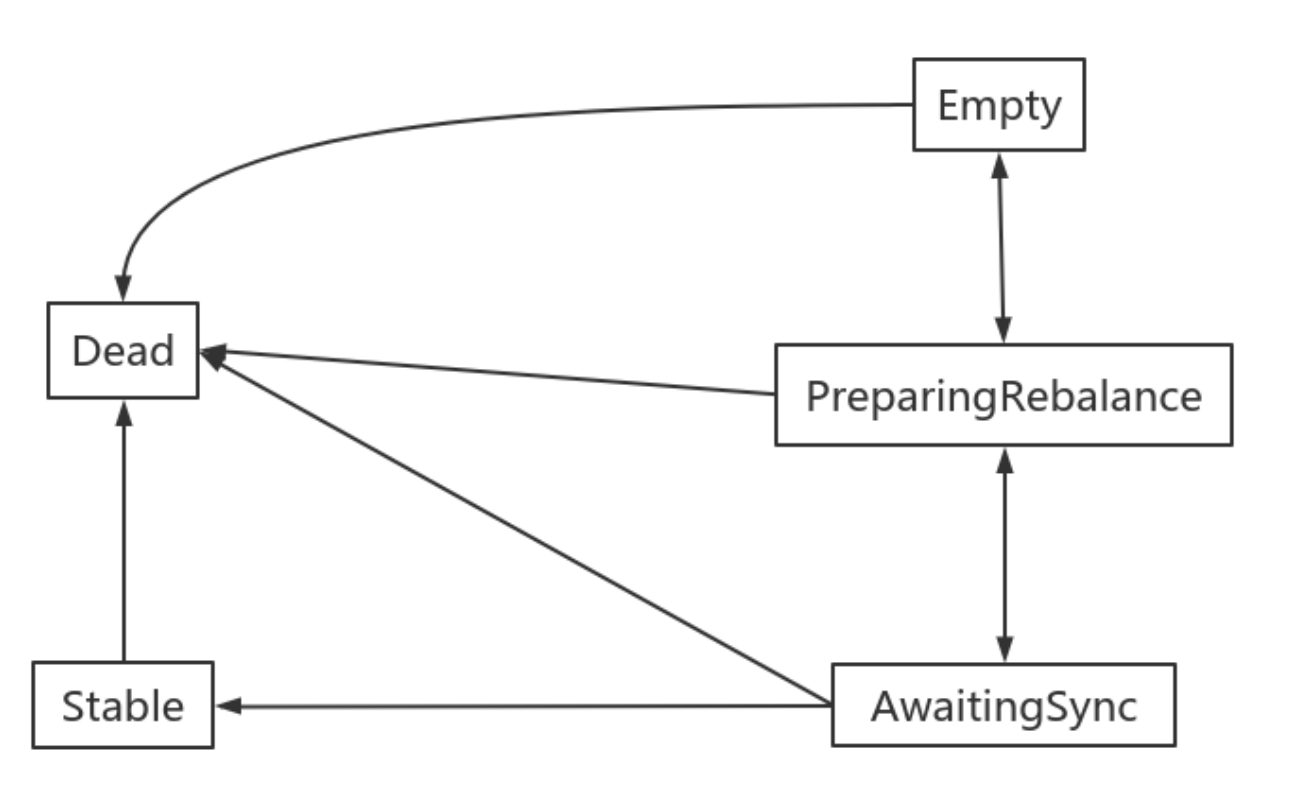

消费组状态机

消费组组协调器根据状态机对消费组做不同的处理:

说明:

- Dead:组内已经没有任何成员的最终状态,组的元数据也已经被组协调器移除了。这种状态响应各种请求都是⼀个response: UNKNOWN_MEMBER_ID

- Empty:组内⽆成员,但是位移信息还没有过期。这种状态只能响应JoinGroup请求

- PreparingRebalance:组准备开启新的rebalance,等待成员加⼊

- AwaitingSync:正在等待leader consumer将分配⽅案传给各个成员

- Stable:再均衡完成,可以开始消费。

避免重平衡

为什么说重平衡为⼈诟病呢?因为重平衡过程中,消费者⽆法从kafka消费消息,这对kafka的TPS影响极⼤,⽽如果kafka集群内节点较多,⽐如数百个,那重平衡可能会耗时极多。数分钟到数⼩时都有可能,⽽这段时间kafka基本处于不可⽤状态。所以在实际环境中,应该尽量避免重平衡发⽣。

不可能完全避免重平衡,因为你⽆法完全保证消费者不会故障。⽽消费者故障其实也是最常⻅的引发重平衡的地⽅,所以我们需要保证尽⼒避免消费者故障。

⽽其他⼏种触发重平衡的⽅式,增加分区,或是增加订阅的主题,抑或是增加消费者,更多的是主动控制。

如果消费者真正挂掉了,就没办法了,但实际中,会有⼀些情况,kafka错误地认为⼀个正常的消费者已经挂掉了,我们要的就是避免这样的情况出现。

⾸先要知道哪些情况会出现错误判断挂掉的情况。

在分布式系统中,通常是通过⼼跳来维持分布式系统的,kafka也不例外。

在分布式系统中,由于⽹络问题你不清楚没接收到⼼跳,是因为对⽅真正挂了还是只是因为负载过重没来得及发⽣⼼跳或是⽹络堵塞。所以⼀般会约定⼀个时间,超时即判定对⽅挂了。**⽽在kafka消费者场景中,

session.timout.ms

参数就是规定这个超时时间是多少**。

还有⼀个参数,**

heartbeat.interval.ms

,这个参数控制发送⼼跳的频率**,频率越⾼越不容易被误判,但也会消耗更多资源。

此外,还有最后⼀个参数,

max.poll.interval.ms

,消费者poll数据后,需要⼀些处理,再进⾏拉取。如果两次拉取时间间隔超过这个参数设置的值,那么消费者就会被踢出消费者组。也就是说,拉取,然后处理,这个处理的时间不能超过

max.poll.interval.ms

这个参数的值。这个参数的默认值是5分钟,⽽如果消费者接收到数据后会执⾏耗时的操作,则应该将其设置得⼤⼀些。

总结:

session.timout.ms控制⼼跳超时时间。heartbeat.interval.ms控制⼼跳发送频率。max.poll.interval.ms控制poll的间隔。

这⾥给出⼀个相对较为合理的配置,如下:

session.timout.ms:设置为6sheartbeat.interval.ms:设置2smax.poll.interval.ms:推荐为消费者处理消息最⻓耗时再加1分钟

2.2.3 消费组管理

2.2.3.1 消费者组的概念

consumer group是kafka提供的可扩展且具有容错性的消费者机制。

三个特性:

- 消费组有⼀个或多个消费者,消费者可以是⼀个进程,也可以是⼀个线程

group.id是⼀个字符串,唯⼀标识⼀个消费组- 对于一个消费组,其订阅的主题的每个分区只能被消费组中的⼀个消费者消费。

- 不同的消费组的消费者可以消费同一个主题的分区

2.2.3.2 消费者位移(consumer position)

消费者在消费的过程中记录已消费的数据,即消费位移(offset)信息。

每个消费组保存⾃⼰的位移信息,那么只需要简单的⼀个整数表示位置就够了;同时可以引⼊checkpoint机制定期持久化。

2.2.3.3 位移管理(offset management)

⾃动VS⼿动

Kafka默认定期⾃动提交位移(

enable.auto.commit

= true),也⼿动提交位移。另外kafka会定期把group消费情况保存起来,做成⼀个offset map,如下图所示:

位移提交

位移是提交到Kafka中的

__consumer_offsets

主题。

__consumer_offsets

中的消息保存了每个消费组某⼀时刻提交的offset信息。

__consumers_offsets 主题配置了compact策略,使得它总是能够保存最新的位移信息,既控制了该topic总体的⽇志容量,也能实现保存最新offset的⽬的。

2.3 主题

使⽤

kafka-topics.sh

脚本时可用的配置:

选项说明–config <String: name=value>为创建的或修改的主题指定配置信息。⽀持下述配置条⽬:

cleanup.policy``compression.type``delete.retention.ms``file.delete.delay.ms``flush.messages``flush.ms``follower.replication.throttled.replicas``index.interval.bytes``leader.replication.throttled.replicas``max.message.bytes``message.format.version``message.timestamp.difference.max.ms``message.timestamp.type``min.cleanable.dirty.ratio``min.compaction.lag.ms``min.insync.replicas``preallocate``retention.bytes``retention.ms``segment.bytes``segment.index.bytes``segment.jitter.ms``segment.ms``unclean.leader.election.enable

–create创建⼀个新主题–delete删除⼀个主题–delete-config <String: name>删除现有主题的⼀个主题配置条⽬。这些条⽬就是在

--config

中给出的配置条⽬。–alter更改主题的分区数量,副本分配和/或配置条⽬。–describe列出给定主题的细节–disable-rack-aware禁⽤副本分配的机架感知。–force抑制控制台提示信息–help打印帮助信息–if-exists如果指定了该选项,则在修改或删除主题的时候,只有主题存在才可以执⾏。–if-not-exists在创建主题的时候,如果指定了该选项,则只有主题不存在的时候才可以执⾏命令。–list列出所有可⽤的主题。–partitions <Integer: # of partitions>要创建或修改主题的分区数。–replica-assignment <String:broker_id_for_part1_replica1 :broker_id_for_part1_replica2,broker_id_for_part2_replica1 :broker_id_for_part2_replica2 , …>当创建或修改主题的时候⼿动指定partition-to-broker的分配关系。–replication-factor <Integer:replication factor>要创建的主题分区副本数。1表示只有⼀个副本,也就是Leader副本。–topic <String: topic>要创建、修改或描述的主题名称。除了创建,修改和描述在这⾥还可以使⽤正则表达式。–topics-with-overridesif set when describing topics, only show topics that haveoverridden configs–unavailable-partitionsif set when describing topics, only show partitions whoseleader is not available–under-replicated-partitionsif set when describing topics, only show under replicatedpartitions–zookeeper <String: urls>必需的参数:连接zookeeper的字符串,逗号分隔的多个host:port列表。多个URL可以故障转移。

主题中可以使⽤的参数定义(也就是上面

--config <String: name=value>

的参数):

属性默认值服务器默认属性说明cleanup.policydeletelog.cleanup.policy要么是”delete“要么是”compact“; 这个字符串指明了针对旧⽇志部分的利⽤⽅式;默认⽅式(“delete”)将会丢弃旧的部分当他们的回收时间或者尺⼨限制到达时。”compact“将会进⾏⽇志压缩compression.typenoneproducer⽤于压缩数据的压缩类型。默认是⽆压缩。正确的选项值是none、gzip、snappy。压缩最好⽤于批量处理,批量处理消息越多,压缩性能越好。delete.retention.ms86400000(24hours)log.cleaner.delete.retention.ms对于压缩⽇志保留的最⻓时间,也是客户端消费消息的最⻓时间,通log.retention.minutes的区别在于⼀个控制未压缩数据,⼀个控制压缩后的数据。此项配置可以在topic创建时的置顶参数覆盖flush.msNonelog.flush.interval.ms此项配置⽤来置顶强制进⾏fsync⽇志到磁盘的时间间隔;例如,如果设置为1000,那么每1000ms就需要进⾏⼀次fsync。⼀般不建议使⽤这个选项flush.messagesNonelog.flush.interval.messages此项配置指定时间间隔:强制进⾏fsync⽇志。例如,如果这个选项设置为1,那么每条消息之后都需要进⾏fsync,如果设置为5,则每5条消息就需要进⾏⼀次fsync。⼀般来说,建议你不要设置这个值。此参数的设置,需要在"数据可靠性"与"性能"之间做必要的权衡.如果此值过⼤,将会导致每次"fsync"的时间较⻓(IO阻塞),如果此值过⼩,将会导致"fsync"的次数较多,这也意味着整体的client请求有⼀定的延迟.物理server故障,将会导致没有fsync的消息丢失.index.interval.bytes4096log.index.interval.bytes默认设置保证了我们每4096个字节就对消息添加⼀个索引,更多的索引使得阅读的消息更加靠近,但是索引规模却会由此增⼤;⼀般不需要改变这个选项max.message.bytes1000000max.message.byteskafka追加消息的最⼤尺⼨。注意如果你增⼤这个尺⼨,你也必须增⼤你consumer的fetch 尺⼨,这样consumer才能fetch到这些最⼤尺⼨的消息。min.cleanable.dirty.ratio0.5min.cleanable.dirty.ratio此项配置控制log压缩器试图进⾏清除⽇志的频率。默认情况下,将避免清除压缩率超过50%的⽇志。这个⽐率避免了最⼤的空间浪费min.insync.replicas1min.insync.replicas当producer设置request.required.acks为-1时,min.insync.replicas指定replicas的最⼩数⽬(必须确认每⼀个repica的写数据都是成功的),如果这个数⽬没有达到,producer会产⽣异常。retention.bytesNonelog.retention.bytes如果使⽤“delete”的retention 策略,这项配置就是指在删除⽇志之前,⽇志所能达到的最⼤尺⼨。默认情况下,没有尺⼨限制⽽只有时间限制retention.ms7 dayslog.retention.minutes如果使⽤“delete”的retention策略,这项配置就是指删除⽇志前⽇志保存的时间。segment.bytes1Glog.segment.byteskafka中log⽇志是分成⼀块块存储的,此配置是指log⽇志划分成块的⼤⼩segment.index.bytes10MBlog.index.size.max.bytes此配置是有关offsets和⽂件位置之间映射的索引⽂件的⼤⼩;⼀般不需要修改这个配置segment.jitter.ms0log.roll.jitter.{ms,hours}The maximum jitter to subtract from logRollTimeMillis.segment.ms7 dayslog.roll.hours即使log的分块⽂件没有达到需要删除、压缩的⼤⼩,⼀旦log 的时间达到这个上限,就会强制新建⼀个log分块⽂件unclean.leader.election.enabletrue指明了是否能够使不在ISR中replicas设置⽤来作为leader

2.3.1 主题操作

创建主题

kafka-topics.sh --zookeeper localhost:2181/myKafka --create --topic tp_demo_02 --partitions 2 --replication-factor 1

kafka-topics.sh --zookeeper localhost:2181/myKafka --create --topic tp_demo_03 --partitions 3 --replication-factor 1 --config max.message.bytes=1048576 --config segment.bytes=10485760

查看主题

kafka-topics.sh --zookeeper localhost:2181/myKafka --list

kafka-topics.sh --zookeeper localhost:2181/myKafka --describe --topic tp_demo_02

kafka-topics.sh --zookeeper localhost:2181/myKafka --topics-with-overrides --describe

修改主题

kafka-topics.sh --zookeeper localhost:2181/myKafka --create --topic tp_demo_04 --partitions 4 --replication-factor 1

kafka-topics.sh --zookeeper localhost:2181/myKafka --alter --topic tp_demo_04 --config max.message.bytes=1048576

kafka-topics.sh --zookeeper localhost:2181/myKafka --describe --topic tp_demo_04

kafka-topics.sh --zookeeper localhost:2181/myKafka --alter --topic tp_demo_04 --config segment.bytes=10485760

kafka-topics.sh --zookeeper localhost:2181/myKafka --alter --delete-config max.message.bytes --topic tp_demo_04

删除主题

kafka-topics.sh --zookeeper localhost:2181/myKafka --delete --topic tp_demo_01

2.3.2 添加分区

通过命令⾏⼯具操作,主题的分区只能增加,不能减少。否则报错

通过–alter修改主题的分区数,增加分区。

kafka-topics.sh --zookeeper localhost:2181/myKafka --alter --topic tp_demo_02 --partitions 3

2.3.3 KafkaAdminClient 应用

说明:

除了使⽤Kafka的bin⽬录下的脚本⼯具来管理Kafka,还可以使⽤管理Kafka的API将某些管理查看的功能集成到系统中。在Kafka0.11.0.0版本之前,可以通过kafka-core包(Kafka的服务端,采⽤Scala编写)中的AdminClient和AdminUtils来实现部分的集群管理操作。Kafka0.11.0.0之后,⼜多了⼀个AdminClient,在kafka-client包下,⼀个抽象类,具体的实现是

org.apache.kafka.clients.admin.KafkaAdminClient

。

功能与原理介绍

Kafka官⽹:The AdminClient API supports managing and inspecting topics, brokers, acls, and other Kafka objects

KafkaAdminClient包含了⼀下⼏种功能(以Kafka1.0.2版本为准):

- 创建主题

createTopics(final Collection<NewTopic> newTopics, final CreateTopicsOptions options) - 删除主题

deleteTopics(final Collection<String> topicNames, DeleteTopicsOptions options) - 列出所有主题

listTopics(final ListTopicsOptions options) - 查询主题

describeTopics(final Collection<String> topicNames, DescribeTopicsOptions options) - 查询集群信息

describeCluster(DescribeClusterOptions options) - 查询配置信息

describeConfigs(Collection<ConfigResource> configResources, final DescribeConfigsOptions options) - 修改配置信息

alterConfigs(Map<ConfigResource, Config> configs, final AlterConfigsOptions options) - 修改副本的日志记录

alterReplicaLogDirs(Map<TopicPartitionReplica, String> replicaAssignment, final AlterReplicaLogDirsOptions options) - 查询节点的⽇志⽬录信息

describeLogDirs(Collection<Integer> brokers, DescribeLogDirsOptions options) - 查询副本的⽇志⽬录信息

describeReplicaLogDirs(Collection<TopicPartitionReplica> replicas, DescribeReplicaLogDirsOptions options) - 增加分区

createPartitions(Map<String, NewPartitions> newPartitions, final CreatePartitionsOptions options)

其内部原理是使⽤Kafka⾃定义的⼀套⼆进制协议来实现,详细可以参⻅Kafka协议。

KafkaAdminClient

⽤到的参数:

属性说明重要性bootstrap.servers向Kafka集群建⽴初始连接⽤到的host/port列表。 客户端会使⽤这⾥列出的所有服务器进⾏集群其他服务器的发现,⽽不管是否指定了哪个服务器⽤作引导。 这个列表仅影响⽤来发现集群所有服务器的初始主机。 字符串形式:host1:port1,host2:port2,… 由于这组服务器仅⽤于建⽴初始链接,然后发现集群中的所有服务器,因此没有必要将集群中的所有地址写在这⾥。 ⼀般最好两台,以防其中⼀台宕掉。highclient.id⽣产者发送请求的时候传递给broker的id字符串。 ⽤于在broker的请求⽇志中追踪什么应⽤发送了什么消息。 ⼀般该id是跟业务有关的字符串。mediumconnections.max.idle.ms当连接空闲时间达到这个值,就关闭连接。long型数据,默认:300000mediumreceive.buffer.bytesTCP接收缓存(SO_RCVBUF),如果设置为-1,则使⽤操作系统默认的值。int类型值,默认65536,可选值:[-1,…]mediumrequest.timeout.ms客户端等待服务端响应的最⼤时间。如果该时间超时,则客户端要么重新发起请求,要么如果重试耗尽,请求失败。int类型值,默认:120000mediumsecurity.protocol跟broker通信的协议:PLAINTEXT, SSL, SASL_PLAINTEXT, SASL_SSL.string类型值,默认:PLAINTEXTmediumsend.buffer.bytes⽤于TCP发送数据时使⽤的缓冲⼤⼩(SO_SNDBUF),-1表示使⽤OS默认的缓冲区⼤⼩。 int类型值,默认值:131072mediumreconnect.backoff.max.ms对于每个连续的连接失败,每台主机的退避将成倍增加,直⾄达到此最⼤值。在计算退避增量之后,添加20%的随机抖动以避免连接⻛暴。 long型值,默认1000,可选值:[0,…]lowreconnect.backoff.ms重新连接主机的等待时间。避免了重连的密集循环。该等待时间应⽤于该客户端到broker的所有连接。 long型值,默认:50lowretriesThe maximum number of times to retry a call before failing it.重试的次数,达到此值,失败。 int类型值,默认5。lowretry.backoff.ms在发⽣失败的时候如果需要重试,则该配置表示客户端等待多⻓时间再发起重试。 该时间的存在避免了密集循环。 long型值,默认值:100。low

主要操作步骤:

客户端根据⽅法的调⽤创建相应的协议请求,⽐如创建Topic的createTopics⽅法,其内部就是发送CreateTopicRequest请求。

客户端发送请求⾄Kafka Broker。

Kafka Broker处理相应的请求并回执,⽐如与CreateTopicRequest对应的是CreateTopicResponse。客户端接收相应的回执并进⾏解析处理。

和协议有关的请求和回执的类基本都在org.apache.kafka.common.requests包中,AbstractRequest和AbstractResponse是这些请求和响应类的两个⽗类。

综上,如果要⾃定义实现⼀个功能,只需要三个步骤:

- ⾃定义XXXOptions;

- ⾃定义XXXResult返回值;

- ⾃定义Call,然后挑选合适的XXXRequest和XXXResponse来实现Call类中的3个抽象⽅法。

2.3.4 偏移量管理

Kafka 1.0.2,__consumer_offsets主题中保存各个消费组的偏移量。

早期由zookeeper管理消费组的偏移量。

查询⽅法:

通过原⽣ kafka 提供的⼯具脚本进⾏查询。

⼯具脚本的位置与名称为bin/kafka-consumer-groups.sh

⾸先运⾏脚本,查看帮助:

参数说明–all-topics将所有关联到指定消费组的主题都划归到reset-offsets操作范围。–bootstrap-server<String:server to connectto>必须:(基于消费组的新的消费者): 要连接的服务器地址。–by-duration<String: duration>距离当前时间戳的⼀个时间段。格式:‘PnDTnHnMnS’–commandconfig<String:command configproperty file>指定配置⽂件,该⽂件内容传递给Admin Client和消费者。–delete传值消费组名称,删除整个消费组与所有主题的各个分区偏移量和所有者关系。 如:–group g1 --group g2。 传值消费组名称和单个主题,仅删除该消费组到指定主题的分区偏移量和所属关系。 如:–group g1 --group g2 --topic t1。 传值⼀个主题名称,仅删除指定主题与所有消费组分区偏移量以及所属关系。 如:–topic t1 注意:消费组的删除仅对基于ZK保存偏移量的消费组有效,并且要⼩⼼使⽤,仅删除不活跃的消费组。–describe描述给定消费组的偏移量差距(有多少消息还没有消费)。–execute执⾏操作。⽀持的操作:reset-offsets。–export导出操作的结果到CSV⽂件。⽀持的操作:reset-offsets。–from-file<String: path toCSV file>重置偏移量到CSV⽂件中定义的值。–group <String:consumer group>⽬标消费组–list列出所有消费组。–new-consumer使⽤新的消费者实现。这是默认值。随后的发⾏版中会删除这⼀操作。–reset-offsets重置消费组的偏移量。当前⼀次操作只⽀持⼀个消费组,并且该消费组应该是不活跃的。 有三个操作选项 1.(默认)plan:要重置哪个偏移量。 2. execute:执⾏reset-offsets操作。 3. process:配合–export将操作结果导出到CSV格式。 可以使⽤如下选项: --to-datetime --by-period --to-earliest --to-latest --shift-by --from-file --to-current 必须选择⼀个选项使⽤。 要定义操作的范围,使⽤: --all-topics --topic。 必须选择⼀个,除⾮使⽤–from-file选项。–shift-by<Long: number-of-offsets>重置偏移量n个。n可以是正值,也可以是负值。–timeout<Long: timeout(ms)>对某些操作设置超时时间。 如:对于描述指定消费组信息,指定毫秒值的最⼤等待时间,以获取正常数据(如刚创建的消费组,或者消费组做了⼀些更改操作)。默认时间:5000。–to-current重置到当前的偏移量。–to-datetime<String: datetime>重置偏移量到指定的时间戳。格式:‘YYYY-MM-DDTHH:mm:SS.sss’–to-earliest重置为最早的偏移量–to-latest重置为最新的偏移量–to-offset<Long: offset>重置到指定的偏移量。

--topic<String:topic>

指定哪个主题的消费组需要删除,或者指定哪个主题的消费组需要包含到resetoffsets操作中。对于reset-offsets操作,还可以指定分区:topic1:0,1,2。其中0,1,2表示要包含到操作中的分区号。重置偏移量的操作⽀持多个主题⼀起操作。–zookeeper<String: urls>必须,它的值,你懂的。–zookeeper localhost:2181/myKafka。

由于kafka 消费者记录group的消费偏移量有两种⽅式 :

- kafka ⾃维护 (新)

- zookpeer 维护 (旧) ,已经逐渐被废弃

所以 ,脚本只查看由broker维护的,由zookeeper维护的可以将–bootstrap-server换成–zookeeper即可。

查看有那些 group ID 正在进⾏消费

kafka-consumer-groups.sh --bootstrap-server localhost:9092 --list

注意:

- 这⾥⾯是没有指定 topic,查看的是所有topic消费者的 group.id 的列表。

- 注意: 重名的 group.id 只会显示⼀次

**查看指定group.id 的消费者消费情况 **

kafka-consumer-groups.sh --bootstrap-server node1:9092 --describe --group group

2.4 分区

2.4.1 副本机制

Kafka在⼀定数量的服务器上对主题分区进⾏复制。

当集群中的⼀个broker宕机后系统可以⾃动故障转移到其他可⽤的副本上,不会造成数据丢失。

创建主题:

kafka-topics.sh --zookeeper localhost:2181/myKafka --create --topic tp_demo_02 --partitions 2 --replication-factor 31.

上面创建主题中的

--replication-factor 3

表示有3个副本,1个Leader + 2个 Follower

- 将复制因⼦为1的未复制主题称为复制主题。

- 主题的分区是复制的最⼩单元。

- 在⾮故障情况下,Kafka中的每个分区都有⼀个Leader副本和零个或多个Follower副本。

- 包括Leader副本在内的副本总数构成复制因⼦。

- 所有读取和写⼊都由Leader副本负责。

- 通常,分区⽐broker多,并且Leader分区在broker之间平均分配

Follower分区像普通的Kafka消费者⼀样,消费来⾃Leader分区的消息,并将其持久化到⾃⼰的⽇志中。

允许Follower对⽇志条⽬拉取进⾏批处理。

同步节点定义:

- 节点必须能够维持与ZooKeeper的会话(通过ZooKeeper的⼼跳机制)

- 对于Follower副本分区,它复制在Leader分区上的写⼊,并且不要延迟太多

Kafka提供的保证是,只要有⾄少⼀个同步副本处于活动状态,提交的消息就不会丢失。

宕机如何恢复:

- 少部分副本宕机 当leader宕机了,会从follower选择⼀个作为leader。当宕机的重新恢复时,会把之前commit的数据清空,重新从leader⾥pull数据。

- 全部副本宕机 当全部副本宕机了有两种恢复⽅式 - 等待ISR中的⼀个恢复后,并选它作为leader。(等待时间较⻓,降低可⽤性)- 选择第⼀个恢复的副本作为新的leader,⽆论是否在ISR中。(并未包含之前leader commit的数据,因此造成数据丢失)

2.4.2 Leader 选举

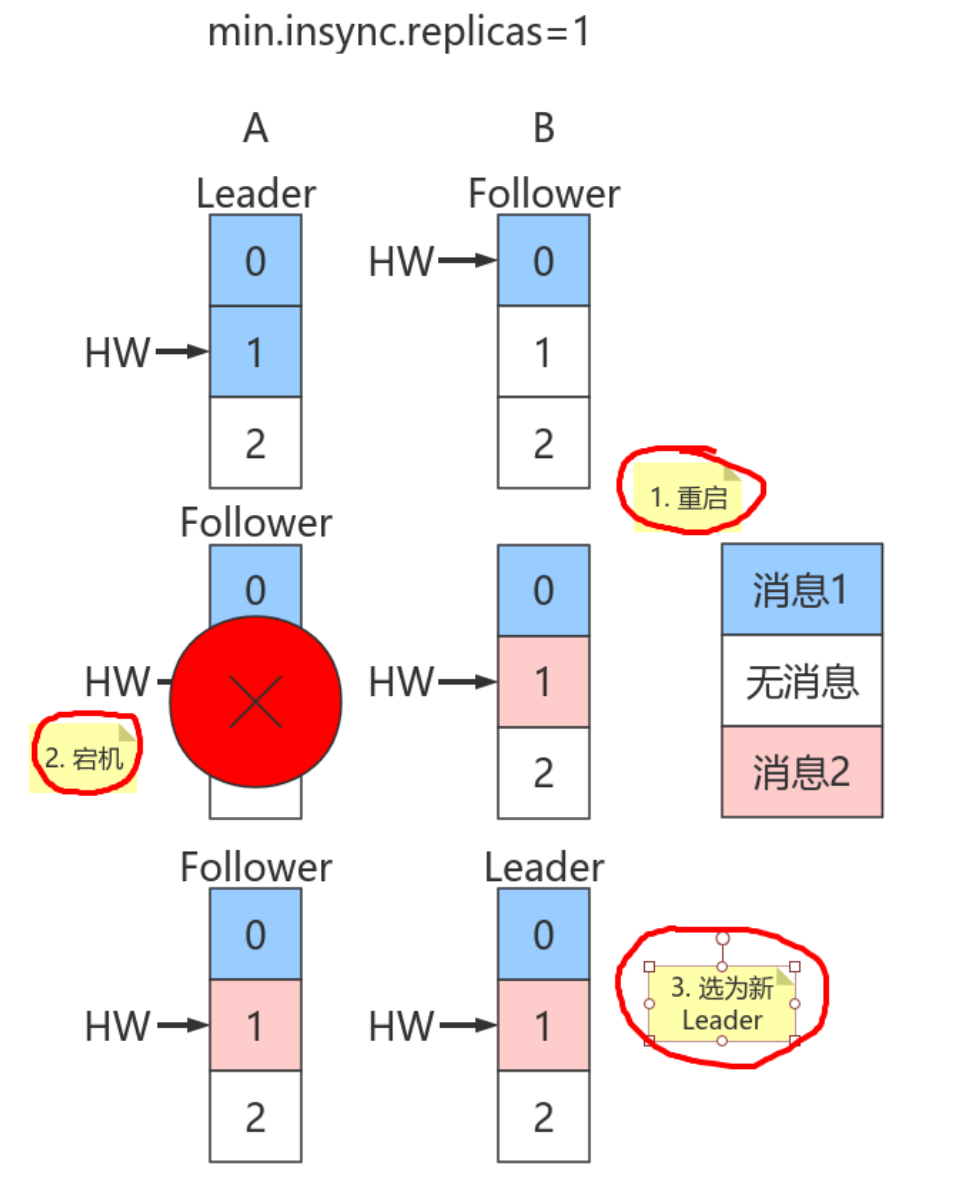

如下图,在这张图片中:

- 分区P1的Leader是0,ISR是0和1

- 分区P2的Leader是2,ISR是1和2

- 分区P3的Leader是1,ISR是0,1,2。

⽣产者和消费者的请求都由Leader副本来处理。Follower副本只负责消费Leader副本的数据和Leader保持同步。

对于P1,如果0宕机会发⽣什么?

Leader副本和Follower副本之间的关系并不是固定不变的,在Leader所在的broker发⽣故障的时候,就需要进⾏分区的Leader副本和Follower副本之间的切换,需要选举Leader副本。

如何选举?

如果某个分区所在的服务器除了问题,不可⽤,kafka会从该分区的其他的副本中选择⼀个作为新的Leader。之后所有的读写就会转移到这个新的Leader上。现在的问题是应当选择哪个作为新的Leader。

只有那些跟Leader保持同步的Follower才应该被选作新的Leader。

Kafka会在Zookeeper上针对每个Topic维护⼀个称为ISR(in-sync replica,已同步的副本)的集合,该集合中是⼀些分区的副本。

只有当这些副本都跟Leader中的副本同步了之后,kafka才会认为消息已提交,并反馈给消息的⽣产者。

如果这个集合有增减,kafka会更新zookeeper上的记录。

如果某个分区的Leader不可⽤,Kafka就会从ISR集合中选择⼀个副本作为新的Leader。

显然通过ISR,kafka需要的冗余度较低,可以容忍的失败数⽐较⾼。

假设某个分区有N+1个副本,kafka可以容忍N个服务器不可⽤。

为什么不⽤少数服从多数的⽅法

少数服从多数是⼀种⽐较常⻅的⼀致性算发和Leader选举法。

它的含义是只有超过半数的副本同步了,系统才会认为数据已同步;

选择Leader时也是从超过半数的同步的副本中选择。

这种算法需要较⾼的冗余度,跟Kafka⽐起来,浪费资源。

譬如只允许⼀台机器失败,需要有三个副本;⽽如果只容忍两台机器失败,则需要五个副本。

⽽kafka的ISR集合⽅法,分别只需要两个和三个副本。

如果所有的ISR副本都失败了怎么办?

此时有两种⽅法可选:

- 等待ISR集合中的副本复活,

- 选择任何⼀个⽴即可⽤的副本,⽽这个副本不⼀定是在ISR集合中。

- 需要设置

unclean.leader.election.enable=true

这两种⽅法各有利弊,实际⽣产中按需选择。

如果要等待ISR副本复活,虽然可以保证⼀致性,但可能需要很⻓时间。⽽如果选择⽴即可⽤的副本,则很可能该副本并不⼀致。

总结:

Kafka中Leader分区选举,通过维护⼀个动态变化的ISR集合来实现,⼀旦Leader分区丢掉,则从ISR中随机挑选⼀个副本做新的Leader分区。

如果ISR中的副本都丢失了,则:

- 可以等待ISR中的副本任何⼀个恢复,接着对外提供服务,需要时间等待。

- 从OSR中选出⼀个副本做Leader副本,此时会造成数据丢失

2.4.3 分区重新分配

向已经部署好的Kafka集群⾥⾯添加机器,我们需要从已经部署好的Kafka节点中复制相应的配置⽂件,然后把⾥⾯的broker id修改成全局唯⼀的,最后启动这个节点即可将它加⼊到现有Kafka集群中(同一个集群中所有节点的ClusterId相同)。

问题:新添加的Kafka节点并不会⾃动地分配数据,⽆法分担集群的负载,除⾮我们新建⼀个topic。

需要⼿动将部分分区移到新添加的Kafka节点上,Kafka内部提供了相关的⼯具来重新分布某个topic的分区。

**使⽤Kafka⾃带的

kafka-reassign-partitions.sh

⼯具来重新分布分区。该⼯具有三种使⽤模式:**

- generate模式,给定需要重新分配的Topic,⾃动⽣成reassign plan(并不执⾏)

- execute模式,根据指定的reassign plan重新分配Partition

- verify模式,验证重新分配Partition是否成功

借助kafka-reassign-partitions.sh⼯具⽣成reassign plan,需要先定义⼀个⽂件,⾥⾯说明哪些topic需要重新分区,⽂件内容如下

[root@node1 ~]# cat topics-to-move.json

{

"topics": [

{ "topic":"tp_re_01" }

],

"version":1

}

然后使⽤kafka-reassign-partitions.sh⼯具⽣成reassign plan

[root@node1 ~]# kafka-reassign-partitions.sh --zookeeper node1:2181/myKafka --topicsto-move-json-file topics-to-move.json --broker-list "0,1" --generate

Current partition replica assignment

{"version":1,"partitions":[{"topic":"tp_re_01","partition":4,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":1,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":2,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":3,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":0,"replicas":[0],"log_dirs":["any"]}]}

Proposed partition reassignment configuration

{"version":1,"partitions":[{"topic":"tp_re_01","partition":4,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":1,"replicas":[1],"log_dirs":["any"]},{"topic":"tp_re_01","partition":2,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":3,"replicas":[1],"log_dirs":["any"]},{"topic":"tp_re_01","partition":0,"replicas":[0],"log_dirs":["any"]}]}

Proposed partition reassignment configuration下⾯⽣成的就是将分区重新分布的结果。

将这些内容保存到名为result.json⽂件⾥⾯(⽂件名不重要,⽂件格式也不⼀定要以json为结尾,只要保证内容是json即可),replicas就是对应分区的brokerId,如果不符合要求可以自己修改

然后执⾏这些reassign plan:

[root@node1 ~]# kafka-reassign-partitions.sh --zookeeper node1:2181/myKafka --reassignment-json-file topics-to-execute.json --execute

Current partition replica assignment

{"version":1,"partitions":[{"topic":"tp_re_01","partition":4,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":1,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":2,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":3,"replicas":[0],"log_dirs":["any"]},{"topic":"tp_re_01","partition":0,"replicas":[0],"log_dirs":["any"]}]}

Save this to use as the --reassignment-json-file option during rollback

Successfully started reassignment of partitions.

2.4.4 自动再平衡

可以在新建主题的时候,⼿动指定主题各个Leader分区以及Follower分区的分配情况,即什么分区副本在哪个broker节点上

执⾏脚本:

[root@node11 ~]# kafka-topics.sh --zookeeper node1:2181/myKafka --create --topic tp_demo_03 --replica-assignment "0:1,1:0,0:1"

上述脚本执⾏的结果是:创建了主题tp_demo_03,有三个分区,每个分区两个副本,Leader副本在列表中第⼀个指定的brokerId上,Follower副本在随后指定的brokerId上。

但是当0号机宕机后,所有Leader分区都会在1号上,当0号机重启后,Leader分区还是都会在1号上

随着系统的运⾏,broker的宕机重启,会引发Leader分区和Follower分区的⻆⾊转换,最后可能Leader⼤部分都集中在少数⼏台broker上,由于Leader负责客户端的读写操作,此时集中Leader分区的少数⼏台服务器的⽹络I/O,CPU,以及内存都会很紧张。

Kafka提供的⾃动再均衡脚本:

kafka-preferred-replica-election.sh

可以让Kafka⾃动帮我们让集群恢复到初始的副本分配

该⼯具会让每个分区的Leader副本分配在合适的位置,让Leader分区和Follower分区在服务器之间均衡分配。

如果该脚本仅指定zookeeper地址,则会对集群中所有的主题进⾏操作,⾃动再平衡。

具体操作:

- 创建preferred-replica.json,内容如下:

{

"partitions": [

{

"topic":"tp_demo_03",

"partition":0

},

{

"topic":"tp_demo_03",

"partition":1

},

{

"topic":"tp_demo_03",

"partition":2

}

]

}

- 执⾏操作:

[root@node1 ~]# kafka-preferred-replica-election.sh --zookeeper node1:2181/myKafka --path-to-json-file preferred-replicas.json

- 查看操作的结果

[root@node1 ~]# kafka-topics.sh --zookeeper node1:2181/myKafka --describe --topic tp_demo_03

Topic:tp_demo_03 PartitionCount:3 ReplicationFactor:2 Configs:

Topic: tp_demo_03 Partition: 0 Leader: 0 Replicas: 0,1 Isr: 1,0

Topic: tp_demo_03 Partition: 1 Leader: 1 Replicas: 1,0 Isr: 1,0

Topic: tp_demo_03 Partition: 2 Leader: 0 Replicas: 0,1 Isr: 1,0

[root@node1 ~]#1.2.3.4.5.6.

恢复到最初的分配情况。

2.4.5 修改分区副本

实际项⽬中,我们可能由于主题的副本因⼦设置的问题,需要重新设置副本因⼦

或者由于集群的扩展,需要重新设置副本因⼦。

topic⼀旦使⽤⼜不能轻易删除重建,因此动态增加副本因⼦就成为最终的选择。

说明:kafka 1.0版本配置⽂件默认没有default.replication.factor=x, 因此如果创建topic时,不指定-replication-factor 默认副本因⼦为1. 我们可以在⾃⼰的server.properties中配置上常⽤的副本因⼦,省去⼿动调整。例如设置default.replication.factor=3, 详细内容可参考官⽅⽂档https://kafka.apache.org/documentation/#replication

原因分析:

假设我们有2个kafka broker分别broker0,broker1。

- 当我们创建的topic有2个分区partition时并且replication-factor为1,基本上⼀个broker上⼀个分区。当⼀个broker宕机了,该topic就⽆法使⽤了,因为两个分区只有⼀个能⽤。

- 当我们创建的topic有3个分区partition时并且replication-factor为2时,可能分区数据分布情况是 broker0, partiton0,partiton1,partiton2, broker1, partiton1,partiton0,partiton2, 每个分区有⼀个副本,当其中⼀个broker宕机了,kafka集群还能完整凑出该topic的两个分区,例如当broker0宕机了,可以通过broker1组合出topic的两个分区。

- 创建主题

[root@node1 ~]# kafka-topics.sh --zookeeper node1:2181/myKafka --create --topic tp_re_02 --partitions 3 --replication-factor 1

- 查看主题细节

[root@node1 ~]# kafka-topics.sh --zookeeper node1:2181/myKafka --describe --topic tp_re_02

Topic:tp_re_02 PartitionCount:3 ReplicationFactor:1 Configs:

Topic: tp_re_02 Partition: 0 Leader: 1 Replicas: 1 Isr: 1

Topic: tp_re_02 Partition: 1 Leader: 0 Replicas: 0 Isr: 0

Topic: tp_re_02 Partition: 2 Leader: 1 Replicas: 1 Isr: 1

使⽤

kafka-reassign-partitions.sh

修改副本因⼦:

- 创建increment-replication-factor.json

{

"version":1,

"partitions":[

{"topic":"tp_re_02","partition":0,"replicas":[0,1]},

{"topic":"tp_re_02","partition":1,"replicas":[0,1]},

{"topic":"tp_re_02","partition":2,"replicas":[1,0]}

]

}

- 执⾏分配

[root@node1 ~]# kafka-reassign-partitions.sh --zookeeper node1:2181/myKafka --reassignment-json-file increase-replication-factor.json --execute

- 查看主题细节

[root@node1 ~]# kafka-topics.sh --zookeeper node1:2181/myKafka --describe --topic tp_re_02

Topic:tp_re_02 PartitionCount:3 ReplicationFactor:2 Configs:

Topic: tp_re_02 Partition: 0 Leader: 1 Replicas: 0,1 Isr: 1,0

Topic: tp_re_02 Partition: 1 Leader: 0 Replicas: 0,1 Isr: 0,1

Topic: tp_re_02 Partition: 2 Leader: 1 Replicas: 1,0 Isr: 1,0

2.4.6 分区分配策略

在Kafka中,每个Topic会包含多个分区,默认情况下⼀个分区只能被⼀个消费组下⾯的⼀个消费者消费,这⾥就产⽣了分区分配的问题。Kafka中提供了多重分区分配算法(PartitionAssignor)的实现:RangeAssignor、RoundRobinAssignor、StickyAssignor。

消费组的成员订阅它们感兴趣的Topic并将这种订阅关系传递给作为订阅组协调者的Broker。协调者选择其中的⼀个消费者来执⾏这个消费组的分区分配并将分配结果转发给消费组内所有的消费者。Kafka默认采⽤RangeAssignor的分配算法。

2.4.6.1 RangeAssignor

RangeAssignor对每个Topic进⾏独⽴的分区分配。对于每⼀个Topic,⾸先对分区按照分区ID进⾏数值排序,然后订阅这个Topic的消费组的消费者再进⾏字典排序,之后尽量均衡的将分区分配给消费者。这⾥只能是尽量均衡,因为分区数可能⽆法被消费者数量整除,那么有⼀些消费者就会多分配到⼀些分区。

⼤致算法如下:

assign(topic, consumers) {

// 对分区和Consumer进⾏排序

List<Partition> partitions = topic.getPartitions();

sort(partitions);

sort(consumers);

// 计算每个Consumer分配的分区数

int numPartitionsPerConsumer = partition.size() / consumers.size();

// 额外有⼀些Consumer会多分配到分区

int consumersWithExtraPartition = partition.size() % consumers.size();

// 计算分配结果

for (int i = 0, n = consumers.size(); i < n; i++) {

// 第i个Consumer分配到的分区的index

int start = numPartitionsPerConsumer * i + Math.min(i, consumersWithExtraPartition);

// 第i个Consumer分配到的分区数

int length = numPartitionsPerConsumer + (i + 1 > consumersWithExtraPartition ? 0 : 1);

// 分装分配结果

assignment.get(consumersForTopic.get(i)).addAll(partitions.subList(start, start + length));

}

}

RangeAssignor策略的原理是按照消费者总数和分区总数进⾏整除运算来获得⼀个跨度,然后将分区按照跨度进⾏平均分配,以保证分区尽可能均匀地分配给所有的消费者。对于每⼀个Topic,RangeAssignor策略会将消费组内所有订阅这个Topic的消费者按照名称的字典序排序,然后为每个消费者划分固定的分区范围,如果不够平均分配,那么字典序靠前的消费者会被多分配⼀个分区。

这种分配⽅式明显的⼀个问题是随着消费者订阅的Topic的数量的增加,不均衡的问题会越来越严重,⽐如上图中4个分区3个消费者的场景,C0会多分配⼀个分区。如果此时再订阅⼀个分区数为4的Topic,那么C0⼜会⽐C1、C2多分配⼀个分区,这样C0总共就⽐C1、C2多分配两个分区了,⽽且随着Topic的增加,这个情况会越来越严重。

字典序靠前的消费组中的消费者⽐较“贪婪”。

2.4.6.2 RoundRobinAssignor

RoundRobinAssignor的分配策略是将消费组内订阅的所有Topic的分区及所有消费者进⾏排序后尽量均衡的分配(RangeAssignor是针对单个Topic的分区进⾏排序分配的)。如果消费组内,消费者订阅的Topic列表是相同的(每个消费者都订阅了相同的Topic),那么分配结果是尽量均衡的(消费者之间分配到的分区数的差值不会超过1)。如果订阅的Topic列表是不同的,那么分配结果是不保证“尽量均衡”的,因为某些消费者不参与⼀些Topic的分配。

相对于RangeAssignor,在订阅多个Topic的情况下,RoundRobinAssignor的⽅式能消费者之间尽量均衡的分配到分区(分配到的分区数的差值不会超过1——RangeAssignor的分配策略可能随着订阅的Topic越来越多,差值越来越⼤)。

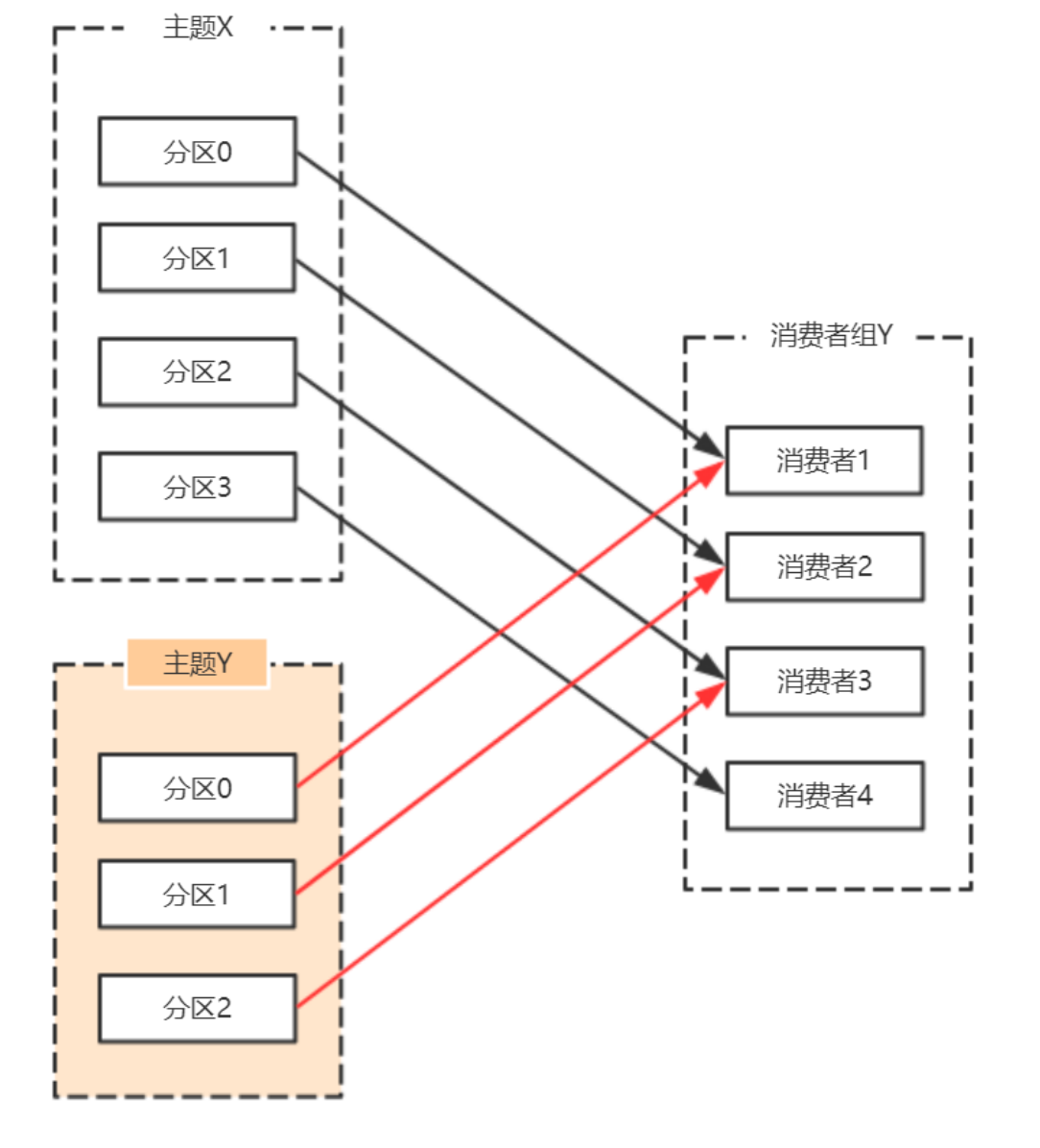

对于消费组内消费者订阅Topic不⼀致的情况:假设有两个个消费者分别为C0和C1,有2个Topic T1、T2,分别拥有3和2个分区,并且C0订阅T1和T2,C1订阅T2,那么RoundRobinAssignor的分配结果如下:

看上去分配已经尽量的保证均衡了,不过可以发现C0承担了4个分区的消费⽽C1订阅了T2⼀个分区,是不是把T2P0交给C1消费能更加的均衡呢?

2.4.6.3 StickyAssignor

动机

尽管RoundRobinAssignor已经在RangeAssignor上做了⼀些优化来更均衡的分配分区,但是在⼀些情况下依旧会产⽣严重的分配偏差,⽐如消费组中订阅的Topic列表不相同的情况下。

更核⼼的问题是⽆论是RangeAssignor,还是RoundRobinAssignor,当前的分区分配算法都没有考虑上⼀次的分配结果。显然,在执⾏⼀次新的分配之前,如果能考虑到上⼀次分配的结果,尽量少的调整分区分配的变动,显然是能节省很多开销的。

目标

从字⾯意义上看,Sticky是“粘性的”,可以理解为分配结果是带“粘性的”:

- 分区的分配尽量的均衡

- 每⼀次重分配的结果尽量与上⼀次分配结果保持⼀致

当这两个⽬标发⽣冲突时,优先保证第⼀个⽬标。第⼀个⽬标是每个分配算法都尽量尝试去完成的,⽽第⼆个⽬标才真正体现出StickyAssignor特性的。

我们先来看预期分配的结构,后续再具体分析StickyAssignor的算法实现。

例如:

- 有3个Consumer:C0、C1、C2

- 有4个Topic:T0、T1、T2、T3,每个Topic有2个分区

- 所有Consumer都订阅了这4个主题

StickyAssignor的分配结果如下图所示(增加RoundRobinAssignor分配作为对⽐):

如果消费者1宕机,则按照RoundRobin的⽅式分配结果如下。打乱从新来过,轮询分配:

按照Sticky的⽅式。仅对消费者1分配的分区进⾏重分配,红线部分。最终达到均衡的⽬的:

再举⼀个例⼦:

- 有3个Consumer:C0、C1、C2

- 3个Topic:T0、T1、T2,它们分别有1、2、3个分区

- C0订阅T0;C1订阅T0、T1;C2订阅T0、T1、T2

分配结果如下图所示

消费者0下线,则按照轮询的⽅式分配:

按照Sticky⽅式分配分区,仅仅需要动的就是红线部分,其他部分不动

StickyAssignor分配⽅式的实现稍微复杂点⼉,我们可以先理解图示部分即可。感兴趣的同学可以研究⼀下。

2.4.6.4 自定义分区策略

PartitionAssignor接⼝⽤于⽤户定义实现分区分配算法,以实现Consumer之间的分区分配。

⾃定义的分配策略必须要实现org.apache.kafka.clients.consumer.internals.PartitionAssignor接⼝。PartitionAssignor接⼝的定义如下:

Subscriptionsubscription(Set<String> topics);Stringname();Map<String,Assignment>assign(Cluster metadata,Map<String,Subscription> subscriptions);voidonAssignment(Assignment assignment);classSubscription{privatefinalList<String> topics;privatefinalByteBuffer userData;}classAssignment{privatefinalList<TopicPartition> partitions;privatefinalByteBuffer userData;}

PartitionAssignor接⼝中定义了两个内部类:Subscription和Assignment。

Subscription类⽤来表示消费者的订阅信息,类中有两个属性:topics和userData,分别表示消费者所订阅topic列表和⽤户⾃定义信息。PartitionAssignor接⼝通过subscription()⽅法来设置消费者⾃身相关的Subscription信息,注意到此⽅法中只有⼀个参数topics,与Subscription类中的topics的相互呼应,但是并没有有关userData的参数体现。为了增强⽤户对分配结果的控制,可以在subscription()⽅法内部添加⼀些影响分配的⽤户⾃定义信息赋予userData,⽐如:权重、ip地址、host或者机架(rack)等等。

Assignment类,它是⽤来表示分配结果信息的,类中也有两个属性:partitions和userData,分别表示所分配到的分区集合和⽤户⾃定义的数据。可以通过PartitionAssignor接⼝中的onAssignment()⽅法是在每个消费者收到消费组leader分配结果时的回调函数,例如在StickyAssignor策略中就是通过这个⽅法保存当前的分配⽅案,以备在下次消费组重平衡(rebalance)时可以提供分配参考依据。

接⼝中的name()⽅法⽤来提供分配策略的名称,对于Kafka提供的3种分配策略⽽⾔,RangeAssignor对应的protocol_name为“range”,RoundRobinAssignor对应的protocol_name为“roundrobin”,StickyAssignor对应的protocol_name为“sticky”,所以⾃定义的分配策略中要注意命名的时候不要与已存在的分配策略发⽣冲突。这个命名⽤来标识分配策略的名称。

真正的分区分配⽅案的实现是在assign()⽅法中,⽅法中的参数metadata表示集群的元数据信息,⽽subscriptions表示消费组内各个消费者成员的订阅信息,最终⽅法返回各个消费者的分配信息。

Kafka中还提供了⼀个抽象类org.apache.kafka.clients.consumer.internals.AbstractPartitionAssignor,它可以简化PartitionAssignor接⼝的实现,对assign()⽅法进⾏了实现,其中会将Subscription中的userData信息去掉后,在进⾏分配。Kafka提供的3种分配策略都是继承⾃这个抽象类。如果开发⼈员在⾃定义分区分配策略时需要使⽤userData信息来控制分区分配的结果,那么就不能直接继承AbstractPartitionAssignor这个抽象类,⽽需要直接实现PartitionAssignor接⼝。

自定义分区策略

packageorg.apache.kafka.clients.consumer;importorg.apache.kafka.clients.consumer.internals.AbstractPartitionAssignor;importorg.apache.kafka.common.TopicPartition;importjava.util.*;publicclassMyAssignorextendsAbstractPartitionAssignor{}

在使⽤时,消费者客户端需要添加相应的Properties参数,示例如下:

properties.put(ConsumerConfig.PARTITION_ASSIGNMENT_STRATEGY_CONFIG,MyAssignor.class.getName());

2.5 存储

2.5.1 日志存储

2.5.1.1 日志概念

Kafka 消息是以主题为单位进⾏归类,各个主题之间是彼此独⽴的,互不影响;每个主题⼜可以分为⼀个或多个分区;每个分区各⾃存在⼀个记录消息数据的⽇志⽂件。

如果创建了⼀个 demo_01 主题,其存在6个 Parition,对应到物理文件在日志路径下就有demo_01-0、demo_01-1、demo_01-2、demo_01-3、demo_01-4、demo_01-5 六个分区文件

在理想情况下,数据流量分摊到各个 Parition 中,实现了负载均衡的效果。在分区⽇志⽂件中,你会发现很多类型的⽂件,⽐如: .index、.timestamp、.log、.snapshot 等。

⽂件名⼀致的⽂件集合称为 LogSement

LogSegment

- 分区⽇志⽂件中包含很多的 LogSegment

- Kafka ⽇志追加是顺序写⼊的

- LogSegment 可以减⼩⽇志⽂件的⼤⼩

- 进⾏⽇志删除的时候和数据查找的时候可以快速定位。

- ActiveLogSegment 是活跃的⽇志分段,拥有⽂件拥有写⼊权限,其余的 LogSegment 只有只读的权限。

⽇志⽂件存在多种后缀⽂件,重点需要关注 .index、.timestamp、.log 三种类型。

类别作⽤

后缀名****说明.index偏移量索引⽂件.timestamp时间戳索引⽂件.log⽇志⽂件.snapshot快照⽂件.deleted要删除的文件.cleaned⽇志清理时临时⽂件.swap⽇志压缩之后的临时⽂件leader-epoch-checkpoint

⽇志与索引⽂件

配置条⽬默认值说明log.index.interval.bytes4096(4K)增加索引项字节间隔密度,会影响索引⽂件中的区间密度和查询效率log.segment.bytes1073741824(1G)⽇志⽂件最⼤值log.roll.ms当前⽇志分段中消息的最⼤时间戳与当前系统的时间戳的差值允许的最⼤范围,单位毫秒log.roll.hours168(7天)当前⽇志分段中消息的最⼤时间戳与当前系统的时间戳的差值允许的最⼤范围,单位⼩时log.index.size.max.bytes10485760(10MB)触发偏移量索引⽂件或时间戳索引⽂件分段字节限额

配置项默认值说明

- 偏移量索引⽂件⽤于记录消息偏移量与物理地址之间的映射关系。

- 时间戳索引⽂件则根据时间戳查找对应的偏移量。

- Kafka 中的索引⽂件是以稀疏索引的⽅式构造消息的索引,并不保证每⼀个消息在索引⽂件中都有对应的索引项。

- 每当写⼊⼀定量的消息时,偏移量索引⽂件和时间戳索引⽂件分别增加⼀个偏移量索引项和时间戳索引项。

- 通过修改 log.index.interval.bytes 的值,改变索引项的密度。

2.5.1.2 .index文件

偏移量索引⽂件⽤于记录消息偏移量与物理地址之间的映射关系。

- log⽇志默认每写⼊4K(log.index.interval.bytes设定的),会写⼊⼀条索引信息到index⽂件中,因此索引⽂件是稀疏索引,它不会为每条⽇志都建⽴索引信息。

- 索引⽂件的数据结构则是由相对offset(4byte)+position(4byte)组成,由于保存的是相对第⼀个消息的相对offset,只需要4byte就可以了,可以节省空间,在实际查找后还需要计算回实际的offset,这对⽤户是透明的。

- 稀疏索引,索引密度不⾼,但是offset有序,⼆分查找的时间复杂度为O(lgN),如果从头遍历时间复杂度是O(N)

- 可以通过

kafka-run-class.sh kafka.tools.DumpLogSegments --files 00000000000000000000.index -- print-data-log | head来查看索引文件 - offset 与 position 没有直接关系,因为会删除数据和清理⽇志

- 在偏移量索引⽂件中,索引数据都是顺序记录 offset

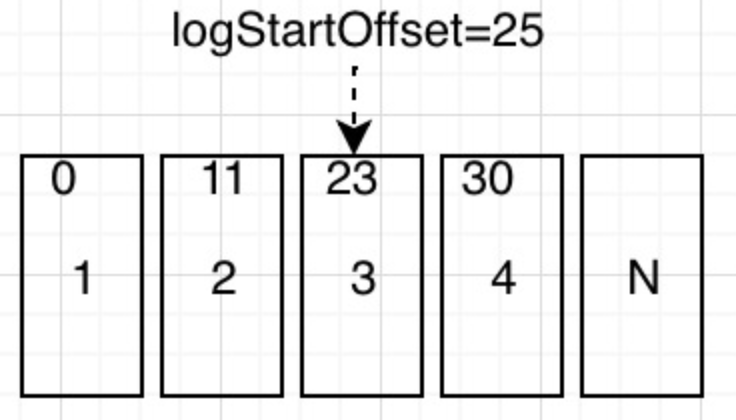

2.5.1.3 .timestamp文件