在我们使用selenium请求网页时,有时不想从浏览器解析后的html标签获取数据,如果能直接获取url返回的json格式数据会更容易解析。就像request和scrapy爬虫返回的响应数据一样。那么,我们用selenium应该怎么做呢?

selenium并不支持获取响应的数据,我们可以使用selenium-wire库,selenium-wire扩展了 Selenium 的 Python 绑定,可以访问浏览器发出的底层请求。 编写的代码与 Selenium 的方式相同。

- 安装selenium-wire库:

pip install selenium-wire

- 修改引入方式

# from selenium import webdriver

from seleniumwire import webdriver

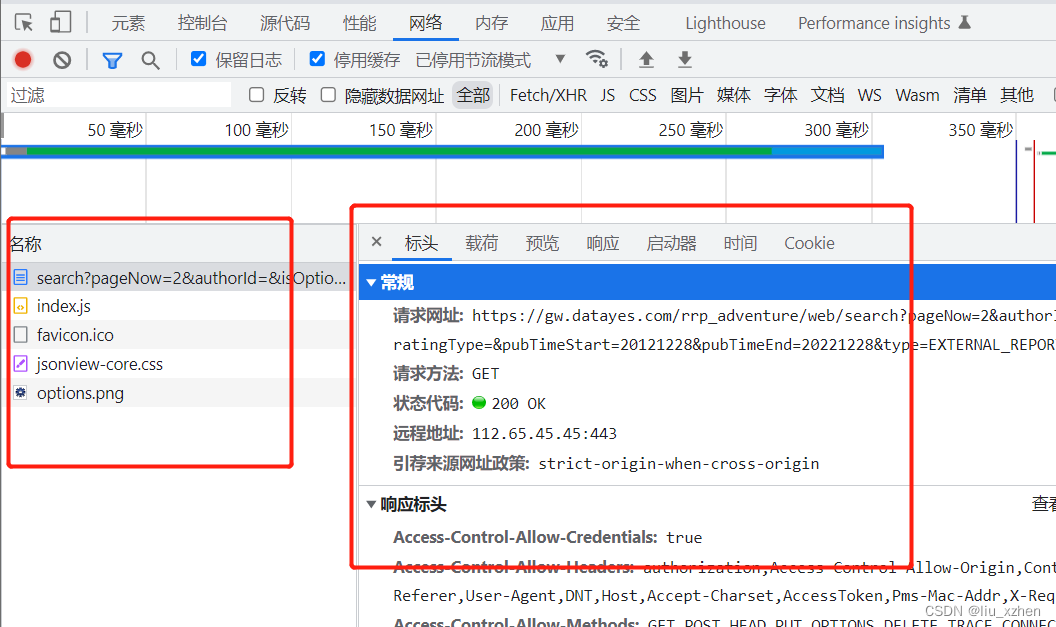

- 获取网络响应的内容,也就是如图部分的url响应:

driver.requests

- 解析返回的响应头

driver.requests返回的是一个列表,遍历每个url来获取想要的url响应信息。一下示例演示如果获取指定url的请求头,获取到的请求头可以直接使用request发送请求。

# 提取接口的请求信息

get_conver_header = {}

get_conver_url = ""

for request in driver.requests:

if "https://coXXX.com/api/" in request.url:

get_conver_url = request.url

for header_key in request.headers:

get_conver_header[header_key] = request.headers[header_key]

break

- 获取返回响应体

from io import BytesIO

import gzip

# 清空之前获取的请求信息

del driver.requests

# 获取响应体的内容数据

rp_body = driver.requests[0].response.body

# 获取到的编码为byte数据,需要解码为utf-8,直接解码会报错

# UnicodeDecodeError: 'utf-8' codec can't decode byte 0x8b in position 1: invalid start byte

# print输出的字节码是以"b’\x1f\x8b\x08"开头的,说明它是gzip压缩过的数据,所以我们要对字节码进行一个解码操作

buff = BytesIO(rp_body)

f = gzip.GzipFile(fileobj=buff)

htmls = f.read().decode('utf-8')

print(htmls)

本文转载自: https://blog.csdn.net/liu_xzhen/article/details/128470821

版权归原作者 liu_xzhen 所有, 如有侵权,请联系我们删除。

版权归原作者 liu_xzhen 所有, 如有侵权,请联系我们删除。