1.1创建Hadoop 用户(简单)

1.2 安装 Hadoop 前的准备工作(如果网络没问题就很简单)

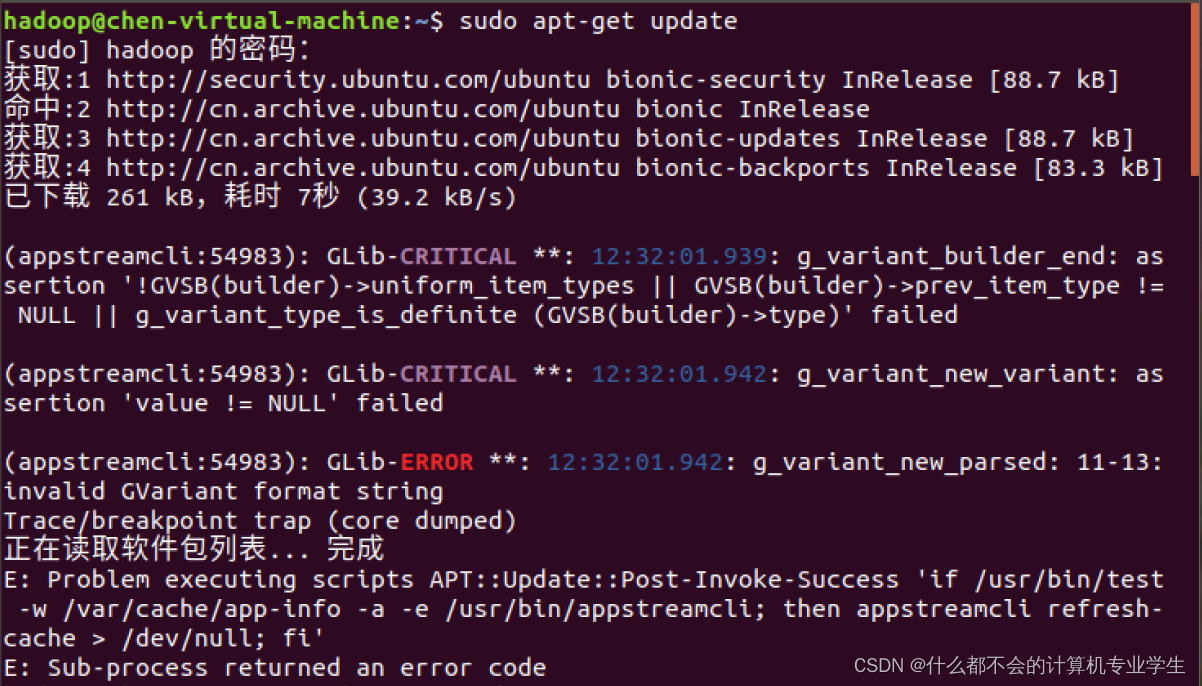

1.2.1 更新 APT

需要输入登录hadoop账户的密码,1.1中设置的

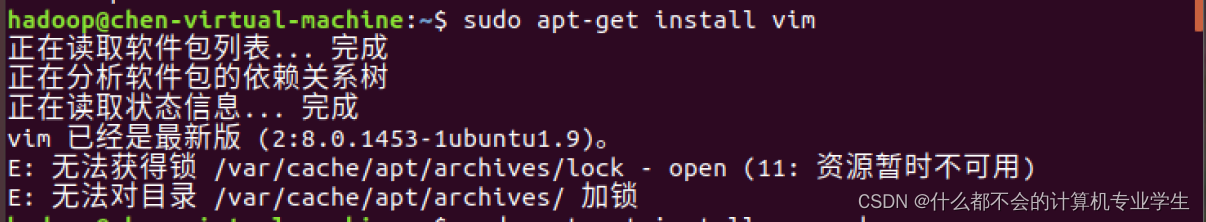

1.2.2 安装vim编辑器

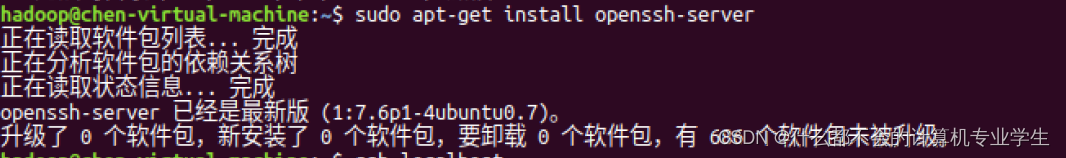

1.2.3安装 SSH

$ sudo apt-get install openssh-server #安装SSH服务端

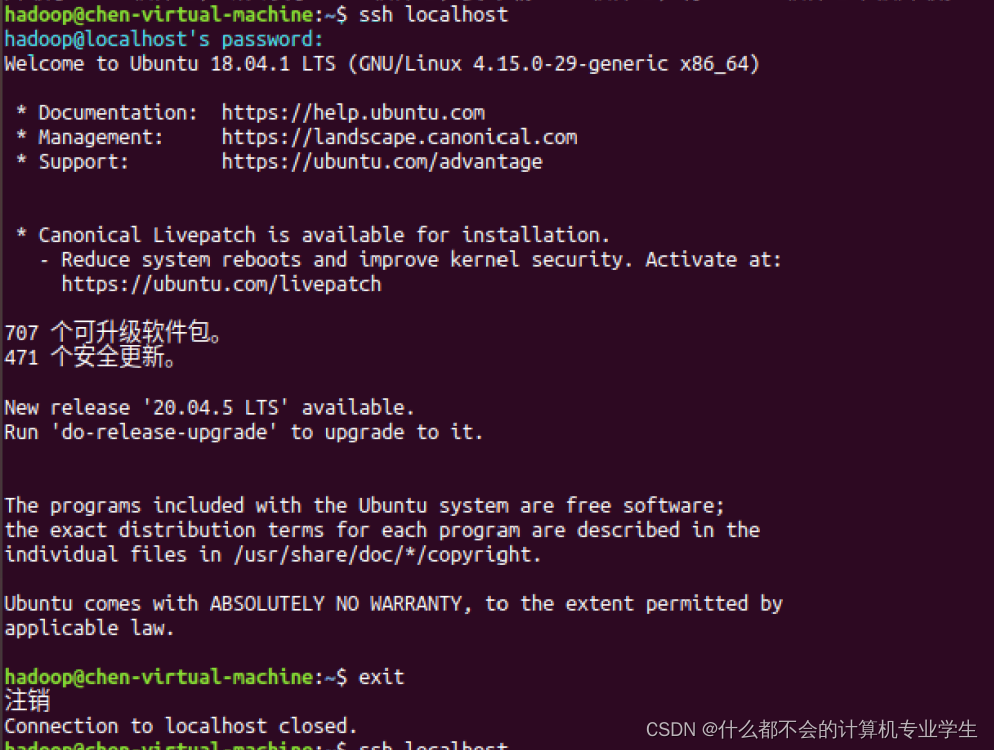

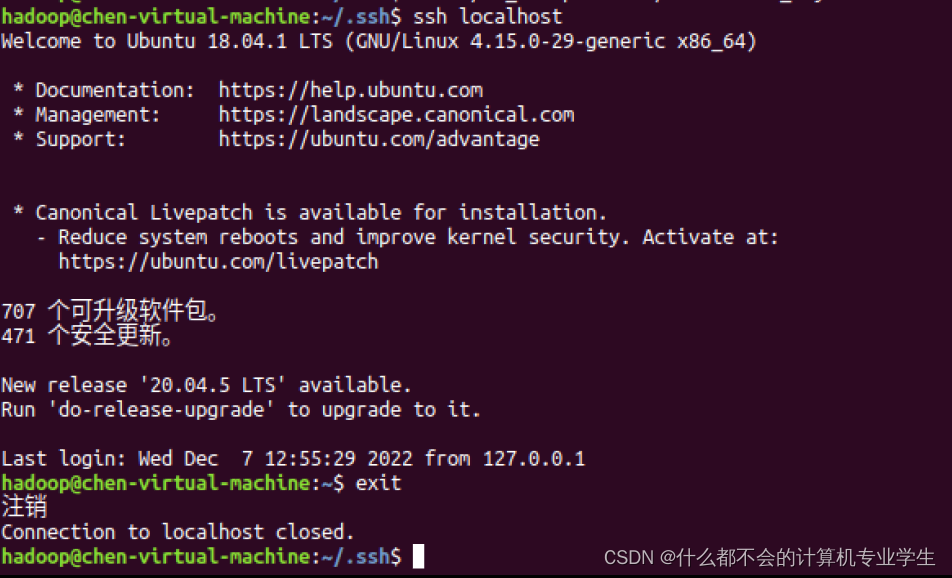

安装后,可以使用如下命令登录本机:

$ ssh localhost #登录需要密码,exit退出登录

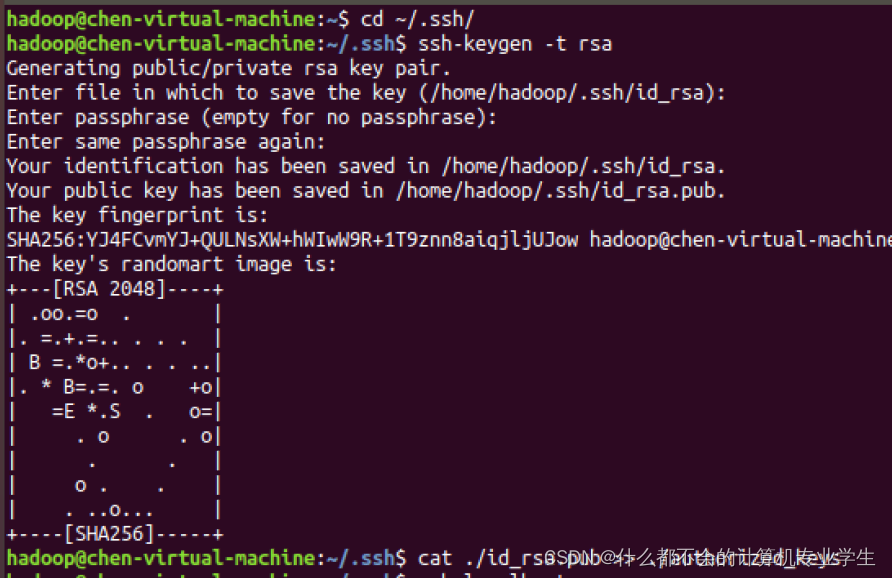

免密登录:利用ssh-keygen生成密钥,并将密钥加入到授权中,命令如下:

$exit

$ cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

$ ssh-keygen -t rsa # 会有提示,都按回车即可(:后边都敲回车)

$ cat ./id_rsa.pub >> ./authorized_keys # 加入授权

此时,再执行ssh localhost命令,无需输入密码就可以直接登录了。

1.3 安装 Java 环境

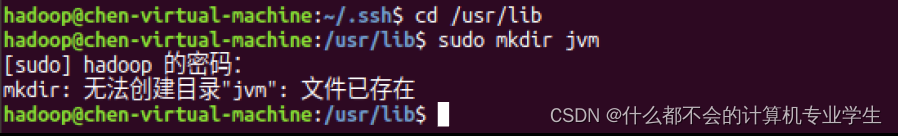

执行如下命令创建/usr/lib/jvm目录用来存放JDK文件:

$ cd /usr/lib

$ sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

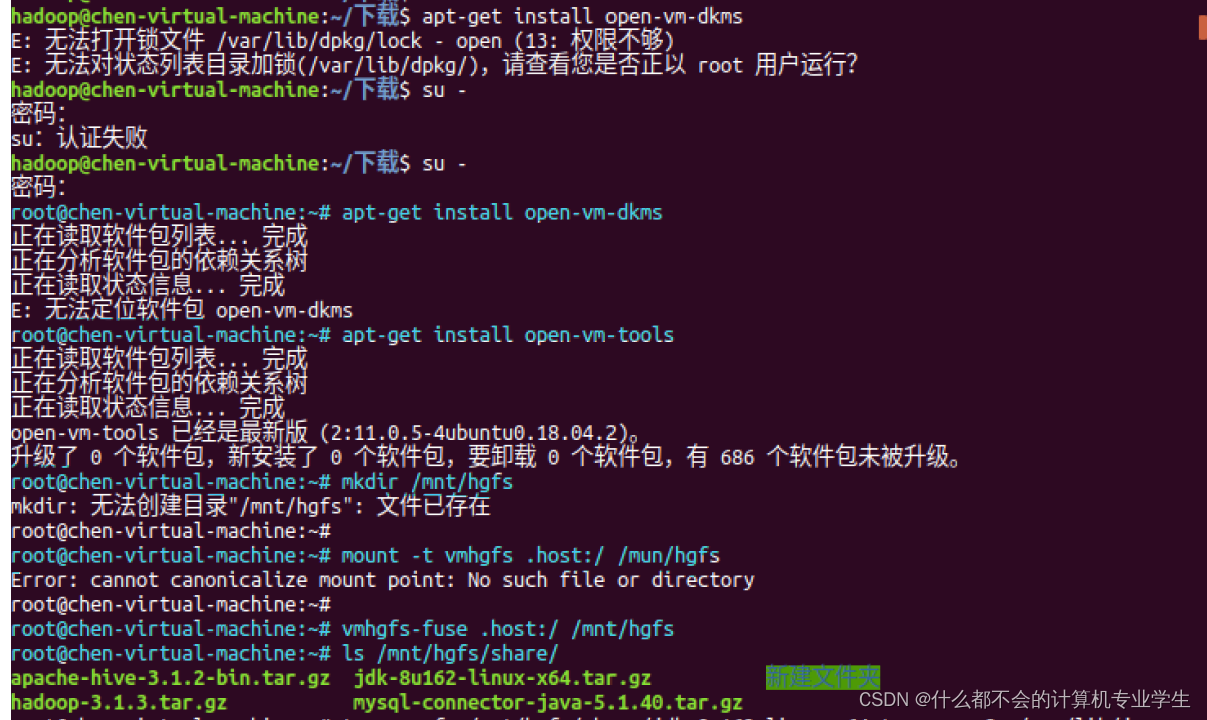

执行如下命令对安装文件进行解压缩:(提前设置好共享文件夹或者设置双向粘贴,直接把压缩包粘到Ubuntu中)

我也有总结---原文链接:https://blog.csdn.net/m0_59865073/article/details/128192013

$ cd ~ #进入stu用户的主目录

$ cd Downloads #切换到压缩包所在目录

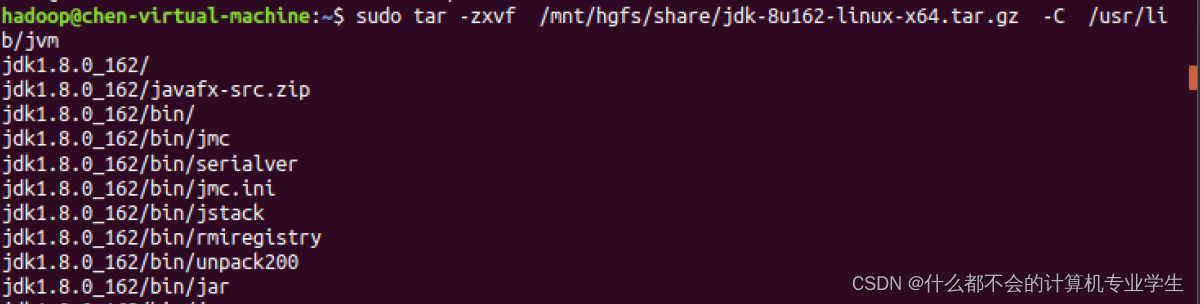

$ sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm

以上两步操作的代码运行截图:(挂载共享文件夹)

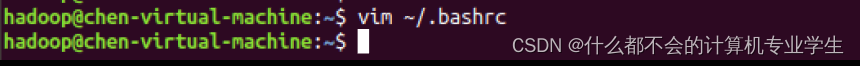

下面继续执行如下命令,设置环境变量:

$ vim ~/.bashrc

如果vim使用不熟悉,同学们可以使用gedit

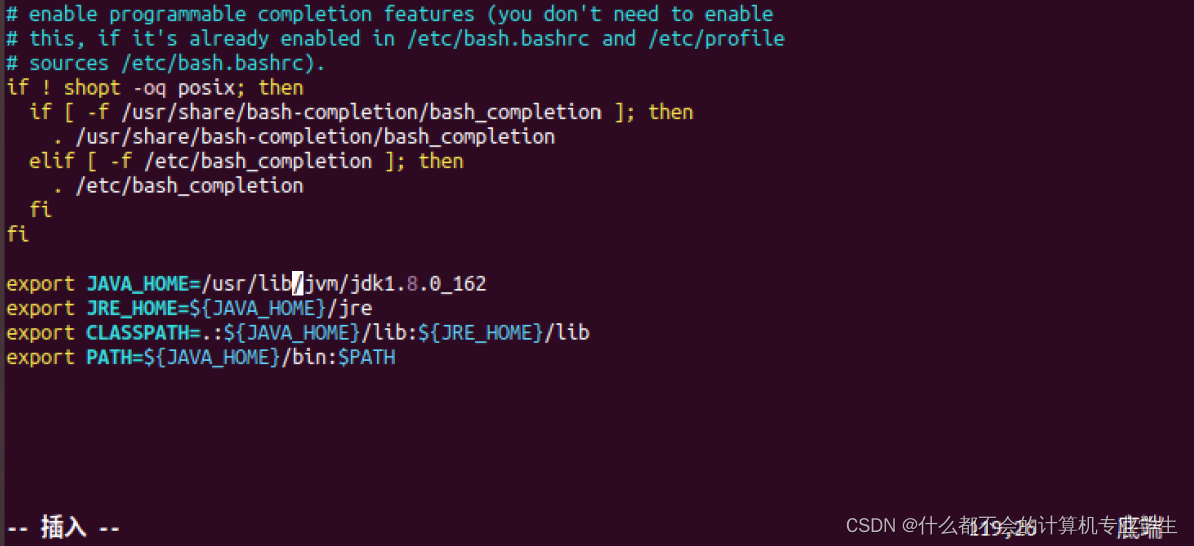

上面命令使用vim编辑器打开了hadoop这个用户的环境变量配置文件,请在这个文件的末尾位置添加如下几行内容:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

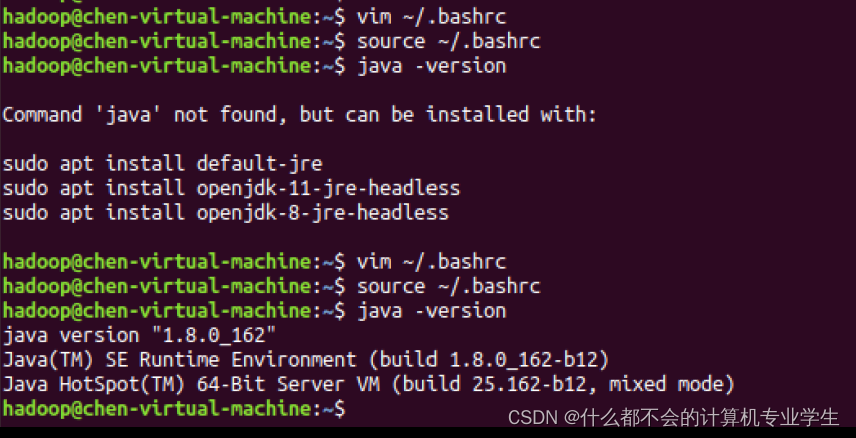

退出vim编辑器。然后,继续执行如下命令让.bashrc文件的配置立即生效:

$ source ~/.bashrc

这时,可以使用如下命令查看是否安装成功:$ java -version

如果能够在屏幕上返回如下信息,则说明安装成功:(若报错,就查看配置文件内容)java version "1.8.0_162"

Java(TM) SE Runtime Environment (build 1.8.0_162-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.162-b12, mixed mode)以上几步代码运行截图:

至此,就成功安装了Java环境。下面就可以进入Hadoop的安装。

1.4 安装Hadoop

1.4.1 安装单机Hadoop

打开一个终端,执行如下命令:(虚线以上笼统,以下具体)

$ cd ~/Downloads # 进入下载目录

$ wget -c http://res.aihyzh.com/大数据技术原理与应用3/02/hadoop-3.1.3.tar.gz #下载资源

$ sudo tar -zxf ~/Downloads/hadoop-3.1.3.tar.gz -C /usr/local # 解压到/usr/local中

$ sudo tar -zxf */hadoop-3.1.3.tar.gz -C /usr/local #将共享文件夹里的压缩包解压到、usr/local中

$ cd /usr/local/

$ sudo mv ./hadoop-3.1.3/ ./hadoop # 将文件夹名重命名为hadoop(./表示当前路径下的)

$ sudo chown -R stu:stu ./hadoop # 授权:修改文件权限(-R 递归处理,对指定目录下的所有文件及子目录一并进行处理)

(当前时hadoop用户,所以将hadoop权限授予文件夹)

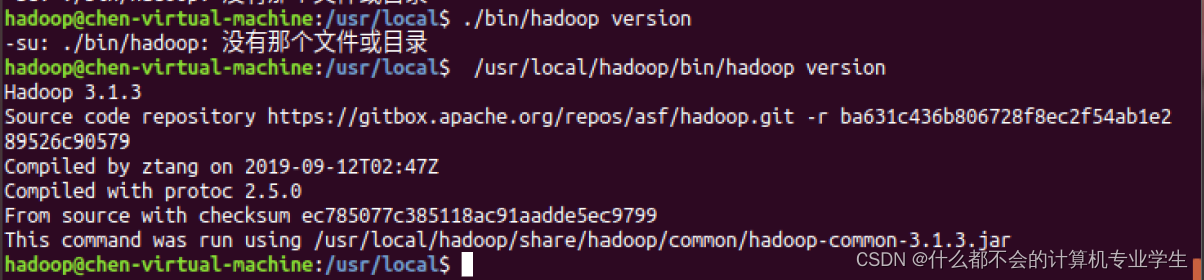

Hadoop解压后即可使用,可以输入如下命令来检查 Hadoop是否可用,成功则会显示 Hadoop版本信息:

$ ./bin/hadoop version #查看版本信息

1.4.2Hadoop伪分布式安装

1.4.2.1修改配置文件

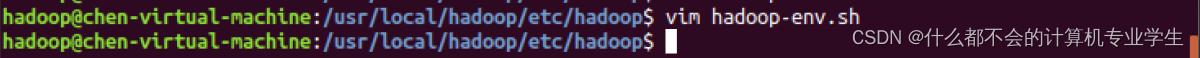

需要配置相关文件,才能够让Hadoop在伪分布式模式下顺利运行。Hadoop的配置文件位于/usr/local/hadoop/etc/hadoop/中,进行伪分布式模式配置时,需要修改3个配置文件,即hadoop-env.sh,core-site.xml和hdfs-site.xml。

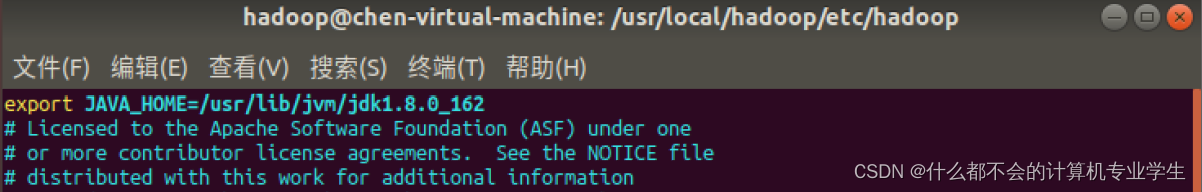

可以使用vim编辑器打开hadoop-env.sh文件,进行修改JAVA_HOME配置,添加一行代码:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

可以使用vim编辑器或者文本编辑器打开core-site.xml文件,修改以后,core-site.xml文件的内容如下:

在core-site.xml文件中,hadoop.tmp.dir用于保存临时文件,若没有配置hadoop.tmp.dir这个参数,则默认使用的临时目录为/tmp/hadoo-hadoop,而这个目录在Hadoop重启时有可能被系统清理掉,导致一些意想不到的问题,因此,必须配置这个参数。fs.defaultFS这个参数,用于指定HDFS的访问地址,其中,9000是端口号。

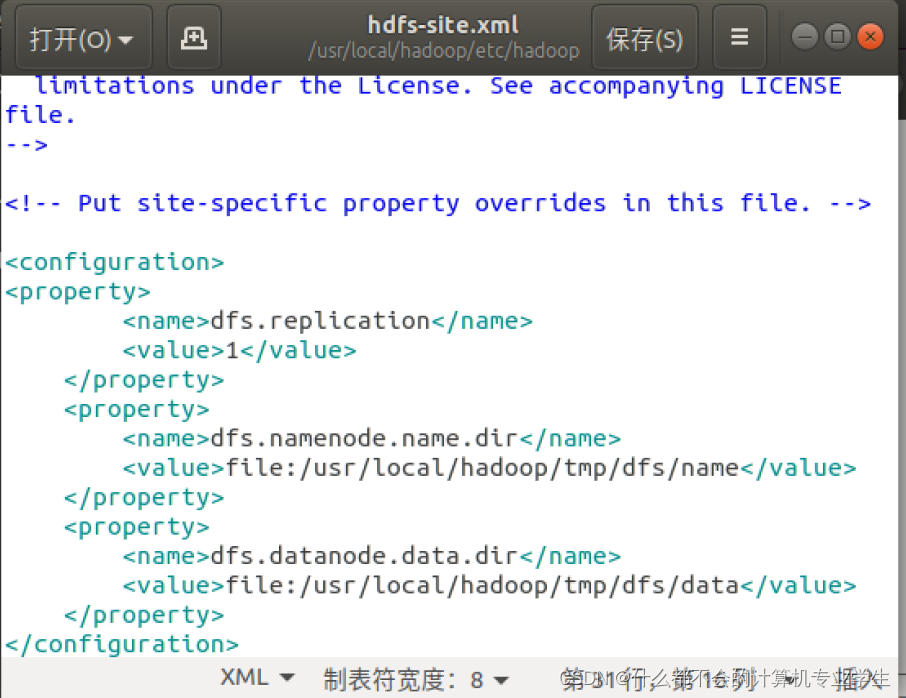

同样,需要修改配置文件hdfs-site.xml,修改后内容如下:

在hdfs-site.xml文件中,dfs.replication这个参数用于指定副本的数量,因为,在分布式文件系统HDFS中,数据会被冗余存储多份,以保证可靠性和可用性。但是,由于这里采用伪分布式模式,只有一个节点,因此,只可能有1个副本,因此,设置dfs.replication的值为1。dfs.namenode.name.dir用于设定名称节点的元数据的保存目录,dfs.datanode.data.dir用于设定数据节点的数据保存目录,这两个参数必须设定,否则后面会出错。

1.4.2.2初始化文件系统

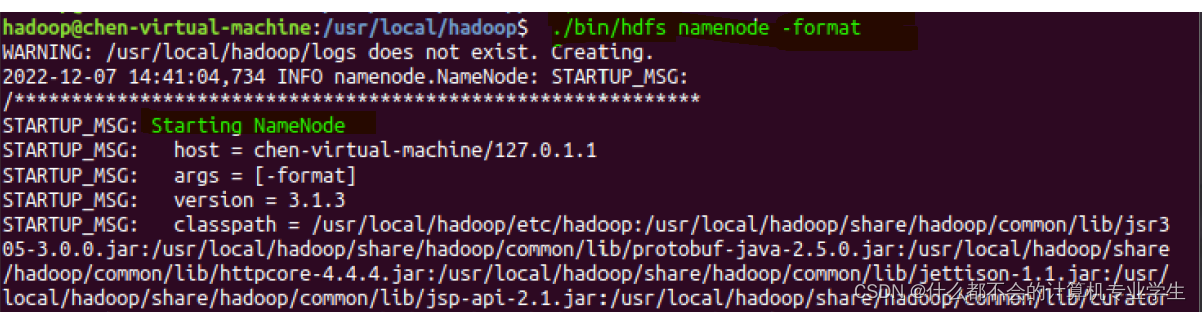

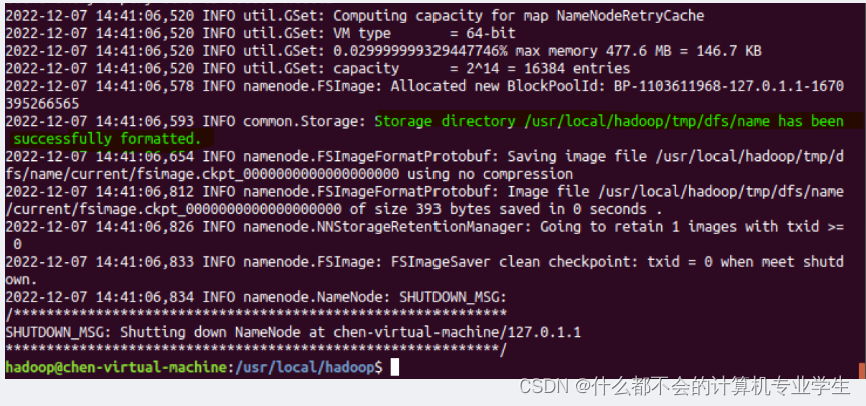

修改配置文件以后,要执行名称节点的格式化,命令如下:

$ cd /usr/local/hadoop

$ ./bin/hdfs namenode -format如果格式化成功,会看到

successfully formatted

1.4.2.3启动Hadoop

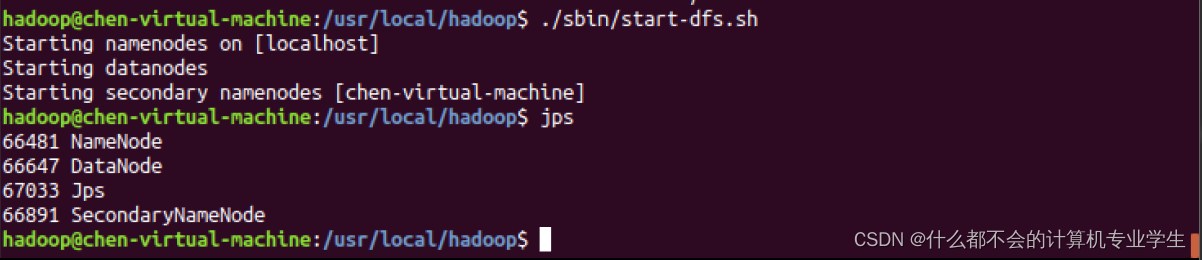

$ cd /usr/local/hadoop

$ ./sbin/start-dfs.sh #start-dfs.sh是个完整的可执行文件,中间没有空格Hadoop启动完成后,可以通过命令 jps 来判断是否成功启动,命令如下:

$ jps

若成功启动,则会列出如下进程:NameNode、DataNode和SecondaryNameNode。

如果看不到SecondaryNameNode进程,请运行命令./sbin/stop-dfs.sh关闭Hadoop相关进程,然后,再次尝试启动。如果看不到NameNode或DataNode进程,则表示配置不成功,请仔细检查之前步骤,或通过查看启动日志排查原因。如果少线程,先关闭集群stop-dfs.sh;然后删除tmp,再重新格式化!!!!!

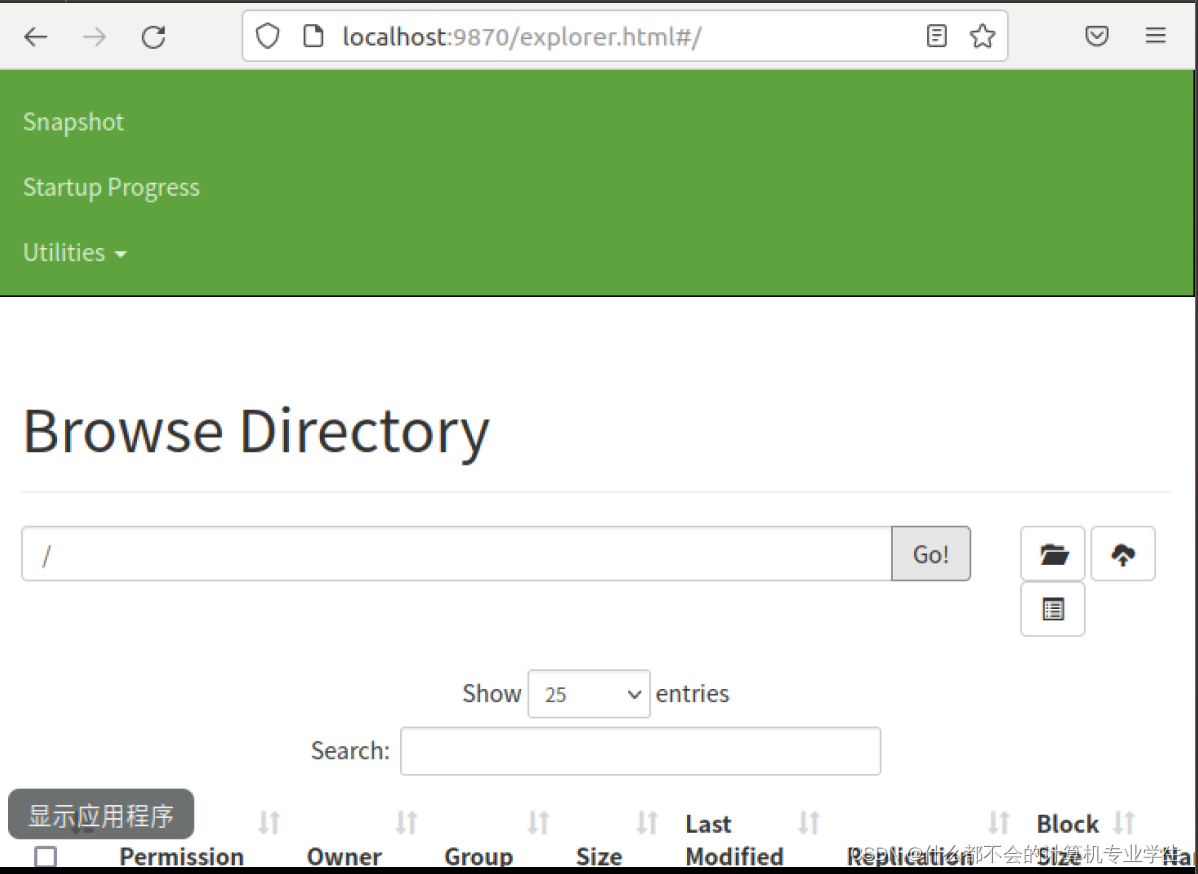

1.4.2.4使用Web界面查看HDFS信息

Hadoop成功启动后,可以在Linux系统中(不是Windows系统)打开一个浏览器,在地址栏输入地址http://localhost:9870,就可以查看名称节点和数据节点信息,还可以在线查看 HDFS 中的文件。

hadoop3.X的Web UI端口为:9870

hadoop2.X的Web UI端口为:50070

旧版本与新版本之间端口号有不一致的地方,但Ubuntu18.0.4是如图所示:

1.4.2.5运行Hadoop伪分布式实例

单机模式中,

grep例子读取的是本地数据,但在伪分布式模式下,读取的则是分布式文件系统

HDFS上的数据。要使用

HDFS,首先需要在

HDFS中创建用户目录,命令如下:

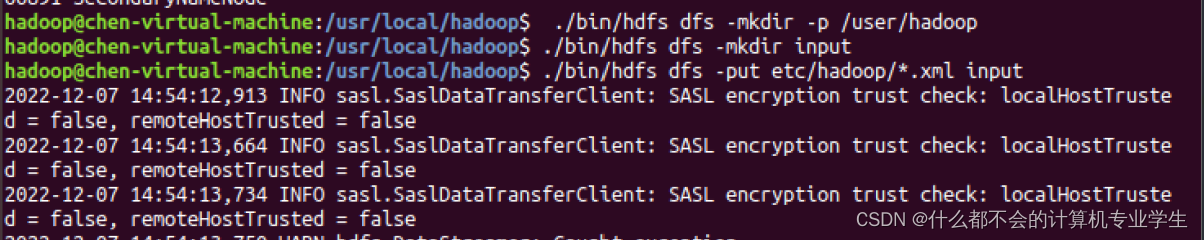

$ cd /usr/local/hadoop

$ ./bin/hdfs dfs -mkdir -p /user/hadoop

然后把复制本地文件到HDFS中,命令如下:$ cd /usr/local/hadoop

$ ./bin/hdfs dfs -mkdir /input #在HDFS中创建hadoop用户对应的input目录

$ ./bin/hdfs dfs -put ./etc/hadoop/*.xml input #把本地文件复制到HDFS中

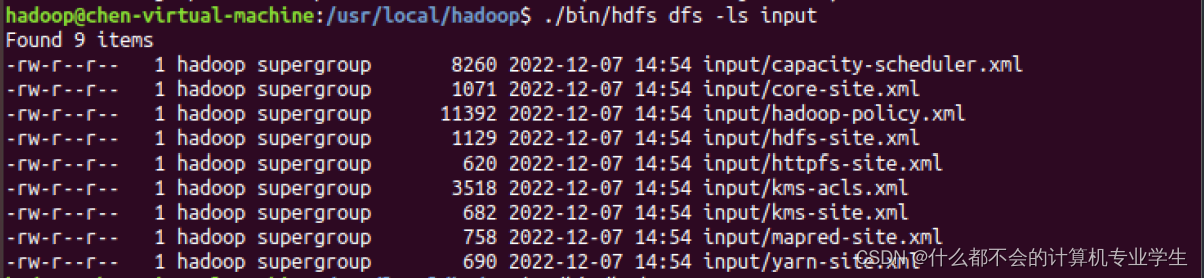

复制完成后,可以通过如下命令查看HDFS中的文件列表:$ ./bin/hdfs dfs -ls input

执行上述命令以后,可以看到input目录下的文件信息。

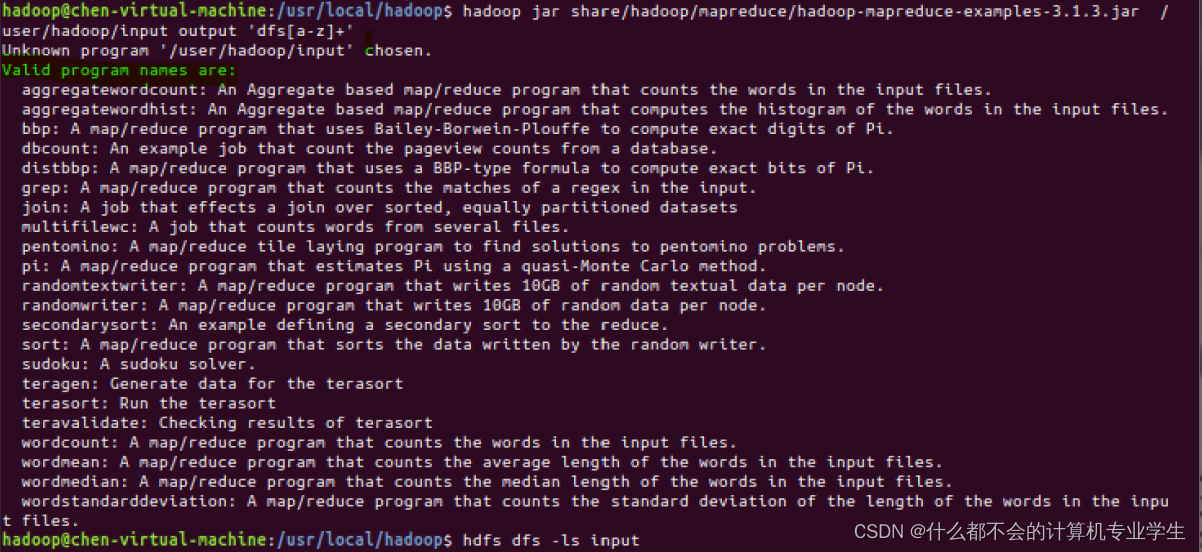

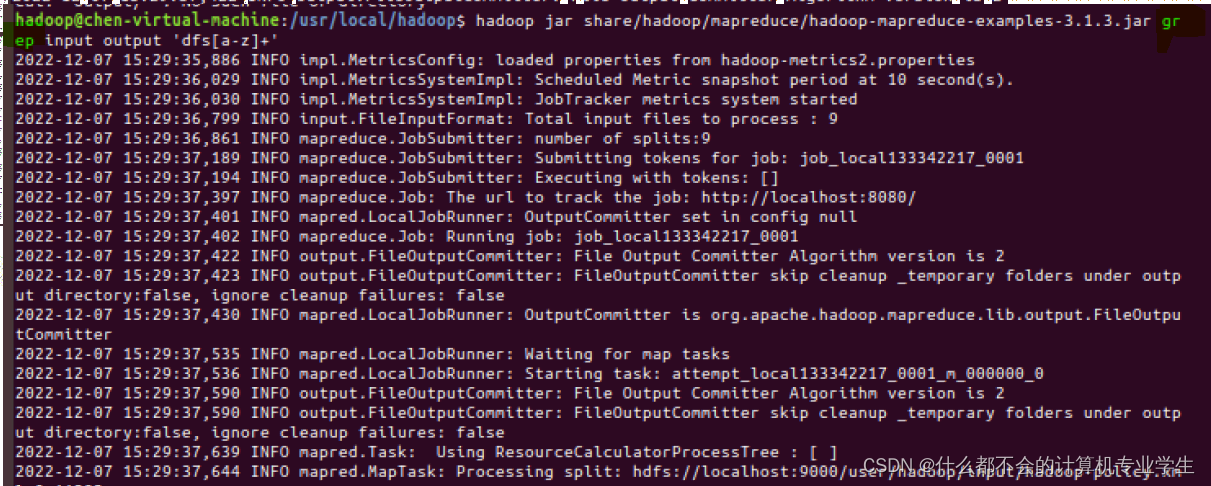

现在就可以运行Hadoop自带的grep程序,命令如下:

$ ./bin/hadoop

jar

./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar

grep input output 'dfs[a-z.]+'

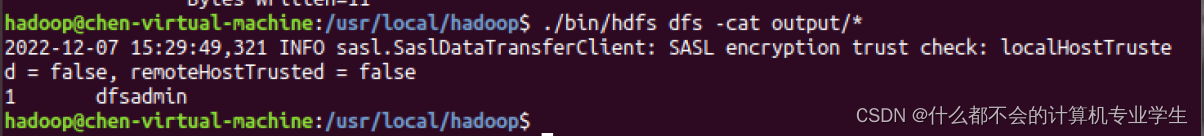

运行结束后,可以通过如下命令查看HDFS中的output文件夹中的内容:

grep十分重要:

$ ./bin/hdfs dfs -cat output/*

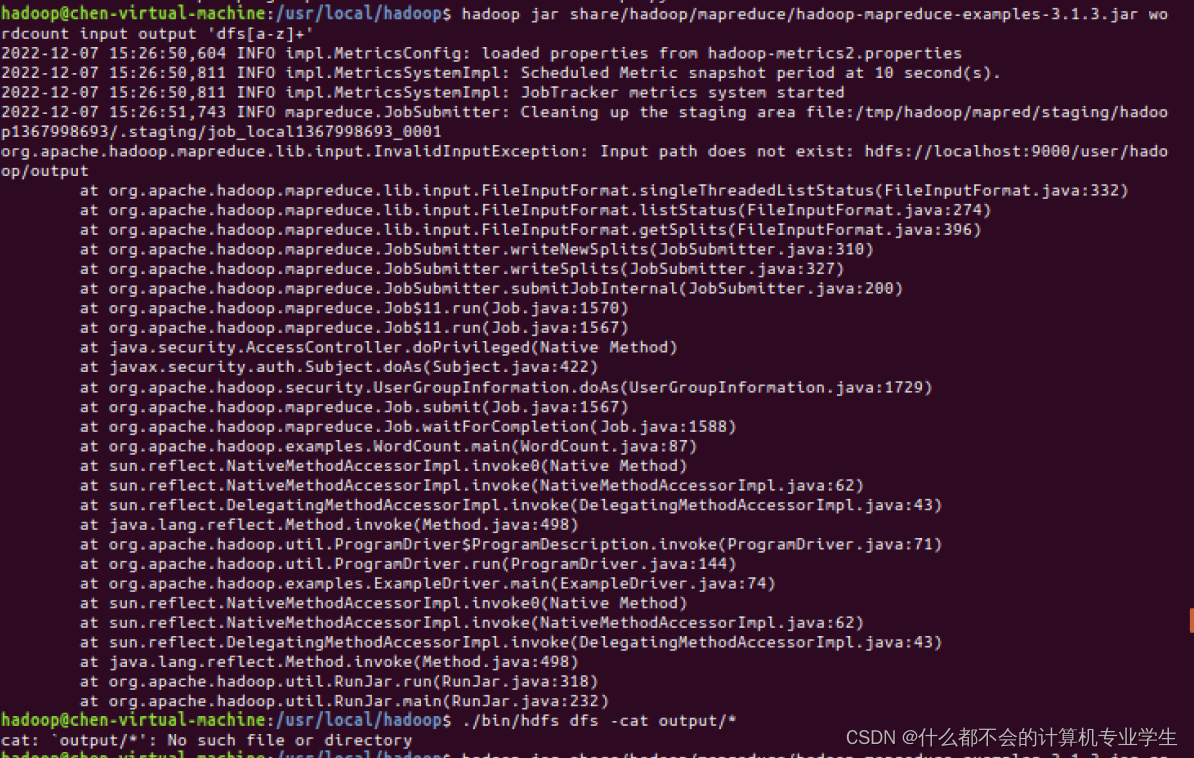

需要强调的是,Hadoop运行程序时,输出目录不能存在,否则会提示错误信息:

因此,若要再次执行grep程序,需要执行如下命令删除HDFS中的output文件夹:

$ ./bin/hdfs dfs -rm -r output # 删除 output 文件夹

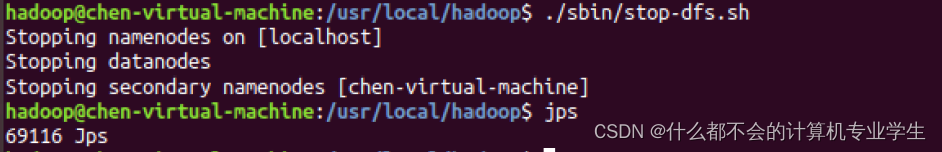

1.4.2.6关闭Hadoop

如果要关闭Hadoop,可以执行下面命令:

$ cd /usr/local/hadoop

$ ./sbin/stop-dfs.sh

下次启动Hadoop时,无需进行名称节点的初始化(否则会出错),也就是说,不要再次执行hdfs namenode -format命令,每次启动Hadoop只需要直接运行./sbin/start-dfs.sh命令即可。

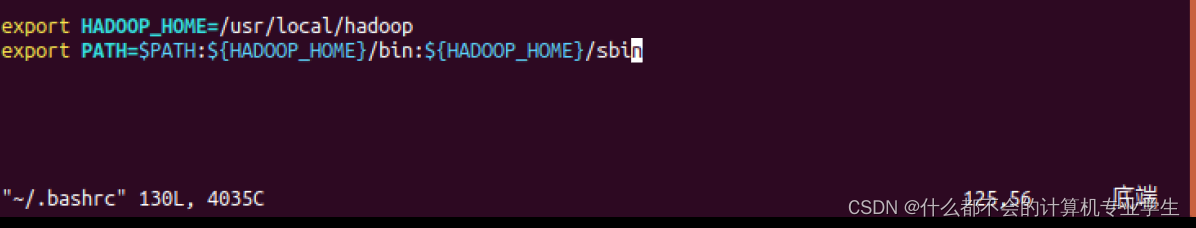

1.4.2.7配置PATH变量(便于执行命令,可略)

前面在启动Hadoop时,都要加上命令的路径,比如,

./sbin/start-dfs.sh这个命令中就带上了路径,实际上,通过设置path变量,就可以在执行命令时,不用带上命令本身所在的路径。

比如,我们打开一个Linux终端,在任何一个目录下执行ls命令时,都没有带上ls命令的路径,实际上,执行ls命令时,是执行/bin/ls这个程序,之所以不需要带上路径,是因为Linux系统已经把ls命令的路径加入到PATH变量中,当执行ls命令时,系统是根据 PATH 这个环境变量中包含的目录位置,逐一进行查找,直至在这些目录位置下找到匹配的ls程序(若没有匹配的程序,则系统会提示该命令不存在)。

知道了这个原理以后,我们同样可以把start-dfs.sh、stop-dfs.sh等命令所在的目录/usr/local/hadoop/sbin,加入到环境变量PATH中,这样,以后在任何目录下都可以直接使用命令start-dfs.sh启动Hadoop,不用带上命令路径。

具体操作方法是,首先使用vim编辑器打开~/.bashrc这个文件,然后,在这个文件的最前面位置加入如下单独一行:

export PATH=$PATH:/usr/local/hadoop/sbin

在后面的学习过程中,如果要继续把其他命令的路径也加入到PATH变量中,也需要继续修改~/.bashrc这个文件。当后面要继续加入新的路径时,只要用英文冒号“:”隔开,把新的路径加到后面即可,比如,如果要继续把/usr/local/hadoop/bin路径增加到PATH中,只要继续追加到后面,如下所示:export PATH=$PATH:/usr/local/hadoop/sbin:/usr/local/hadoop/bin

添加后,执行命令source ~/.bashrc使设置生效。设置生效后,在任何目录下启动Hadoop,都只要直接输入start-dfs.sh命令即可,同理,停止Hadoop,也只需要在任何目录下输入stop-dfs.sh命令即可。

原文链接:https://blog.csdn.net/m0_59865073/article/details/128175855

版权归原作者 什么都不会的计算机专业学生 所有, 如有侵权,请联系我们删除。