问题描述:

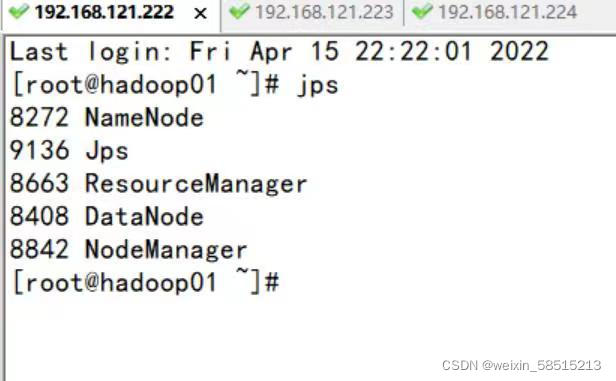

HADOOP集群启动的时候,用jps指令查看各个节点的服务进程启动情况发现hadoop01正常启动,hadoop02缺少一个datanode

情况如下:

主要原因:

多次hdfs namenode -format格式化导致

解决方法:

1.首先停掉集群:

输入stop-dfs.sh 和 stop-yarn.sh

2.先进入到主节点hadoop01解压包下的etc/hadoop/目录

输入:cd /export/servers/hadoop/etc/hadooop

注:我之前重命名过hadoop安装包,之前没有重命名的把红色标注的改为hadoop-2.7.4,这里根据自己安装的hadoop安装包版本决定。

输入:vi core-site.xml 查看配置文件目录路径

荧光笔标记的请用相机拍照,待会要切换目录

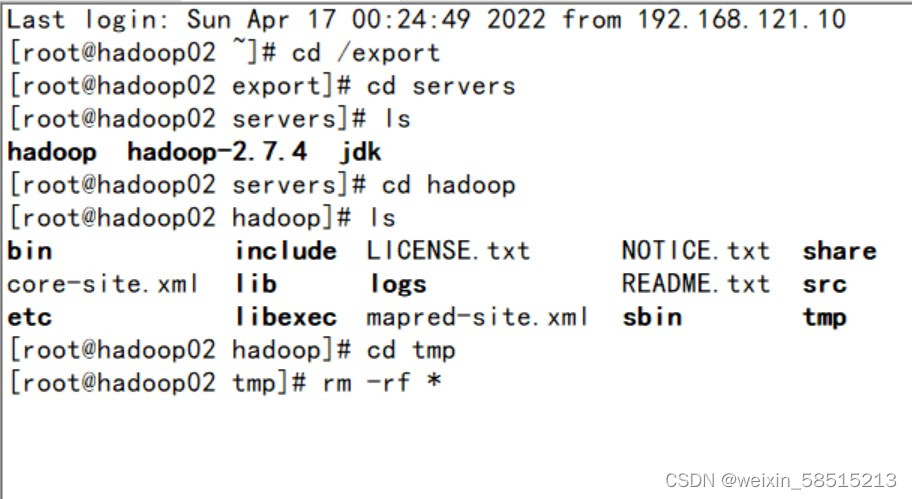

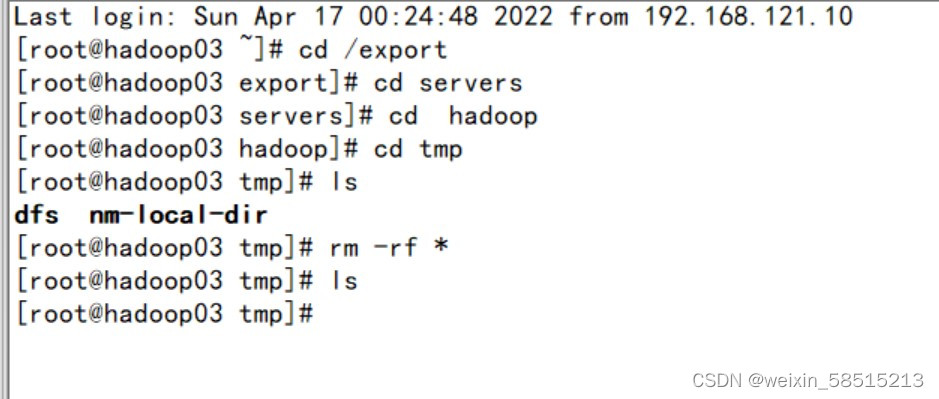

3.切换至hadoop02从节点

一步一步切换到tmp目录下

输入:rm -rf * // 删掉临时目录下的所有内容,这里不用担心删了会影响接下来的操作待会重新格式化还是会出现的

hadoop03也是如此操作

如果有同学主节点的datanode也没启动,也是按照上述个步骤删除临时文件下的所有文件。所有搞完在进行格式化

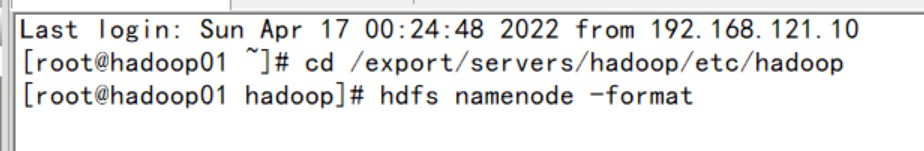

4.格式化文件

在主节点hadoop01输入 hdfs namenode -format

注格式化是在主节点上进行的,不用在两个节点都格式化。

如果格式化有提示选(Y/N),选N

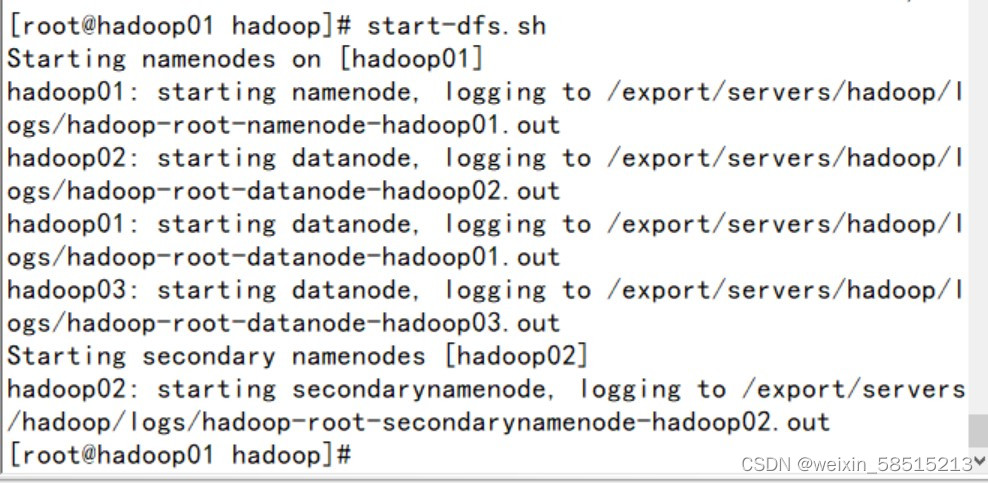

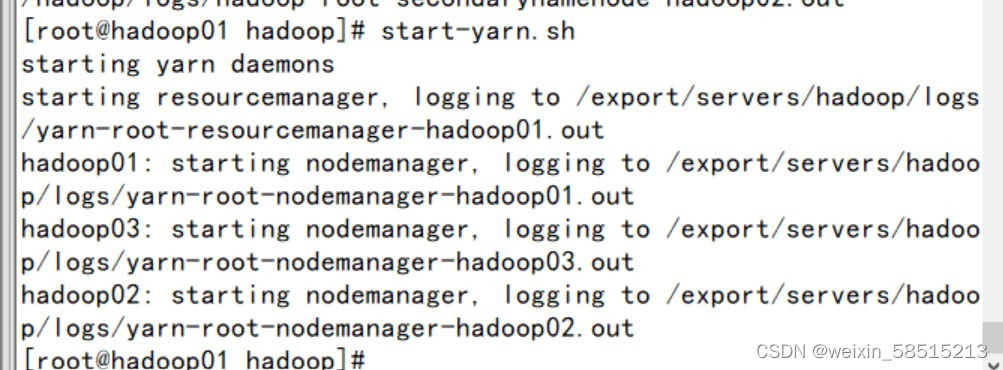

5.启动集群

输入start-dfs.sh 和 start-yarn.sh

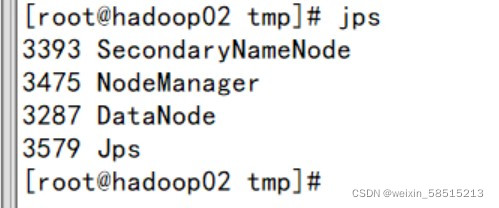

6.jps查看进程

hadoop01 02 03都成功启动,完成

版权归原作者 Vivian维维安 所有, 如有侵权,请联系我们删除。