点击上方“Deephub Imba”,关注公众号,好文章不错过 !

深度学习模型的使用越来越大众化,在很多行业中都是不可或缺的。然而,高效神经网络的实现通常需要架构的知识和大量的时间,在不停的迭代过程中使用我们的知识的探索合理的解决方案。神经网络的形式和结构会根据具体需要而有所不同,所以针对不同的任务和不同需求需要设定特定的结构。但是以试错的方式设计这些网络是一项耗时且乏味的任务,不仅需要架构技能还需要专业领域的知识。一般的情况下,专家们会利用他们过去的经验或技术知识来创建和设计神经网络。

在大部分行业,都会关注模型效率(这里的效率不仅说的执行的效率还包括了开发的效率)。为了使神经网络泛化而不过度拟合训练数据集,找到最优的结构是很重要的。但是在生产力比质量更重要的时代,一些行业忽视了他们模型的效率,并且只满足于实现了他们的目标的第一个模型(能用就行)而没有进一步。寻找合适的架构是一项耗时且容易出错的任务,需要架构设计技能。由于缺乏时间或架构专业知识,这些行业没有通过“足够”的模型充分利用其数据的潜力。

本文旨在展示神经网络架构搜索(NAS)的进展、面临的困难和提出的解决方案,以及 NAS 在当今的普及和未来趋势。

如何理解神经结构搜索的复杂性

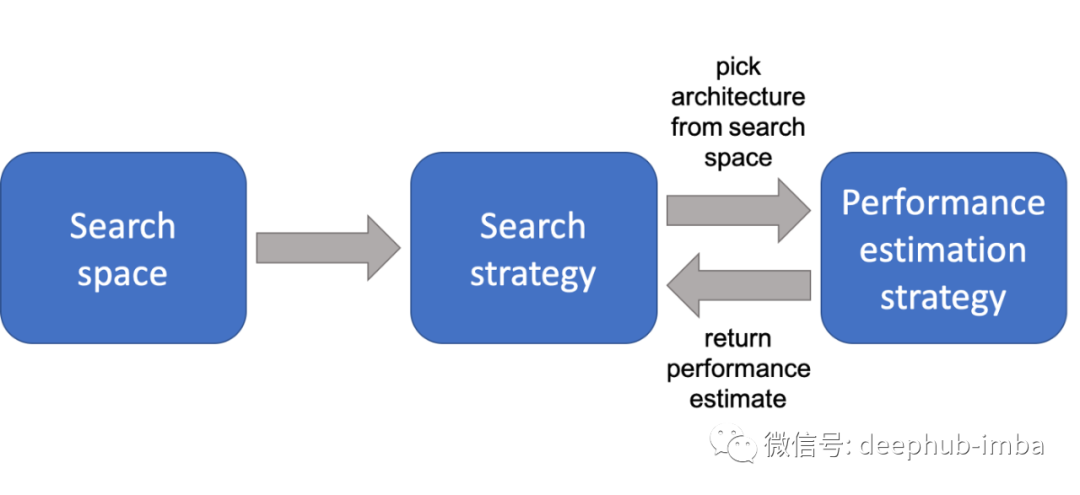

NAS的目的是发现神经网络的最佳结构,以满足特定的需要。NAS 本质是将人工调整神经网络的过程变成自动执行任务以发现更复杂的架构的过程。这个领域包含了一组工具和方法,它们将使用搜索策略在搜索空间中测试和评估大量架构,并通过最大化适应度函数选择最能满足给定问题目标的架构。

NAS 是 AutoML 的一个子领域,它封装了所有自动化机器学习问题和深度学习问题的过程。2016 年标志着 NAS 的开始,Zoph 和 Le 或 Baker 和 al 的工作实现了最先进的图像识别和语言建模架构与强化学习算法。这项工作对这一领域有很大的推动作用。

一些有名的项目

神经网络架构搜索 (NAS) 是机器学习发展最快的领域之一。大量研究工作涉及在不同行业和不同问题中搜索神经网络架构的自动化。时至今日,许多手工架构已经被 NAS 做的架构所取代:

- 目标检测 — 图像处理 — Zoph 和 al 2017

- 图像分类 — 图像处理 — Real and al, 2019

- 超参数优化 — AutoML — Feurer 和 Hutter,2019

- 元学习 — AutoML — Vanchoren,2018

最近在 NAS 上的工作表明,该领域正处于全面扩张和发展中,尤其是2019 年和 2020 年。虽然早期的工作可以被视为概念证明,但当前的研究正在解决跨多个行业和研究领域的更具体的需求。无论是在其效率和适应任何类型问题的能力方面,还是在工程师处理非自动化任务所节省的时间方面,这一趋势都显示了 NAS 可以带来的潜力,

NAS的好处和限制

NAS 方法探索了许多具有可变复杂性的潜在解决方案,因此在计算上非常昂贵。他们的搜索空间越大,需要测试、训练、评估的架构就越多。这些方法需要大量资源和时间才能找到足够好的模型,例如Zoph等人利用800个NVIDIA K40 gpu进行了28天的基于NAS方法的强化学习。以这个方法作为起点,出现了搜索时间更短的新模型。例如,Progressive Neural Architecture Search已经展示了最新结果,搜索时间提高了 5-8 倍。这种高效的方法大约需要 7 个小时找到高效的架构,与 NAS 相比GPU 小时数减少了 50,000 多倍。

但是该领域还受到其他一些限制。例如:很难知道潜在模型在真实数据上的表现如何。由于架构是使用训练数据进行评估的,如果我们期望在真实数据上运行模型,则最终的模型必须具有良好的质量。

虽然大部分工作可以自动化的进行,但是定义如何找到和评估这些架构的算法仍然是手工完成的,并且需要微调。虽然缺乏领域知识不会影响架构的效率。这一知识有助于加快搜索过程,它将指导搜索从而算法将更快地收敛到最优解。

最近的算法(如 PNAS 方法)试图预测未来的大致性能,但这些预测器必须进行微调并且仍然是近似值。此外,某些方法存在健壮性问题并且难以训练。

现在的一些实际研究集中在使用受生物学启发的算法作为 NAS 方法。这些算法对于优化任务非常有效,因此似乎是寻找神经网络最佳架构的理想候选者。

总结

- NAS 从大量候选中找到一个理想的解决方案,并选择最能满足给定问题目标的解决方案

- 基于优化的算法

- 计算成本非常高

- 很难估计它在真实数据下的表现

在优化和性能至关重要的时代,NAS是一个快速扩展的领域。这个刚刚起步的领域仍然面临一些困难,目前还难以成为行业中深度学习项目设计的成熟步骤。然而最近的工作趋向于表明,随着更快、更完整的体系结构评估方法的到来,这些困难将在未来几年消失。领域知识的贡献也不再是必不可少的,而提高研究方法效率的优势边的更为重要。因此,NAS将为行业和公司带来更多的灵活性,这些工具能够适应多种特定需求。

引用

Neural Architecture Search with Reinforcement Learning — Zoph and al, 2017

Designing neural network architectures using reinforcement learning — Baker and al, 2017

Meta-Learning, a survey — Joaquin Vanschoren, 2018

Progressive Neural Architecture Search — Liu and al, 2018

Efficient Neural Architecture Search via Parameter Sharing — Pham and al, 2018

Regularized Evolution for Image Classifier Architecture Search —Real and al, 2019

Hyperparameter Optimization — Matthias Feurer and Frank Hutter, 2019

DeepSwarm: Optimising Convolutional Neural Networks using Swarm Intelligence — Byla and Pang, 2019

作者:Thomas Gey

喜欢就关注一下吧:

点个 在看 你最好看!********** **********