Atlas安装:

solr版本:8.11.2

atlas版本:2.1.0

maven版本:3.5.4

jdk8

一、 SOLR安装

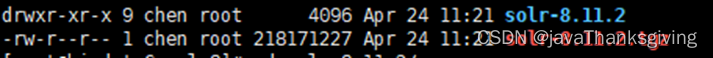

1、Solr官网https://solr.apache.org/downloads.html下载8.11.2版本solr(solr版本需要和atlas进行版本匹配)

2、上传到服务器。

3、tar -zxvf solr-8.11.2.tgz 进行解压

4、修改solr ZK_HOST配置信息

vim /var/bigdata_app/solr/solr8/solr-8.11.2/bin/solr.in.sh

5、启动solr

cd /var/bigdata_app/solr/solr8/solr-8.11.2/bin/

./solr start (需要在非root用户下启动)

6、启动成功

访问:http://ip:8983

二、 安装MAVEN

1、 maven官网下载3.5.4版本maven https://maven.apache.org/download.cgi

2、 上传到服务器。

3、 解压安装 tar -zxvf apache-maven-3.5.4-bin.tar.gz

4、 配置环境变量

vim /etc/profile

末尾添加

export MAVEN_HOME=/opt/installed/apache-maven-3.5.4

export PATH=

M

A

V

E

N

H

O

M

E

/

b

i

n

:

MAVEN_HOME/bin:

MAVENHOME/bin:PATH

5、 保存退出/etc/profile,设置环境变量生效

source /etc/profile

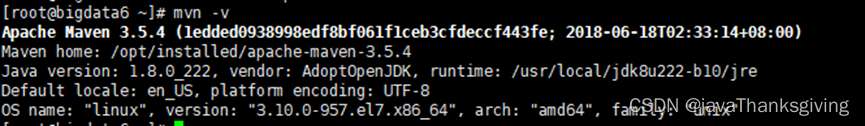

6、 检查maven是否安装成功

mvn -v

7、 修改maven镜像地址(maven仓库镜像地址最好用华为和阿里云结合,如果只用阿里云,sqoop-1.4.6.2.3.99.0-195.jar可能无法下载)

vim $MAVEN_HOME/conf/settings.xml

<mirror><id>huaweimaven</id><name>huawei maven</name><url>https://mirrors.huaweicloud.com/repository/maven/</url><mirrorOf>central</mirrorOf></mirror><mirror><id>ali apache snapshots</id><url>https://maven.aliyun.com/repository/apache-snapshots</url><mirrorOf>apache snapshots</mirrorOf></mirror><mirror><id>ali central</id><url>https://maven.aliyun.com/repository/central</url><mirrorOf>central</mirrorOf></mirror><mirror><id>ali google</id><url>https://maven.aliyun.com/repository/google</url><mirrorOf>google</mirrorOf></mirror><mirror><id>ali gradle-plugin</id><url>https://maven.aliyun.com/repository/gradle-plugin</url><mirrorOf>gradle-plugin</mirrorOf></mirror><mirror><id>ali jcenter</id><url>https://maven.aliyun.com/repository/jcenter</url><mirrorOf>jcenter</mirrorOf></mirror><mirror><id>ali spring</id><url>https://maven.aliyun.com/repository/spring</url><mirrorOf>spring</mirrorOf></mirror><mirror><id>ali spring-plugin</id><url>https://maven.aliyun.com/repository/spring-plugin</url><mirrorOf>spring-plugin</mirrorOf></mirror><mirror><id>ali public</id><url>https://maven.aliyun.com/repository/public</url><mirrorOf>public</mirrorOf></mirror><mirror><id>ali releases</id><url>https://maven.aliyun.com/repository/releases</url><mirrorOf>releases</mirrorOf></mirror><mirror><id>ali snapshots</id><url>https://maven.aliyun.com/repository/snapshots</url><mirrorOf>snapshots</mirrorOf></mirror><mirror><id>ali grails-core</id><url>https://maven.aliyun.com/repository/grails-core</url><mirrorOf>grails-core</mirrorOf></mirror><mirror><id>ali mapr-public</id><url>https://maven.aliyun.com/repository/mapr-public</url><mirrorOf>mapr-public</mirrorOf></mirror>

三、ATLAS安装

1、atlas官网下载 https://atlas.apache.org/#/Downloads

2、上传到服务器并解压

tar -zxvf apache-atlas-2.1.0-sources.tar.gz

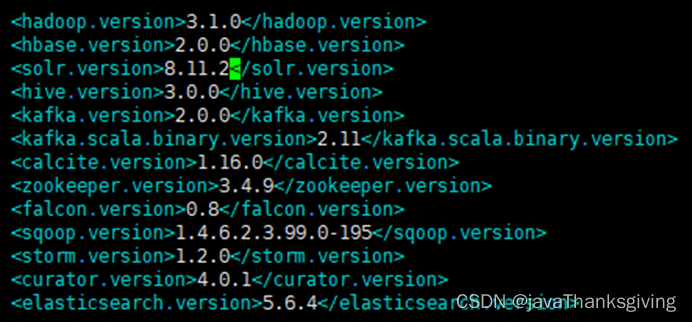

3、修改/apache-atlas-sources-2.1.0/pom.xml

把各个组件替换成自己需要的版本。

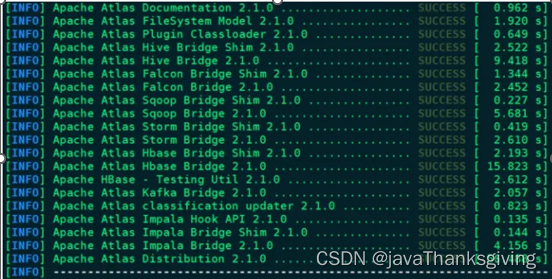

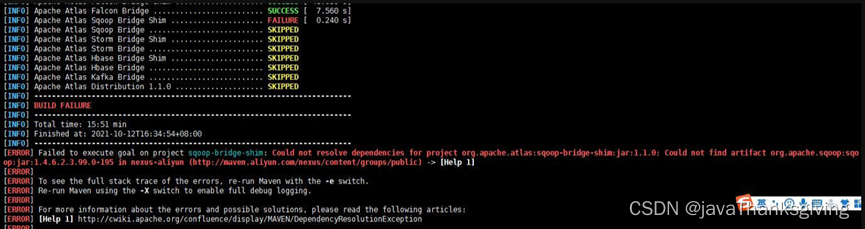

4、编译atlas(有部分包需要自己下载,根据报错内容来自行下载所需jar包)

cd /var/bigdata_app/atlas/apache-atlas-sources-2.1.0

mvn clean -DskipTests package -Pdist

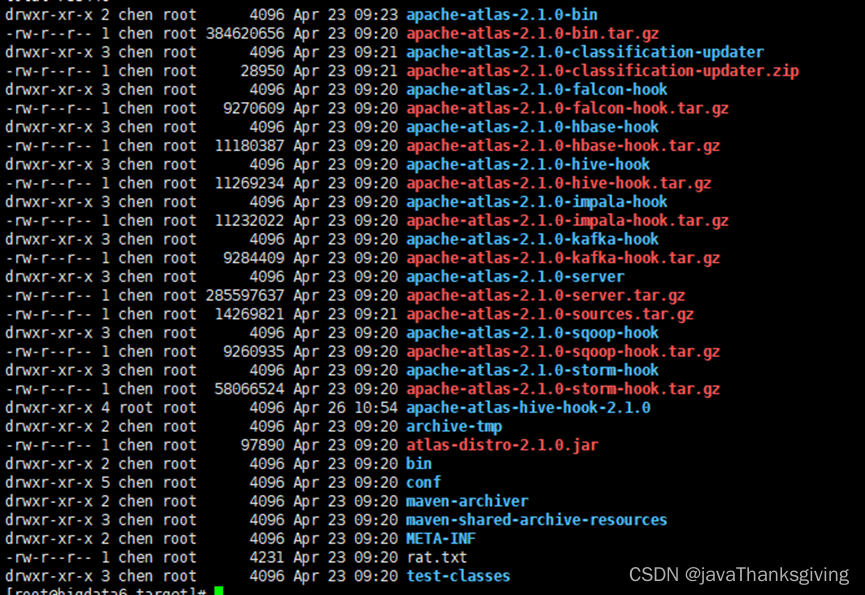

编译成功

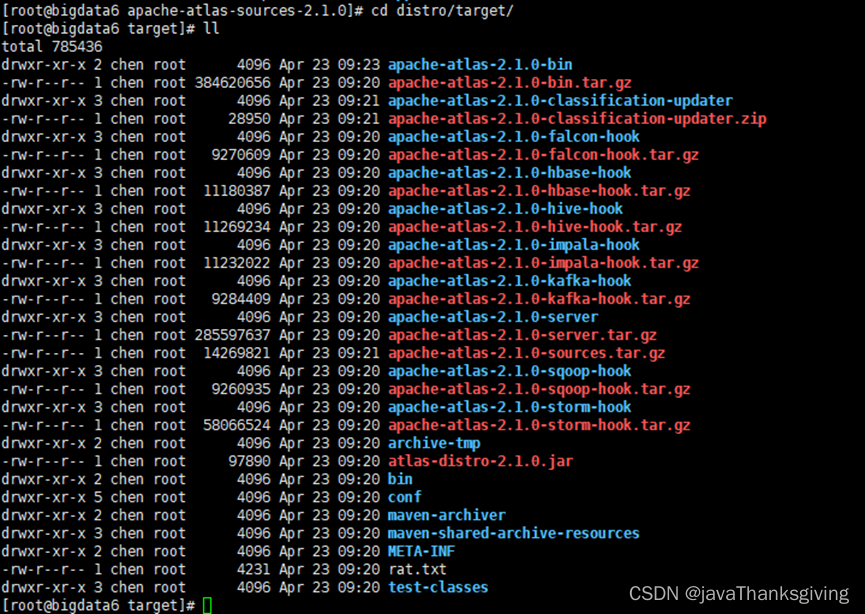

cd /var/bigdata_app/atlas/apache-atlas-sources-2.1.0/distro/target/

5、编译成功之后将apache-atlas-2.1.0-bin复制到atlas目录

cp /var/bigdata_app/atlas/apache-atlas-sources-2.1.0/distro/target/ /var/bigdata_app/atlas/

6、配置jdk

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/conf

vim atlas-env.sh

添加jdk

export JAVA_HOME=/usr/local/jdk8u222-b10

7、atlas集成Hbase

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/conf

vim atlas-env.sh

#如果想要使用外部的HBase 改成false

export MANAGE_LOCAL_HBASE=false

#添加HBase 配置文件路径

export HBASE_CONF_DIR=/usr/hdp/current/hbase-client/conf

vim atlas-application.properties

#如果使用外部HBase,则填写外部zookeeper地址

atlas.graph.storage.hostname=ip:2181,ip:2181,ip:2181

8、 集成solr

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/conf

vim atlas-env.sh

#如果想要使用外部的SOLR 改成false

export MANAGE_LOCAL_SOLR=false

vim atlas-application.properties

#配置 Solr 的Zookeeper地址

atlas.graph.index.search.solr.zookeeper-url=ip:2181,ip:2181,ip:2181

#Solr地址配置

atlas.graph.index.search.solr.http-urls=http://ip:8983/solr

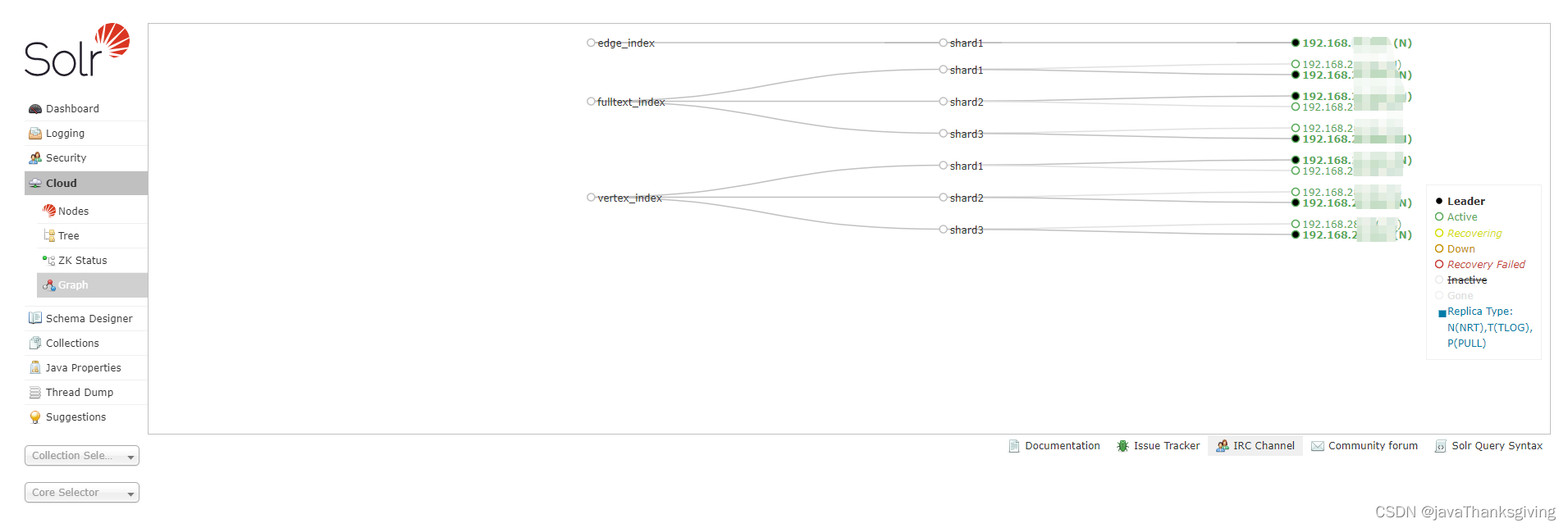

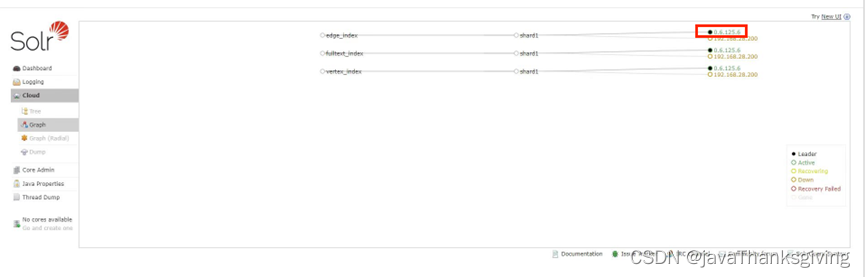

创建solr初始索引

cd /var/bigdata_app/solr/solr8/solr-8.11.2/bin/

执行

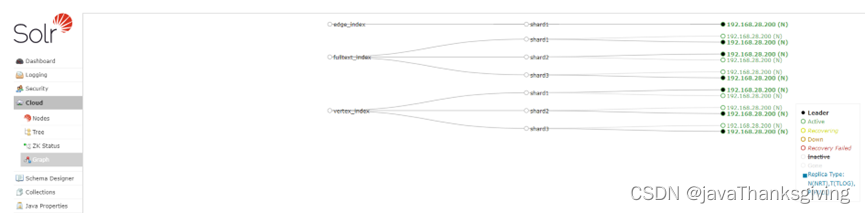

./solr create -c vertex_index -shards 3 -replicationFactor 2

./solr create -c edge_index -shards 3 -replicationFactor 2

./solr create -c fulltext_index -shards 3 -replicationFactor 2

重启solr

./solr stop

./solr start

访问:http://ip:8983/

9、 配置atlas server

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/conf/

vim atlas-application.properties

atlas.rest.address=http://192.168.xx.xx:21000

atlas.server.run.setup.on.start=false

atlas.audit.hbase.zookeeper.quorum=ip:2181,ip:2181,ip:2181

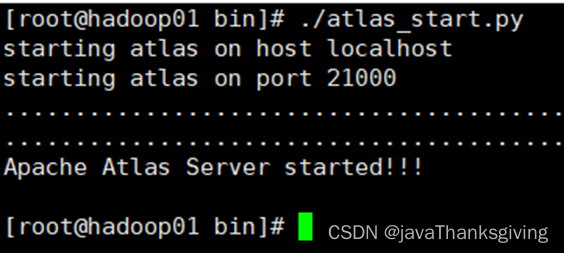

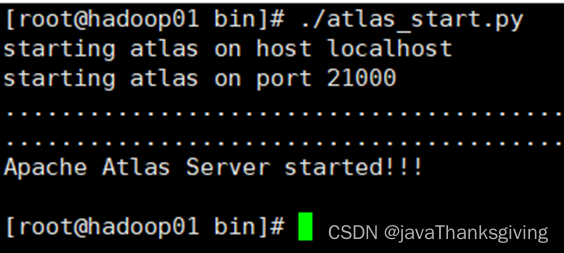

10、启动atlas

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/bin/

./atlas_start.py

使用默认账号登录,用户名:admin,密码:admin

11、atlas集成kafka

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/conf/

vim atlas-application.properties

######### Notification Configs #########

#使用外部kafka

atlas.notification.embedded=false

#atlas.kafka.data=${sys:atlas.home}/data/kafka

#kafka log文件存储地址

atlas.kafka.data=/kafka-logs,/BigData/kafka-logs

atlas.kafka.zookeeper.connect=ip:2181,ip:2181,ip:2181/kafka

atlas.kafka.bootstrap.servers=bigdata3:9092,bigdata4:9092,bigdata5:9092,bigdata6:9092

atlas.kafka.zookeeper.session.timeout.ms=4000

atlas.kafka.zookeeper.connection.timeout.ms=2000

atlas.kafka.zookeeper.sync.time.ms=20

atlas.kafka.auto.commit.interval.ms=1000

atlas.kafka.hook.group.id=atlas

atlas.kafka.enable.auto.commit=true

atlas.kafka.auto.offset.reset=earliest

atlas.kafka.session.timeout.ms=30000

atlas.kafka.offsets.topic.replication.factor=1

atlas.kafka.poll.timeout.ms=1000

#自动创建topic

atlas.notification.create.topics=true

atlas.notification.replicas=1

atlas.notification.topics=ATLAS_HOOK,ATLAS_ENTITIES

atlas.notification.log.failed.messages=true

atlas.notification.consumer.retry.interval=500

atlas.notification.hook.retry.interval=1000

在kafka中创建topic(ATLAS_HOOK,ATLAS_ENTITIES)

sh kafka-topics.sh -zookeeper ip:2181,ip:2181,ip:2181 --create --partitions 2 --replication-factor 2 --topic ATLAS_HOOK

sh kafka-topics.sh -zookeeper ip:2181,ip:2181,ip:2181 --create --partitions 2 --replication-factor 2 --topic ATLAS_ENTITIES

12、atlas集成hive

进入atlas编译目录

cd /var/bigdata_app/atlas/apache-atlas-sources-2.1.0/distro/target/

解压hook包

tar -zxvf apache-atlas-2.1.0-hive-hook.tar.gz

把hook复制到Atlas安装路径

cp -r /var/bigdata_app/atlas/apache-atlas-sources-2.1.0/distro/target/apache-atlas-2.1.0-hive-hook/* /var/bigdata_app/atlas/

HIVE环境添加HIVE-hook的jar路径

cd /usr/hdp/current/hive-client/conf

mv hive-env.sh.template hive-env.sh(如果已经改完则直接操作hive-env.sh)

vim hive-env.sh

export HIVE_AUX_JARS_PATH=/var/bigdata_app/atlas/apache-atlas-2.1.0/hook/hive/(需要在ambari集群进行操作,否则被覆盖掉,同时需要在集群的每台机器上都创建/var/bigdata_app/atlas/apache-atlas-2.1.0/hook/hive/文件夹,并把对应的文件进行下发,不然找不到对应的钩子文件)

HIVE配置添加Hook钩子

cd /usr/hdp/current/hive-client/conf

vim hive-site.xml(需要在ambari集群进行配置,不然会被覆盖)

添加下列配置

hive.exec.post.hooks

org.apache.atlas.hive.hook.HiveHook

加入Atlas的HIVE-Hook配置

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/conf/

vim atlas-application.properties

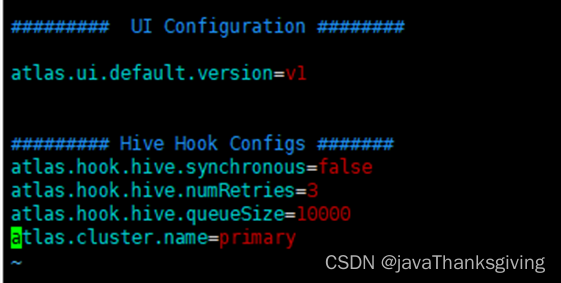

末尾添加Hive Hook Configs

######### Hive Hook Configs #######

atlas.hook.hive.synchronous=false

atlas.hook.hive.numRetries=3

atlas.hook.hive.queueSize=10000

atlas.cluster.name=primary

将Atlas配置文件atlas-application.properties拷贝到HIVE(需要在ambari集群进行配置,不然会被覆盖,比如kafka信息内容)

cp /var/bigdata_app/atlas/apache-atlas-2.1.0/conf/atlas-application.properties /usr/hdp/current/hive-client/conf/

重启atlas

cd /var/bigdata_app/atlas/apache-atlas-2.1.0/bin/

./atlas_stop.py

./atlas_start.py

启动成功访问:http://ip:21000/

历史数据初始导入:

cd /var/bigdata_app/atlas/apache-atlas-hive-hook-2.1.0/hook-bin

执行import-hive.sh

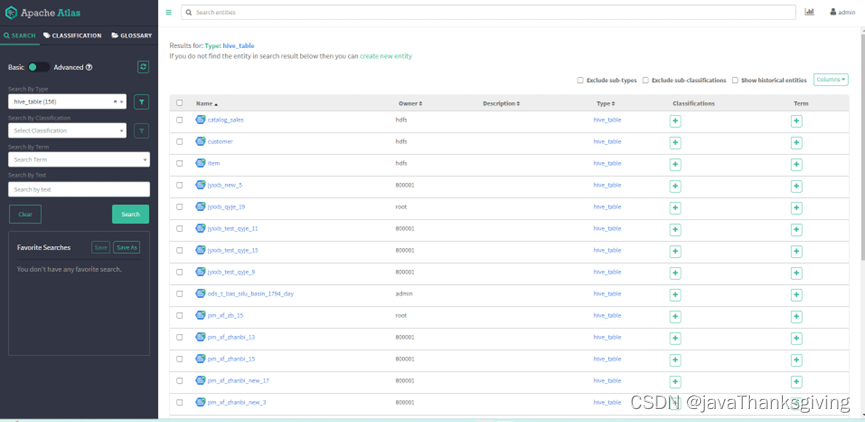

可查看hive相关元数据信息

点击具体的表查看血缘关系

Hive表自动更新

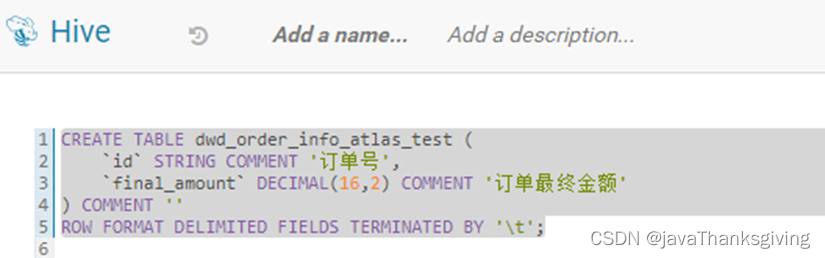

Hue创建dwd_order_info_atlas_test表

建表语句

CREATE TABLE dwd_order_info_atlas_test (

id

STRING COMMENT ‘订单号’,

final_amount

DECIMAL(16,2) COMMENT ‘订单最终金额’

) COMMENT ‘’

ROW FORMAT DELIMITED FIELDS TERMINATED BY ‘\t’;

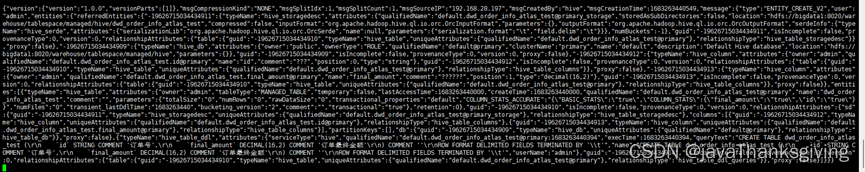

Kafka接受建表数据

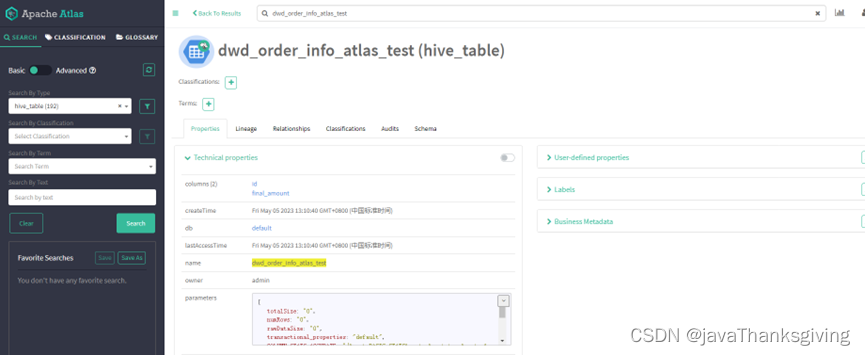

Atlas自动更新

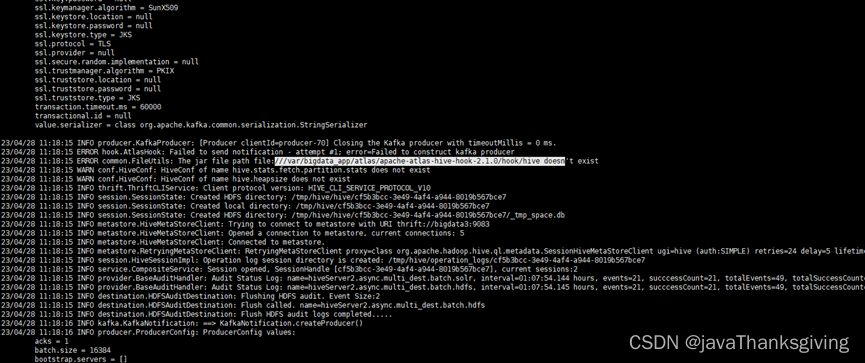

Hive表无法自动更新(钩子问题)和kafka无法更新topic数据问题查看hive日志

cd hive日志地址

tail -1000f hive-server2.err

问题整理

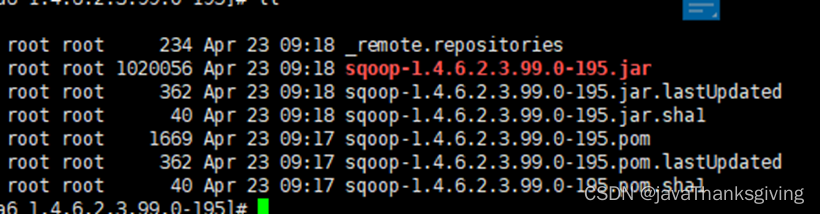

sqoop-1.4.6.2.3.99.0-195.jar

一、sqoop-1.4.6.2.3.99.0-195.jar

编译atlas过程中sqoop jar包无法下载问题。

原因是因为aliyun的镜像没有这个包,需要在网上手动下载。

下载地址:https://download.csdn.net/download/qq_26502245/12713290?utm_source=bbsseo

进入maven本地仓库找到对应的包位置进行上传

cd repository/org/apache/sqoop/sqoop/1.4.6.2.3.99.0-195/

上传之后重新进行编译。

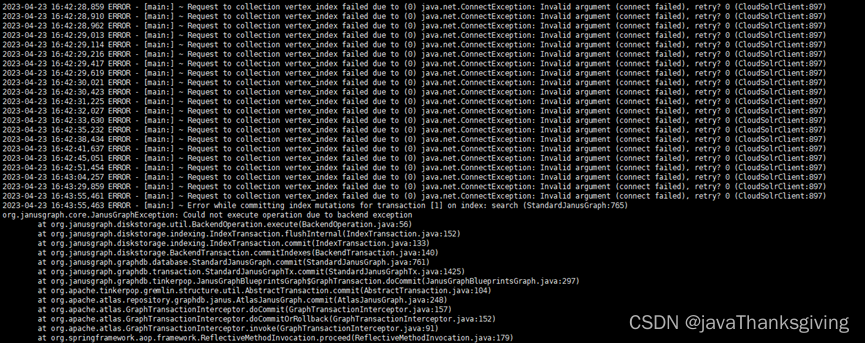

二、atlas查询不到solr索引

原因是最开始装的是solr5.5.1版本,其版本过低与atlas2.1.0匹配不成功。

解决办法:更换更高版本的solr(8.11.2)

三、solr创建索引失败

Solr上多出了虚拟ip,创建索引无法成功。

原因是之前在别的服务器上测试启动过solr,没有指定过solr ip,但是都是用一套zk进行管理的,所以给分配了虚拟ip。

解决办法:关闭测试solr,创建索引正常。

四、找不到钩子目录

找不到钩子目录

解决办法:需要在集群中每台机器都创建此文件夹,并把目录下的文件分发到每台机器上。

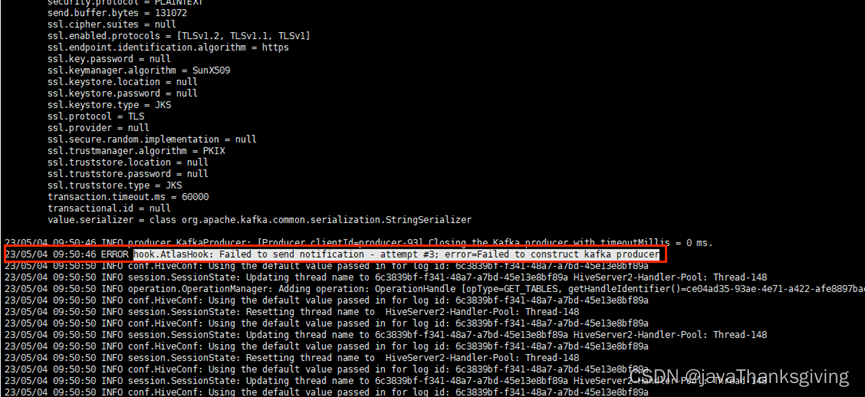

五、无法解析kafka broker

报错信息:

bootstrap.servers = []

ERROR hook.AtlasHook: Failed to send notification - attempt #3; error=Failed

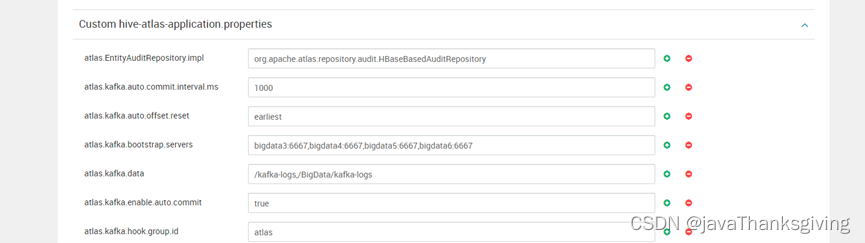

原因是hive集群会不定期覆盖atlas-application.properties文件。需要在ambari中进行配置。

位置:Ambari hiveCONFIGSADCANVED atlas-application.properties

Hive表无法自动更新(钩子问题)和kafka无法更新topic数据问题查看hive日志

tail -1000f hive-server2.err

版权归原作者 Thanksgiving~ 所有, 如有侵权,请联系我们删除。