一、创建hadoop用户

如果安装 Ubuntu 的时候设置用户名时用的不是****** "hadoop" 用户,那么需要增加一个名为 hadoop 的用户******

sudo useradd -m hadoop -s /bin/bash

设置密码,按提示输入两次密码:

sudo passwd hadoop

为 hadoop 用户增加管理员权限,方便操作

sudo adduser hadoop sudo

创建完hadoop用户后,注销,选择hadoop用户登入,如下所示:

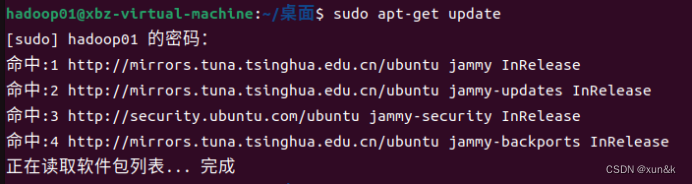

二、更新apt

使用 apt 安装软件,避免没更新导致有一些软件安装不了统****

sudo apt-get update

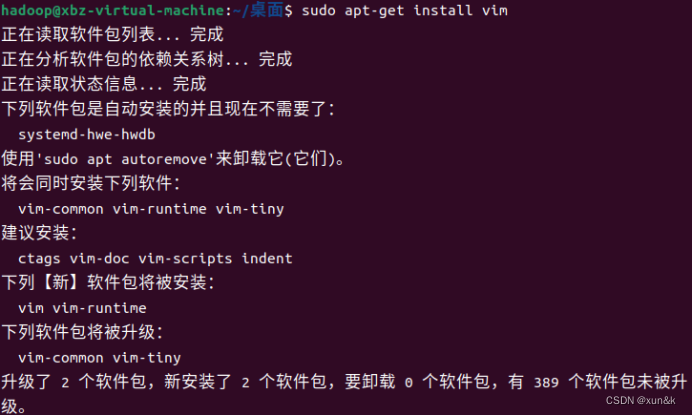

后面会需要更改一些配置文件,安装 vim,方便编辑文件,个人可以根据自身需求进行安装

sudo apt-get install vim

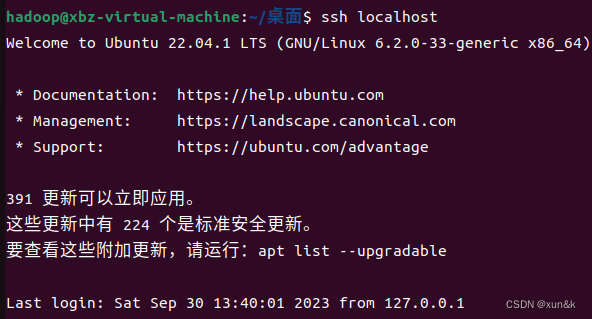

三、安装SSH、配置SSH无密码登陆****

1.Ubuntu默认已安装了SSH client,此外还需要安装SSH server:

sudo apt-get install openssh-server

2.ssh免密登陆

ssh localhost #需要密码才能登录

cd ~/.ssh/

ssh-keygen -t rsa #生成密钥

cat ./id_rsa.pub >> ./authorized_keys

ssh localhost #检验免密登录

四、安装Java****环境

建议直接在linux上进入官网下载jdk和hadoop,当然也可以在windows上下载,复制到虚拟机即可

cd /usr/lib

sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm #把jdk文件解压到/usr/lib/jvm目录下,****红色部分为你自己虚拟机下jdk存放的位置路径

cd ./jvm

sudo mv jdk-8u162 jdk #重命名,红色部分根据你安装的jdk 版本

cd ~

vim ~/.bashrc #配置环境变量

将以下的配置内容复制到该环境变量的配置文件里(注意红色部分):

export HADOOP_HOME=/usr/local/hadoop

export JAVA_HOME=/usr/lib/jvm/jdk

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin

source ~/.bashrc

五、安装 Hadoop

这里采用的是hadoop-3.1.3 ****

cd /usr/local/

sudo tar -zxvf ~/下载/hadoop-3.1.3.tar.gz -C /usr/local **#把hadoop-3.1.3文件解*压到/usr/local目录下*,**红色部分为你自己虚拟机下hadoop-3.1.3存放的位置

sudo mv hadoop-3.1.3 hadoop #重命名,红色部分根据你安装的hadoop 版本

sudo chown -R hadoop ./hadoop # 修改文件权限

六、检验jdk、hadoop的安装成果

cd /usr/lib/jvm

Java -version

cd /usr/local

hadoop version

七、Hadoop单机配置

cd /usr/local/hadoop

mkdir ./input

cp ./etc/hadoop/*.xml ./input # 将配置文件作为输入文件

./bin/hadoop

jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-*.jar grep ./input ./output 'dfs[a-z.]+'

(出现这个说明成功了)

cat ./output/* # 查看运行结果

Hadoop 默认不会覆盖结果文件,因此再次运行上面实例会提示出错,需要先将 ./output 删除

rm -r ./output

八、 Hadoop伪分布式配置****

Hadoop 的配置文件位于 /usr/local/hadoop/etc/hadoop/ 中,完全分布式需要修改4个配置文件 core-site.xml 、hdfs-site.xml、yarn-site.xml和mapred-site.xml**** ;伪分布只需要修改2个配置文件core-site.xml和hdfs-site.xml。(配置完后需要格式化及启动集群)

cd /usr/local/hadoop/etc/hadoop

- 配置core-site.xml文件

sudo vim core-site.xml

打开文件后,添加以下配置:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

2.配置hdfs-site.xml文件

sudo vim hdfs-site.xml

打开文件后,添加以下配置:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

3.配置yarn-site.xml文件

sudo vim yarn-site.xml

打开文件后,添加以下配置:

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</onfiguration>

4.配置mapred-site.xml文件

sudo vim mapred-site.xml

打开文件后,添加以下配置:

<cnfiguration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

配置完4个文件后,执行 NameNode 的格式化:

cd /usr/local/hadoop

./bin/hdfs namenode -format

启动集群:

cd /usr/local/hadoop

./sbin/start-all.sh

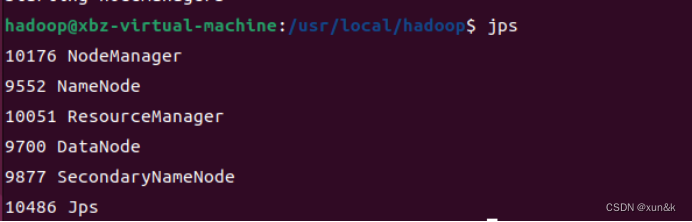

启动完成后,可以通过命令 jps 来判断是否成功启动

版权归原作者 xun&k 所有, 如有侵权,请联系我们删除。