SQL性能分析

SQL执行频率

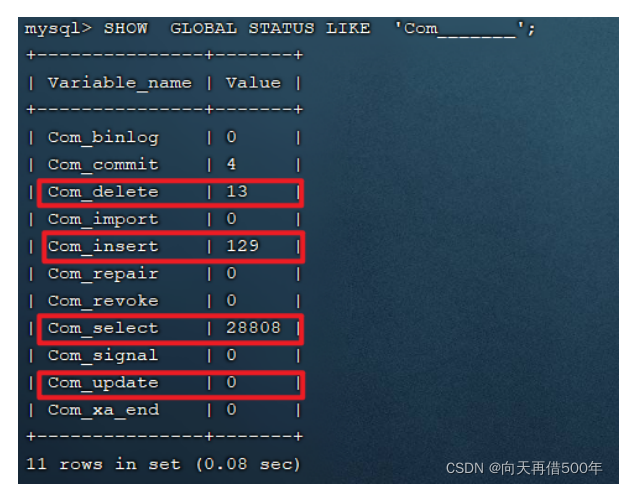

MySQL 客户端连接成功后,通过 show [session|global] status 命令可以提供服务器状态信息。通过如下指令,可以查看当前数据库的INSERT、UPDATE、DELETE、SELECT的访问频次:

-- session 是查看当前会话 ;-- global 是查询全局数据 ;SHOWGLOBALSTATUSLIKE'Com_______';

- Com_delete: 删除次数

- Com_insert: 插入次数

- Com_select: 查询次数

- Com_update: 更新次数

通过上述指令,我们可以查看到当前数据库到底是以查询为主,还是以增删改为主,从而为数据库优化提供参考依据。 如果是以增删改为主,我们可以考虑不对其进行索引的优化。 如果是以查询为主,那么就要考虑对数据库的索引进行优化了。

慢查询日志

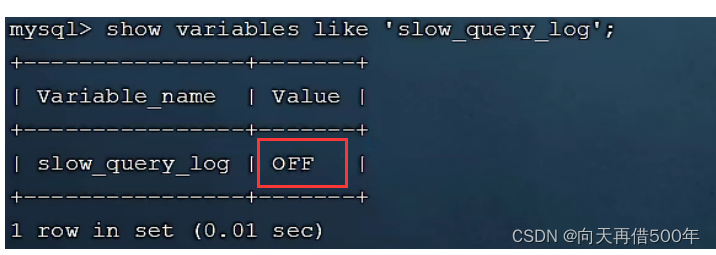

慢查询日志记录了所有执行时间超过指定参数(long_query_time,单位:秒,默认10秒)的所有SQL语句的日志。

MySQL的慢查询日志默认没有开启,我们可以查看一下系统变量 slow_query_log。

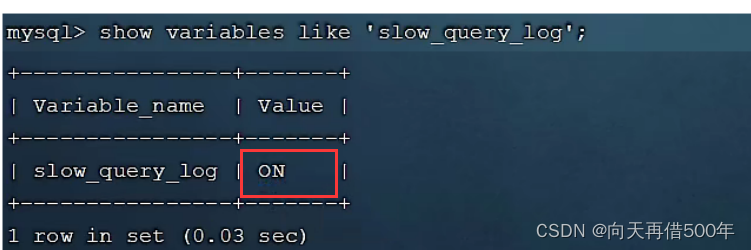

如果要开启慢查询日志,需要在MySQL的配置文件(/etc/my.cnf)中配置如下信息:

# 开启MySQL慢日志查询开关

slow_query_log=1# 设置慢日志的时间为2秒,SQL语句执行时间超过2秒,就会视为慢查询,记录慢查询日志

long_query_time=2

配置完毕之后,通过以下指令重新启动MySQL服务器进行测试,查看慢日志文件中记录的信息

/var/lib/mysql/localhost-slow.log。

systemctl restart mysqld

然后,再次查看开关情况,慢查询日志就已经打开了。

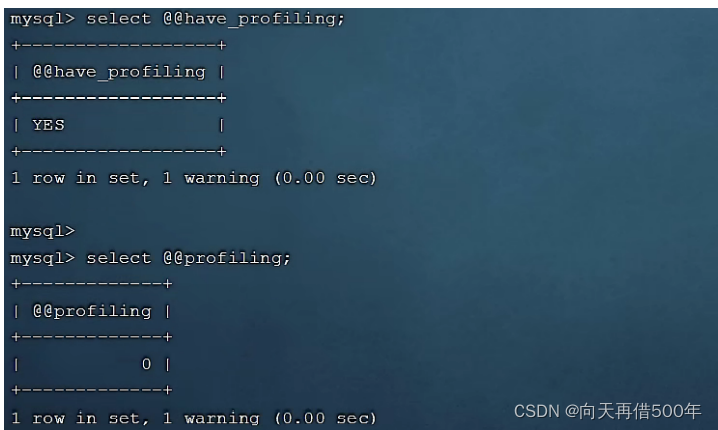

profile详情

show profiles 能够在做SQL优化时帮助我们了解时间都耗费到哪里去了。通过have_profiling参数,能够看到当前MySQL是否支持profile操作:

SELECT @@have_profiling;

可以看到,当前MySQL是支持 profile操作的,但是开关是关闭的。可以通过set语句在session/global级别开启profiling:

SET profiling =1;

开关已经打开了,接下来,我们所执行的SQL语句,都会被MySQL记录,并记录执行时间消耗到哪儿去

了。 我们直接执行如下的SQL语句:

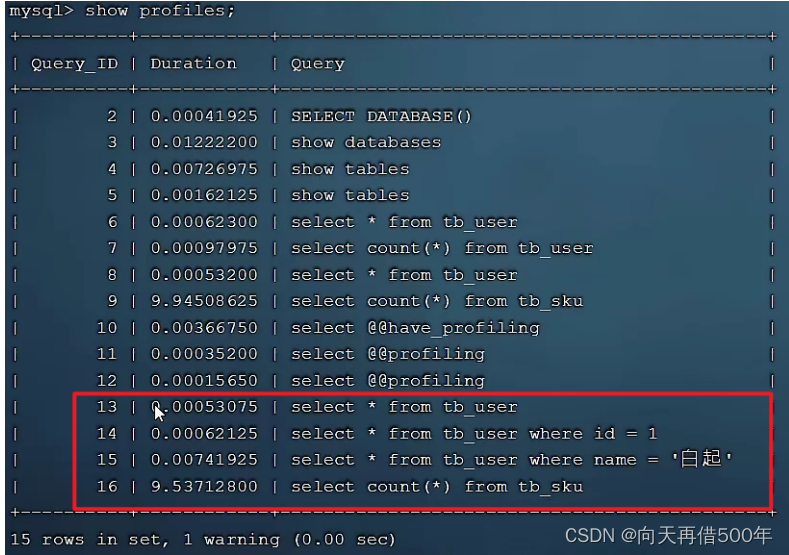

select*from tb_user;select*from tb_user where id =1;select*from tb_user where name ='白起';selectcount(*)from tb_sku;

执行一系列的业务SQL的操作,然后通过如下指令查看指令的执行耗时:

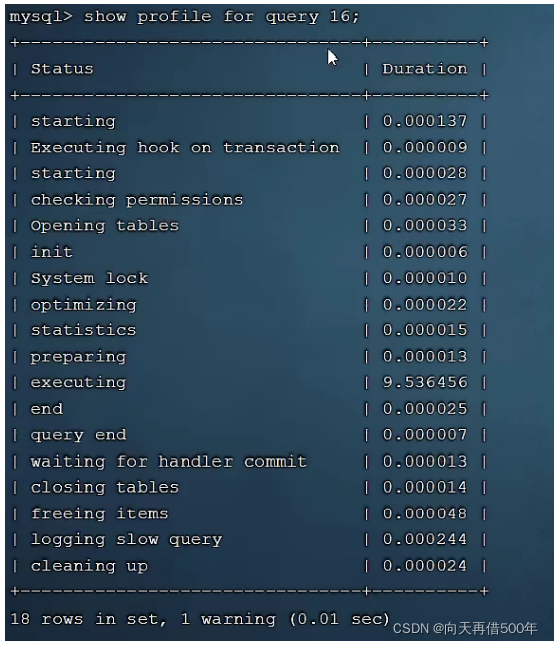

-- 查看每一条SQL的耗时基本情况show profiles;-- 查看指定query_id的SQL语句各个阶段的耗时情况show profile for query query_id;-- 查看指定query_id的SQL语句CPU的使用情况show profile cpu for query query_id;

查看每一条SQL的耗时情况:

查看指定SQL各个阶段的耗时情况 :

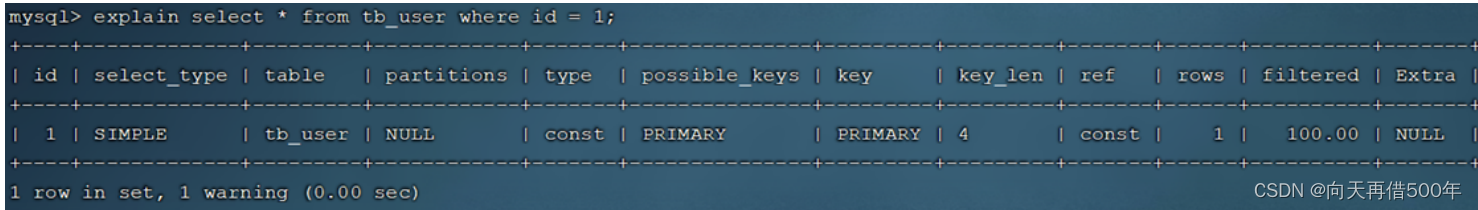

explain

EXPLAIN 或者 DESC命令获取 MySQL 如何执行 SELECT 语句的信息,包括在 SELECT 语句执行

过程中表如何连接和连接的顺序。

-- 直接在select语句之前加上关键字 explain / descEXPLAINSELECT 字段列表 FROM 表名 WHERE 条件 ;

Explain 执行计划中各个字段的含义:

SQL优化

插入数据

如果我们需要一次性往数据库表中插入多条记录,可以从以下三个方面进行优化。

insertinto tb_test values(1,'tom');insertinto tb_test values(2,'cat');insertinto tb_test values(3,'jerry');

优化方案一

批量插入数据

Insertinto tb_test values(1,'Tom'),(2,'Cat'),(3,'Jerry');

优化方案二

手动控制事务

starttransaction;insertinto tb_test values(1,'Tom'),(2,'Cat'),(3,'Jerry');insertinto tb_test values(4,'Tom'),(5,'Cat'),(6,'Jerry');insertinto tb_test values(7,'Tom'),(8,'Cat'),(9,'Jerry');commit;

优化方案三

主键顺序插入,性能要高于乱序插入。

大批量插入数据

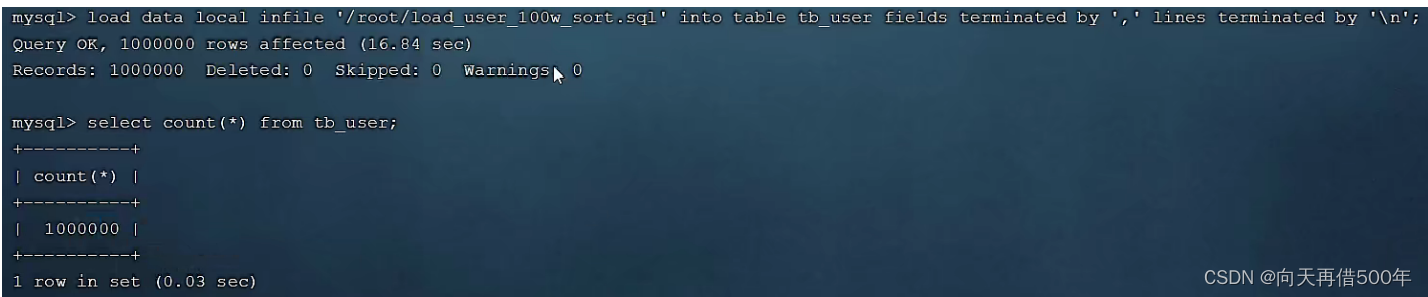

如果一次性需要插入大批量数据(比如: 几百万的记录),使用insert语句插入性能较低,此时可以使用MySQL数据库提供的load指令进行插入。操作如下:

-- 客户端连接服务端时,加上参数 -–local-infile

mysql –-local-infile-u root -p

-- 设置全局参数local_infile为1,开启从本地加载文件导入数据的开关setglobal local_infile =1;-- 执行load指令将准备好的数据,加载到表结构中loaddatalocalinfile'/root/load_user_100w_sort.sql'intotable

tb_user fieldsterminatedby','linesterminatedby'\n';

在load时,主键顺序插入性能高于乱序插入

主键优化

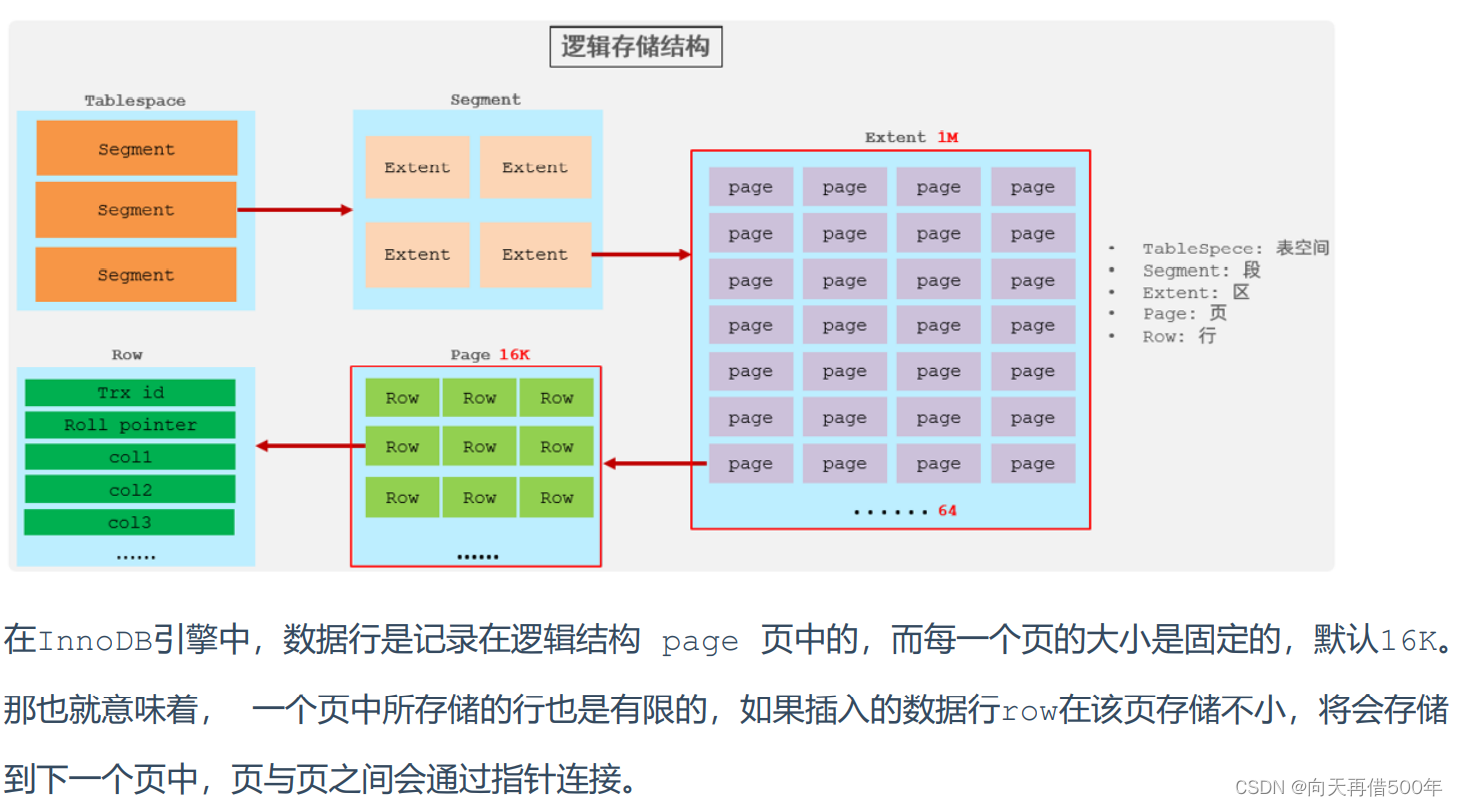

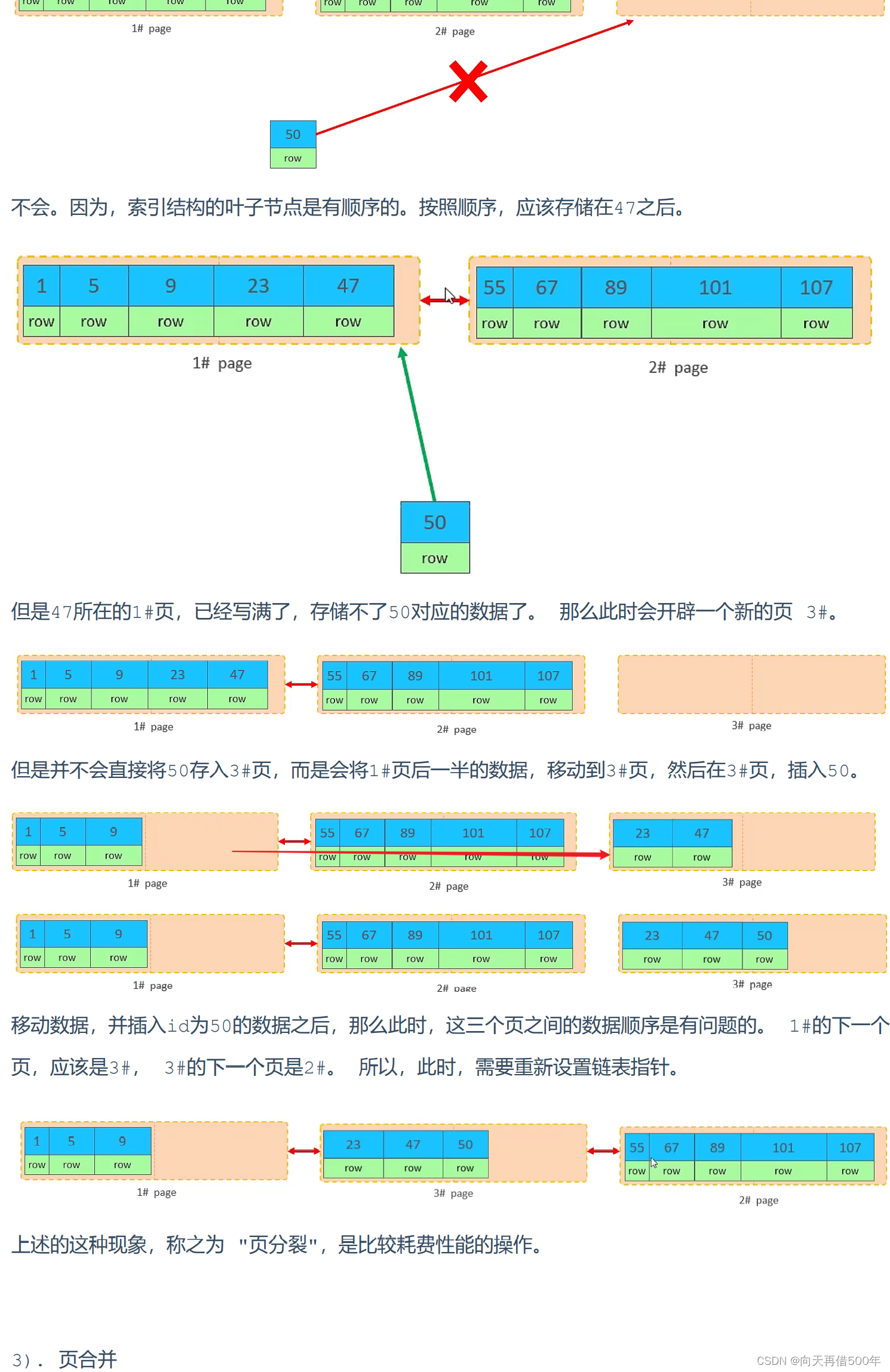

页分裂

页可以为空,也可以填充一半,也可以填充100%。每个页包含了2-N行数据(如果一行数据过大,会行溢出),根据主键排列。

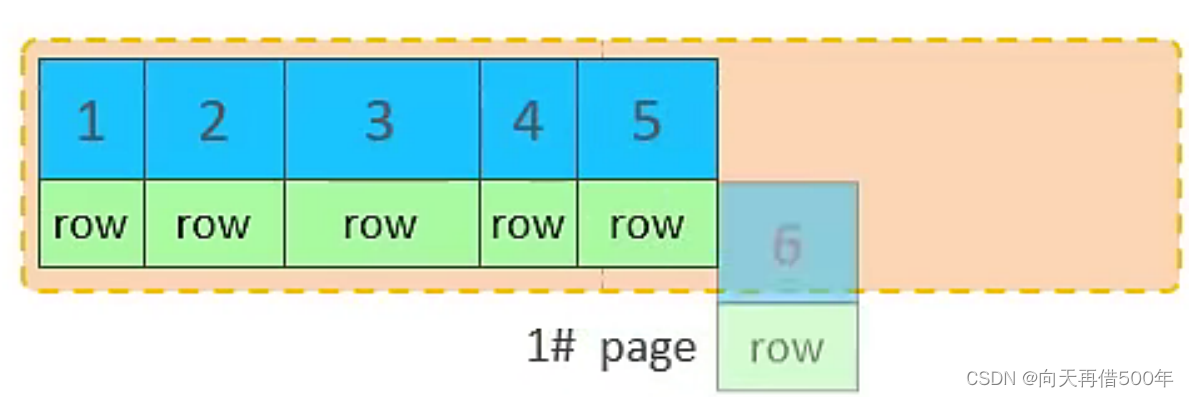

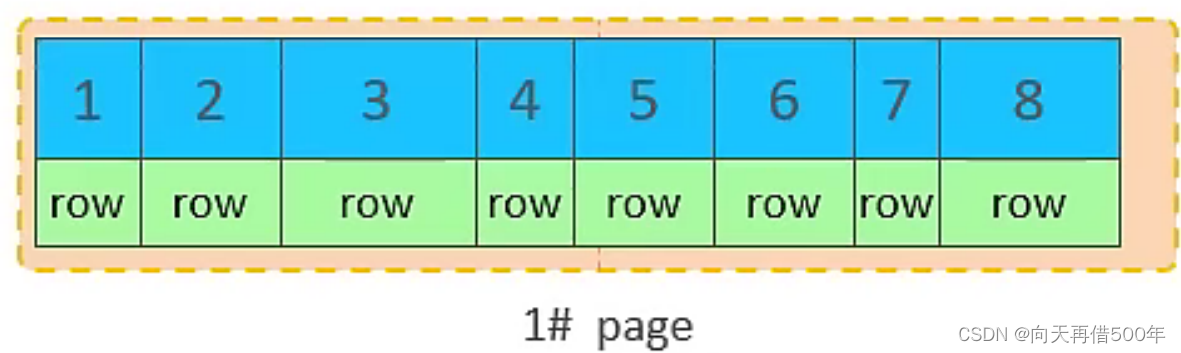

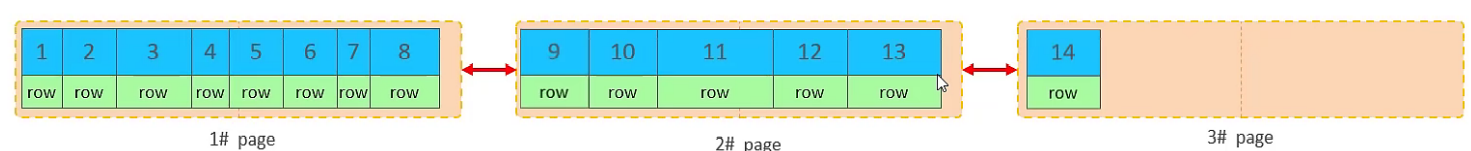

主键顺序插入效果

- 从磁盘中申请页, 主键顺序插入

- 第一个页没有满,继续往第一页插入

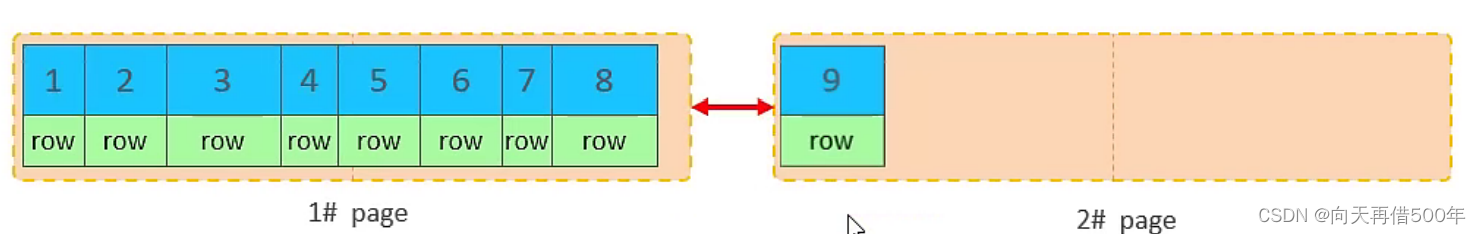

- 当第一个也写满之后,再写入第二个页,页与页之间会通过指针连接

- 当第二页写满了,再往第三页写入

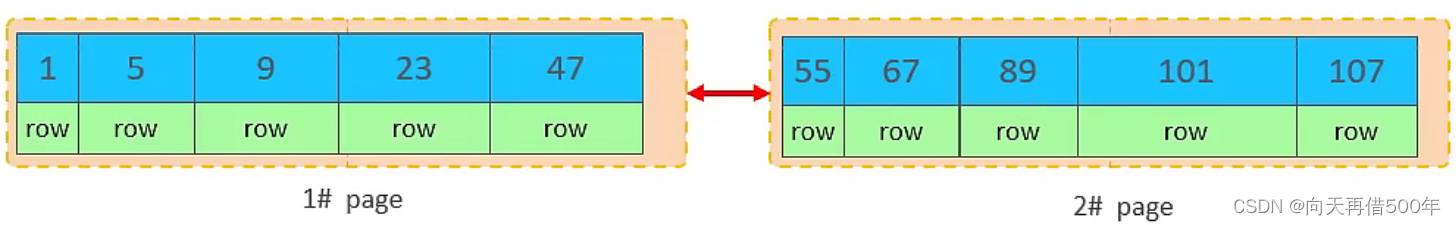

主键乱序插入效果

- 加入1#,2#页都已经写满了,存放了如图所示的数据

- 此时再插入id为50的记录

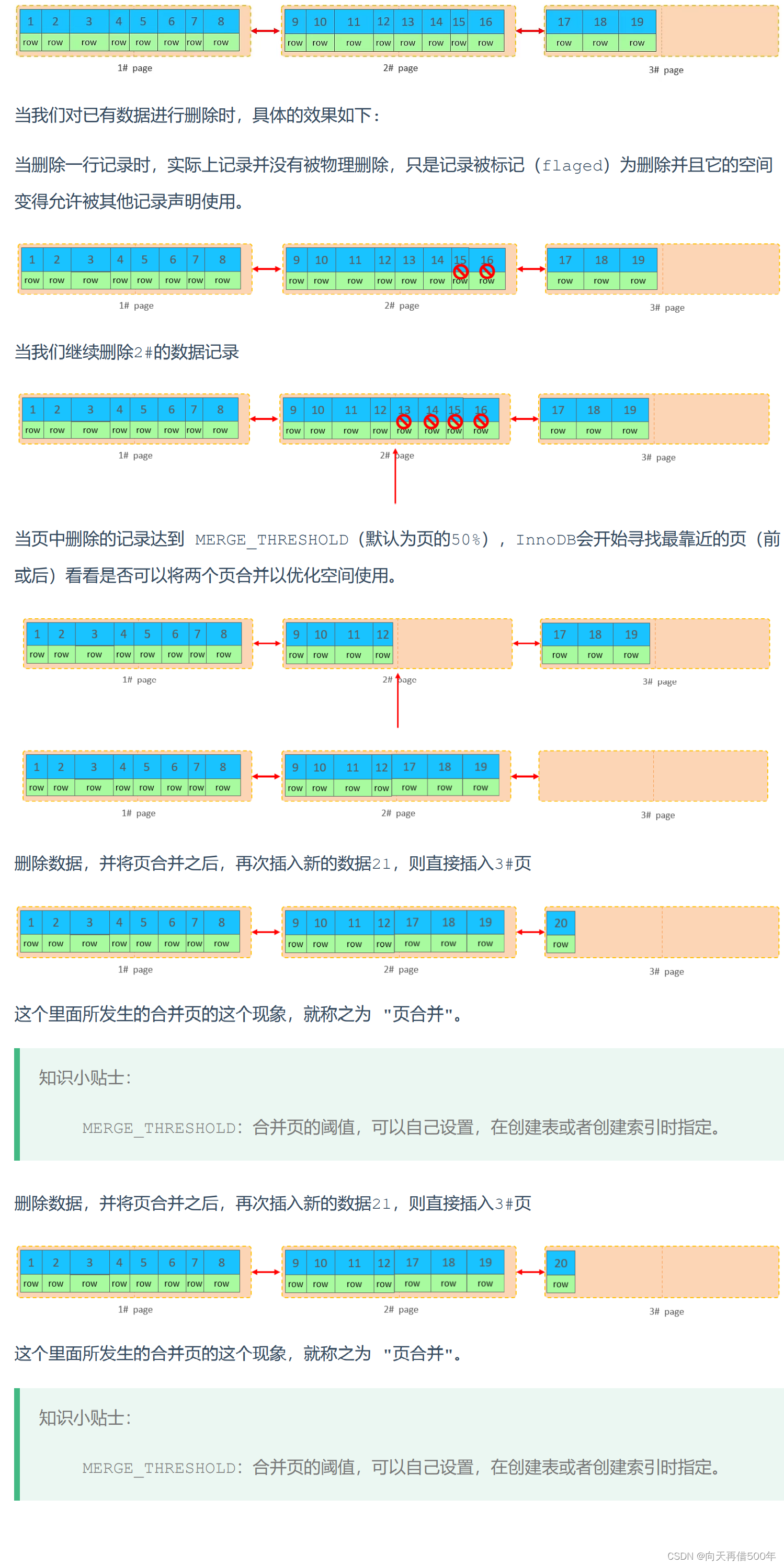

页合并

目前表中已有数据的索引结构(叶子节点)如下:

主键设计原则

- 满足业务需求的情况下,尽量降低主键的长度。

- 插入数据时,尽量选择顺序插入,选择使用AUTO_INCREMENT自增键。

- 尽量不要使用UUID做主键或者是其他自然主键,如身份证号。

- 业务操作时,避免对主键的修改。

order by优化

MySQL的排序,有两种方式:

- Using filesort : 通过表的索引或全表扫描,读取满足条件的数据行,然后在排序缓冲区sortbuffer中完成排序操作,所有不是通过索引直接返回排序结果的排序都叫 FileSort 排序。

- Using index : 通过有序索引顺序扫描直接返回有序数据,这种情况即为 using index,不需要额外排序,操作效率高。

对于以上的两种排序方式,Using index的性能高,而Using filesort的性能低,我们在优化排序 操作时,尽量要优化为 Using index。

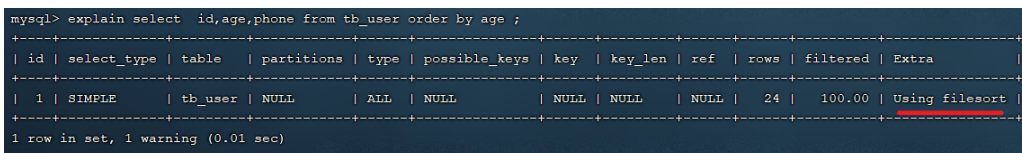

explainselect id,age,phone from tb_user orderby age ;

explainselect id,age,phone from tb_user orderby age, phone ;

由于 age, phone 都没有索引,所以此时再排序时,出现Using filesort, 排序性能较低

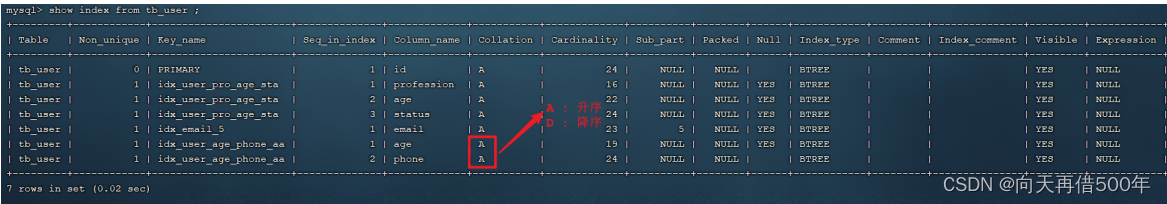

创建索引

-- 创建索引createindex idx_user_age_phone_aa on tb_user(age,phone);

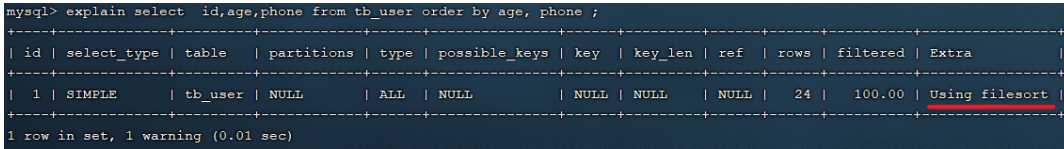

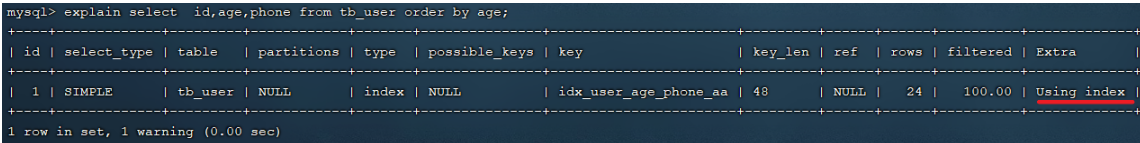

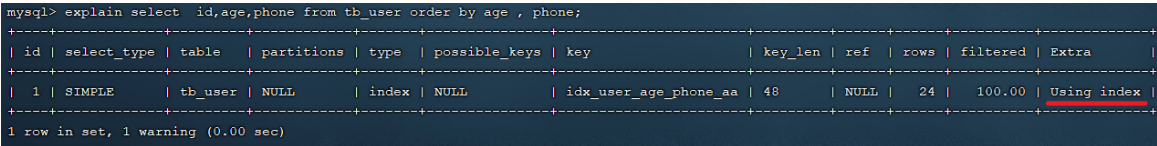

创建索引后,根据age, phone进行升序排序

explainselect id,age,phone from tb_user orderby age;

explainselect id,age,phone from tb_user orderby age , phone;

建立索引之后,再次进行排序查询,就由原来的Using filesort, 变为了 Using index,性能就是比较高的了。

创建索引后,根据age, phone进行降序排序

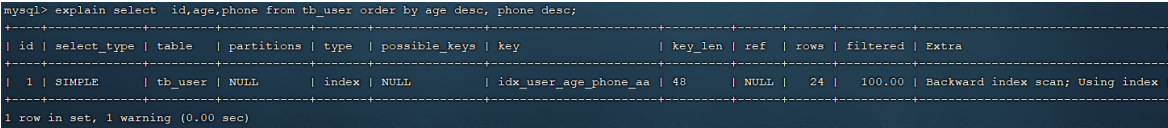

explainselect id,age,phone from tb_user orderby age desc, phone desc;

也出现 Using index, 但是此时Extra中出现了 Backward index scan,这个代表反向扫描索引,因为在MySQL中我们创建的索引,默认索引的叶子节点是从小到大排序的,而此时我们查询排序时,是从大到小,所以,在扫描时,就是反向扫描,就会出现 Backward index scan。 在MySQL8版本中,支持降序索引,我们也可以创建降序索引

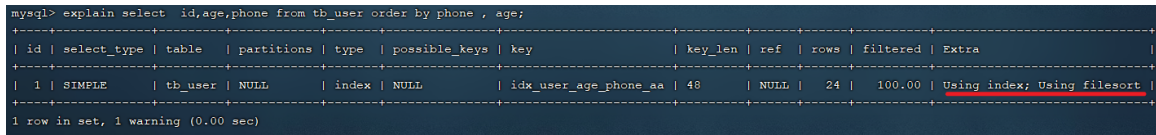

根据phone,age进行升序排序,phone在前,age在后

explainselect id,age,phone from tb_user orderby phone , age;

排序时,也需要满足最左前缀法则,否则也会出现 filesort。因为在创建索引的时候, age是第一个字段,phone是第二个字段,所以排序时,也就该按照这个顺序来,否则就会出现 Usingfilesort。

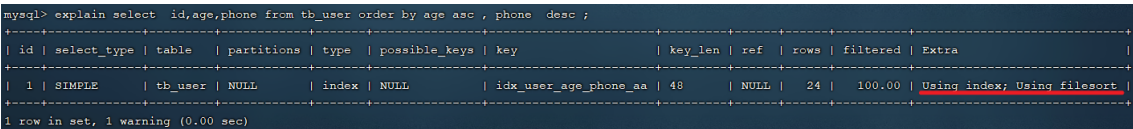

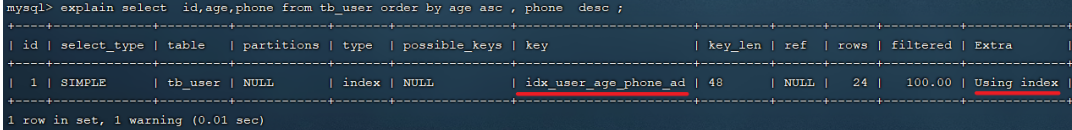

根据age, phone进行降序一个升序,一个降序

explainselect id,age,phone from tb_user orderby age asc, phone desc;

因为创建索引时,如果未指定顺序,默认都是按照升序排序的,而查询时,一个升序,一个降序,此时就会出现Using filesort。

为了解决上述的问题,我们可以创建一个索引,这个联合索引中 age 升序排序,phone 倒序排序。

创建联合索引(age 升序排序,phone 倒序排序)

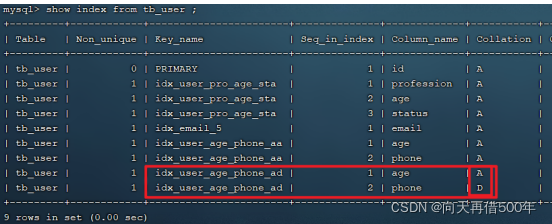

createindex idx_user_age_phone_ad on tb_user(age asc,phone desc);

explainselect id,age,phone from tb_user orderby age asc, phone desc;

order by优化原则

- 根据排序字段建立合适的索引,多字段排序时,也遵循最左前缀法则。

- 尽量使用覆盖索引。

- 多字段排序, 一个升序一个降序,此时需要注意联合索引在创建时的规则(ASC/DESC)。

- 如果不可避免的出现filesort,大数据量排序时,可以适当增大排序缓冲区大小sort_buffer_size(默认256k)。

group by优化

分组操作,我们主要来看看索引对于分组操作的影响。

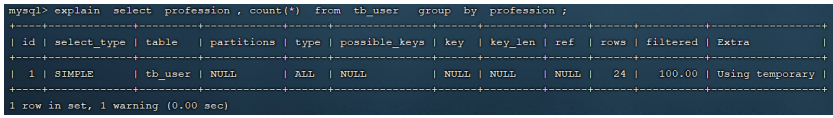

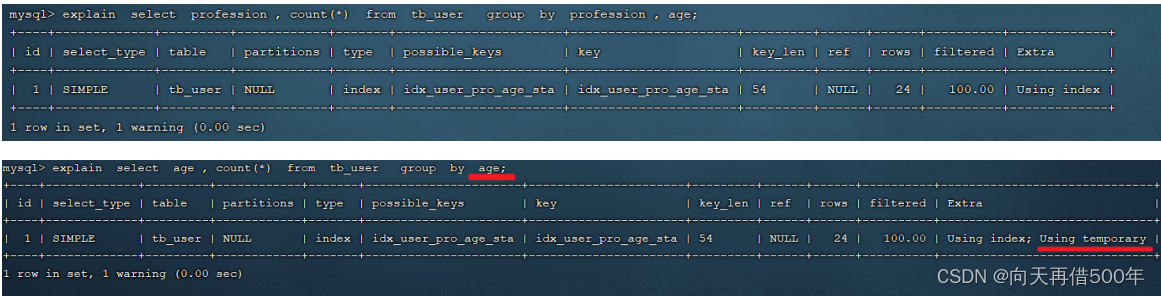

接下来,在没有索引的情况下,执行如下SQL,查询执行计划:

explainselect profession ,count(*)from tb_user groupby profession ;

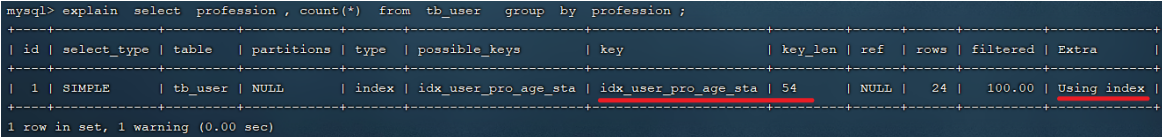

然后,我们在针对于 profession , age, status 创建一个联合索引。

createindex idx_user_pro_age_sta on tb_user(profession , age ,status);

紧接着,再执行前面相同的SQL查看执行计划。

explainselect profession ,count(*)from tb_user groupby profession ;

再执行如下的分组查询SQL,查看执行计划:

我们发现,如果仅仅根据age分组,就会出现 Using temporary ;而如果是 根据profession,age两个字段同时分组,则不会出现 Using temporary。原因是因为对于分组操作,在联合索引中,也是符合最左前缀法则的。

group by优化原则

- 在分组操作时,可以通过索引来提高效率。

- 分组操作时,索引的使用也是满足最左前缀法则的。

limit优化

在数据量比较大时,如果进行limit分页查询,在查询时,越往后,分页查询效率越低。

通过测试我们会看到,越往后,分页查询效率越低,这就是分页查询的问题所在。因为,当在进行分页查询时,如果执行 limit 2000000,10 ,此时需要MySQL排序前2000010 记录,仅仅返回 2000000 - 2000010 的记录,其他记录丢弃,查询排序的代价非常大 。

优化思路: 一般分页查询时,通过创建 覆盖索引 能够比较好地提高性能,可以通过覆盖索引加子查询形式进行优化。

explainselect*from tb_sku t ,(select id from tb_sku orderby id

limit2000000,10) a where t.id = a.id;

count优化

selectcount(*)from tb_user ;

在之前的测试中,我们发现,如果数据量很大,在执行count操作时,是非常耗时的。

MyISAM 引擎把一个表的总行数存在了磁盘上,因此执行 count() 的时候会直接返回这个数,效率很高; 但是如果是带条件的count,MyISAM也慢。

InnoDB 引擎就麻烦了,它执行 count() 的时候,需要把数据一行一行地从引擎里面读出来,然后累积计数。

count用法

count() 是一个聚合函数,对于返回的结果集,一行行地判断,如果 count 函数的参数不是NULL,累计值就加 1,否则不加,最后返回累计值。

用法:count()、count(主键)、count(字段)、count(数字)

count用法含义count(主键)InnoDB 引擎会遍历整张表,把每一行的 主键id 值都取出来,返回给服层。服务层拿到主键后,直接按行进行累加(主键不可能为null)count(字段)没有not null 约束 : InnoDB 引擎会遍历整张表把每一行的字段值都取出来,返回给服务层,服务层判断是否为null,不为null,计数累加。有not null 约束:InnoDB 擎会遍历整张表把每一行的字段值都取出来,返回给服务层,直接按行进行累加。count(数字)InnoDB 引擎遍历整张表,但不取值。服务层对于返回的每一行,放一个数字“1”进去,直接按行进行累加。count()InnoDB引擎并不会把全部字段取出来,而是专门做了优化,不取值,服务层直接按行进行累加。

按照效率排序的话,count(字段) < count(主键 id) < count(1) ≈ count(),所以尽量使用 count()。

update优化

我们主要需要注意一下update语句执行时的注意事项。

update course set name ='javaEE'where id =1;

当我们在执行删除的SQL语句时,会锁定id为1这一行的数据,然后事务提交之后,行锁释放。

但是当我们在执行如下SQL时。

update course set name ='SpringBoot'where name ='PHP';

当我们开启多个事务,在执行上述的SQL时,我们发现行锁升级为了表锁。 导致该update语句的性能大大降低。

InnoDB的行锁是针对索引加的锁,不是针对记录加的锁 ,并且该索引不能失效,否则会从行锁升级为表锁 。

版权归原作者 向天再借500年 所有, 如有侵权,请联系我们删除。