hadoop格式化失败-拒绝连接

1.项目场景

搭建hadoop高可用集群

包含两个namenode,该集群结合zookeeper自动故障转移功能

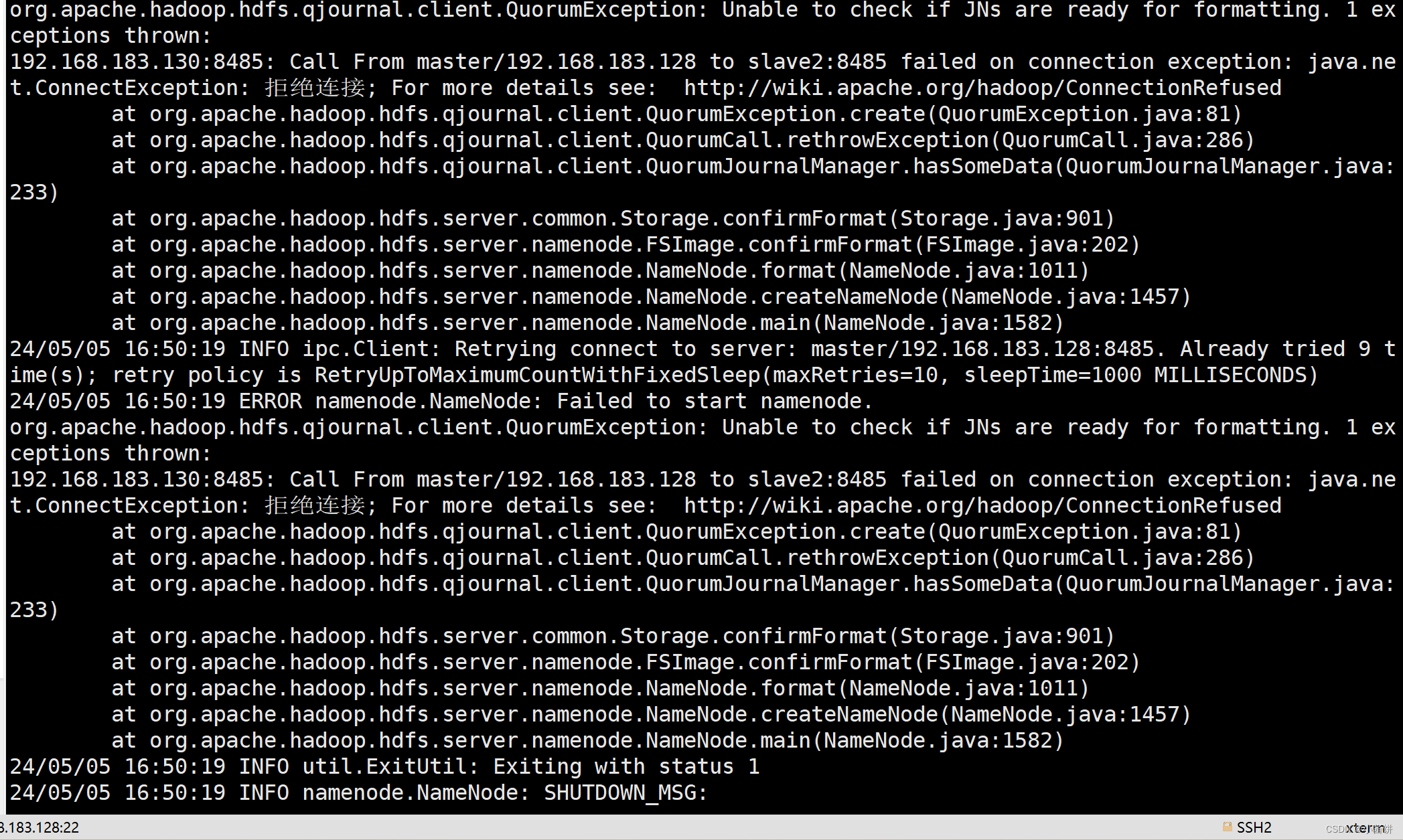

2.问题描述

当我们安装,配置Hadoop之后,启动zookeeper都没出现问题但是初始化出现了问题该如何解决

3.原因分析

1.配置文件

配置文件(

hdfs-site.xml

core-site.xml

yarn-site.xml

mapred-site.xml

hadoop-env.sh

mapred-env.sh

yarn-env.sh

)这个需自己检查

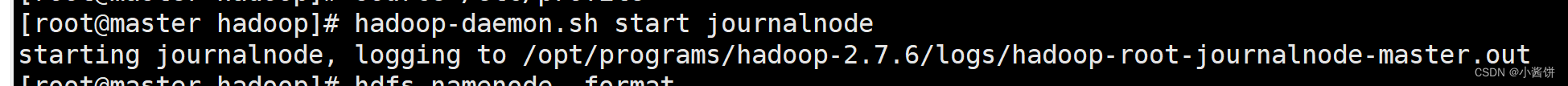

2.journalnode没启动

[注意]:集群 搭建完成之后,由于第一次启动Hadoop,故启动之前需格式化namenode,而格式化之前需启动journalnode(3个节点分别执行)之后不需格式化和启动journalnode。

hadoop-daemon.sh start journalnode

解决方案

当我们发现Hadoop格式化失败并且是拒绝连接时

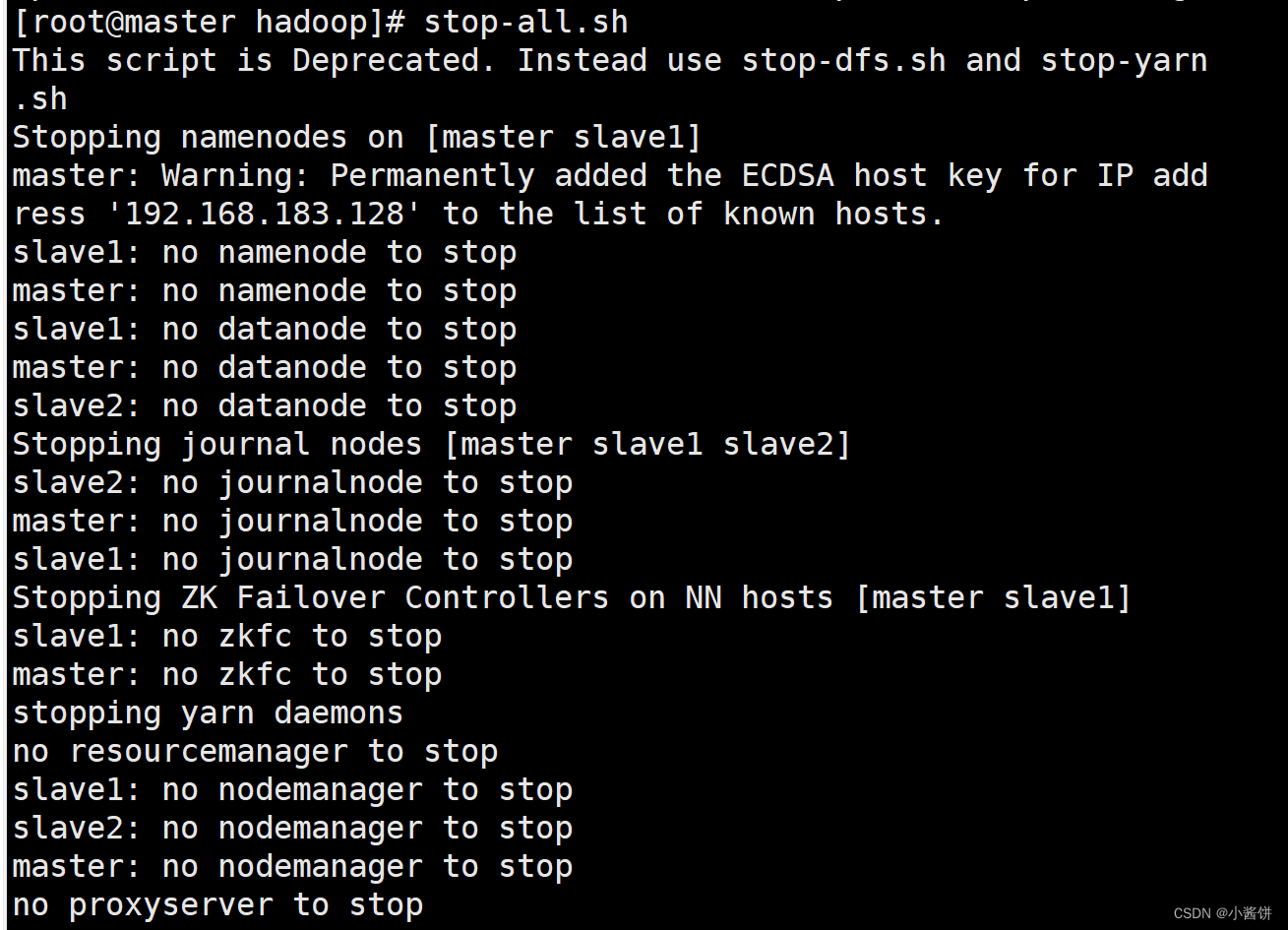

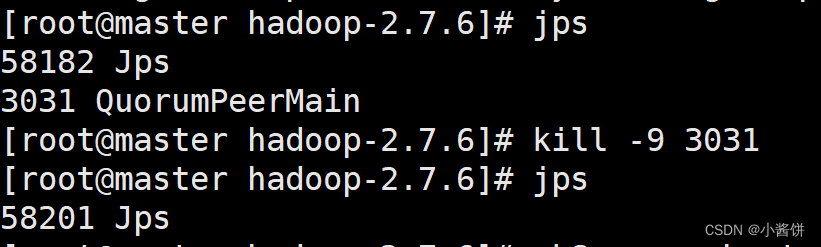

1.停止当前所有进程

stop-all.sh

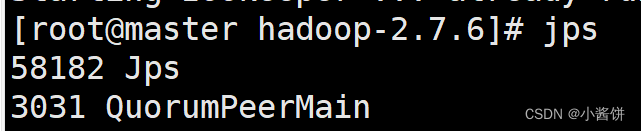

通过

jps

命令查看当前进程是否全部关闭

如果zookeeper进程没有停止可通过

kill -9 3031

将其杀死,也可通过

zkServer.sh stop

将zookeeper停止

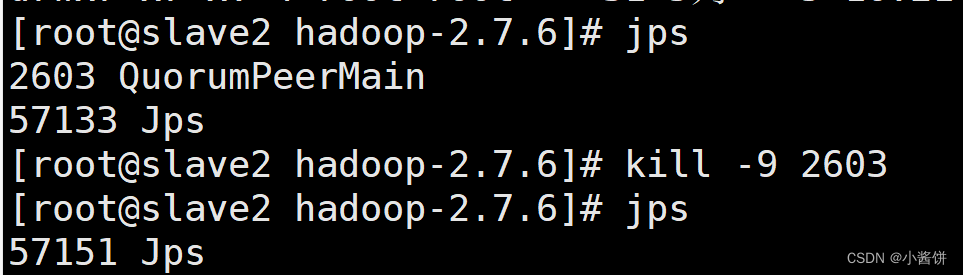

slave1,slave2同理

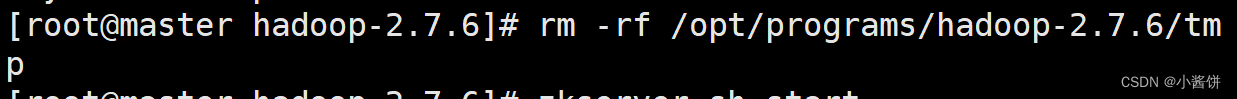

2.将tmp文件删除

rm-rf /opt/programs/hadoop-2.7.6/tmp

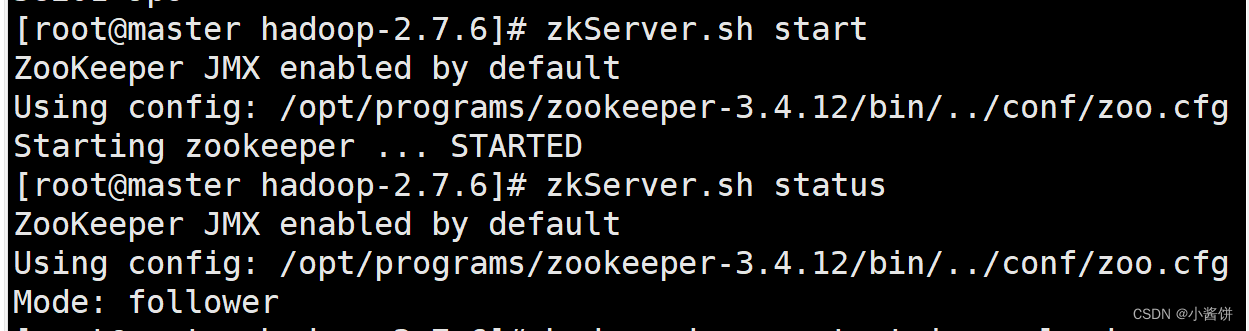

3.重新启动zookeeper

zkServer.sh start

zkServer.sh status

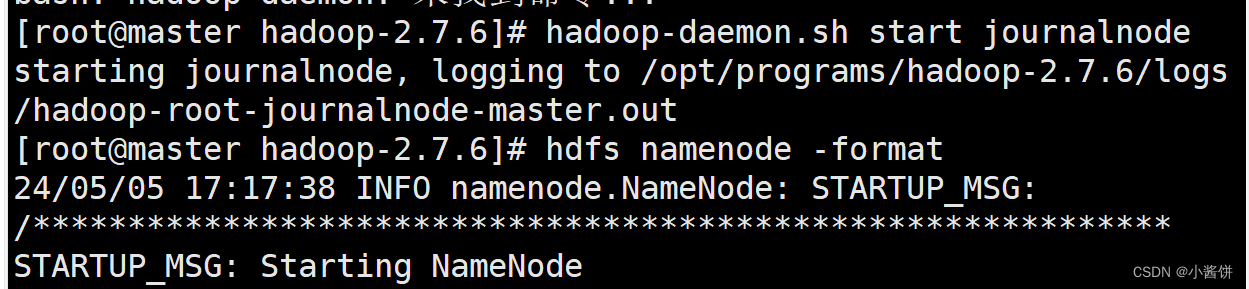

4.重新格式化

重新启动

journalnode

和格式化

hdfs namenode -format

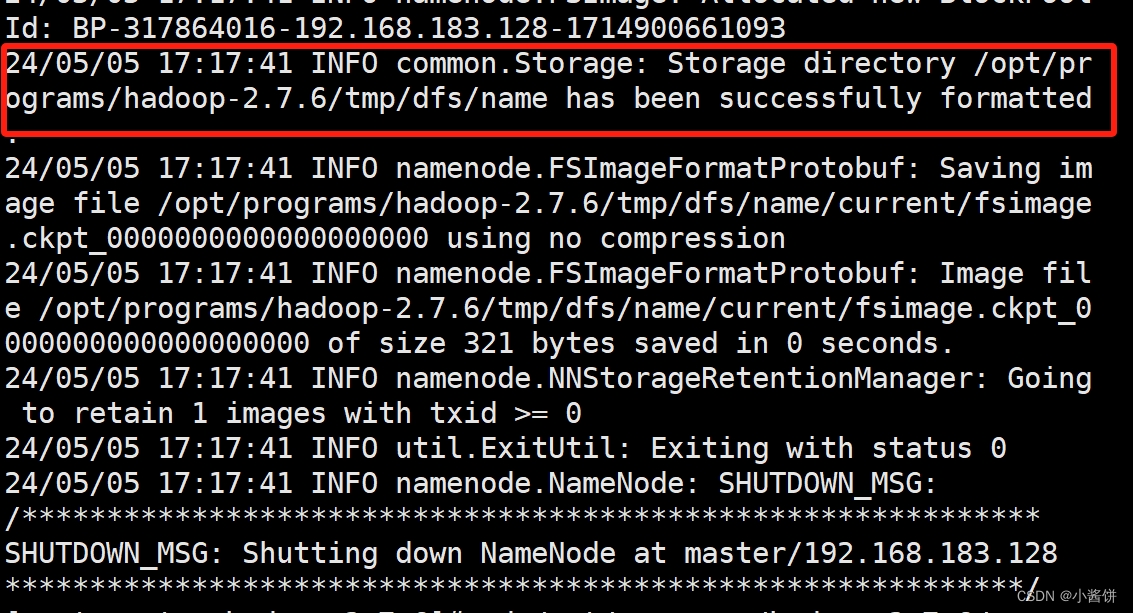

当出现这条信息时,说明格式化成功

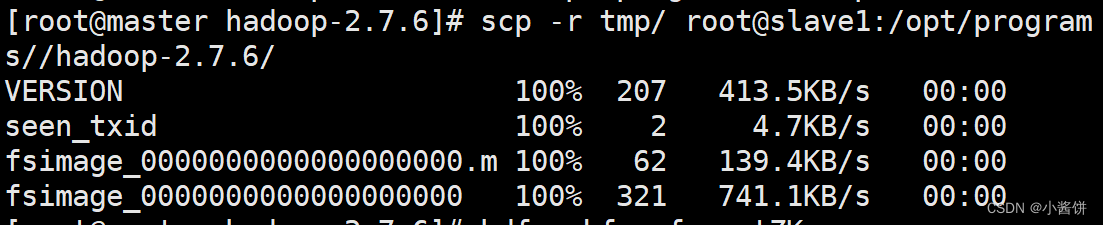

5.远程复制

进入到

cd /opt/programs/hadoop-2.7.6/

目录中

将master目录下tmp文件远程复制到slave1Hadoop目录下

scp-r tmp/ root@slave1:/opt/programs//hadoop-2.7.6/

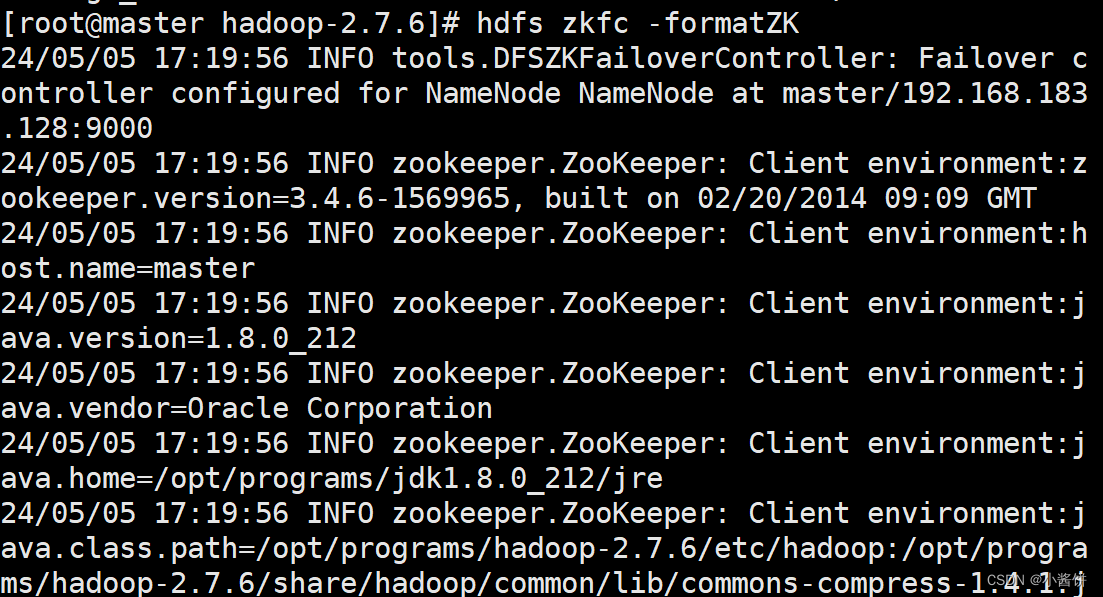

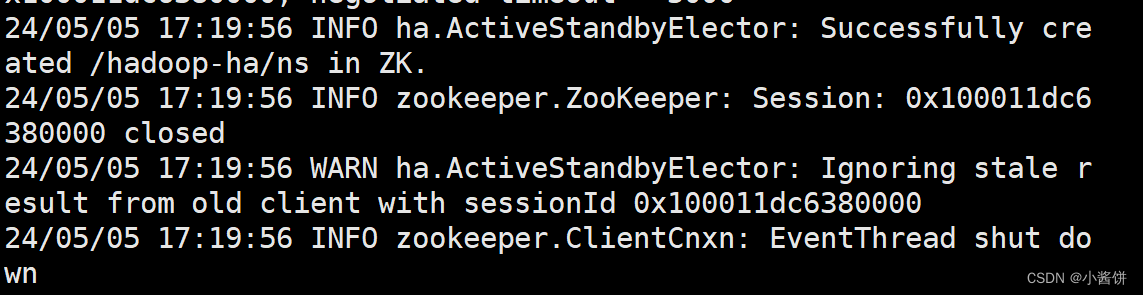

6.在master节点格式化ZKFC

在master节点格式化ZKFC

hdfs zkfc -formatZK

出现该信息说明格式化成功

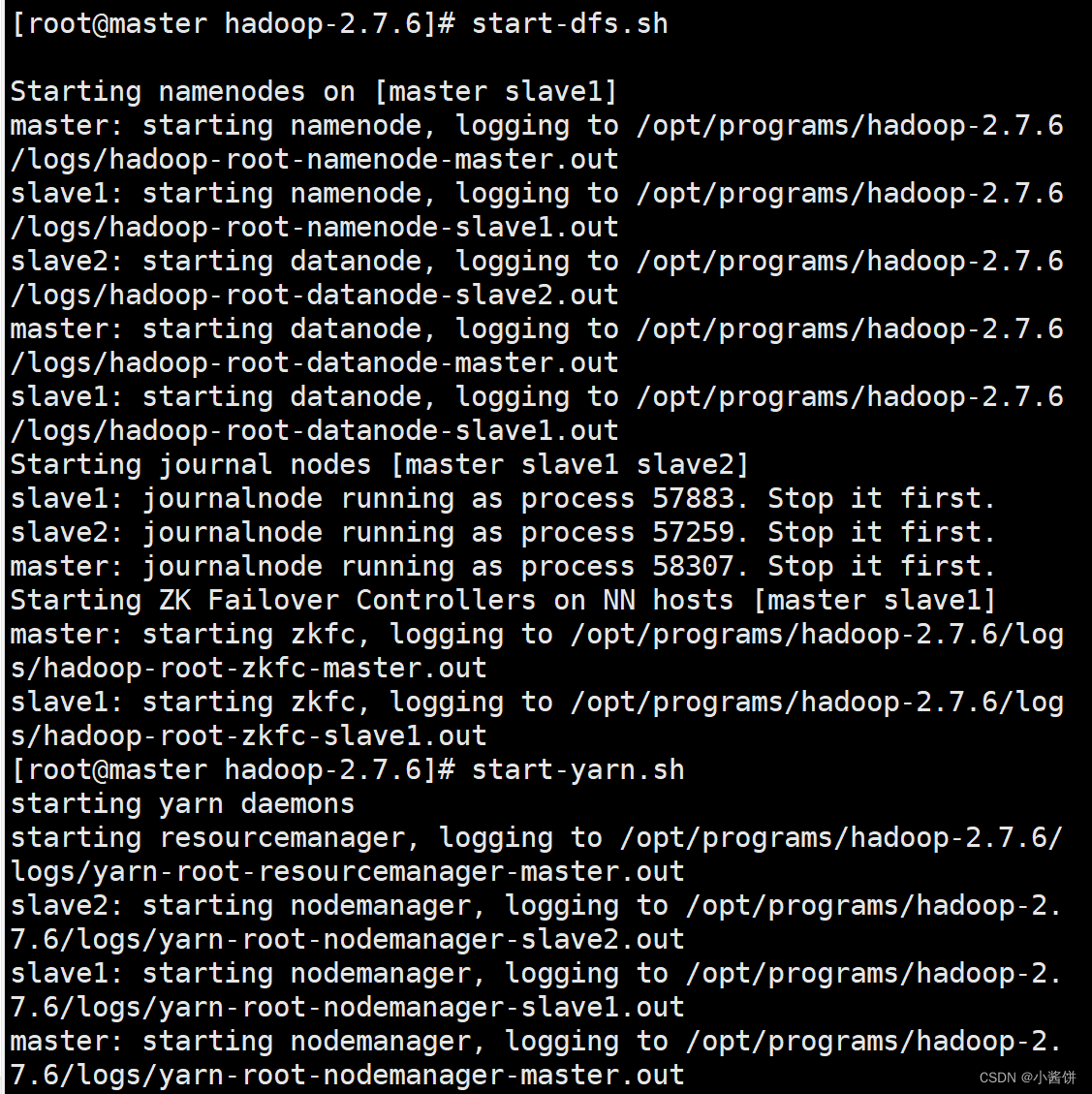

7.在master启动dfs和yarn

在master节点启动

start-dfs.sh

和

start-yarn.sh

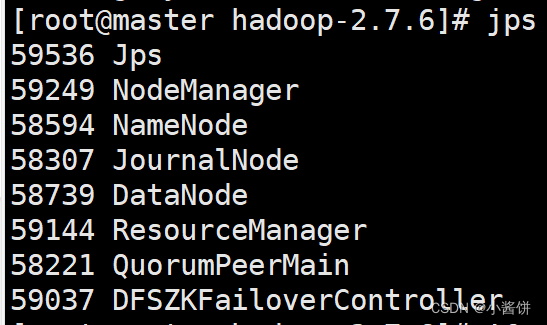

通过

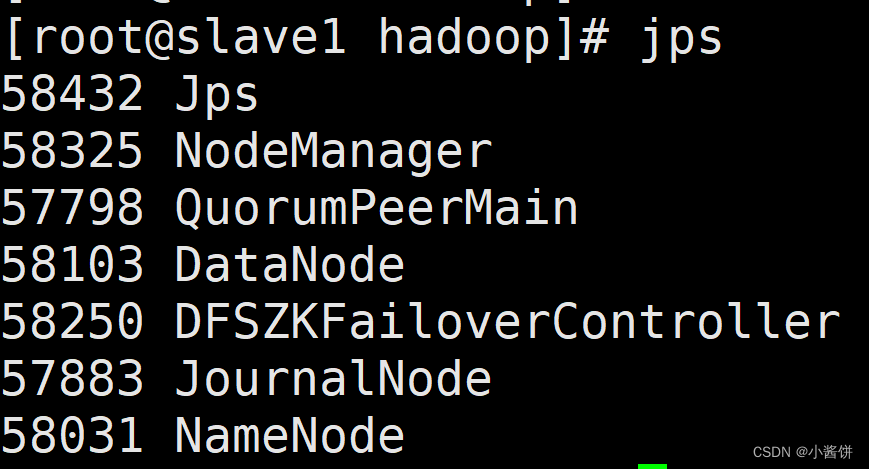

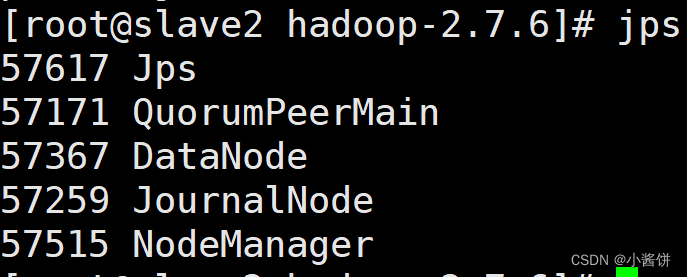

jps

查看各节点进程

总结

以上就是今天要讲的内容,本文仅仅简单介绍了格式化失败-拒绝连接的原因及解决办法,本文搭建的是hadoop的高可用集群经常会遇到的问题。

Hadoop的高可用性:Hadoop的NameNode包括active和standby两种状态,通过故障转移机制(即当active NameNode意外终止时,快速启动stantby NameNode)可保证HDFS的高可用性

版权归原作者 小酱饼 所有, 如有侵权,请联系我们删除。