博主使用的配置是

x86_64 Linux服务器

第一步设置代理镜像:

export HF_ENDPOINT=https://hf-mirror.com

第二步(使用代码时,删除引号):

--token参数表示下载的模型是否需要登录验证(部分模型需要token)

huggingface-cli download --token "获取的hf_*******token" --resume-download --local-dir-use-symlinks False "HuggingFace上对应的模型名称" --local-dir "下载到本地的地址"

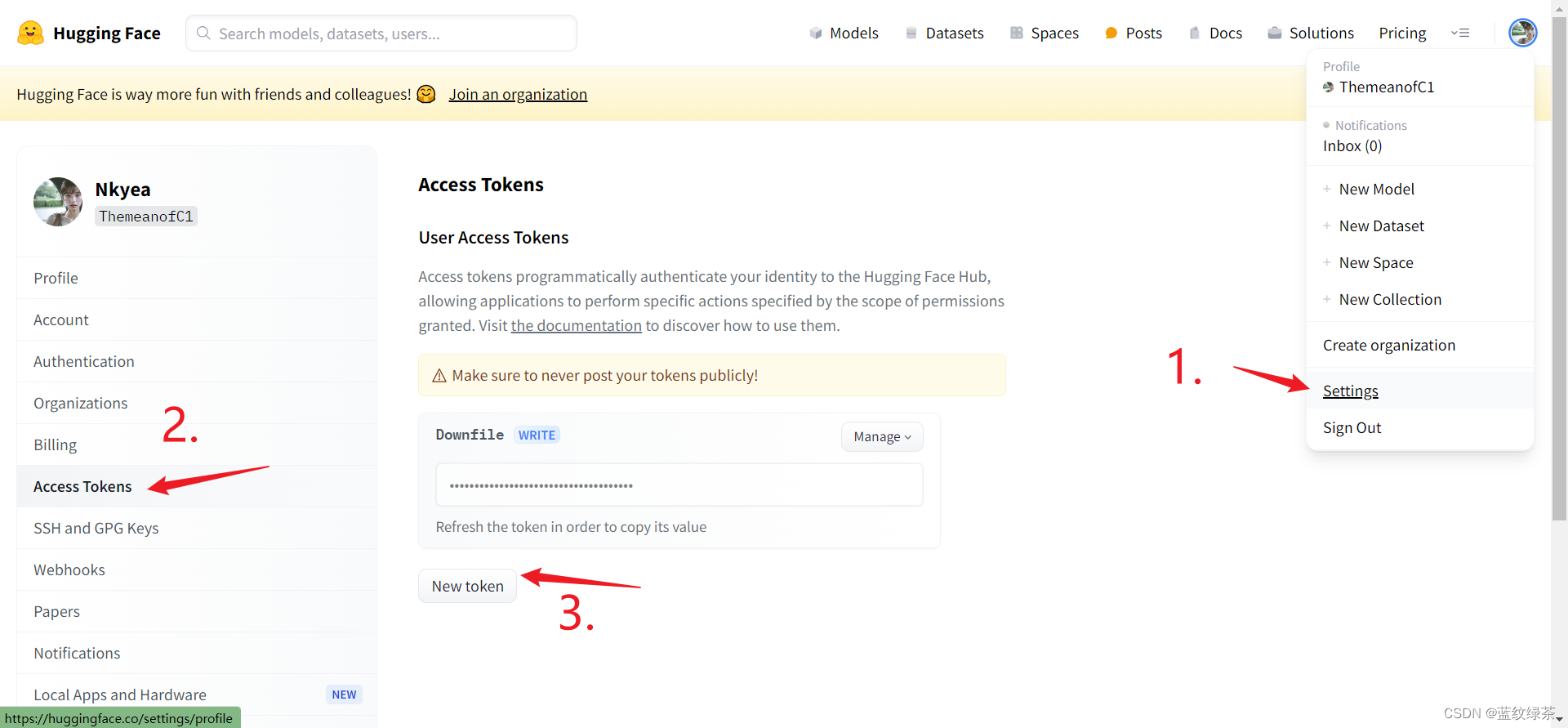

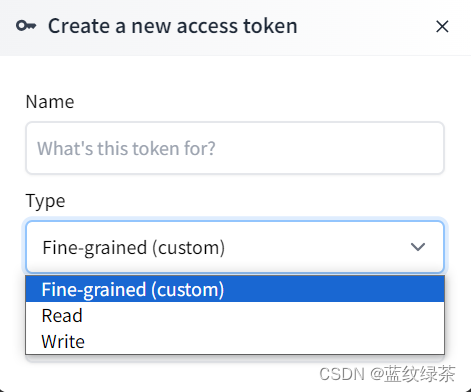

如何获取token

切记设置的权限需要Write

(二)下载方式2

如果需要对模型中的单个文件或者文件夹中的文件下载可使用以下命令

第一步:进入python

第二步:

from huggingface_hub import login

login()

第三步:

hf_hub_download(repo_id="meta-llama/Meta-Llama-3-8B-Instruct ", filename="original/*", local_dir="/data")

(三)下载方式3

使用黑科技

第一步:

pip install -U hf-transfer

第二步:设置环境变量

Linux

export HF_HUB_ENABLE_HF_TRANSFER=1

Windows Powershell

$env:HF_HUB_ENABLE_HF_TRANSFER = 1

之后使用代码:

huggingface-cli download --token "获取的hf_*******token" --resume-download --local-dir-use-symlinks False "HuggingFace上对应的模型名称" --local-dir "下载到本地的地址"

版权归原作者 蓝纹绿茶 所有, 如有侵权,请联系我们删除。