前言

在生产环境中,akfka集群下的每台服务器的配置和性能可能不一样,但Kafka集群只会根据配置规则创建对应的分区副本,这样一来可能就会导致个别服务器存储压力较大。

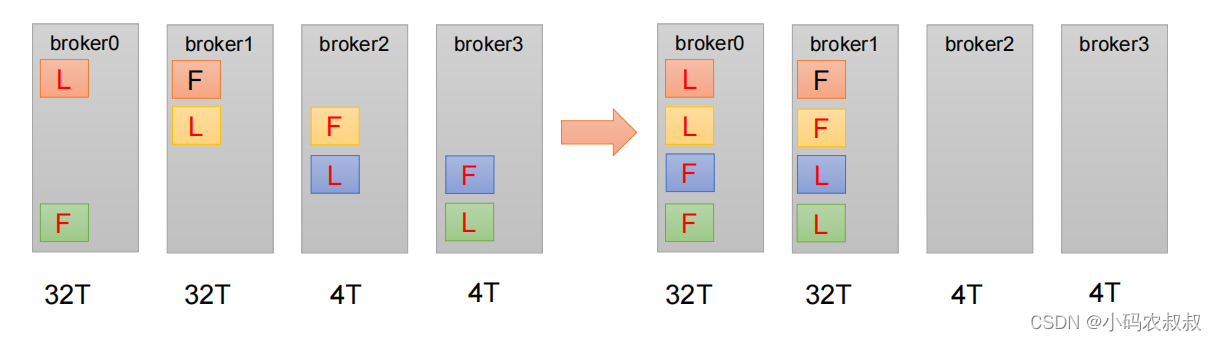

在这种情况下,就需要手动调整分区副本的存储。我们不妨看看下面的这张图就明白了

上图的传达的意思是:

broker0和broker1所在的服务器配置较高,存储容量较大,但是broker2和broker3所在的机器配置稍差存储容量较小,一开始创建出主题之后,集群只会按照默认的配置规则,将leader和follower均匀的分配到不同的节点上去,并不知道具体哪一台机器的配置如何;

但实际上,我们希望某台服务器承担更多的读写压力,这样的话,就需要事后人为进行手动的对分区副本的调整

来看看我们的需求

创建一个新的topic,4个分区,两个副本,名为three,将 该topic的所有副本都存储到broker1和broker2两台服务器上

前置准备

- centos7服务器,虚拟机或者云服务器

- 提前安装好kafka集群,并启动集群,关于集群搭建,可以参考 kafka集群服役新节点

操作步骤

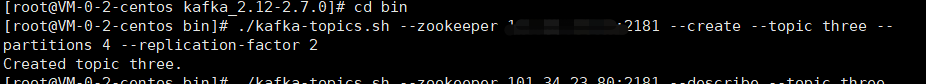

1、创建一个主题,4个分区,2个副本

./kafka-topics.sh --zookeeper IP:2181 --create --topic three --partitions 4 --replication-factor 2

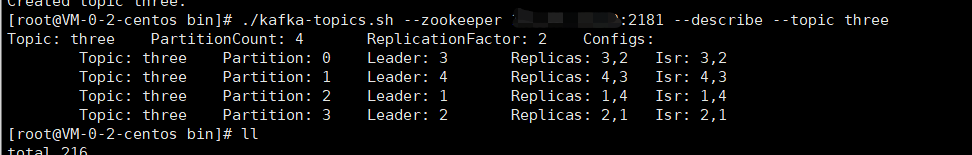

2、检查下当前创建的topic情况

./kafka-topics.sh --zookeeper IP:2181 --describe --topic three

从副本的分布情况来看,副本目前尽可能的分布在不同的机器上,而我们的需求是期望所有的数据尽可能存储在broker1和broker2上面

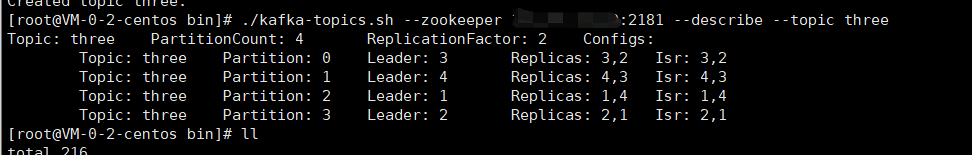

3、创建副本存储计划

这个有点类似于前面的章节中我们讲到的服役新节点的操作,在bin目录下创建一个json文件,手动指定分区副本的存储位置

创建一个名字叫做 increase-replication-factor.json 的文件,将如下内容拷贝进去,关于下面这段内容,相信大家都能看得懂,实际操作过程中,需要结合自己kafka集群下的机器配置情况合理调整,我这里按照原始需求,假定broker3和broker4的配置稍差,于是将副本尽可能的配置到broker1和broker2上

{"version":1,

"partitions":[{"topic":"three","partition":0,"replicas":[1,2]},

{"topic":"three","partition":1,"replicas":[1,2]},

{"topic":"three","partition":2,"replicas":[2,1]},

{"topic":"three","partition":3,"replicas":[2,1]}]}

4、执行存储计划

./kafka-reassign-partitions.sh --zookeeper IP:2181 --reassignment-json-file increase-replication-factor.json --execute

看到下面的内容,说明计划执行完毕,

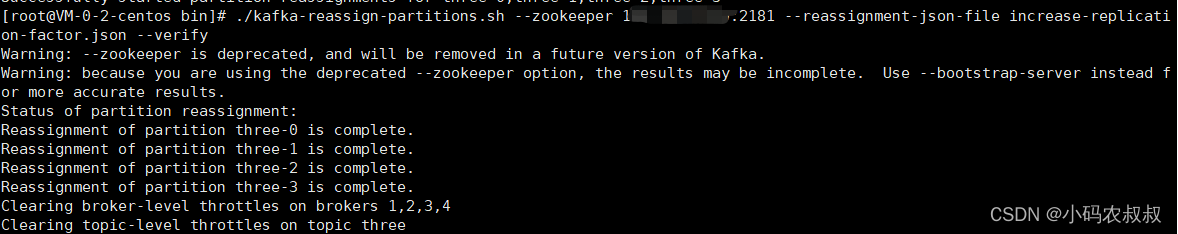

5、验证第四步中的执行计划

./kafka-reassign-partitions.sh --zookeeper IP:2181 --reassignment-json-file increase-replication-factor.json --verify

看到下面的内容,说明副本执行计划完成执行

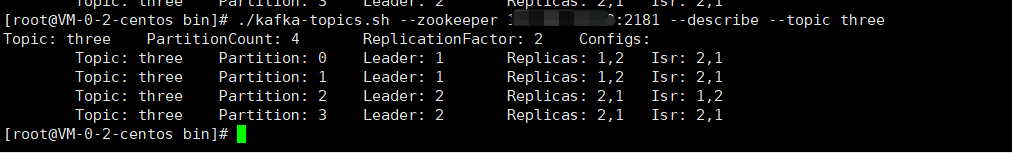

6、再次查看副本存储情况

./kafka-topics.sh --zookeeper IP:2181 --describe --topic three

与第一次的对比,重新分配之后,副本都转移到了broker1和broker2上面了

通过上面的操作步骤,我们就完成了手动调整分区副本的需求

增加副本

在生产环境中,假如某个主题重要等级需提升,则可以考虑在现有的基础上增加副本。副本数的增加需要先制定计划,然后根据计划执行,这个和之前的kafka集群服役新节点以及上文调整分区副本类似

下面来看看具体的操作步骤

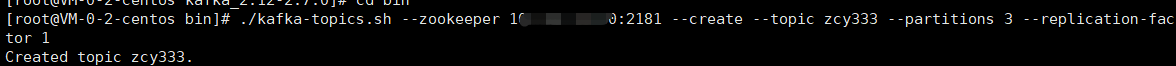

1、创建一个新的主题,3个分区,1个副本

./kafka-topics.sh --zookeeper IP:2181 --create --topic zcy333 --partitions 3 --replication-factor 1

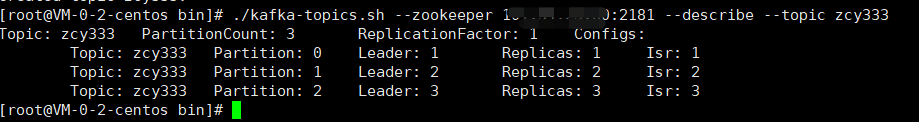

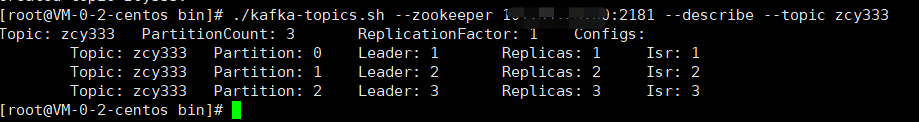

2、查看当前主题的分区副本存储情况

./kafka-topics.sh --zookeeper IP:2181 --describe --topic zcy333

从展示情况来看,目前副本只有一个,因此我们的需求是增加副本数量

3、创建副本存储计划

所有副本都指定存储在 broker1、broker2、broker3 中

增加一个increase-replication-factor.json的文件,将下面的内容拷贝进去

{"version":1,

"partitions":[{"topic":"zcy333","partition":0,"replicas":[1,2,3]},

{"topic":"zcy333","partition":1,"replicas":[1,2,3]},

{"topic":"zcy333","partition":2,"replicas":[1,2,3]}]}

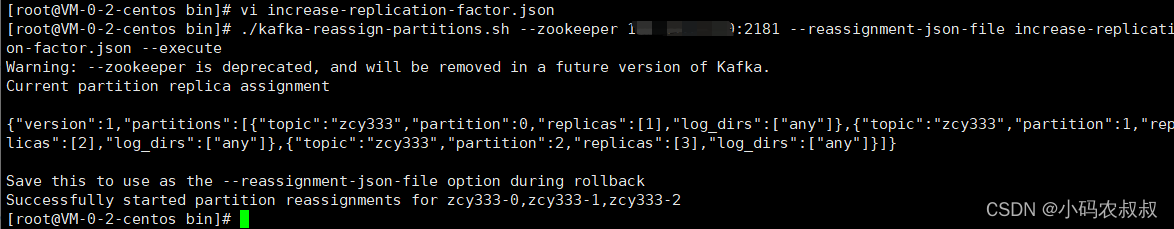

4、执行副本存储计划

./kafka-reassign-partitions.sh --zookeeper IP:2181 --reassignment-json-file increase-replication-factor.json --execute

看到下面的内容,说明执行成功

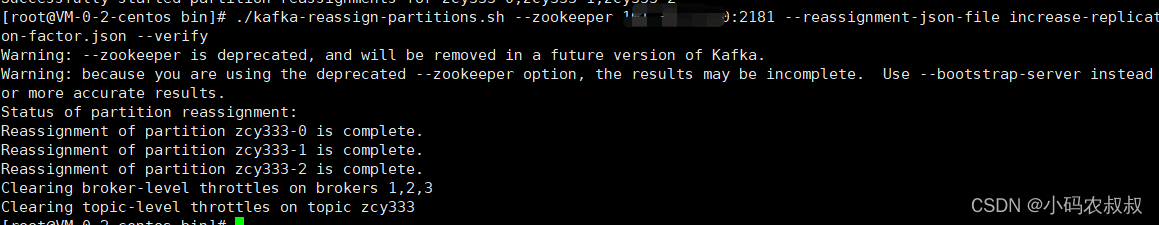

可以使用下面的命令,验证执行计划

./kafka-reassign-partitions.sh --zookeeper IP:2181 --reassignment-json-file increase-replication-factor.json --verify

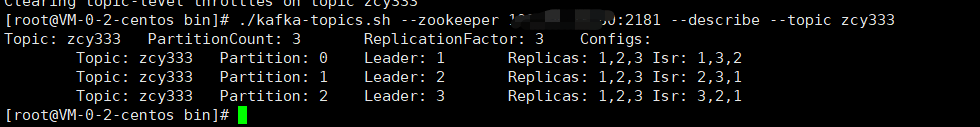

5、再次查看执行后的主题分区副本情况

./kafka-topics.sh --zookeeper IP:2181 --describe --topic zcy333

可以对比执行后的情况与执行之前的情况,明显发现通过上面的操作,针对zcy333这个topic,副本增加了

通过上面的操作,我们成功对现有的topic的副本数进行了增加

版权归原作者 小码农叔叔 所有, 如有侵权,请联系我们删除。