1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

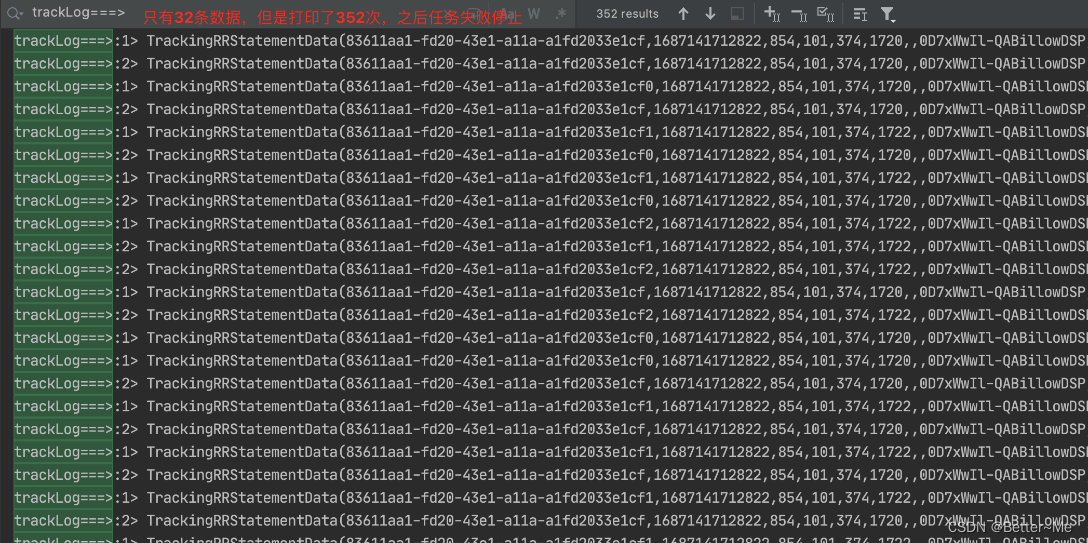

Idea中执行任务时,没法看到JobManager的错误,以至于我以为是什么特殊的原因导致任务总是反复消费。在close方法中,增加日志,发现jdbc连接被关闭了。 重新消费,jdbc连接又启动了。

注意,在Flink的函数中,open和close方法只在任务启动和结束的时候执行一次。反之,可以推理出,如果close方法被执行了,那么说明任务挂了。

在本地任务中增加本地Flink UI,很明显可以看到任务在不断的重启。JobManager中有明显的Exception,就是

SQLSyntaxErrorException:Unknown column 'day_after_back' in 'field list'

版权归原作者 Better~Me 所有, 如有侵权,请联系我们删除。