一、实战概述

在本次实战任务中,我们的目标是在大数据环境下利用Hive工具进行词频统计。以下是详细步骤和关键操作的优化描述:

- 数据源准备:- 将测试用的文本文件

test.txt上传到HDFS的/hivewc/input目录,以便Hive高效访问数据。 - Hive环境准备:- 启动Hive Metastore服务,确保Hive元数据存储正常运行。- 启动Hive客户端,方便后续的数据操作和查询。

- 数据表创建:- 在Hive客户端中创建一个名为

t_word的外部表,仅包含一个word字段,类型为字符串,用于存储拆分后的单词。- 将表的位置设置为HDFS中的/hivewc/input目录,实现Hive与HDFS数据的无缝对接。 - 词频统计逻辑实现:- 使用一条优化过的Hive SQL语句实现词频统计。该语句利用explode和split函数高效拆分每个句子为单个单词。- 通过子查询和分组操作对单词进行计数,确保准确统计每个单词的频率。

- 结果分析与展望:- 执行优化后的SQL语句,高效完成词频统计任务,并获得准确结果。- 通过这个实战任务,加深对Hive的理解和应用能力,为今后的数据处理工作积累经验。- 在大数据分析和处理任务中,这些经验将发挥重要的指导作用。

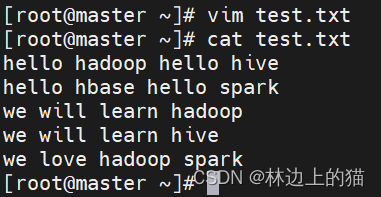

二、提出任务

- 对以下数据进行,进行词频统计

hello hadoop hello hive

hello hbase hello spark

we will learn hadoop

we will learn hive

we love hadoop spark

三、完成任务

(一)准备数据文件

1、在虚拟机上创建文本文件

- 在master虚拟机上创建

test.txt文件

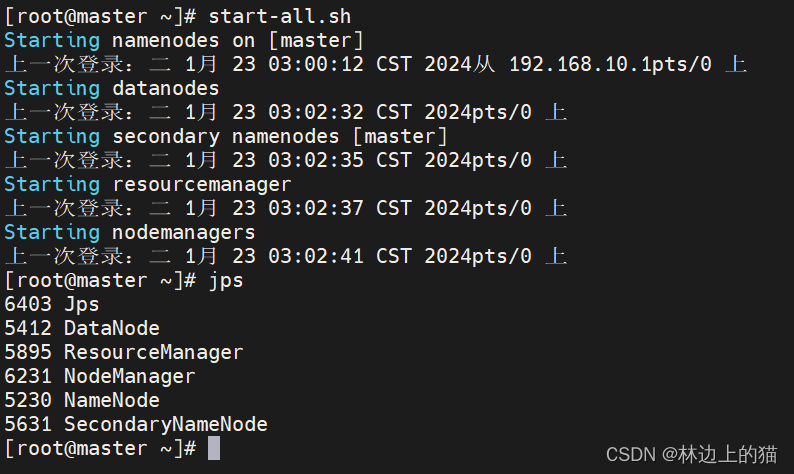

2、启动Hadoop服务

- 执行命令:

start-all.sh

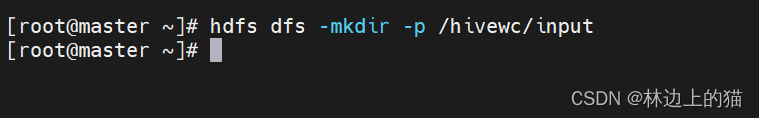

3、将文本文件上传到HDFS指定目录

- 在HDFS上创建

/hivewc/input目录

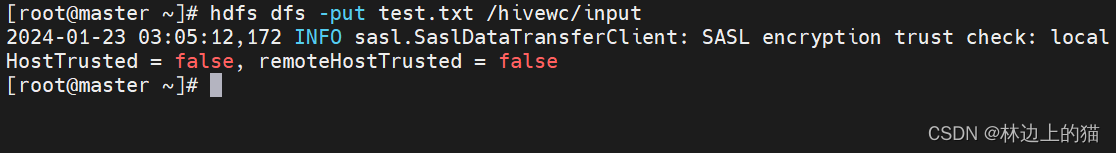

- 将

test.txt文件上传到HDFS的/hivewc/input目录

(二)实现步骤

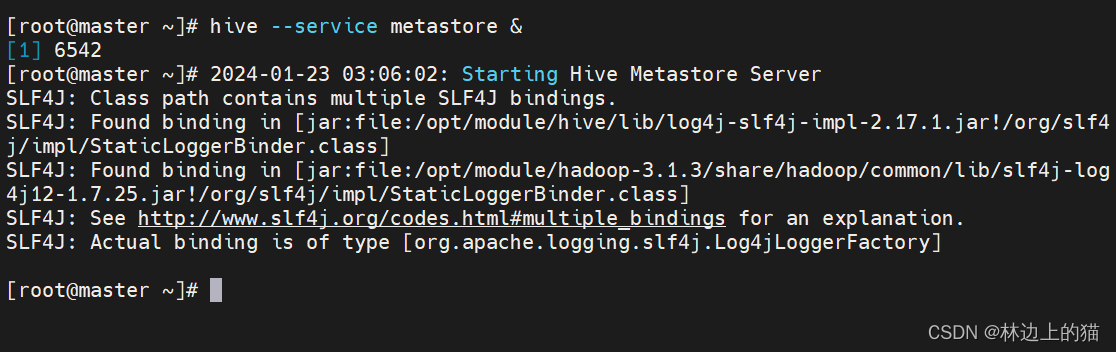

1、启动Hive Metastore服务

- 我们需要启动Hive Metastore服务,这是Hive的元数据存储服务。 执行命令:

hive --service metastore &

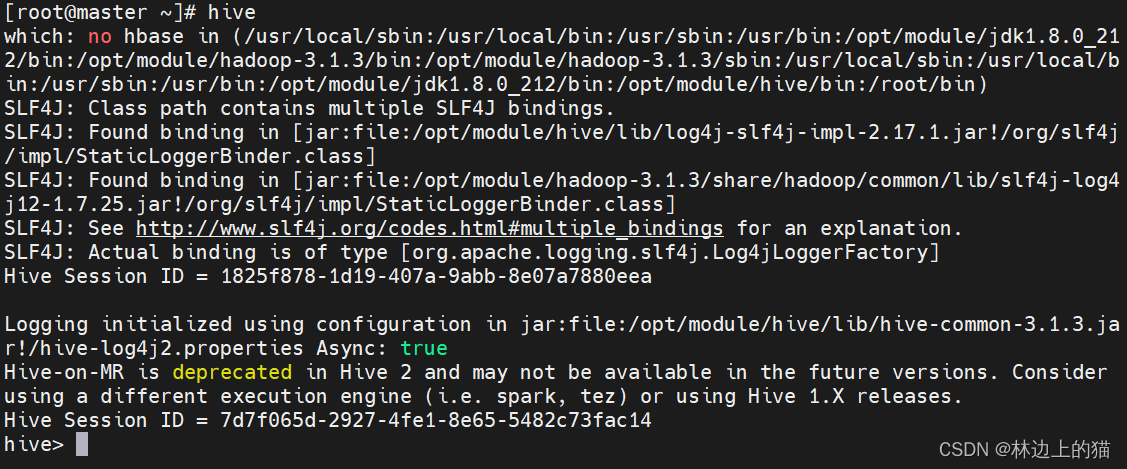

2、启动Hive客户端

- 执行命令:

hive,看到命令提示符hive>

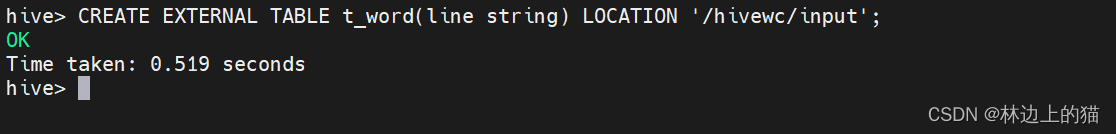

3、基于HDFS文件创建外部表

- 基于

/hivewc/input下的文件创建外部表t_word执行命令:CREATE EXTERNAL TABLE t_word(line string) LOCATION '/hivewc/input';

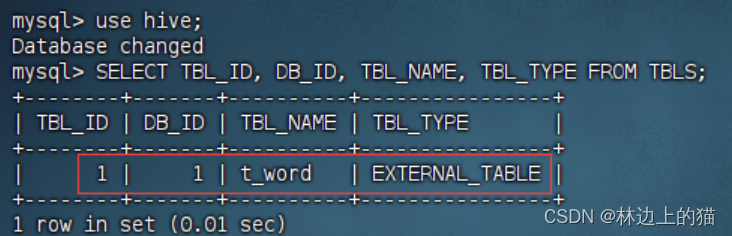

- 在MySQL的hive数据库的TBLS表里,我们可以查看外部表t_word对应的记录。

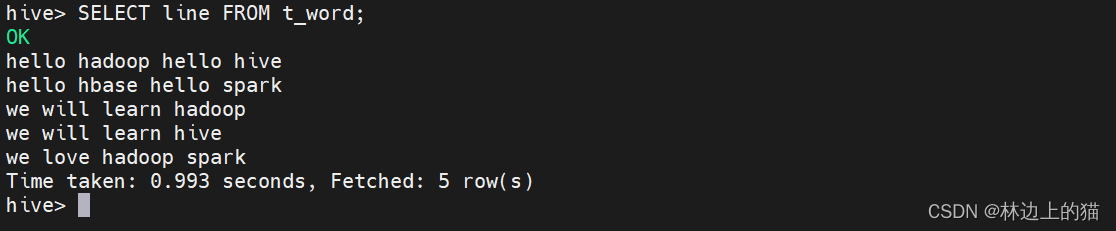

4、查询单词表,所有单词成一列

- 查看单词表记录,执行语句:

SELECT line FROM t_word;

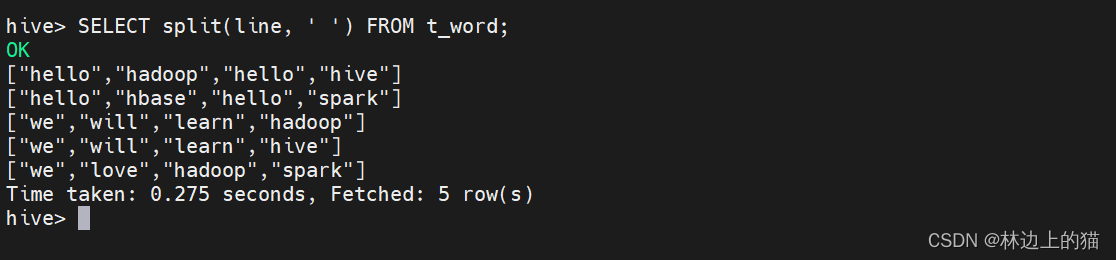

- 按空格拆分行数据,执行语句:

SELECT split(line, ' ') FROM t_word;

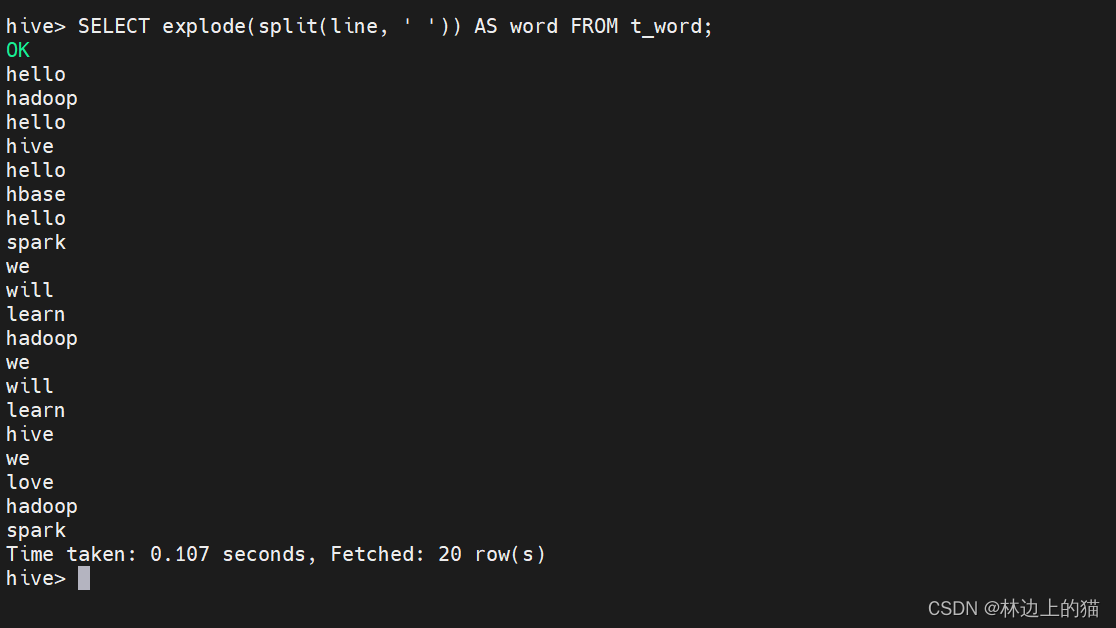

- 让单词成一列,执行语句:

SELECT explode(split(line, ' ')) AS word FROM t_word;

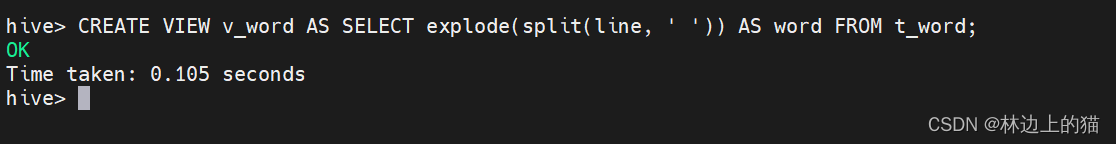

5、基于查询结果创建视图

- 基于查询结果创建了一个视图

v_word执行语句:CREATE VIEW v_word AS SELECT explode(split(line, ' ')) AS word FROM t_word;

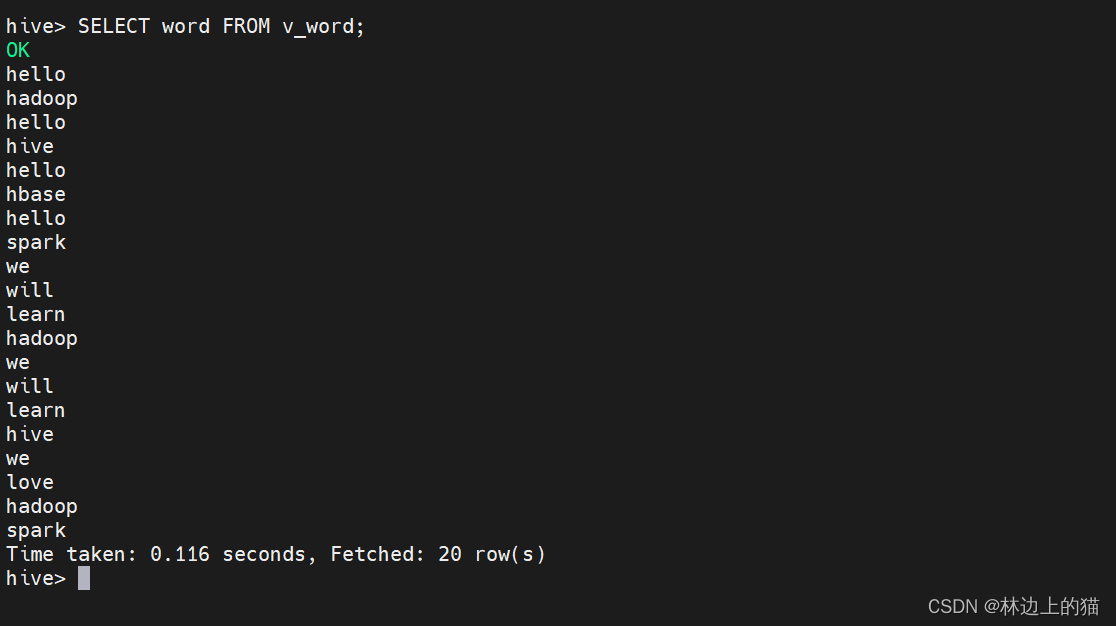

- 查询视图的全部记录,执行语句:

SELECT word FROM v_word;

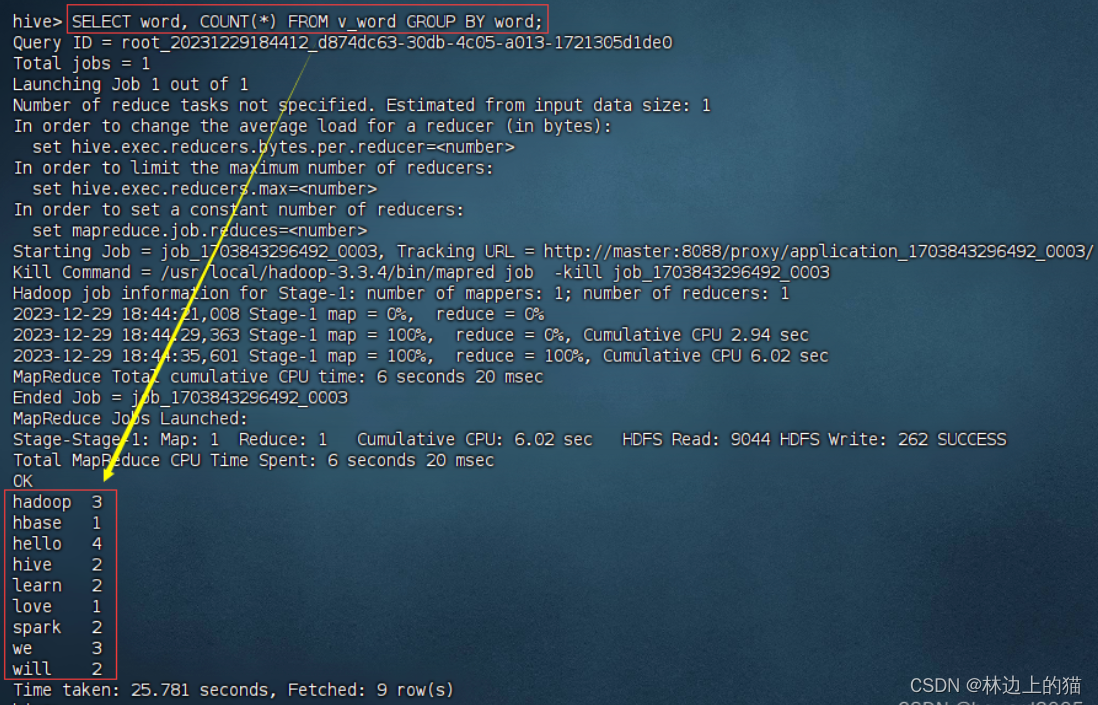

6、基于视图进行分组统计

- 基于视图分组统计操作,执行语句:

SELECT word, COUNT(*) FROM v_word GROUP BY word;

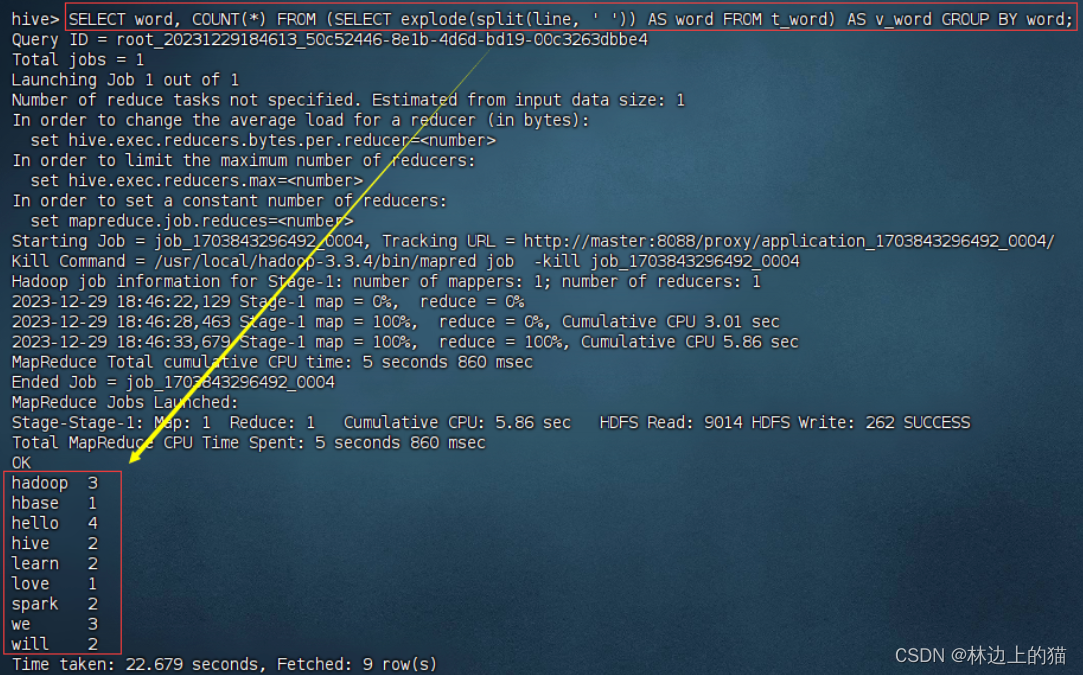

7、基于嵌套查询一步搞定

- 为了更简便地实现相同的效果,使用嵌套查询:

SELECT word, COUNT(*) FROM (SELECT explode(split(line, ' ')) AS word FROM t_word) AS v_word GROUP BY word; 注意,这里在嵌套查询中,我们为子查询取了一个别名,这个别名是v_word。

注意,这里在嵌套查询中,我们为子查询取了一个别名,这个别名是v_word。

这条SQL语句是在处理一个名为t_word的表,该表中有一个word字段,该字段存储的是由空格分隔的单词字符串。

首先,使用explode(split(line, ’ ')) AS word从t_word表中的每一行word字段创建一个新的临时表(别名v_word)。这里split(word, ’ ')函数将每个word字段的内容按照空格分割成多个单词,并生成一个多行的结果集,每行包含一个单词。

explode函数则将这个分割后的数组转换为多行记录,即每一行对应原字符串中的一个单词。

然后,通过GROUP BY word对新生成的临时表v_word中的word字段进行分组,即将所有相同的单词归为一组。

最后,使用COUNT(*)统计每个单词分组的数量,结果将展示每个单词及其在原始数据集中出现的次数。

整个查询的目的在于统计t_word表中各个单词出现的频率。

版权归原作者 林边上的猫 所有, 如有侵权,请联系我们删除。