安装hive前提环境:Hadoop完全分布式集群搭建成功,mysql安装成功

安装位置:HadoopMaster节点(主节点)

步骤一

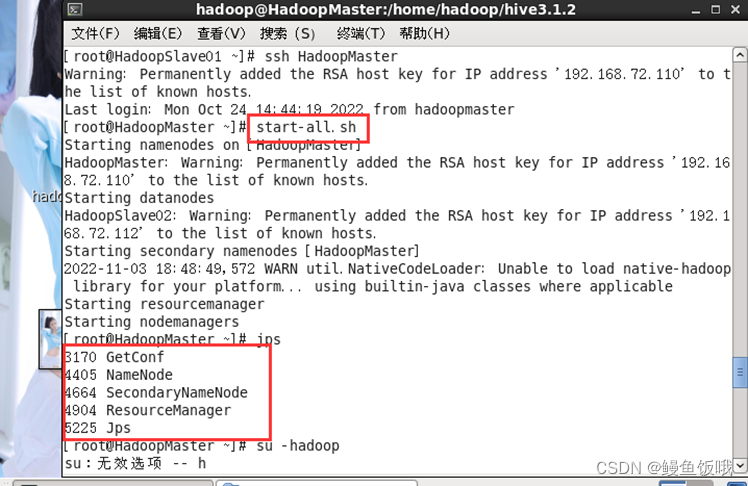

验证:

1.Hadoop完全分布式集群是否搭建成功,命令:

start-all.sh

jps

2.mysql是否安装成功(也是进入mysql的命令),输入密码能进入即成功,命令:

mysql -u root -p

步骤二

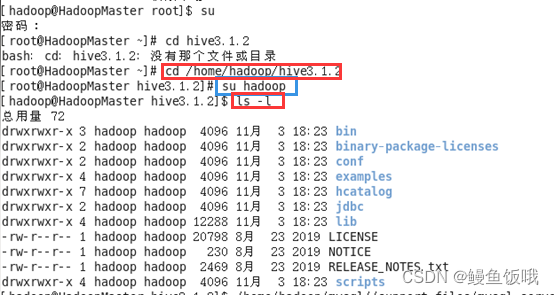

解压并安装 Hive 使用下面的命令,解压 Hive 安装包:

cd /home/hadoop/(具体路径看自己在哪个目录下)

tar -zxvf apache-hive-3.1.2-bin.tar.gz

mv apache-hive-3.1.2-bin hive3.1.2

cd /home/hadoop/hive3.1.2

步骤三

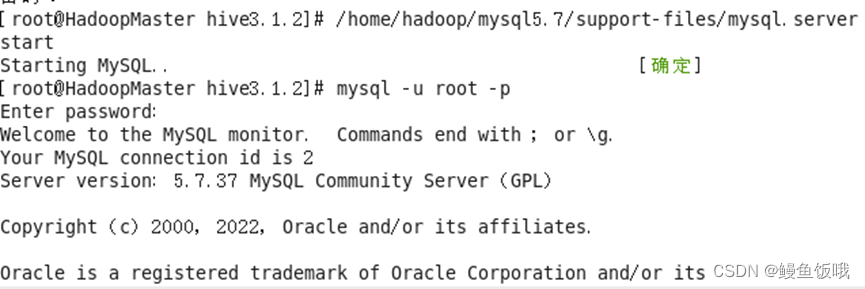

启动Hadoop集群和MySQL服务,步骤一已经启动Hadoop集群,这里只需要启动MySQL服务即可(注意安装hive前一定要启动)

启动MySQL服务,命令:

/home/hadoop/mysql5.7/support-files/mysql.server start

步骤四

创建 myhive 用户,创建数据库hive01并且退出

1.进入mysql

mysql -u root -p

2.创建 myhive 用户

grant all on . to myhive@'%' identified by '123456';

grant all on . to myhive@'localhost' identified by '123456';

grant all on . to myhive@'master' identified by '123456'; flush privileges;

flush privileges;

3.创建数据库hive01并且退出

create database myhive;

步骤五

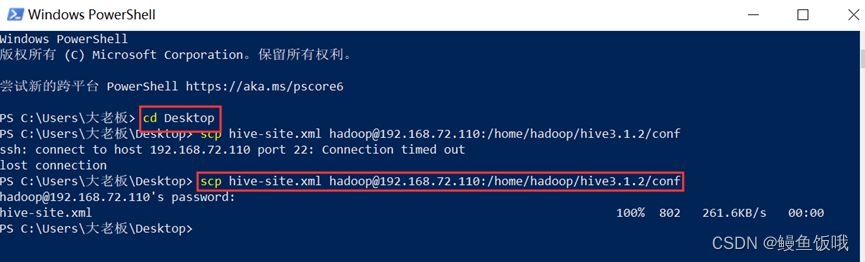

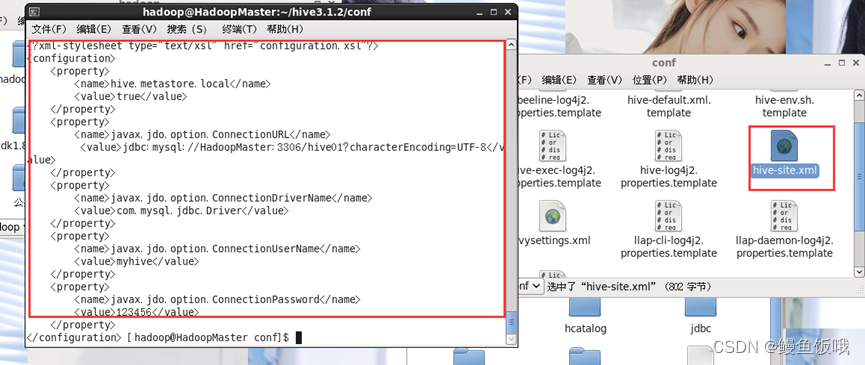

配置hive以及hive-site.xml文件的配置

1.配置hive-site.xml文件

因为hive下的conf文件里没有hive-site.xml文件,所以这里需要先创建一个配置文件,这里我觉得麻烦所以就直接从本地远程上传了一个配置好的hive-site.xml文件,我的2文件链接:https://pan.baidu.com/s/1DSKjr-2CeTN7AQcrhEMrXg?pwd=9y73

提取码:9y73 操作如下:

显示如下:

2.将 mysql 的 java connector 复制到依赖库中(如果mysql-connector-java.jar文件不在当前目录记得切换到文件所在目录下执行操作或者直接在命令里加路径)

cp mysql-connector-java.jar /home/hadoop/hive3.1.2/lib/

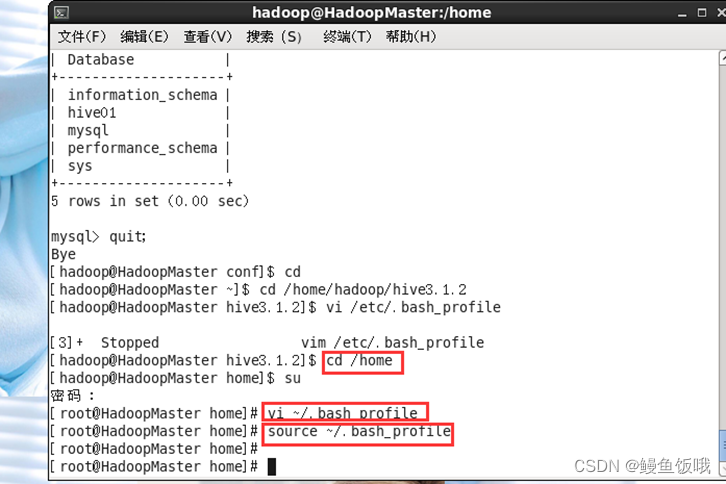

3.配置hive环境变量

vi ~/.bash_profile

进入文件添加以下内容(注意自己hive的正确路径)

export HIVE_HOME=/home/hadoop/hive3.1.2

export PATH=$HIVE_HOME/bin:$PATH

步骤六

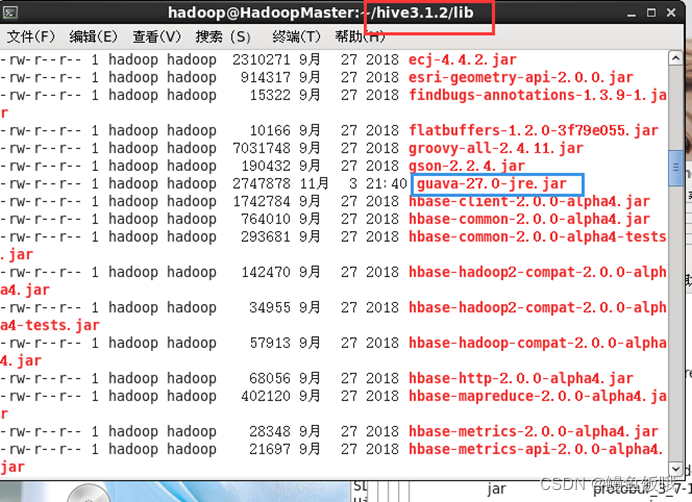

在hadoop下的share/common/lib目录下找到guava-27.0-jre.jar并复制到hive3.1.2下的lib目录下

注意提前把hive3.1.2里的相同文件删除,原因版本不同(注意不能scp,不然hadoop没有该文件同样出错)

cp guava-27.0-jre.jar /home/hadoop/hive3.1.2/lib

以上操作完成后在hive3.1.2下的lib目录下输入 ls -l 命令,查看结果

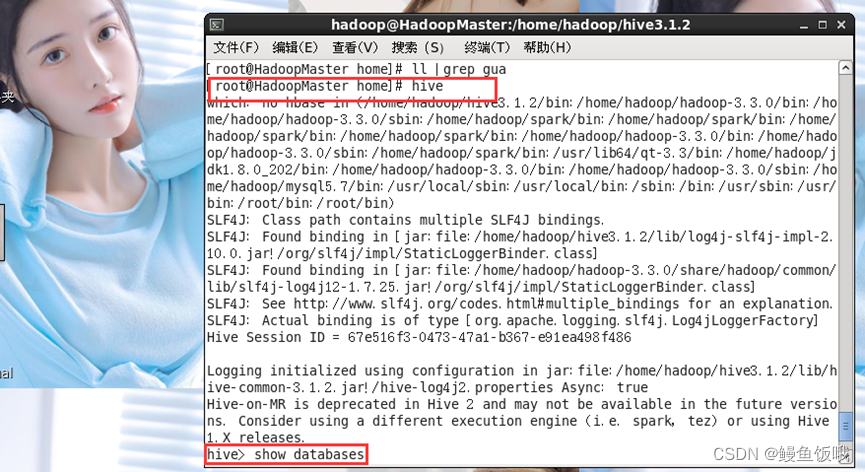

然后启动hive,命令:

hive

总结

因为每个人在配置的时候,不管是自己的问题还是机子的问题,可能或多或少都会出现一些小问题,所以本人的安装过程不一定完全正确,欢迎讨论。

问题不可避免,作为一名学者,我们能做的,就是摆正自己的学习态度尽最大努力和能力去解决它!到这里Hive在Linux上的安装就算完成了,解决问题的过程很有所获,希望自己愈来愈好!

版权归原作者 鳗鱼饭哦 所有, 如有侵权,请联系我们删除。