前言

首先,Hive MySQL Hadoop 要确保没问题,若有小伙伴对这个有疑问,可以在评论区提问

- 其次在Hive中要有一组数据来完成这一次的数据导入

下面我们进入实操环节

叮叮叮叮叮叮~

- 先启动Hadoop集群,为之后获取Hive数据表做准备

- 现在进入Hive

INSERT OVERWRITE DIRECTORY '/home/hadoop/hd'

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

LINES TERMINATED BY '\n'SELECT*FROM user_action

以上需要注意的是

目录可以根据实际情况进行修改,下面的表名“user_action"同理;

- 现在可以进入浏览器Hadoop的web页面查看 数据表 是否导入到

“/home/hadoop/hd”这个目录下 - 接下来把它下载下来,并使用

sudo cp 文件名位置 /var/lib/mysql-files将这个文件放在这里之后接下来进行最关键的一步: - 使用

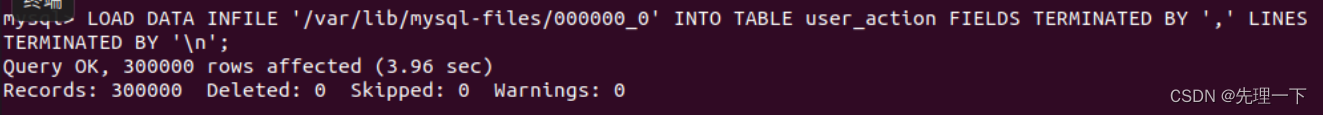

LOAD DATA INFILE '/var/lib/mysql-files/000000_0' INTO TABLE user_action FIELDS TERMINATED BY ',' LINES TERMINATED BY '\n';将刚刚从hive导出的数据表加载导”Mysql“中 结果如图所示: 查询一下,就发现导入成功了!

查询一下,就发现导入成功了!

本文转载自: https://blog.csdn.net/weixin_52062114/article/details/135231004

版权归原作者 先理一下 所有, 如有侵权,请联系我们删除。

版权归原作者 先理一下 所有, 如有侵权,请联系我们删除。