本文还有配套的精品资源,点击获取

简介:本PPT详细介绍了如何运用Hadoop技术来实施大数据项目。内容涵盖了大数据的基础知识、Hadoop生态系统的组件及其在大数据处理中的作用,以及Hadoop的优势和架构。通过实例演示了Hadoop的配置和应用,并探讨了大数据应用案例,挑战及解决方案,并展望了Hadoop及大数据技术的未来趋势。

1. 大数据简介与特性

1.1 大数据的定义和来源

1.1.1 大数据的概念解析

大数据(Big Data)是指传统数据处理软件工具难以在合理时间内处理的大规模、复杂的数据集合。随着互联网、物联网、社交媒体等数字技术的迅猛发展,数据的产生呈现出爆炸性增长。大数据不仅强调数据的体量大,还包括数据处理的速度快以及数据类型的多样等特性。

1.1.2 大数据的来源和类型

大数据来源于多种渠道,包括社交媒体、电子商务、物联网设备、在线搜索、云计算平台等。这些数据可以是非结构化数据,如文本、图片、视频和音频;也可以是结构化数据,如数据库表格和电子表格。除此之外,还存在半结构化数据,它包含了混合上述两者的数据形式,如XML文件和JSON文件。

大数据的特点通常归纳为“4V”模型: - ** 体量巨大(Volume) ** :数据量非常庞大,需要新的存储、计算和分析技术来应对。 - ** 类型多样(Variety) ** :数据种类和格式繁多,既有传统数据库中的结构化数据,也包括非结构化和半结构化数据。 - ** 价值密度低(Veracity) ** :大量数据中有效信息(即价值)的比例相对较低,因此需要高效的数据处理和分析技术来挖掘。 - ** 处理速度快(Velocity) ** :大数据的另一个特点是快速产生,要求系统能实时或近实时地处理和分析数据。

通过深入理解大数据的定义和来源,可以更好地把握其本质,并为应用大数据技术打下坚实的基础。

2. Hadoop生态系统组件介绍

2.1 Hadoop核心组件概览

2.1.1 HDFS与数据存储

Hadoop分布式文件系统(HDFS)是Hadoop项目中的核心组件之一,用于存储大规模数据集。HDFS的设计遵循了高容错性的原则,可以运行在廉价的硬件上,即使硬件出现故障,也能保证数据不丢失。

HDFS采用了主从(Master/Slave)结构模型,主要分为NameNode和DataNode两部分。NameNode作为主节点,负责管理文件系统的命名空间和客户端对文件的访问;DataNode作为从节点,负责存储实际的数据。数据块(block)是HDFS中数据的存储单位,通常为128MB大小,可以在多个DataNode上分布式存储。

** 代码块实例: **

hadoop fs -mkdir /user/hadoop

hadoop fs -put localfile /user/hadoop/file

** 逻辑分析与参数说明: ** - 上述命令在HDFS中创建了一个名为

/user/hadoop

的目录,并将本地文件

localfile

上传到该目录下。这些命令演示了如何使用Hadoop的文件系统命令行接口进行基本的数据存储操作。

2.1.2 MapReduce与数据处理

MapReduce是一种编程模型和处理大数据集的相关实现,用于处理和生成大型数据集的并行运算。在Hadoop中,MapReduce作为分布式计算模型,允许开发者通过简单的接口编写并行程序,然后在由Hadoop管理的集群上自动处理分布和容错。

MapReduce的工作原理包括两个阶段:Map阶段和Reduce阶段。Map阶段将输入数据分割为独立的块,然后每个块并行处理;Reduce阶段将Map处理后的数据进行汇总和计算,得到最终结果。

** 代码块实例: **

public static class MyMap extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split("\\s+");

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

** 逻辑分析与参数说明: ** - 这是一个简单的MapReduce的Map类实现,用于统计文本中每个单词出现的次数。该代码展示了如何通过实现特定的Map类接口来定义Map过程。

2.2 Hadoop生态系统扩展组件

2.2.1 Hive的数据仓库工具

Hive是建立在Hadoop之上的一种数据仓库工具,它提供了一种类似SQL的查询语言(HiveQL)来查询存储在HDFS中的数据。Hive允许用户对大数据集进行高效的查询和分析。

Hive将HiveQL语句转换为MapReduce任务,然后在Hadoop上执行。HiveQL语句经过编译和优化后,生成执行计划,由底层的MapReduce、Tez或Spark引擎执行。

** 表格展示: **

| 属性 | 描述 | | ---------------- | ---------------------------------------------------- | | 存储数据 | 管理数据存储于HDFS中 | | 查询语言 | HiveQL,SQL风格的语言,便于熟悉SQL的用户使用 | | 优化引擎 | 使用Tez或Spark进行执行计划优化和任务调度 | | 数据格式支持 | 支持多种数据格式,如ORC, Parquet, Avro, RCFile等 | | 数据聚合 | 支持MapReduce,Tez以及Spark等多种聚合计算方式 |

2.2.2 HBase的非关系型数据库

HBase是一个开源、非关系型的分布式数据库,建立在Hadoop的HDFS之上。HBase在设计上支持高并发读写和高可扩展性,适用于存储大量的稀疏数据集。

HBase使用列族(Column Family)存储数据,允许在表中动态添加列。其模型与传统的行式关系型数据库相比,具有更灵活的数据模型和高扩展性。

** mermaid格式流程图示例: **

graph LR

A[HBase架构]

A --> B[RegionServer]

B --> C[Column Families]

C --> D[Columns]

D --> E[Cells]

B --> F[MemStore]

B --> G[HFile]

** 流程图描述: ** - HBase架构中,RegionServer负责处理客户端的读写请求。它管理多个Column Families,每个Column Family包含多个Columns,而Columns则包含了实际的数据Cell。 - MemStore和HFile是HBase中用于存储和管理数据的关键组件。MemStore是内存中的存储结构,用于缓存数据,而HFile是HBase的数据文件格式,存储在磁盘上。

2.2.3 Zookeeper的分布式协调服务

Zookeeper是一个开源的分布式协调服务,被设计为高可用的,用于维护配置信息、命名、提供分布式锁以及提供消息队列等服务。在Hadoop生态系统中,Zookeeper是多个组件依赖的服务,用于保持集群状态的一致性和同步。

Zookeeper采用树状结构组织数据节点(Znode),客户端能够监控数据节点的变化,实现高效的协调机制。Zookeeper在Hadoop中的角色主要是作为服务发现和配置管理的工具。

** 代码块实例: **

ZooKeeper zooKeeper = new ZooKeeper("***.*.*.*:2181", 3000, new Watcher() {

@Override

public void process(WatchedEvent event) {

if (event.getType() == Event.EventType.NodeDataChanged) {

System.out.println("节点数据发生变更");

}

}

});

** 逻辑分析与参数说明: ** - 代码展示了如何在Java中使用Zookeeper客户端API连接到Zookeeper服务器,并设置一个监听器(Watcher),当所监视的节点数据发生变化时,会触发回调方法。

通过上述章节的介绍,我们已经对Hadoop的核心组件和扩展组件有了深入的了解。Hadoop生态系统通过这些组件的协同工作,为大数据处理提供了全面的解决方案。接下来,我们将继续探讨Hadoop的优势以及其分布式架构设计的细节。

3. Hadoop优势与架构解析

3.1 Hadoop的核心优势

3.1.1 高度可扩展的数据存储能力

Hadoop作为一种分布式存储系统,能够将大数据集分散存储在由廉价硬件组成的集群上。其数据存储能力的可扩展性是其核心优势之一。

在Hadoop的生态系统中,HDFS(Hadoop Distributed File System)负责管理数据的存储。HDFS提供了高吞吐量的数据访问,非常适合大规模数据集的应用。它通过将大数据文件分割成块(Block),然后将这些块分布在不同的数据节点(DataNode)上,实现数据的冗余存储。

- ** 数据冗余: ** HDFS通过复制每个数据块的多个副本,分散存储在不同的DataNode上,这样即使部分节点失败,数据也不会丢失。

- ** 水平扩展: ** 当需要增加存储容量时,只需增加更多的DataNode节点即可。

- ** 成本效益: ** 使用普通的商用硬件即可搭建Hadoop集群,相比传统的集中式存储解决方案,Hadoop大幅度降低了成本。

3.1.2 强大的数据处理和分析功能

Hadoop之所以广受关注,不仅在于其存储能力,还在于它强大的数据处理和分析功能。MapReduce是Hadoop处理数据的核心编程模型,它简化了大规模数据集的并行运算。

MapReduce的处理流程分为两个阶段:Map阶段和Reduce阶段。Map阶段负责读取输入数据,然后对数据进行过滤和排序;Reduce阶段则对Map阶段的中间结果进行合并和汇总。

MapReduce的优势在于: - ** 高容错性: ** 即使在执行过程中有节点失败,MapReduce可以重新调度任务到其他节点,不会影响整体处理进度。 - ** 易于编程: ** MapReduce提供了一个简单而强大的编程模型,开发者无需担心分布式环境中的数据分片和任务调度问题。 - ** 高效性: ** Hadoop MapReduce通过并行处理极大的提升了数据处理的速度和效率。

3.2 Hadoop的分布式架构设计

3.2.1 NameNode和DataNode的角色与功能

在Hadoop分布式文件系统HDFS中,NameNode和DataNode是两个核心组件。

- ** NameNode: ** 主要负责管理文件系统的命名空间,维护文件系统树及整个文件系统的元数据。NameNode记录每一个文件中各个块所在的DataNode节点,并不存储数据本身。

- ** DataNode: ** 负责存储实际数据,每个DataNode会存储一部分块(Block)数据。DataNode负责处理文件系统客户端的读写请求。

HDFS通过这种设计,实现了数据的分片存储和容错。当某个DataNode节点出现故障时,NameNode会重新调度该节点上的块到其他健康节点上。NameNode和DataNode之间的通信是通过心跳机制和块报告完成的。

graph LR

NN(NameNode)

DN(DataNode1)

DN2(DataNode2)

NN -->|管理元数据| DN

NN -->|管理元数据| DN2

DN -->|存储数据块| HDFS

DN2 -->|存储数据块| HDFS

3.2.2 JobTracker与TaskTracker的协调机制

Hadoop的MapReduce组件中,JobTracker和TaskTracker负责任务的分配和执行。

- ** JobTracker: ** 是MapReduce的主节点,它负责监控所有作业的执行状态,调度Map和Reduce任务到TaskTracker。

- ** TaskTracker: ** 负责在工作节点上执行具体的任务,比如Map任务或Reduce任务。TaskTracker会周期性地向JobTracker发送心跳包和任务状态信息。

JobTracker会根据资源的可用性和任务的调度策略决定任务分配。TaskTracker与JobTracker之间通过RPC(远程过程调用)进行通信。Hadoop的这种设计确保了在计算集群中动态地调度资源和处理任务。

graph LR

JT(JobTracker)

TT(TaskTracker1)

TT2(TaskTracker2)

JT -->|任务调度| TT

JT -->|任务调度| TT2

TT -->|执行任务| MR

TT2 -->|执行任务| MR

通过以上架构设计,Hadoop确保了数据的高可用性和任务的高效执行。下一节将结合具体的部署实例,解析Hadoop集群的部署步骤和配置流程。

4. Hadoop部署与配置实例

4.1 Hadoop的集群部署步骤

4.1.1 系统环境准备和软件安装

在进行Hadoop集群部署之前,首先需要准备适合的系统环境。这通常包括Linux操作系统的安装,因为Hadoop是基于Java开发,且在类Unix系统上运行更加稳定和高效。推荐使用如CentOS或Ubuntu等稳定版本的Linux发行版。

系统环境准备包括以下步骤:

- 选择并配置硬件资源,包括CPU、内存和存储空间等。

- 安装操作系统并更新必要的系统包。

- 配置静态IP地址和主机名映射,以确保集群内各节点间通信的稳定性。

在软件安装方面,需要按照Hadoop的官方文档来操作。主要包括:

- 安装Java开发环境,推荐使用JDK 8或更高版本。

- 添加Hadoop仓库,可以通过编辑

/etc/yum.repos.d目录下的配置文件来完成。 - 安装Hadoop软件包,使用如

yum install hadoop或apt-get install hadoop命令。

4.1.2 集群配置与启动流程

在完成系统环境和软件安装之后,接下来是集群的配置和启动。Hadoop集群的配置文件位于

$HADOOP_HOME/etc/hadoop

目录下,主要包括:

core-site.xml:设置Hadoop核心配置,如文件系统默认类型和I/O配置。hdfs-site.xml:配置HDFS相关参数,如副本数量和存储路径。mapred-site.xml:设置MapReduce作业配置,如运行模式和框架地址。yarn-site.xml:配置YARN资源管理器的参数,如调度器类型和资源容量。

集群启动流程:

- 首先格式化HDFS文件系统,使用命令

hdfs namenode -format。 - 启动HDFS守护进程,执行

start-dfs.sh脚本。 - 启动YARN守护进程,执行

start-yarn.sh脚本。 - 验证集群状态,使用

jps命令查看Java进程,以及访问Hadoop管理界面确认服务状态。

4.2 Hadoop集群的监控与优化

4.2.1 资源监控工具的使用

对于Hadoop集群的监控,可以使用多种工具来收集和分析集群的运行状态。其中,使用最广泛的是Ambari和Ganglia等。

Ambari是一个基于Web的管理工具,它提供了可视化界面来监控集群的健康状况、服务状态和资源使用情况。通过Ambari可以很直观地看到集群的CPU、内存、磁盘和网络的使用情况,并可以对集群进行配置和管理。

使用Ambari进行集群监控和优化的大致步骤如下:

- 安装Ambari服务,使用提供的安装向导。

- 通过Web界面添加Hadoop集群的主机信息。

- Ambari会自动检测Hadoop集群组件并添加至监控。

- 查看各个服务的仪表板,监控集群状态和性能指标。

- 设置报警和阈值,以便在出现问题时及时通知。

4.2.2 性能优化的常见策略

性能优化是保证Hadoop集群高效运行的重要环节。以下是一些常见的优化策略:

- 硬件优化:使用更快的CPU、更大的内存、更快的磁盘和网络设备。

- 配置参数调优:通过调整Hadoop配置文件中的参数,如调整数据块大小、内存缓冲区大小等,以提高数据处理速度。

- 压缩算法选择:根据数据类型和使用场景选择合适的压缩算法,以减少存储和传输的数据量。

- 作业调度优化:合理分配Map和Reduce任务的资源,以及优化任务的执行计划。

代码块示例:

# 以调整HDFS数据块大小为例,修改配置文件hdfs-site.xml

<configuration>

<property>

<name>dfs.block.size</name>

<value>***</value> <!-- 设置为256MB -->

</property>

</configuration>

逻辑分析和参数说明:

在上述配置中,将HDFS数据块大小设置为256MB,适合处理大文件的场景,这样可以减少Map任务的数量,提高数据读写效率。但是,如果处理的是大量小文件,这样的配置可能会增加NameNode的负担,因此需要根据实际应用场景来调整参数。

通过这种方式,我们能够对Hadoop集群进行细致的调整,以实现性能上的最优化。

5. 大数据应用案例分析

在前面的章节中,我们已经了解了大数据的基本概念、特性以及Hadoop生态系统的关键组件和架构。现在,让我们通过几个真实世界的大数据应用案例,来深入了解大数据在不同行业中的实际运用,以及它为行业带来的价值。

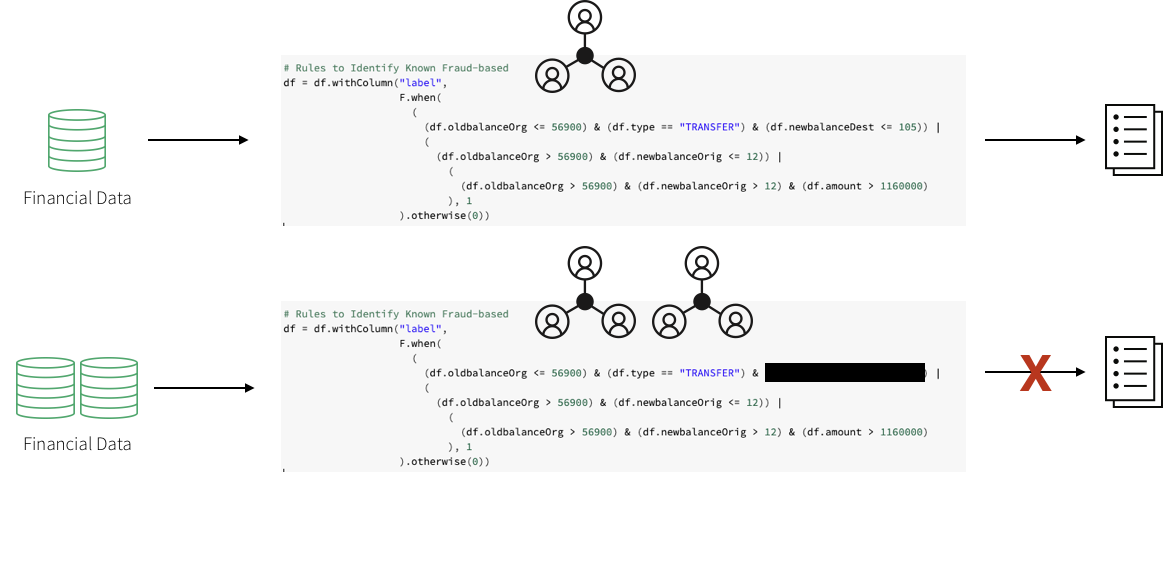

5.1 大数据在金融领域的应用

5.1.1 风险管理和信用评估

金融行业是最早采用大数据技术的行业之一,风险管理与信用评估是大数据应用的典型案例。通过分析大量的交易数据、市场趋势、客户行为以及外部环境等信息,金融机构能够建立更为精准的风险评估模型。

应用步骤:

- ** 数据收集 ** :从多个源收集数据,包括市场数据、客户交易记录、信用历史等。

- ** 数据处理 ** :使用MapReduce等技术处理和分析数据,挖掘潜在的风险和信用模式。

- ** 模型构建 ** :运用统计分析和机器学习算法构建信用评分和风险模型。

- ** 决策支持 ** :模型结果支持决策,帮助银行等金融机构进行贷款审批、风险定价等。

5.1.2 客户关系管理和营销策略

大数据技术在客户关系管理(CRM)中的应用,使得金融机构能够更好地理解客户需求,提供个性化的服务和产品。

实践路径:

- ** 客户细分 ** :根据客户的行为、偏好和价值等指标将客户细分为不同的群体。

- ** 个性化推荐 ** :利用协同过滤、深度学习等技术,为不同客户群体制定个性化的金融产品和服务。

- ** 营销优化 ** :通过分析历史营销活动的效果,优化未来的营销策略和预算分配。

- ** 客户流失分析 ** :预测可能流失的客户并采取挽留措施。

5.2 大数据在互联网企业的应用

5.2.1 用户行为分析和产品推荐

互联网企业,如电商和社交媒体平台,依赖大数据技术进行用户行为分析,以优化用户体验并提升产品推荐的准确度。

分析过程:

- ** 数据采集 ** :收集用户点击、浏览、购买等行为数据。

- ** 用户画像构建 ** :利用这些数据建立详细的用户画像。

- ** 行为模式识别 ** :使用数据挖掘技术识别用户的兴趣和偏好。

- ** 个性化推荐 ** :基于识别出的行为模式,为用户推荐产品或内容。

5.2.2 网络流量监控和异常检测

为了保证网站的正常运行,网络流量监控和异常检测至关重要。大数据技术可以帮助互联网企业实时监控网站流量,及时发现并处理异常情况。

监控流程:

- ** 实时数据流处理 ** :利用流处理技术对网站的实时数据流进行监控。

- ** 流量模式识别 ** :通过分析流量模式识别潜在的DDoS攻击或异常流量。

- ** 自动化响应 ** :一旦发现异常行为,自动触发防御措施或报警系统。

5.3 大数据在医疗健康领域的应用

5.3.1 疾病模式识别和预测

大数据在医疗健康领域的应用日益广泛,尤其在疾病模式识别和预测方面具有巨大潜力。通过分析海量的医疗记录、遗传信息、生活习惯等数据,可以辅助医疗工作者更准确地预测和诊断疾病。

应用关键:

- ** 健康数据整合 ** :整合患者的历史健康记录、基因数据和生活习惯数据。

- ** 模式识别 ** :使用机器学习算法识别疾病的发展模式和高风险人群。

- ** 预测模型 ** :构建疾病预测模型,辅助医生进行早期诊断和预防。

5.3.2 患者数据管理和临床决策支持

大数据技术还能够帮助医疗机构实现患者数据的高效管理,并在临床决策中提供支持,提高治疗效果和医疗服务水平。

管理与支持:

- ** 电子健康记录(EHR)系统 ** :利用大数据技术建立和维护电子健康记录系统。

- ** 临床决策系统 ** :开发基于数据的临床决策支持系统,为医生提供实时的诊断建议和治疗方案。

- ** 数据可视化 ** :通过数据可视化工具帮助医生直观理解数据,做出更好的决策。

通过以上案例,我们可以看到大数据技术如何在不同行业实现创新应用,并促进业务发展。这些案例也展示了大数据分析的复杂性和多样性,以及它在解决实际问题中的巨大价值。

接下来的内容将在第六章中展开,我们将讨论大数据实施过程中遇到的挑战以及相应的解决方案。

本文还有配套的精品资源,点击获取

简介:本PPT详细介绍了如何运用Hadoop技术来实施大数据项目。内容涵盖了大数据的基础知识、Hadoop生态系统的组件及其在大数据处理中的作用,以及Hadoop的优势和架构。通过实例演示了Hadoop的配置和应用,并探讨了大数据应用案例,挑战及解决方案,并展望了Hadoop及大数据技术的未来趋势。

本文还有配套的精品资源,点击获取

版权归原作者 不胖的羊 所有, 如有侵权,请联系我们删除。