点击上方“Deephub Imba”,关注公众号,好文章不错过 !

**

**

这是谷歌在2019年发布的一种在强化学习模型中分配奖励机制的新方法。

强化学习一直是过去五年中一些最大的人工智能 (AI) 突破的核心。在围棋、雷神之锤 III 或星际争霸等游戏中,强化学习模型证明它们可以超越人类的表现,并创造出前所未有的独特长期策略。强化学习的部分魔力依赖于定期奖励能够带来更好结果的行为的智能体。该模型在密集奖励环境中效果很好,例如游戏中几乎每个动作都对应于特定反馈,但如果该反馈不可用会发生什么?在强化学习中,这被称为稀疏奖励环境,不幸的是,它代表了大多数现实世界的场景。19年谷歌的研究人员发表了一篇新论文,提出了一种通过在稀疏奖励环境中运行的强化学习实现泛化的技术。

强化学习一直是过去五年人工智能(AI)一些重大突破的核心。在掌握围棋、《雷神之锤3》或《星际争霸》等游戏时,强化学习模型证明它们能够超越人类的表现并创造出前所未有的独特长期策略。强化学习的最主要的部分依赖于定期奖励能带来更好结果的行为。这种模式在密集的奖励环境(即几乎所有行动都与特定反馈能够相互对应的游戏)中非常有效,但如果反馈不可用怎么办?在强化学习中,这被称为稀疏奖励环境,这其实是实际大多数现实场景的代表。几年前,谷歌的研究人员发表了一篇新论文,提出了一种在稀疏奖励环境中使用强化学习实现泛化的技术。

稀疏奖励环境下强化学习的挑战在于在有限反馈的情况下实现良好的泛化。更具体地说,在稀疏奖励环境中实现稳健泛化的过程可以概括为两个主要问题:

1)探索环境和行动进行平衡:使用稀疏奖励的agent需要平衡何时采取行动以获得直接结果,何时进一步探索环境以收集更好的情报。

2)处理未指定的奖励:环境中未指定奖励和没有奖励一样难以管理。在稀疏奖励场景中,agent并不总是针对特定类型的奖励进行训练。在接收到一个新的反馈信号后,agent需要评估这个信号是否对成功或失败的有良好的结果。

稀疏奖励环境存在于各种 AI 场景中,但没有像自然语言理解 (NLU) 任务那样突出。许多 NLU 任务基于将复杂的自然语言结构映射到客观动作并接收二元的成功/失败反馈。NLU 环境中的奖励既稀疏又不明确,这导致强化学习环境极具挑战性。让我们用几个例子来说明这一点。

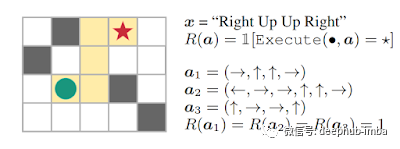

考虑一个“盲人”agent,其任务是通过一系列自然语言命令(例如,“向右、向上、向上、向右”)到达迷宫中的目标位置。给定输入文本,agent(绿色圆圈)需要解释命令并根据这种解释采取行动以生成动作序列(a)。如果达到目标(红星),agent将获得 1 的奖励,否则为 0。由于agent无法访问任何视觉信息,agent解决此任务并推广到新指令的唯一方法是正确解释指令。

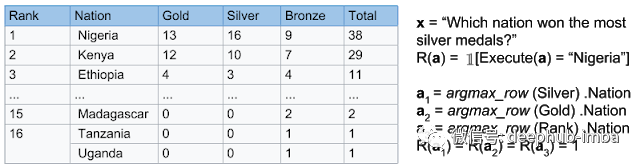

另一个例子是使用语义解析问答对自然语言问题生成一个sql程序。如果在相关数据表上执行程序 a 导致正确答案(例如,美国),则agent将获得 1 的奖励。如果奖励未指定因为偶然程序(例如,a2;a3)agent也可以获得 1 的奖励。

在上述两种情况下,强化学习agent都需要学习从稀疏奖励中推广,其中只有少数轨迹转换为非零奖励。类似地,有些奖励可能没有明确区分偶然成功和有目的成功之间的区别。在这种情况下学习概括需要两个主要的成就:

1)有效探索,寻找成功轨迹。

2)弱化偶然轨迹以学习可推广的行为。

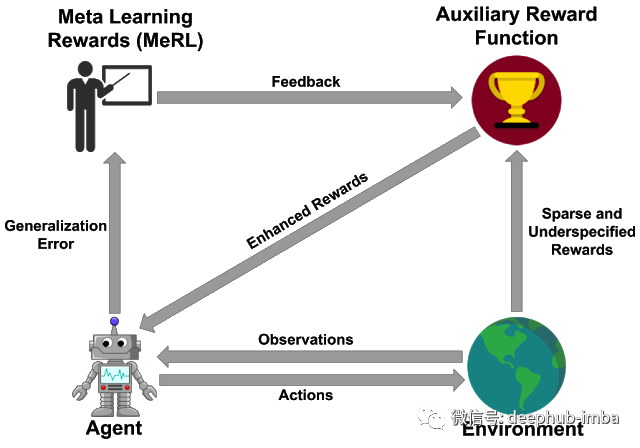

Meta Rewards Learning(MeRL)是谷歌提出的方法,用于将强化学习agent在奖励稀疏的环境中进行泛化。MeRL 的关键贡献是在不影响agent的泛化性能的情况下有效地处理未指定的奖励。在我们的迷宫游戏示例中,agent可能会意外地找到解决方案。但是如果它在训练期间学会了执行偶然动作,则在提供未出现的指令时很可能会失败。为了应对这一挑战MeRL 优化了一个更精细的辅助奖励函数,它可以根据动作轨迹的特征区分意外成功和有目的的成功。通过Meta Rewards最大化agent在保持验证集上的性能来优化辅助奖励。

让我们在第二个NLU示例的上下文中说明MeRL。在语义解析游戏中,agent的目标是学习复杂的自然语言句子和SQL语法之间的映射。例如,在回答“Which nation won the most silver medals?”和相关的Wikipedia表,我们的agent需要生成一个类似sql的程序,以得到正确的答案(例如,“Nigeria”)。

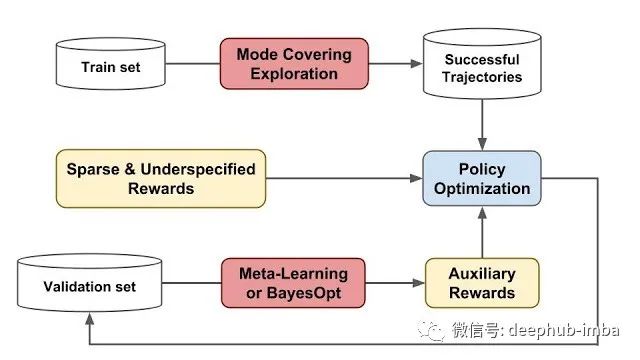

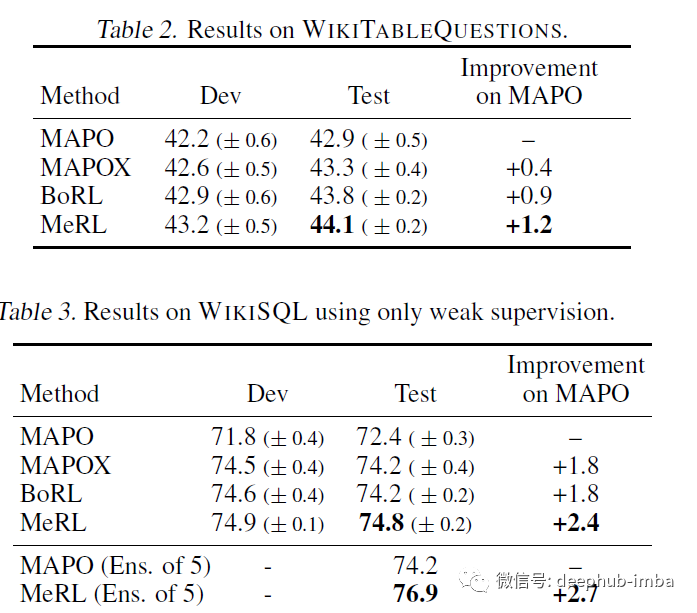

将 MeRL 应用于语义解析游戏场景可以有效地将组合搜索、探索与稳健的策略优化分开。在高层次上,MeRL 模型将利用一种覆盖探索方法的模式在内存缓冲区中收集不同的成功轨迹集。然后使用元学习或贝叶斯优化技术来学习辅助奖励函数以减少偶然轨迹。在实践中,MeRL 方法在 WikiTableQuestions 和 WikiSQL 基准测试中取得了最先进的结果,分别比之前的工作提高了 1.2% 和 2.4%。此外,MeRL 无需任何专家演示即可自动学习辅助奖励功能。语义解析游戏场景中MeRL模型的通用构建块如下图所示:

在该实验中,MeRL优于目前最先进的强化学习模型,如下表所示:

MeRL 是解决强化学习中两个关键挑战的首批尝试之一。首先,它提供了一个模型来探索组合搜索空间以找到罕见的成功,同时它还有助于区分偶然的成功和有目的的成功。MeRL 的原则可以帮助将强化学习的采用扩展到更主流的场景,例如当今最热门的conversational AI。

论文:arXiv:1902.07198

喜欢就关注一下吧:

点个 在看 你最好看!********** **********