配置前也是要确保前面都配置正确,把多余的jdk都删掉(不会删看笔者第一篇文章)

1.配置hbase

1.1上传解压改名加环境变量

上传不再赘述

解压:

tar -zxvf /usr/local/hbase-1.3.1-bin.tar.gz -C /usr/local/

改名:

mv /usr/local/hbase-1.3.1 /usr/local/hbase

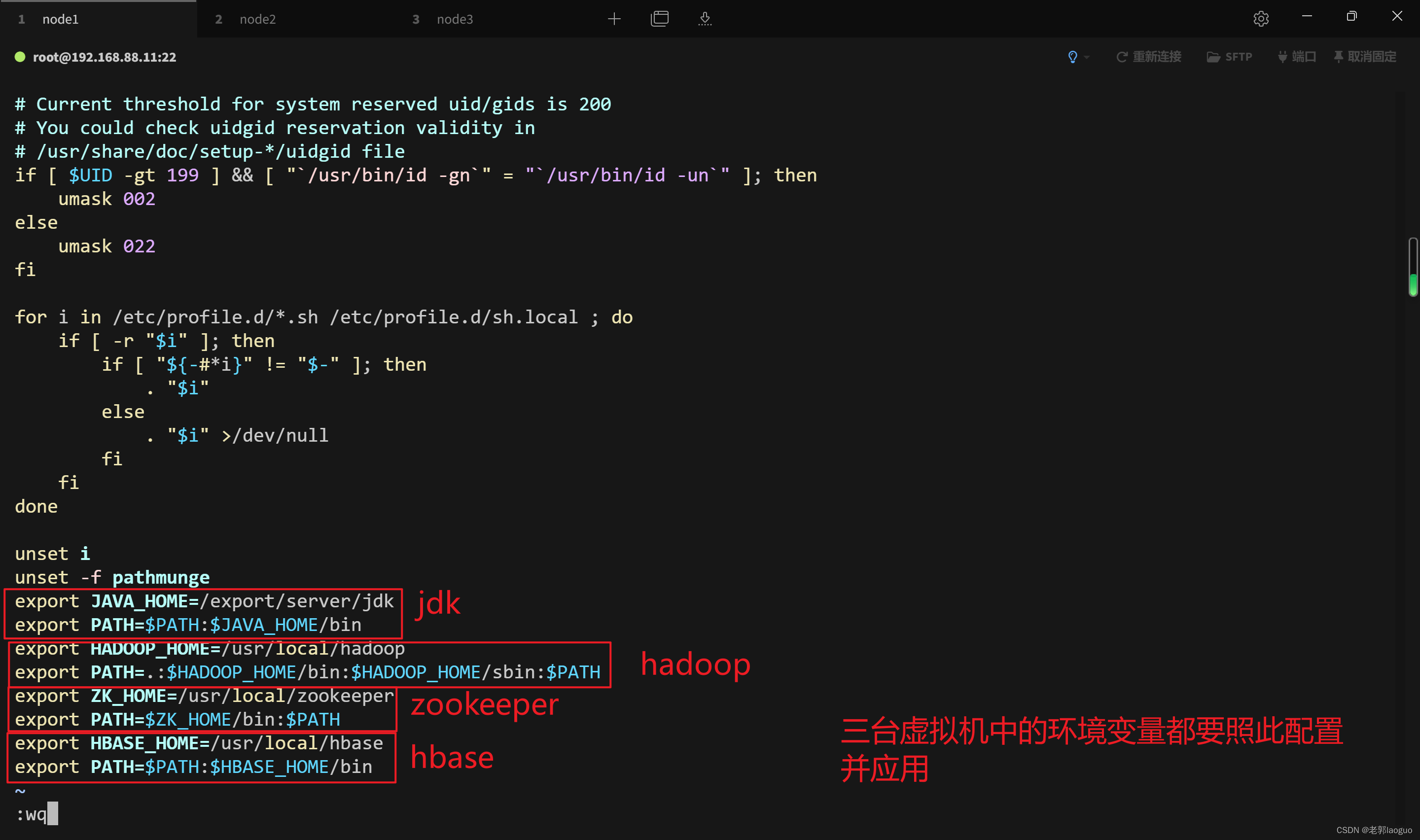

环境变量:

vim /etc/profile

export HBASE_HOME=/usr/local/hbase

export PATH=$PATH:$HBASE_HOME/bin

应用:

source /etc/profile

1.2修改hbase-env.sh

要修改jdk和设置zookeeper外部使用

vim /usr/local/hbase/conf/hbase-env.sh

export JAVA_HOME=/export/server/jdk

export HBASE_MANAGES_ZK=false

1.3修改hbase-site.xml

vim /usr/local/hbase/conf/hbase-site.xml

<property>

<name>hbase.rootdir</name>

<value>hdfs://node1:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master</name>

<value>node1:60000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>node1:2181,node2:2181,node3:2181</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/usr/local/hbase/data/zookeeper</value>

</property>

1.4修改regionservers

vim /usr/local/hbase/conf/regionservers

node1

node2

node3

1.5拷贝hadoop配置文件

由于hbase对hdfs有依赖关系,则需要将hadoop下的core-site.xml和hdfs-site.xml复制到hbase中的conf目录下

cp /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hbase/conf/

cp /usr/local/hadoop/etc/hadoop/hdfs-site.xml /usr/local/hbase/conf/

1.6分发到node2和node3

scp -r /usr/local/hbase root@node2:/usr/local

scp -r /usr/local/hbase root@node3:/usr/local

2.启动顺序及验证

2.1启动顺序

zookeeper->hadoop->hbase

启动zookeeper(三台都要启动):

zkServer.sh start

启动hadoop:

在node1上执行

start-all.sh

在node2上执行

yarn-daemon.sh start resourcemanager

启动hbase:

在node1上执行

start-hbase.sh

2.2验证

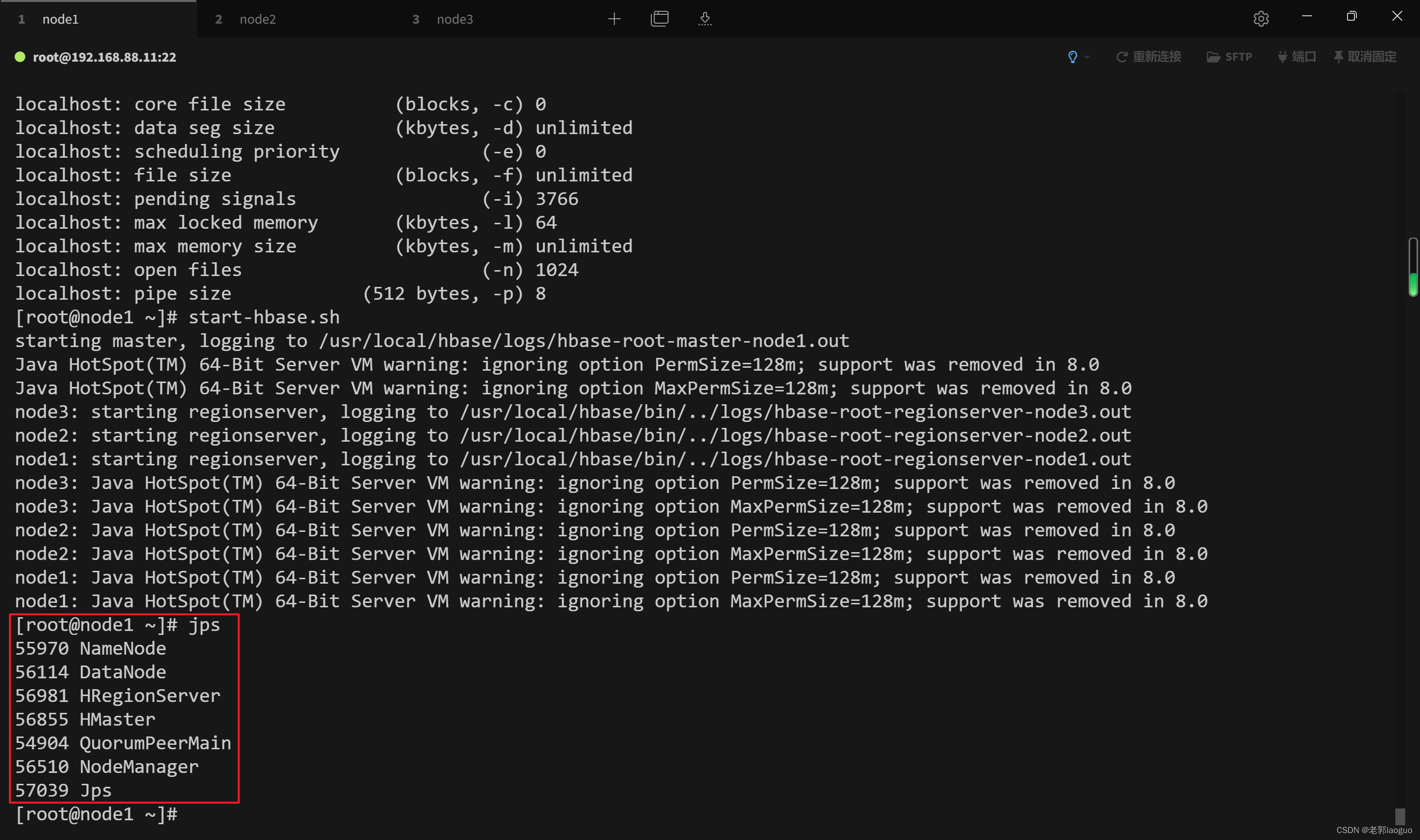

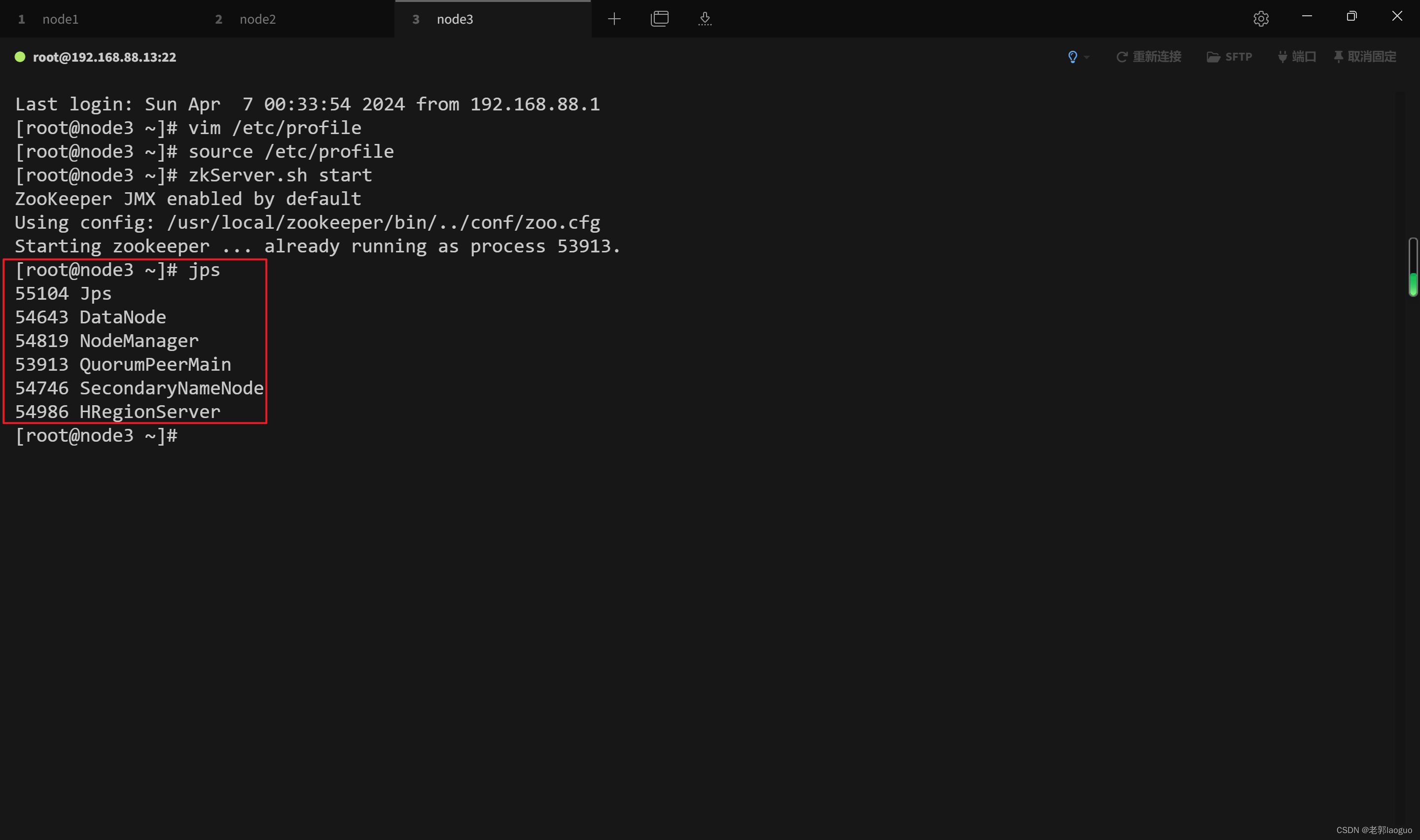

法一:jps

node1有7个服务

node2有6个

node3有6个

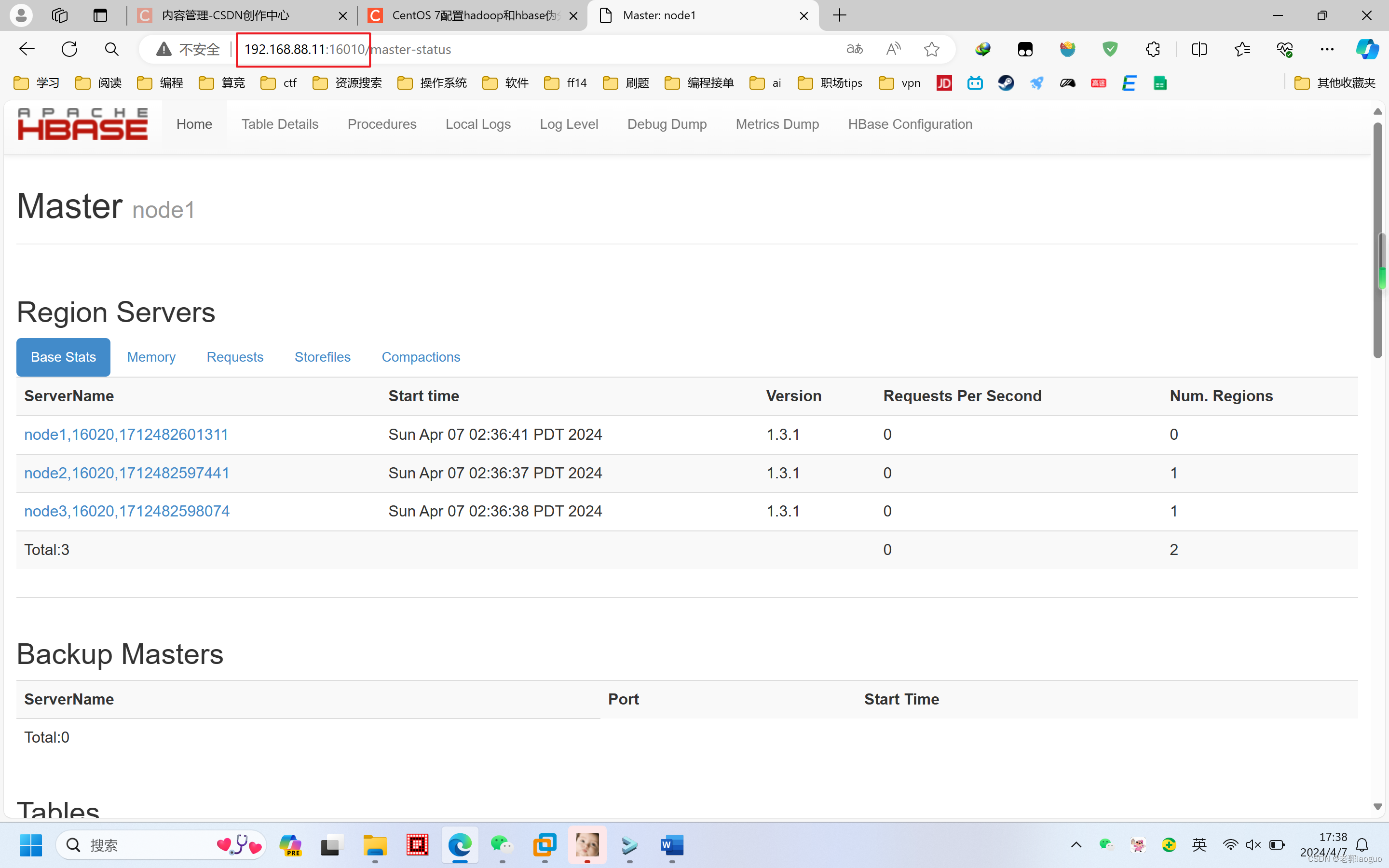

法二:浏览器访问http://ip:16010

ip指的是主机(node1)的ip

2.3关闭顺序

hbase->hadoop->zookeeper

关闭hbase:

node1上执行

stop-hbase.sh

关闭hadoop:

node2上执行

yarn-daemon.sh stop resourcemanager

node1上执行

stop-all.sh

关闭zookeeper:

在三台虚拟机上都执行

zkServer.sh stop

版权归原作者 老郭laoguo 所有, 如有侵权,请联系我们删除。