问题:

在接收第三方推送kafka数据时出现相同数据一直循环重复消费。

原因:

消费者处理比较耗时,一次poll的数据,在max.poll.interval.ms达到最大值后仍未完成,未提交offest,默认值为5分钟。

解决办法

1.提高max.poll.interval.ms的值。

Ⅰ.使用springboot自动配置方式

spring:

kafka:

bootstrap-servers: 127.0.0.1:9092

#分号不能去

consumer:

auto-offset-reset: latest

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

# 值的反序列化方式

value-deserializer: org.apache.kafka.common.serialization.StringDeserializer

max:

poll:

interval:

ms: 60000*50

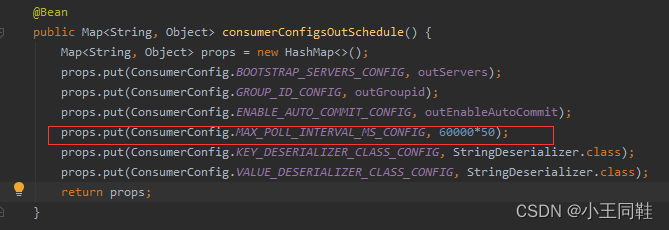

Ⅱ.使用自定义配置kafkaConfig则在消费者配置部分添加

版权归原作者 小王同鞋 所有, 如有侵权,请联系我们删除。