Kafka的架构和运行原理

Kafka是一个分布式流处理平台,它由以下几个核心组件组成:

- Broker:Kafka集群中的一个节点,负责接收、存储和转发消息。

- Topic:消息的逻辑容器,可以理解为消息的类别或主题,每个消息都会被发布到一个特定的主题。

- Partition:每个主题可以被分成多个分区,分区是消息的物理顺序。每个分区在多个Broker之间进行复制,以实现数据冗余和高可用性。

- Producer:消息的生产者,将消息发布到指定的主题。

- Consumer:消息的消费者,从一个或多个主题订阅消息并进行处理。

Kafka的运行原理如下:

- Producer将消息发布到指定的主题,并将消息发送给Broker。

- 每个Broker接收到消息后,根据消息的主题和分区信息,将消息存储到对应的分区中。

- Consumer通过指定的主题和分区订阅消息,并从Broker拉取消息。

- 当消息被消费后,消费者可以提交偏移量(offset)来记录已消费消息的位置。

- Kafka集群中的Broker之间会进行数据复制,以实现数据冗余和高可用性。

- Kafka提供了消息的持久化存储,即使消费者离线一段时间后也可以继续消费未读取的消息。

- Kafka还支持消息的批量处理和压缩,能够提高吞吐量和降低网络带宽的消耗。

Kafka在大数据中的应用

主要可以分为以下几个方面:

- 数据流处理:Kafka被广泛用于数据流处理场景,如实时日志收集、事件流处理、实时监控等。Kafka的高吞吐量和低延迟特性使得它成为处理实时数据流的理想选择。数据源可以将数据写入Kafka的主题(Topic),然后消费者可以从主题中读取数据进行处理。

- 消息队列:Kafka可以用作消息队列,将消息从一个系统传递到另一个系统。生产者将消息发布到Kafka的主题中,消费者可以从主题中订阅并消费消息。Kafka具有高可用性和可靠性的特性,可以保证消息的可靠传递。

- 日志收集与分析:Kafka可以用作日志收集和分析的基础设施。应用程序可以将日志写入Kafka,然后使用Kafka Connect将日志数据导入到其他数据存储或数据处理系统中,如Hadoop、Elasticsearch等。Kafka的高吞吐量和分布式架构使得它能够承载大量日志数据。

- 数据备份与复制:Kafka支持数据的备份和复制。通过将数据复制到多个Kafka集群中的主题,可以实现数据的冗余存储和容错性。这对于大规模数据的高可用性和数据恢复非常重要。

总之,Kafka在大数据中的应用非常广泛,它为实时数据流处理、消息传递、日志收集和分析等场景提供了强大的支持。同时,Kafka的分布式架构和高可靠性也使得它成为大规模数据处理和存储的理想选择。

Kafka搭建

在搭建Kafka之前,需要进行以下准备工作:

- 确定环境:确定Kafka将要运行的环境,包括操作系统、网络环境等。

- 安装JDK:Kafka是基于Java开发的,因此需要安装和配置Java Development Kit(JDK)

- 配置Kafka:在配置Kafka之前,需要了解和确定一些关键参数,如Kafka集群的名称、端口、数据存储目录等。您还可以根据自己的需求进行更高级的配置,如日志级别、Zookeeper连接等。

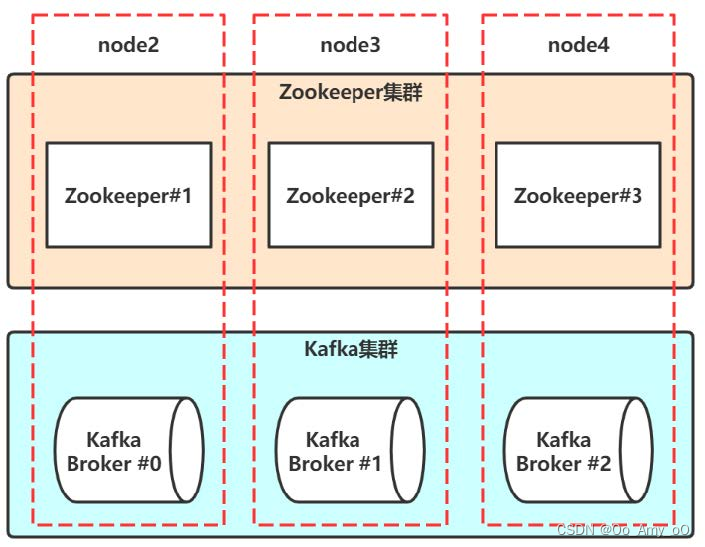

- 安装Zookeeper:Kafka依赖于Zookeeper来管理集群的元数据和状态。因此,您需要安装和配置Zookeeper,并确保Kafka和Zookeeper的版本兼容。

- 创建Kafka集群:根据您的需求,可以创建单节点或多节点的Kafka集群。如果是多节点集群,您需要设置适当的主题和分区数,并为每个节点分配适当的资源。

搭建Kafka可以分为以下几个步骤:

- 下载Kafka:首先需要从官网下载Kafka的二进制安装包。选择适合你操作系统的版本进行下载。

- 解压安装包:将下载的安装包解压到指定的目录。

- 配置Kafka:进入Kafka解压后的目录,编辑

config/server.properties文件。根据需要修改以下几个重要的配置项:-broker.id:Kafka集群中的每个节点需要有唯一的一个编号。-listeners:设置Kafka监听的地址和端口。-log.dirs:设置Kafka存储消息日志的目录。-zookeeper.connect:设置ZooKeeper的地址和端口。 - 启动ZooKeeper:Kafka依赖ZooKeeper进行集群管理和协调。启动ZooKeeper服务,可以使用Kafka自带的脚本或独立安装的ZooKeeper。

- 启动Kafka节点:依次启动Kafka集群中的每个节点。在Kafka的安装目录下运行命令

bin/kafka-server-start.sh config/server.properties启动节点。 - 创建主题:使用Kafka提供的命令行工具创建主题。例如,使用

bin/kafka-topics.sh --create --topic mytopic --bootstrap-server localhost:9092 --partitions 1 --replication-factor 1命令创建一个名为mytopic的主题。 - 发布和消费消息:使用Kafka提供的命令行工具或开发相关的应用程序来发布和消费消息。例如,使用

bin/kafka-console-producer.sh --topic mytopic --bootstrap-server localhost:9092命令启动消息生产者,使用bin/kafka-console-consumer.sh --topic mytopic --bootstrap-server localhost:9092 --from-beginning命令启动消息消费者。

以上是搭建Kafka的基本过程,具体的配置和操作可能会根据实际情况有所不同。在实际部署和运维Kafka时,还需要考虑到高可用性、安全性和性能优化等问题。

版权归原作者 Oo_Amy_oO 所有, 如有侵权,请联系我们删除。