我们最近看到了一些大型数据集的出现,它们允许训练深度学习模型来自动化各种任务,例如植物细胞评估,细胞核分割或有丝分裂检测,所有这些都非常准确,有时甚至超过人类 专家。

虽然有些人已经在谈论另一个AI冬天,但在生物医学领域,我们只是看到深度学习模型却并非如此,而是真正兑现了诺言并取得了卓越的成果。

但是-他们有一个大问题。而且大多数论文对此都不公开:

一旦向使用了其他实验室的图像,这些AI模型中许多模型的优良性能就会瓦解。

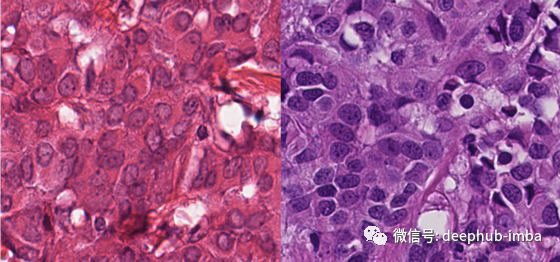

您可能已经听说过,来自不同机构的显微图像看起来有所不同。为了说明这一点,下面是TUPAC16数据集中使用的两个扫描仪的示例:

两种图像均显示相同的组织类型:人类乳腺癌。然而,两个图像之间的差异是惊人的。通常,这归因于组织处理的差异,例如化学染色剂的浓度或染色方案。

所有这些都导致了所谓的域偏移:图像只是具有不同的视觉表示。这通常还会导致深度学习模型中的不同特征表示。如果我们将其简化为2D区域,则可能如下所示:

因此,如果我们针对实验1的数据分布训练深度学习模型,则对于实验2的部分数据集可能会正常工作,但对于实验3的数据可能根本不起作用。您想为所有人提供解决方案的问题。

还有另一个区别,直到最近才被广泛讨论:这些图像也是用不同的显微镜整片扫描仪获得的。

这是为什么?首先,因为有许多显微扫描仪制造商,并且他们都提供了优质的产品。因此,我们有有多种产品可供选择。对于显微镜扫描仪,他们的价格大约为10万欧元。如果病理实验室中需要多个扫描仪,只有大型实验室,才会在这种全数字化的情况下工作。在这种情况下,对于采购而言很有可能会使用相同类型的扫描仪,以简化工作流程,所以会出现在各处具有相似的图片,因为都是同品牌甚至同型号的显微扫描仪。

对于不同的实验室可能使用不同的扫描仪。但这真的有问题吗?如果在正常光线条件下用两部智能手机拍摄场景照片,则图像看起来非常相似。

最初,我我也对昂贵的显微扫描仪有所期望。因为在我们的理解里这些设备应完全照原样捕获硬件显微镜载玻片,甚至可以控制光线条件等。

但事实并非如此。我们最近在欧洲各地发送了几张显微镜幻灯片来测试这一点。所以我们用不同厂家的扫描仪扫描了相同的幻灯片。这些差异令人大开眼界。

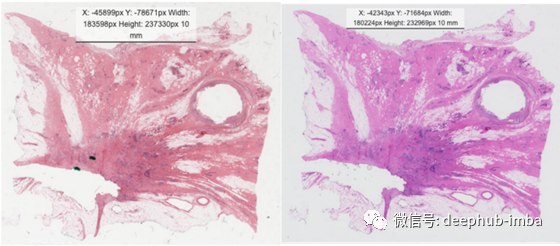

用两种不同的全幻灯片扫描仪扫描人体乳房组织。

概述中的图片,我们已经看到了区别。现在让我们放大。

这在颜色上和细节上都有很大的变化。左扫描仪的对比度似乎比右扫描仪高。

这对深度学习模型意味着什么?

现在让我们回到我们最初的问题:为什么深度学习模型不能在其他实验室的图像上工作?部分答案是肯定的:使用不同的扫描仪造成的色域移位。

我做了一个小数据实验来证明这一点:我在上图所示的TUPAC16数据集的图像上训练了一个RetinaNet 模型。我们要完成的任务是检测有丝分裂。有丝分裂象代表细胞正在进行细胞分裂,是重要的肿瘤标志物。因此,拥有一个可以应用于任何显微镜图像的泛化模型将对肿瘤诊断大有裨益。

正如上面所讨论的,TUPAC16集已经包含了两个扫描仪,我们希望它可以推广到更多的扫描仪。但它会吗?

我们拥有由三台扫描仪组成的数据集——这是它们之间唯一的区别。所有病例均来自UMC乌得勒支大学病理科——欧洲最大的病理科之一,具有高度标准化的工作流程。

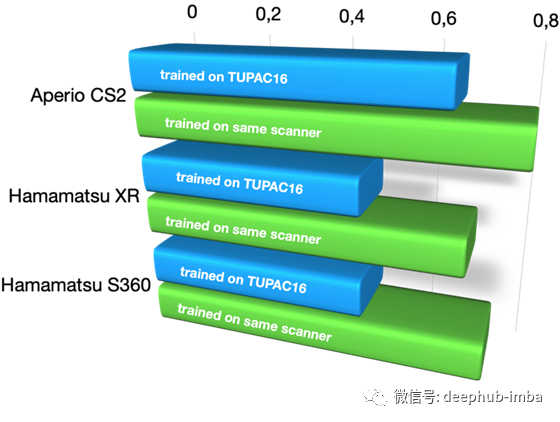

我们在所有这些集合上运行TUPAC16上训练的模型,并与域内训练(使用来自同一扫描器的不同案例)进行比较。以下是我们得到的结果:

在TUPAC16数据集上训练与在同一扫描仪上训练时,在使用不同扫描仪获得的图像上有丝分裂检测(F1分数)的表现。

一旦我们不再使用来自同一个扫描器的数据进行训练,性能就会大幅下降(当然,这都是独立的情况)。这种下降在Hamamatsu扫描仪上表现得尤其明显,而在Aperio CS2扫描仪上则相当微弱。另一方面,这并不奇怪,因为TUPAC16数据集的一个扫描器是(旧型号)Aperio扫描器。

那么到底发生了什么呢?

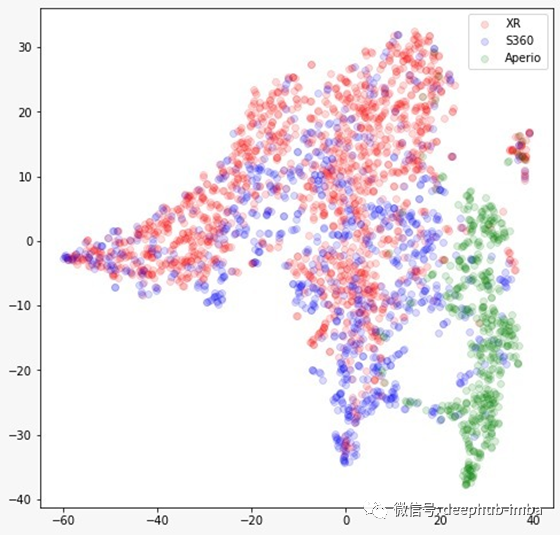

因此,扫描器诱导的域位移是数字病理图像识别的一个主要问题。如果我们深入研究我们的模型(我的意思是:我们研究内部表示),我们可以看到输入的域移位(如上所示)也反映在表示的域移位上。这是t-SNE图:

对MIDOG挑战集的图像进行推理时,在TUPAC16上训练的RetinaNet模型表示的t-SNE图。

让我为你解释一下这个图:每个图像(集合的随机样本)都被输入到网络中,并由图中的单个点表示。图像中的相似度越高(如模型所见,该模型为这项任务接受了训练),二维平面上的点就越接近。如果没有域转移,我们就看不到聚类。相反,我们看到了一个强大的集群(特别是对于Aperio和其他扫描器)。因此,该模型在扫描器之间有很好的区别——但它应该只在图像中寻找有丝分裂而与域移位无关。

该模型强烈地依赖于扫描仪所诱发的特性。这就是为什么一旦我们改变了这些,它就不能很好地工作。

效果有多强?我们发现,它甚至比不同实验室和不同物种的组合所引起的领域差距还要强。

作者:Prof. Marc Aubreville

deephub翻译组