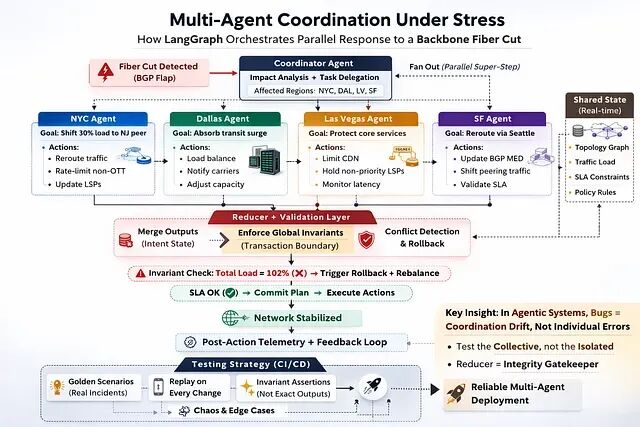

并行多智能体系统的协调测试实战:从轨迹捕获到CI/CD的六个步骤

传统软件里bug 是逻辑错误。代码做了不该做的事;并行智能体系统里的 bug 往往以另一种形态出现:协调漂移。

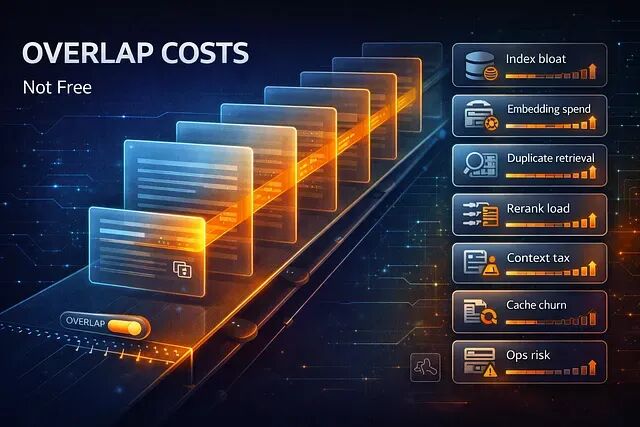

RAG 中分块重叠的 8 个隐性开销与权衡策略

本文将总结的八项 RAG 分块重叠隐藏的成本,以及如何判断什么时候重叠真正有用,什么时候只是花钱买心安。

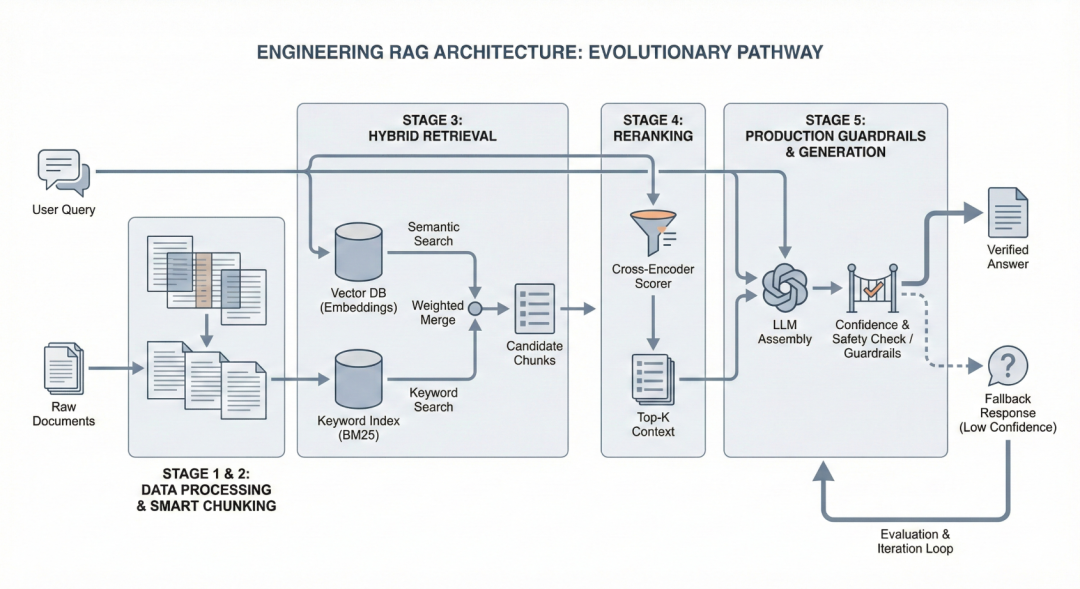

深入RAG架构:分块策略、混合检索与重排序的工程实现

从 Level 1 开始。记录并监控系统在哪翻车,搞清楚原因之后再往上走。 这才是构建一个真正能用的RAG系统的路径。

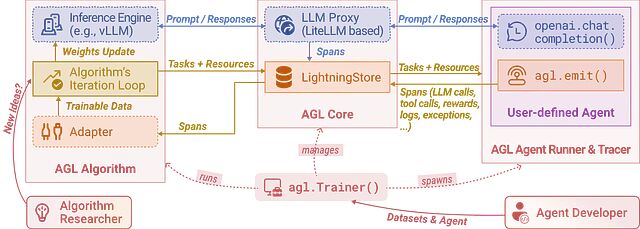

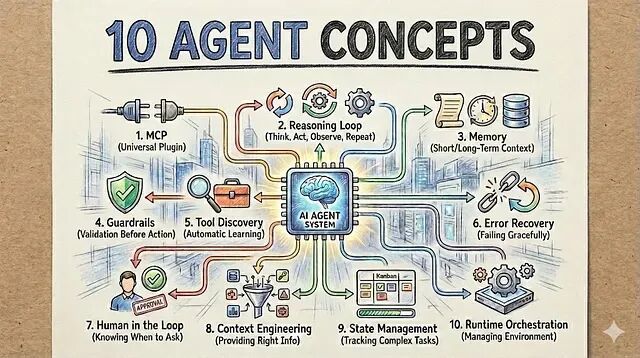

AI Agent技术栈:10个构建生产级Agent的核心概念

本文就总结了构建AI系统时真正绕不开的10个基础概念

长上下文"记忆"的舒适陷阱:为什么更多记忆不等于更可靠

人们喜欢长上下文,智能体记得你的项目、你的偏好、你说话的方式,连你那些反复冒出来的琐碎任务都帮你记着,所以用起来当然顺手。但顺手归顺手,顺手不等于靠谱,把这两件事搞混后面的麻烦就来了。

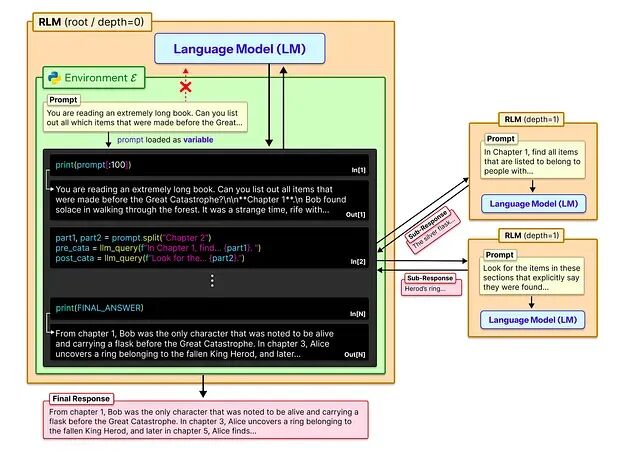

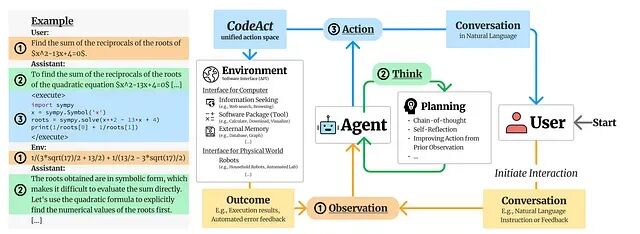

超越上下文窗口:CodeAct与RLM,两种代码驱动的LLM扩展方案

与其一味地扩大上下文窗口,不如去重构计算本身。无论是 CodeAct 的执行循环还是 RLM 的递归分解,LLM 系统的未来不在于能吃下多少 Token,而在于如何更聪明地控制推理和动作。

15 分钟用 FastMCP 搭建你的第一个 MCP Server(附完整代码)

Model Context Protocol 是一个开放标准,它的目标是给 LLM 一种干净、统一的方式去发现和调用外部工具。

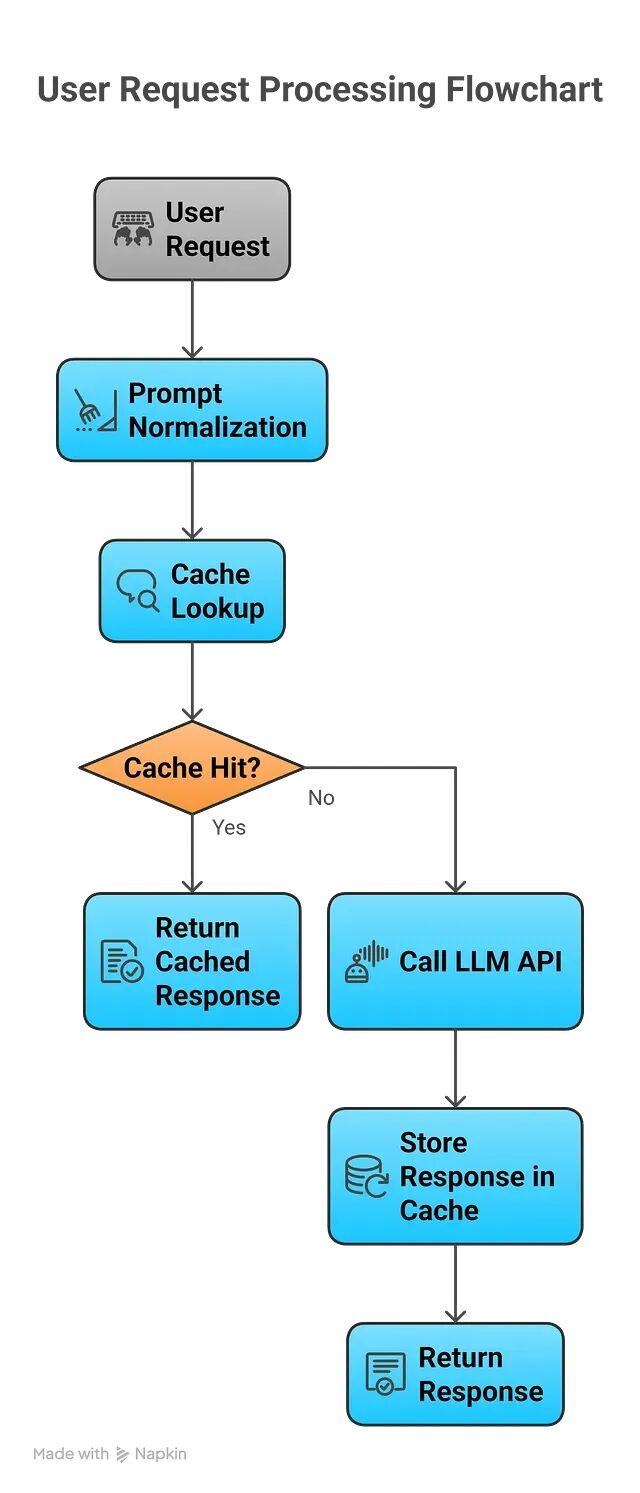

Prompt 缓存的四种策略:从精确匹配到语义检索

在 LLM 系统的各种优化手段中,Prompt 缓存的投入产出比可能是最高的。入手门槛低,可以渐进式迭代,而且到了一定规模之后几乎是刚需。

RAG 文本分块:七种主流策略的原理与适用场景

分块就是在生成 Embedding 之前,把大段文本拆成更小语义单元的过程。检索器真正搜索的对象而不是整篇文档就是这些分块。

LLM创造力可以被度量吗?一个基于提示词变更的探索性实验

提示词工程在今天基本还是被当作一种"艺术"。这篇文章要讨论的就是为什么这是个问题,以及怎么把它变成一门可度量的工程学科。

软件工程原则在多智能体系统中的应用:分层与解耦

本文的出发点是想验证一件事:智能体系统到底能不能像其他严肃软件一样做架构。

一分钟训练搞懂 DPPO:把扩散过程建模为 MDP 的强化学习方法

这篇文章解释了如何为单步环境中的扩散模型实现 DPPO,希望能提供一个比典型机器人环境更容易理解训练动态的平台。

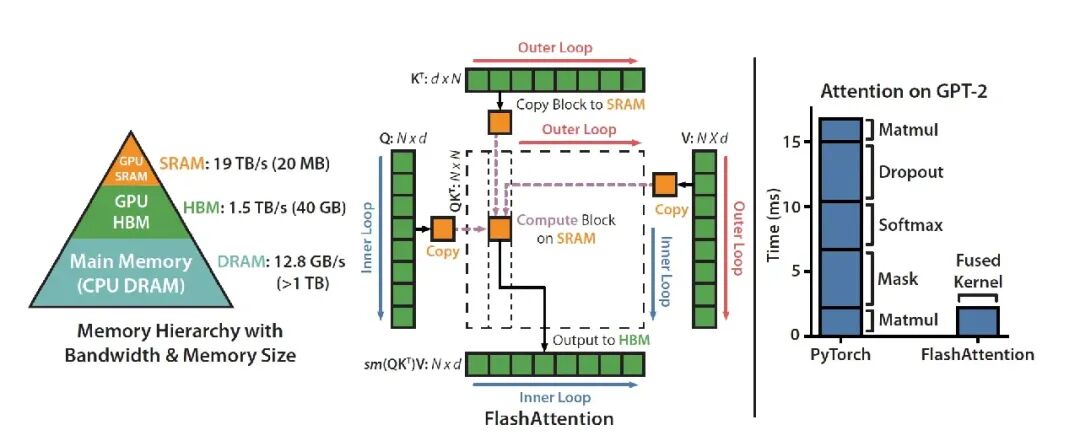

从零开始用自定义 Triton 内核编写 FlashAttention-2

本文只实现了前向传播。扩展到完整的训练级 FlashAttention(反向传播、dropout、各种 mask 变体)留待后续工作。

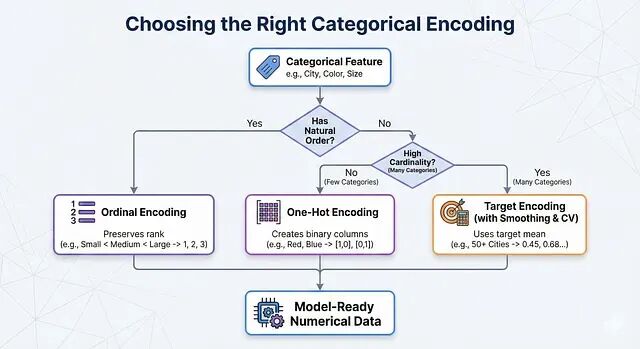

机器学习特征工程:分类变量的数值化处理方法

实际操作中可以这样判断:特征有天然顺序就用 Ordinal Encoding;没有顺序、类别数量也不多就用 One-Hot Encoding;类别太多就上 Target Encoding,记得配合 Smoothing 和交叉验证。

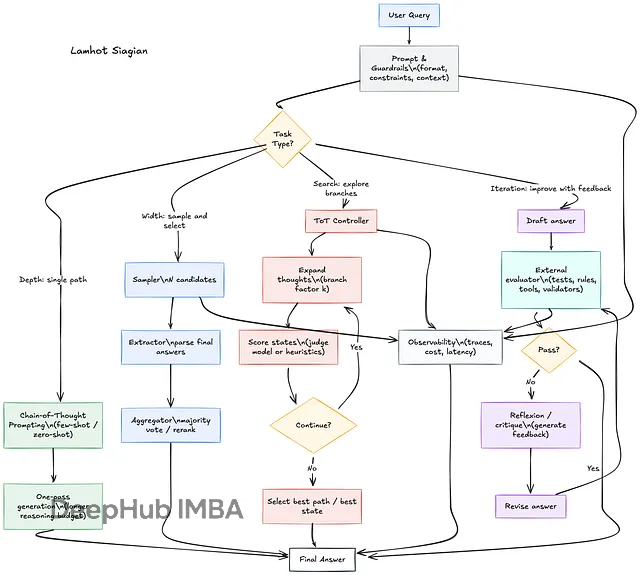

LLM推理时计算技术详解:四种提升大模型推理能力的方法

本文要讲四种主流的推理时计算技术:深度方向的Chain-of-Thought,宽度方向的Self-Consistency,搜索方向的Tree-of-Thoughts,以及迭代方向的Reflexion/Self-Refine。

分类数据 EDA 实战:如何发现隐藏的层次结构

这篇文章讲的是如何在 EDA 阶段把这些隐藏结构找出来,用实际的步骤、真实的案例,外加可以直接复用的 Python 代码。

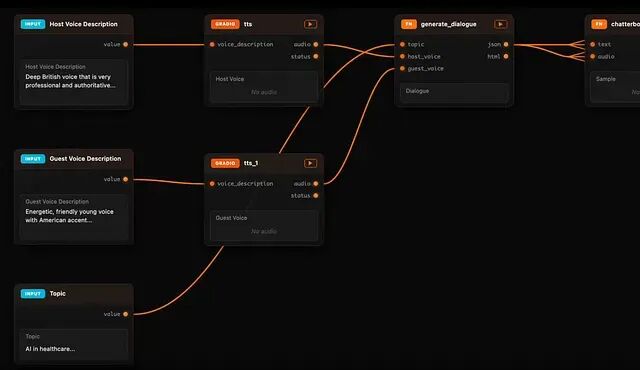

Daggr:介于 Gradio 和 ComfyUI 之间的 AI 工作流可视化方案

Daggr 是一个代码优先的 Python 库,可将 AI 工作流转换为可视化图,支持对 Gradio 管道进行检查、重跑和调试。

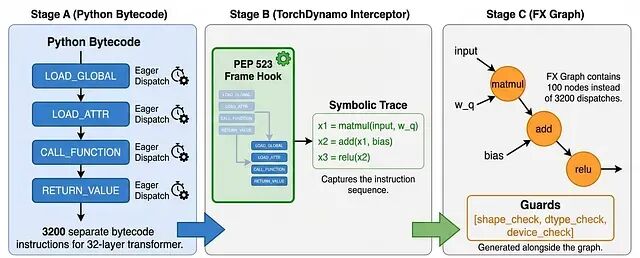

torch.compile 加速原理:kernel 融合与缓冲区复用

torch.compile 的价值在于:它把原本需要手写 CUDA 或 Triton 才能实现的优化,封装成了一行代码的事情。

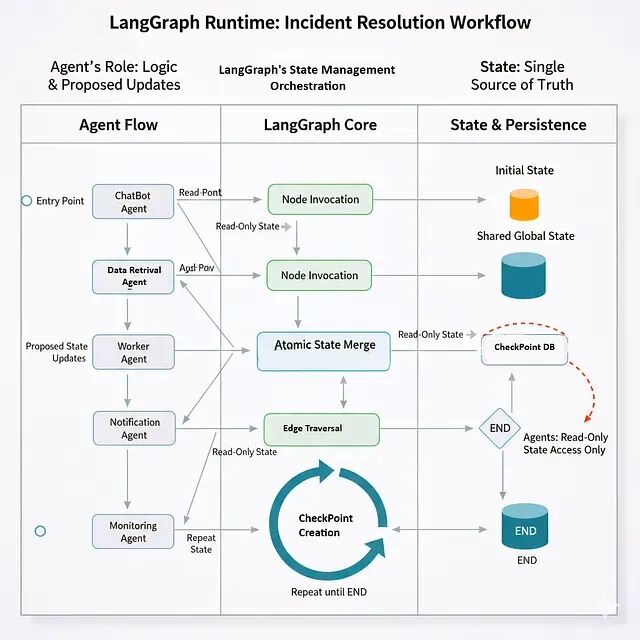

LangGraph 入门:用图结构构建你的第一个多智能体工作流

LangGraph 里每个工作流都是一个 StateGraph——本质上是有向图。节点就是智能体,或者说处理状态的函数;边是智能体之间的转换;状态则是在整个图中流动的共享数据结构。